1.马尔可夫性质

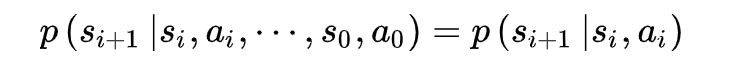

马尔可夫决策过程(Markov Decision Process, MDP)独有性质即当前时刻的状态仅与前一时刻的状态和动作有关,与其他时刻的状态和动作条件独立。

等式右侧的条件概率被称为MDP的状态间的转移概率 。马尔可夫性质是所有马尔可夫模型共有的性质,但相比于马尔可夫链,MDP的转移概率加入了智能体的动作,其马尔可夫性质也与动作有关

2.MDP基本组成部分

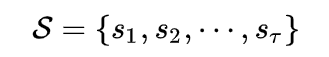

状态集合

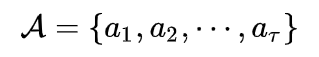

动作集合

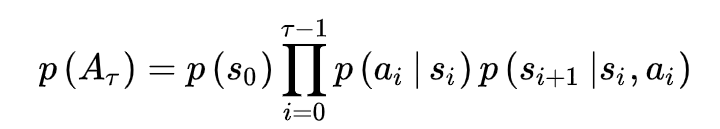

状态转移概率函数

奖励函数

策略函数

●折扣因子:γ∈[0,1]

◆γ=0:贪婪法,价值只由当前延时奖励决定;

◆γ=1:所有后续状态奖励和当前状态奖励同等重要;

◆γ∈(0,1):当前延时奖励的权重比后续奖励的权重大。

马尔科夫决策过程可以表示成一个五元组

MDP(S,A,P(a|s),R(s|a),γ)

本文深入解析了马尔可夫决策过程(MDP)的基本构造,包括状态、动作、状态转移概率、奖励函数及策略函数,强调了其马尔可夫性质,并介绍了折扣因子如何影响决策策略。同时,给出了MDP的五元组形式(S,A,P(a|s),R(s|a),γ)。

本文深入解析了马尔可夫决策过程(MDP)的基本构造,包括状态、动作、状态转移概率、奖励函数及策略函数,强调了其马尔可夫性质,并介绍了折扣因子如何影响决策策略。同时,给出了MDP的五元组形式(S,A,P(a|s),R(s|a),γ)。

2085

2085

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?