- 🍨 本文为🔗365天深度学习训练营 中的学习记录博客

- 🍖 原作者:K同学啊

用C3模块实现天气识别

一、导入库

import torch

import torch.nn as nn

import torchvision.transforms as transforms

import torchvision

from torchvision import transforms, datasets

import os,PIL,pathlib,warnings

import os,PIL,random,pathlib

import torch.nn.functional as F

import torchsummary as summary

import copy

import matplotlib.pyplot as plt

二、数据导入及分割数据集

1. 查看使用的是cpu还是gpu

warnings.filterwarnings("ignore")#忽略警告信息

device = torch.device("cuda" if torch.cuda.is_available() else "cpu")

2.导入数据及标准化

data_dir = './data/weather_photos'

data_dir = pathlib.Path(data_dir)

data_paths = list(data_dir.glob('*'))

classeNames = [str(path).split("\\")[2] for path in data_paths]

train_transforms = transforms.Compose([

transforms.Resize([224, 224]), # 将输入图片resize成统一尺寸

# transforms.RandomHorizontalFlip(), # 随机水平翻转

transforms.ToTensor(), # 将PIL Image或numpy.ndarray转换为tensor,并归一化到[0,1]之间

transforms.Normalize( # 标准化处理-->转换为标准正太分布(高斯分布),使模型更容易收敛

mean=[0.485, 0.456, 0.406],

std=[0.229, 0.224, 0.225]) # 其中 mean=[0.485,0.456,0.406]与std=[0.229,0.224,0.225] 从数据集中随机抽样计算得到的。

])

test_transform = transforms.Compose([

transforms.Resize([224, 224]), # 将输入图片resize成统一尺寸

transforms.ToTensor(), # 将PIL Image或numpy.ndarray转换为tensor,并归一化到[0,1]之间

transforms.Normalize( # 标准化处理-->转换为标准正太分布(高斯分布),使模型更容易收敛

mean=[0.485, 0.456, 0.406],

std=[0.229, 0.224, 0.225]) # 其中 mean=[0.485,0.456,0.406]与std=[0.229,0.224,0.225] 从数据集中随机抽样计算得到的。

])

2. 划分训练集和测试集

total_data = datasets.ImageFolder("./data/weather_photos",transform=train_transforms)

total_data# 关于transforms.Compose的更多介绍可以参考:https://blog.youkuaiyun.com/qq_38251616/article/details/124878863

train_transforms = transforms.Compose([

transforms.Resize([224, 224]), # 将输入图片resize成统一尺寸

# transforms.RandomHorizontalFlip(), # 随机水平翻转

transforms.ToTensor(), # 将PIL Image或numpy.ndarray转换为tensor,并归一化到[0,1]之间

transforms.Normalize( # 标准化处理-->转换为标准正太分布(高斯分布),使模型更容易收敛

mean=[0.485, 0.456, 0.406],

std=[0.229, 0.224, 0.225]) # 其中 mean=[0.485,0.456,0.406]与std=[0.229,0.224,0.225] 从数据集中随机抽样计算得到的。

])

test_transform = transforms.Compose([

transforms.Resize([224, 224]), # 将输入图片resize成统一尺寸

transforms.ToTensor(), # 将PIL Image或numpy.ndarray转换为tensor,并归一化到[0,1]之间

transforms.Normalize( # 标准化处理-->转换为标准正太分布(高斯分布),使模型更容易收敛

mean=[0.485, 0.456, 0.406],

std=[0.229, 0.224, 0.225]) # 其中 mean=[0.485,0.456,0.406]与std=[0.229,0.224,0.225] 从数据集中随机抽样计算得到的。

])

total_data = datasets.ImageFolder("./data/weather_photos",transform=train_transforms)

train_size = int(0.8 * len(total_data))

test_size = len(total_data) - train_size

train_dataset, test_dataset = torch.utils.data.random_split(total_data, [train_size, test_size])

3. 训练批次

batch_size = 4

train_dl = torch.utils.data.DataLoader(train_dataset,

batch_size=batch_size,

shuffle=True,

num_workers=1)

test_dl = torch.utils.data.DataLoader(test_dataset,

batch_size=batch_size,

shuffle=True,

num_workers=1)

三、搭建模型

模型结构

import torch.nn.functional as F

def autopad(k, p=None): # kernel, padding

# Pad to 'same'

if p is None:

p = k // 2 if isinstance(k, int) else [x // 2 for x in k] # auto-pad

return p

class Conv(nn.Module):

# Standard convolution

def __init__(self, c1, c2, k=1, s=1, p=None, g=1, act=True): # ch_in, ch_out, kernel, stride, padding, groups

super().__init__()

self.conv = nn.Conv2d(c1, c2, k, s, autopad(k, p), groups=g, bias=False)

self.bn = nn.BatchNorm2d(c2)

self.act = nn.SiLU() if act is True else (act if isinstance(act, nn.Module) else nn.Identity())

def forward(self, x):

return self.act(self.bn(self.conv(x)))

class Bottleneck(nn.Module):

# Standard bottleneck

def __init__(self, c1, c2, shortcut=True, g=1, e=0.5): # ch_in, ch_out, shortcut, groups, expansion

super().__init__()

c_ = int(c2 * e) # hidden channels

self.cv1 = Conv(c1, c_, 1, 1)

self.cv2 = Conv(c_, c2, 3, 1, g=g)

self.add = shortcut and c1 == c2

def forward(self, x):

return x + self.cv2(self.cv1(x)) if self.add else self.cv2(self.cv1(x))

class C3(nn.Module):

# CSP Bottleneck with 3 convolutions

def __init__(self, c1, c2, n=1, shortcut=True, g=1, e=0.5): # ch_in, ch_out, number, shortcut, groups, expansion

super().__init__()

c_ = int(c2 * e) # hidden channels

self.cv1 = Conv(c1, c_, 1, 1)

self.cv2 = Conv(c1, c_, 1, 1)

self.cv3 = Conv(2 * c_, c2, 1) # act=FReLU(c2)

self.m = nn.Sequential(*(Bottleneck(c_, c_, shortcut, g, e=1.0) for _ in range(n)))

def forward(self, x):

return self.cv3(torch.cat((self.m(self.cv1(x)), self.cv2(x)), dim=1))

class model_K(nn.Module):

def __init__(self):

super(model_K, self).__init__()

# 卷积模块

self.Conv = Conv(3, 32, 3, 2)

# C3模块1

self.C3_1 = C3(32, 64, 3, 2)

# 全连接网络层,用于分类

self.classifier = nn.Sequential(

nn.Linear(in_features=802816, out_features=100),

nn.ReLU(),

nn.Linear(in_features=100, out_features=4)

)

def forward(self, x):

x = self.Conv(x)

x = self.C3_1(x)

x = torch.flatten(x, start_dim=1)

x = self.classifier(x)

return x

device = "cuda" if torch.cuda.is_available() else "cpu"

print("Using {} device".format(device))

model = model_K().to(device)

print(model)

输出model显示

model_K(

(Conv): Conv(

(conv): Conv2d(3, 32, kernel_size=(3, 3), stride=(2, 2), padding=(1, 1), bias=False)

(bn): BatchNorm2d(32, eps=1e-05, momentum=0.1, affine=True, track_running_stats=True)

(act): SiLU()

)

(C3_1): C3(

(cv1): Conv(

(conv): Conv2d(32, 32, kernel_size=(1, 1), stride=(1, 1), bias=False)

(bn): BatchNorm2d(32, eps=1e-05, momentum=0.1, affine=True, track_running_stats=True)

(act): SiLU()

)

(cv2): Conv(

(conv): Conv2d(32, 32, kernel_size=(1, 1), stride=(1, 1), bias=False)

(bn): BatchNorm2d(32, eps=1e-05, momentum=0.1, affine=True, track_running_stats=True)

(act): SiLU()

)

(cv3): Conv(

(conv): Conv2d(64, 64, kernel_size=(1, 1), stride=(1, 1), bias=False)

(bn): BatchNorm2d(64, eps=1e-05, momentum=0.1, affine=True, track_running_stats=True)

(act): SiLU()

)

(m): Sequential(

(0): Bottleneck(

(cv1): Conv(

(conv): Conv2d(32, 32, kernel_size=(1, 1), stride=(1, 1), bias=False)

(bn): BatchNorm2d(32, eps=1e-05, momentum=0.1, affine=True, track_running_stats=True)

(act): SiLU()

)

(cv2): Conv(

(conv): Conv2d(32, 32, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1), bias=False)

(bn): BatchNorm2d(32, eps=1e-05, momentum=0.1, affine=True, track_running_stats=True)

(act): SiLU()

)

)

(1): Bottleneck(

(cv1): Conv(

(conv): Conv2d(32, 32, kernel_size=(1, 1), stride=(1, 1), bias=False)

(bn): BatchNorm2d(32, eps=1e-05, momentum=0.1, affine=True, track_running_stats=True)

(act): SiLU()

)

(cv2): Conv(

(conv): Conv2d(32, 32, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1), bias=False)

(bn): BatchNorm2d(32, eps=1e-05, momentum=0.1, affine=True, track_running_stats=True)

(act): SiLU()

)

)

(2): Bottleneck(

(cv1): Conv(

(conv): Conv2d(32, 32, kernel_size=(1, 1), stride=(1, 1), bias=False)

(bn): BatchNorm2d(32, eps=1e-05, momentum=0.1, affine=True, track_running_stats=True)

(act): SiLU()

)

(cv2): Conv(

(conv): Conv2d(32, 32, kernel_size=(3, 3), stride=(1, 1), padding=(1, 1), bias=False)

(bn): BatchNorm2d(32, eps=1e-05, momentum=0.1, affine=True, track_running_stats=True)

(act): SiLU()

)

)

)

)

(classifier): Sequential(

(0): Linear(in_features=802816, out_features=100, bias=True)

(1): ReLU()

(2): Linear(in_features=100, out_features=4, bias=True)

)

)

Process finished with exit code 0

查看模型详情

#print(summary.summary(model, (3, 224, 224)))

----------------------------------------------------------------

Layer (type) Output Shape Param #

================================================================

Conv2d-1 [-1, 32, 112, 112] 864

BatchNorm2d-2 [-1, 32, 112, 112] 64

SiLU-3 [-1, 32, 112, 112] 0

Conv-4 [-1, 32, 112, 112] 0

Conv2d-5 [-1, 32, 112, 112] 1,024

BatchNorm2d-6 [-1, 32, 112, 112] 64

SiLU-7 [-1, 32, 112, 112] 0

Conv-8 [-1, 32, 112, 112] 0

Conv2d-9 [-1, 32, 112, 112] 1,024

BatchNorm2d-10 [-1, 32, 112, 112] 64

SiLU-11 [-1, 32, 112, 112] 0

Conv-12 [-1, 32, 112, 112] 0

Conv2d-13 [-1, 32, 112, 112] 9,216

BatchNorm2d-14 [-1, 32, 112, 112] 64

SiLU-15 [-1, 32, 112, 112] 0

Conv-16 [-1, 32, 112, 112] 0

Bottleneck-17 [-1, 32, 112, 112] 0

Conv2d-18 [-1, 32, 112, 112] 1,024

BatchNorm2d-19 [-1, 32, 112, 112] 64

SiLU-20 [-1, 32, 112, 112] 0

Conv-21 [-1, 32, 112, 112] 0

Conv2d-22 [-1, 32, 112, 112] 9,216

BatchNorm2d-23 [-1, 32, 112, 112] 64

SiLU-24 [-1, 32, 112, 112] 0

Conv-25 [-1, 32, 112, 112] 0

Bottleneck-26 [-1, 32, 112, 112] 0

Conv2d-27 [-1, 32, 112, 112] 1,024

BatchNorm2d-28 [-1, 32, 112, 112] 64

SiLU-29 [-1, 32, 112, 112] 0

Conv-30 [-1, 32, 112, 112] 0

Conv2d-31 [-1, 32, 112, 112] 9,216

BatchNorm2d-32 [-1, 32, 112, 112] 64

SiLU-33 [-1, 32, 112, 112] 0

Conv-34 [-1, 32, 112, 112] 0

Bottleneck-35 [-1, 32, 112, 112] 0

Conv2d-36 [-1, 32, 112, 112] 1,024

BatchNorm2d-37 [-1, 32, 112, 112] 64

SiLU-38 [-1, 32, 112, 112] 0

Conv-39 [-1, 32, 112, 112] 0

Conv2d-40 [-1, 64, 112, 112] 4,096

BatchNorm2d-41 [-1, 64, 112, 112] 128

SiLU-42 [-1, 64, 112, 112] 0

Conv-43 [-1, 64, 112, 112] 0

C3-44 [-1, 64, 112, 112] 0

Linear-45 [-1, 100] 80,281,700

ReLU-46 [-1, 100] 0

Linear-47 [-1, 4] 404

================================================================

Total params: 80,320,536

Trainable params: 80,320,536

Non-trainable params: 0

----------------------------------------------------------------

Input size (MB): 0.57

Forward/backward pass size (MB): 150.06

Params size (MB): 306.40

Estimated Total Size (MB): 457.04

----------------------------------------------------------------

None

Process finished with exit code 0

四、训练函数

# 训练循环

def train(dataloader, model, loss_fn, optimizer):

size = len(dataloader.dataset) # 训练集的大小

num_batches = len(dataloader) # 批次数目, (size/batch_size,向上取整)

train_loss, train_acc = 0, 0 # 初始化训练损失和正确率

for X, y in dataloader: # 获取图片及其标签

X, y = X.to(device), y.to(device)

# 计算预测误差

pred = model(X) # 网络输出

loss = loss_fn(pred, y) # 计算网络输出和真实值之间的差距,targets为真实值,计算二者差值即为损失

# 反向传播

optimizer.zero_grad() # grad属性归零

loss.backward() # 反向传播

optimizer.step() # 每一步自动更新

# 记录acc与loss

train_acc += (pred.argmax(1) == y).type(torch.float).sum().item()

train_loss += loss.item()

train_acc /= size

train_loss /= num_batches

return train_acc, train_loss

五、测试函数

def test (dataloader, model, loss_fn):

size = len(dataloader.dataset) # 测试集的大小

num_batches = len(dataloader) # 批次数目, (size/batch_size,向上取整)

test_loss, test_acc = 0, 0

# 当不进行训练时,停止梯度更新,节省计算内存消耗

with torch.no_grad():

for imgs, target in dataloader:

imgs, target = imgs.to(device), target.to(device)

# 计算loss

target_pred = model(imgs)

loss = loss_fn(target_pred, target)

test_loss += loss.item()

test_acc += (target_pred.argmax(1) == target).type(torch.float).sum().item()

test_acc /= size

test_loss /= num_batches

return test_acc, test_loss

五、正式训练

optimizer = torch.optim.Adam(model.parameters(), lr=1e-4)

loss_fn = nn.CrossEntropyLoss() # 创建损失函数

epochs = 20

train_loss = []

train_acc = []

test_loss = []

test_acc = []

best_acc = 0 # 设置一个最佳准确率,作为最佳模型的判别指标

if __name__ == "__main__":

for epoch in range(epochs):

model.train()

epoch_train_acc, epoch_train_loss = train(train_dl, model, loss_fn, optimizer)

model.eval()

epoch_test_acc, epoch_test_loss = test(test_dl, model, loss_fn)

# 保存最佳模型到 best_model

if epoch_test_acc > best_acc:

best_acc = epoch_test_acc

best_model = copy.deepcopy(model)

train_acc.append(epoch_train_acc)

train_loss.append(epoch_train_loss)

test_acc.append(epoch_test_acc)

test_loss.append(epoch_test_loss)

# 获取当前的学习率

lr = optimizer.state_dict()['param_groups'][0]['lr']

template = ('Epoch:{:2d}, Train_acc:{:.1f}%, Train_loss:{:.3f}, Test_acc:{:.1f}%, Test_loss:{:.3f}, Lr:{:.2E}')

print(template.format(epoch + 1, epoch_train_acc * 100, epoch_train_loss,

epoch_test_acc * 100, epoch_test_loss, lr))

六、保存最佳模型

# 保存最佳模型到文件中

PATH = './best_model.pth' # 保存的参数文件名

torch.save(model.state_dict(), PATH)

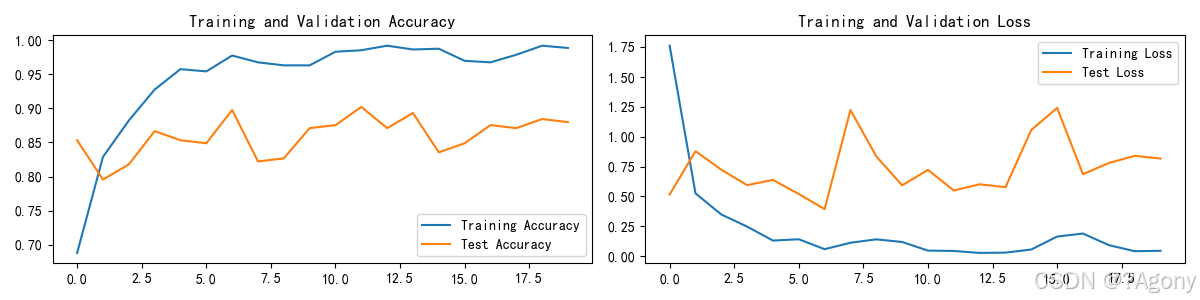

七、可视化测试过程准确率和损失值的可视化过程

warnings.filterwarnings("ignore") #忽略警告信息

plt.rcParams['font.sans-serif'] = ['SimHei'] # 用来正常显示中文标签

plt.rcParams['axes.unicode_minus'] = False # 用来正常显示负号

plt.rcParams['figure.dpi'] = 100 #分辨率

epochs_range = range(epochs)

plt.figure(figsize=(12, 3))

plt.subplot(1, 2, 1)

plt.plot(epochs_range, train_acc, label='Training Accuracy')

plt.plot(epochs_range, test_acc, label='Test Accuracy')

plt.legend(loc='lower right')

plt.title('Training and Validation Accuracy')

plt.subplot(1, 2, 2)

plt.plot(epochs_range, train_loss, label='Training Loss')

plt.plot(epochs_range, test_loss, label='Test Loss')

plt.legend(loc='upper right')

plt.title('Training and Validation Loss')

plt.show()

Epoch: 1, Train_acc:68.8%, Train_loss:1.763, Test_acc:85.3%, Test_loss:0.517, Lr:1.00E-04

Epoch: 2, Train_acc:82.9%, Train_loss:0.526, Test_acc:79.6%, Test_loss:0.879, Lr:1.00E-04

Epoch: 3, Train_acc:88.2%, Train_loss:0.349, Test_acc:81.8%, Test_loss:0.724, Lr:1.00E-04

Epoch: 4, Train_acc:92.8%, Train_loss:0.248, Test_acc:86.7%, Test_loss:0.595, Lr:1.00E-04

Epoch: 5, Train_acc:95.8%, Train_loss:0.131, Test_acc:85.3%, Test_loss:0.639, Lr:1.00E-04

Epoch: 6, Train_acc:95.4%, Train_loss:0.142, Test_acc:84.9%, Test_loss:0.520, Lr:1.00E-04

Epoch: 7, Train_acc:97.8%, Train_loss:0.059, Test_acc:89.8%, Test_loss:0.394, Lr:1.00E-04

Epoch: 8, Train_acc:96.8%, Train_loss:0.112, Test_acc:82.2%, Test_loss:1.225, Lr:1.00E-04

Epoch: 9, Train_acc:96.3%, Train_loss:0.141, Test_acc:82.7%, Test_loss:0.836, Lr:1.00E-04

Epoch:10, Train_acc:96.3%, Train_loss:0.119, Test_acc:87.1%, Test_loss:0.594, Lr:1.00E-04

Epoch:11, Train_acc:98.3%, Train_loss:0.047, Test_acc:87.6%, Test_loss:0.723, Lr:1.00E-04

Epoch:12, Train_acc:98.6%, Train_loss:0.044, Test_acc:90.2%, Test_loss:0.550, Lr:1.00E-04

Epoch:13, Train_acc:99.2%, Train_loss:0.027, Test_acc:87.1%, Test_loss:0.602, Lr:1.00E-04

Epoch:14, Train_acc:98.7%, Train_loss:0.030, Test_acc:89.3%, Test_loss:0.578, Lr:1.00E-04

Epoch:15, Train_acc:98.8%, Train_loss:0.056, Test_acc:83.6%, Test_loss:1.057, Lr:1.00E-04

Epoch:16, Train_acc:97.0%, Train_loss:0.164, Test_acc:84.9%, Test_loss:1.242, Lr:1.00E-04

Epoch:17, Train_acc:96.8%, Train_loss:0.189, Test_acc:87.6%, Test_loss:0.687, Lr:1.00E-04

Epoch:18, Train_acc:97.9%, Train_loss:0.093, Test_acc:87.1%, Test_loss:0.780, Lr:1.00E-04

Epoch:19, Train_acc:99.2%, Train_loss:0.042, Test_acc:88.4%, Test_loss:0.840, Lr:1.00E-04

Epoch:20, Train_acc:98.9%, Train_loss:0.045, Test_acc:88.0%, Test_loss:0.818, Lr:1.00E-04

Done

Process finished with exit code 0

总结

YOLO的基本原理

- 输入图像:YOLO将输入图像划分为多个网格(grid cells),每个网格负责预测中心点落在该网格内的目标。

- 边界框预测:每个网格预测多个边界框(bounding boxes),每个边界框包含位置坐标(x, y, width, height)和置信度(confidence score),置信度表示边界框内包含目标的概率以及边界框的准确度。

- 类别预测:每个边界框还预测一个类别概率分布,表示边界框内目标的类别。

- 损失函数:YOLO使用一个综合的损失函数,同时优化边界框的坐标、置信度和类别概率。

C3模块在YOLO中的作用

C3模块在YOLOv5等版本中用于构建更高效的特征提取网络,其主要作用包括:

-

特征融合:

- C3模块通过在不同阶段的特征图之间进行拼接,融合了不同层次的特征。这种特征融合有助于捕捉到更丰富的语义信息和细节信息,提高模型对目标的检测能力。

- 例如,

cv1和cv2分别对输入特征图进行卷积操作,生成两个中间特征图,然后通过瓶颈结构m进一步提取特征,最后将这些特征图拼接在一起,通过cv3进行融合。

-

计算效率:

- C3模块使用1x1卷积核进行通道数转换,减少了计算量,同时通过瓶颈结构减少了参数数量,提高了计算效率。

- 1x1卷积核可以有效地减少特征图的通道数,降低后续卷积层的计算负担,而瓶颈结构则通过减少中间特征图的通道数,进一步减少了计算量。

-

残差连接:

- 每个瓶颈结构中的残差连接有助于缓解深层网络中的梯度消失问题,提高模型的训练稳定性。

- 残差连接允许梯度直接通过网络,减少了梯度在反向传播过程中的衰减,使得网络可以训练得更深,而不会出现梯度消失或梯度爆炸的问题。

前向传播过程

- 输入特征图:输入特征图

x首先通过cv1卷积层,得到中间特征图x1。 - 瓶颈结构:中间特征图

x1通过多个瓶颈结构(Bottleneck),得到特征图x2。 - 输出卷积层:输入特征图

x同时通过cv2卷积层,得到中间特征图x3。 - 特征图拼接:将

x2和x3在通道维度上拼接,得到特征图x4。 - 最终输出:特征图

x4通过cv3卷积层,得到最终的输出特征图y。

优点

- 特征融合:通过在不同阶段的特征图之间进行拼接,C3模块能够更好地融合不同层次的特征,提高特征的丰富性和表达能力。

- 计算效率:使用1x1卷积核进行通道数转换,减少了计算量,同时通过瓶颈结构减少了参数数量,提高了计算效率。

- 残差连接:每个瓶颈结构中的残差连接有助于缓解深层网络中的梯度消失问题,提高模型的训练稳定性。

598

598

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?