本文来源公众号“江大白”,仅用于学术分享,侵权删,干货满满。

原文链接:深夜读完 OpenAI 开源gpt-oss-120b/20b 技术报告后,OpenAI还是那个OpenAI!

导读

近期,OpenAI 首次开放大模型权重,发布支持工具调用、超长上下文和三档推理强度的开源模型,为多步推理与智能 Agent 提供了强有力的基础支撑。本文将对此进行详细解析,期望为相关开发与研究提供参考。

2025 年 8 月 5 日,OpenAI 在毫无预热的情况下,把首批“开源权重”的推理模型 gpt-oss-120b 和 gpt-oss-20b 直接扔了出来。

本以为OpenAI会掏出一个老掉牙的玩意儿,比如gpt4的开源等,没想到还挺有诚意,基本可以说位于开源第一梯队,不输给R1和K2和GLM4.5。

基本上是一套带工具调用、三段推理强度可调、专为 Agentic Workflow 设计的完整前沿方案。

1. 一句话总结:这是目前最接近 o4-mini 的开源模型

| 维度 | gpt-oss-120b | gpt-oss-20b | 社区体感 |

|---|---|---|---|

| 参数量 | 116.8 B(激活 5.1 B) | 20.9 B(激活 3.6 B) | 20 B 就能跑 16 GB 机器,真香 |

| 上下文 | 131 K tokens | 131 K tokens | YaRN + Rotary,长度管够 |

| 推理强度 | low / medium / high | 同上 | 三挡可调,CoT 长度平滑提升 |

| 工具 | 浏览器 + Python + 任意函数 | 同上 | 官方给了参考 Harness,可插拔 |

| 量化 | MXFP4(4.25 bit) | 同上 | 120 B 单卡 80 GB 就能跑 |

| 协议 | Apache 2.0 | Apache 2.0 | 商用无门槛 |

2. 技术拆解

2.1 架构:经典 MoE 的“细节拉满”版

-

MoE 层

-

120b:128 experts × top-4;20b:32 experts × top-4

-

Gated-SwiGLU + 残差连接,激活内存砍半

-

-

Attention

-

GQA(8 KV heads)+ 128 宽窗口与全密集交替

-

YaRN 把 8 K 预训练长度硬拉到 131 K

-

-

量化

-

只对 MoE weight 做 MXFP4,90 % 参数 4 bit,效果不掉点 (注意,这是整个模型牛逼的地方,当初R1搞定8bit训练就震惊了,OpenAI浓眉大眼漏了一手infra实力,果然大模型时代,infra才是胜负手)

-

2.2 分词器:新鲜货o200k_harmony开源了

-

在 GPT-4o 的 o200k 基础上,新增 Harmony Chat 专用 token

-

总词表 201 K,中文/代码/数学 token 密度肉眼可见提高

2.3 三段式训练

| 阶段 | 数据&技巧 | 亮点 |

|---|---|---|

| 预训练 | 数 T tokens(STEM+Code 权重高) | 知识截止 2024-06 |

| 后训练 | 与 o3 同源的 CoT RL | 推理 token 20 K+ 不崩 |

| 工具微调 | 浏览器、Python、函数调用混合训练 | 支持任意 JSON schema |

3. 一些评测效果

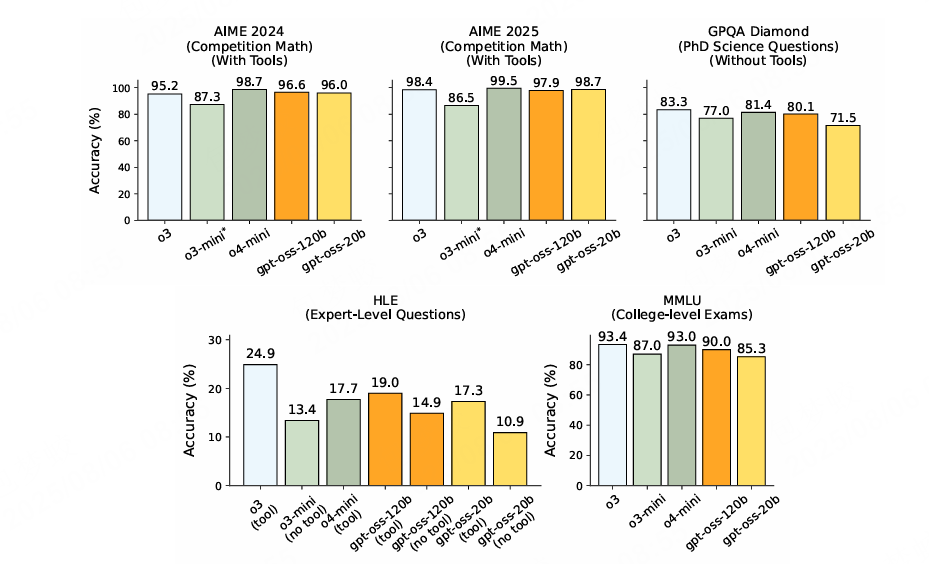

“实测表现:

AIME 2025(with tools)97.9 %,打平 o4-mini-high

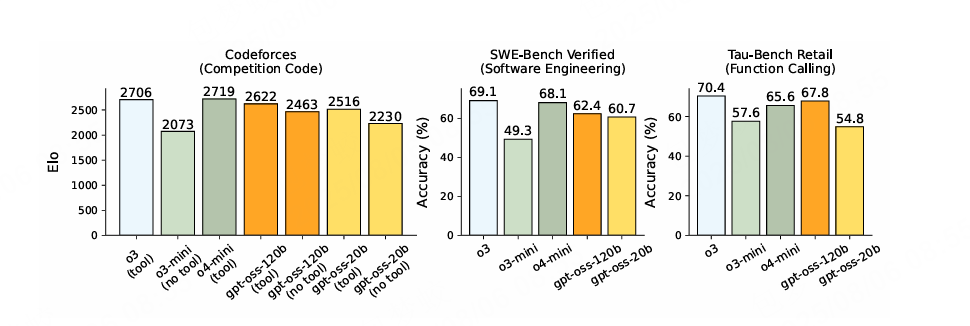

SWE-Bench Verified 62.4 %,比 o3-mini 高 5+ 个点

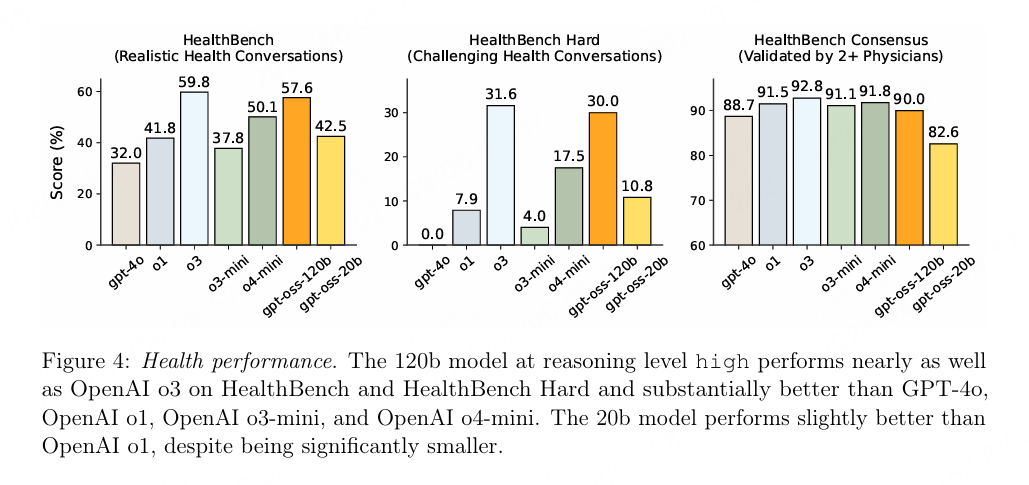

HealthBench Hard 30 %,直接把 GPT-4o 按在地上摩擦

总体评测

code评测

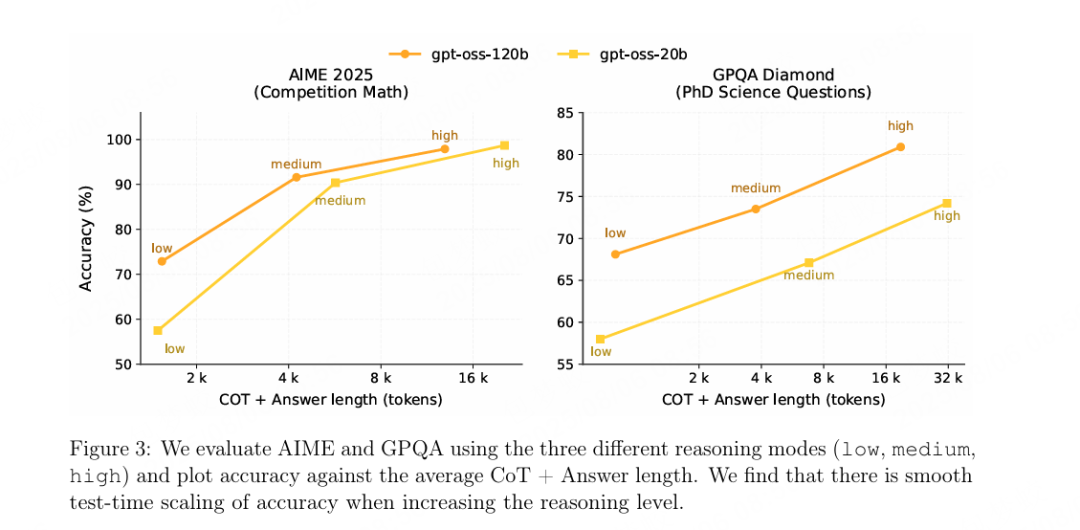

infrence scalinglaw依然生效

openAI把整个模型在医疗化学领域的表现作为一个核心卖点,特地评估了Heath领域。

4. 快速上手:3 条命令跑起来

# 1. 一键下载(已量化)

git clone https://github.com/openai/gpt-oss

cd gpt-oss

pip install -r requirements.txt

# 2. 120b 单卡推理

python -m gpt_oss.cli \

--model gpt-oss-120b \

--quantize mxfp4 \

--reasoning high \

--tools browser,python

# 3. 20b 低资源模式

python -m gpt_oss.cli \

--model gpt-oss-20b \

--gpu-mem 16 \

--reasoning medium

Harmony Chat 的 JSON 模板直接照抄附录,LangChain / LlamaIndex 已连夜适配。

5. 写在最后:它到底改变了什么?

| 对开发者 | 对研究社区 | 对行业 |

|---|---|---|

| 免费拿到 o4-mini 90 % 能力 + 全套 Agent 脚手架 | 可复现的 RL + Tool 训练流水线 | 开源权重首次通过生物/网络红队 |

| Apache 2.0,可商用,可微调 | CoT 无隐藏,方便做监控与对齐研究 | 给闭源厂商一次“降维打击” |

如果你正在做:

-

复杂工作流 Agent

-

长链数学/代码推理

-

医疗、法律等高价值场景

gpt-oss-120b/20b 值得立刻拉分支实测。

毕竟,上一次开源圈这么热闹,还是 Llama 2 发布的时候。

“引用

[1] OpenAI. gpt-oss-120b & gpt-oss-20b Model Card, 2025-08-05

[2] 知乎问答:如何看待 OpenAI 开源 MoE 模型 gpt-oss-120b & gpt-oss-20b?

THE END !

文章结束,感谢阅读。您的点赞,收藏,评论是我继续更新的动力。大家有推荐的公众号可以评论区留言,共同学习,一起进步。

OpenAI开源gpt-oss-120b/20b模型解析

OpenAI开源gpt-oss-120b/20b模型解析

1146

1146

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?