摘要

在当今数字化时代,局域网资源共享的需求日益增加。Ollama作为一种强大的工具,能够在局域网内提供高效的服务。本文将详细介绍如何在Windows系统中配置Ollama服务,使其能够被局域网中的其他设备访问。我们将从概念讲解、环境变量设置、防火墙配置、测试访问、应用场景、注意事项等多个方面进行深入探讨,并通过Mermaid格式绘制数据流图,帮助读者更好地理解和实践。

一、概念讲解

1.1 Ollama简介

Ollama是一个开源的AI模型管理工具,它可以帮助用户轻松地部署和管理各种AI模型。它通过提供一个简洁的API接口,使得用户可以在不同的设备上访问和使用这些模型。Ollama的核心优势在于其轻量级、易部署和高性能的特点,这使得它在局域网环境中具有广泛的应用前景。

1.2 局域网访问的意义

在局域网环境中,设备之间可以通过网络进行通信和资源共享。通过开放Ollama服务的局域网访问权限,用户可以在不同的设备上共享AI模型的计算能力,从而提高工作效率和资源利用率。例如,一个团队可以在同一局域网内共享一个强大的AI模型,而无需在每台设备上单独部署。

1.3 环境变量与防火墙的作用

-

环境变量:在Windows系统中,环境变量是一种用于存储系统配置信息的机制。通过设置环境变量

OLLAMA_HOST,可以指定Ollama服务监听的网络接口。默认情况下,Ollama只监听本地请求(localhost),通过设置OLLAMA_HOST为0.0.0.0,可以使Ollama监听所有网络接口,从而允许局域网中的其他设备访问。 -

防火墙:防火墙是一种网络安全工具,用于控制网络流量的进出。在Windows系统中,Windows Defender防火墙可以保护系统免受未经授权的访问。为了允许局域网中的其他设备访问Ollama服务,需要在防火墙中开放对应的端口(默认为

11434)。

二、设置环境变量

2.1 打开环境变量设置

在Windows系统中,可以通过以下步骤打开环境变量设置:

-

右键点击“此电脑”或“计算机”,选择“属性”。

-

在左侧点击“高级系统设置”。

-

在弹出的窗口中,点击“环境变量”。

2.2 添加环境变量

在“环境变量”窗口中,进行以下操作:

-

在“系统变量”部分,点击“新建”。

-

在“变量名”输入框中输入

OLLAMA_HOST。 -

在“变量值”输入框中输入

0.0.0.0,然后点击“确定”。

2.3 重启Ollama服务

完成环境变量设置后,需要重启Ollama服务以使配置生效。可以通过以下步骤重启Ollama服务:

-

打开命令提示符(以管理员身份运行)。

-

输入以下命令并按回车键:

ollama restart

三、开放防火墙端口

Ollama服务默认使用端口11434。为了允许局域网中的其他设备访问该服务,需要在Windows防火墙中开放此端口。以下是两种开放端口的方法:

3.1 方法一:通过图形界面开放端口

-

打开“控制面板”,搜索并选择“Windows Defender 防火墙”。

-

在左侧点击“高级设置”,进入高级防火墙设置页面。

-

在左侧菜单中,点击“入站规则”,然后在右侧点击“新建规则”。

-

选择“端口”作为规则类型,点击“下一步”。

-

选择“TCP”,在“特定本地端口”一栏中输入

11434,点击“下一步”。 -

选择“允许连接”,点击“下一步”。

-

根据需求选择应用的网络类型(域、专用或公用),点击“下一步”。

-

为这条规则命名(如“Allow Ollama Port 11434”),点击“完成”。

3.2 方法二:通过命令行开放端口

-

打开命令提示符(以管理员身份运行),使用以下命令为Ollama服务开放

11434端口(TCP协议):netsh advfirewall firewall add rule name="Allow Port 11434" dir=in action=allow protocol=TCP localport=11434 -

可以通过以下命令确认规则是否正确添加:

netsh advfirewall firewall show rule name="Allow Port 11434"

四、测试局域网访问

完成上述设置后,Ollama服务应该可以通过局域网中的其他设备访问。以下是测试步骤:

4.1 获取本机IP地址

-

打开命令提示符。

-

输入以下命令并按回车键:

ipconfig -

在输出结果中找到本机的局域网IP地址(如

192.168.1.100)。

4.2 在其他设备上访问

-

在局域网中的其他设备的浏览器中输入以下地址:

http://<你的本机IP地址>:11434例如:

http://192.168.1.100:11434 -

如果服务成功启动,页面应显示Ollama API的相关信息。

五、应用场景

5.1 多设备共享AI模型

在团队协作环境中,多个用户可能需要共享同一个AI模型。通过开放Ollama服务的局域网访问权限,团队成员可以在各自的设备上访问和使用该模型,而无需在每台设备上单独部署。这不仅可以节省资源,还可以提高工作效率。

5.2 远程开发与调试

开发者可以在一台设备上部署Ollama服务,并通过局域网访问的方式在其他设备上进行开发和调试。这种模式特别适用于需要在不同设备上测试模型性能的场景。

5.3 教学与培训

在教学和培训环境中,教师可以在一台设备上部署Ollama服务,并通过局域网共享给学生。学生可以在各自的设备上访问和使用该服务,从而更好地理解AI模型的工作原理和应用方法。

六、注意事项

6.1 安全性

开放Ollama服务的局域网访问权限可能会带来一定的安全风险。为了确保系统的安全性,建议采取以下措施:

-

限制访问范围:仅允许局域网内的设备访问Ollama服务,避免将服务暴露在公共网络中。

-

使用强密码:如果Ollama服务支持身份验证,建议使用强密码保护服务。

-

定期更新:及时更新Ollama服务和Windows系统,以修复已知的安全漏洞。

6.2 性能优化

在开放局域网访问时,可能会对Ollama服务的性能产生一定的影响。为了优化性能,可以采取以下措施:

-

合理配置资源:根据实际需求,合理配置Ollama服务的资源(如内存、CPU等)。

-

负载均衡:如果需要支持大量并发访问,可以考虑使用负载均衡技术。

6.3 故障排查

在配置过程中,可能会遇到一些问题。以下是一些常见的故障排查方法:

-

检查环境变量:确保

OLLAMA_HOST环境变量已正确设置为0.0.0.0。 -

检查防火墙规则:确保防火墙规则已正确添加,并且允许

11434端口的流量。 -

检查网络连接:确保局域网中的设备可以正常通信。

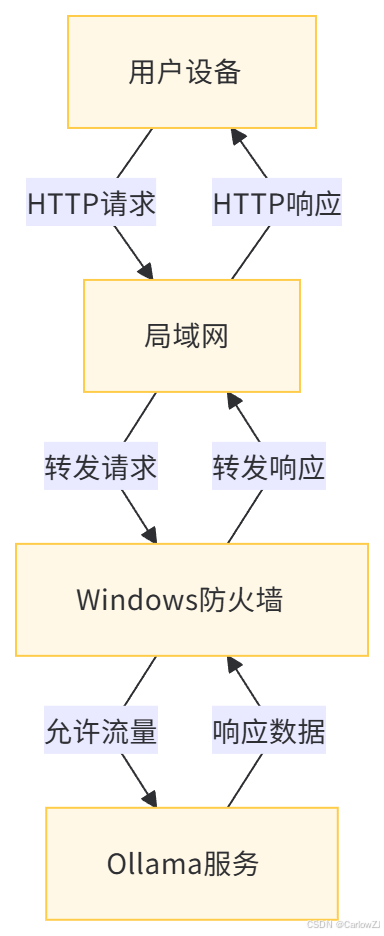

七、数据流图

以下是使用Mermaid格式绘制的Ollama服务局域网访问的数据流图:

7.1 数据流图说明

-

用户设备:局域网中的其他设备,通过浏览器或其他客户端工具向Ollama服务发送HTTP请求。

-

局域网:负责在设备之间转发请求和响应数据。

-

Windows防火墙:检查并允许

11434端口的流量。 -

Ollama服务:接收请求并处理,然后返回响应数据。

八、总结

本文详细介绍了如何在Windows系统中配置Ollama服务,使其能够被局域网中的其他设备访问。通过设置环境变量OLLAMA_HOST和开放Windows防火墙中的11434端口,可以实现Ollama服务的局域网共享。我们还探讨了Ollama服务的应用场景、注意事项以及故障排查方法。通过本文的介绍,读者可以轻松地在自己的局域网环境中部署和使用Ollama服务。

1765

1765

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?