本文 的 原文 地址

原始的内容,请参考 本文 的 原文 地址

本文作者:

- 第一作者 老架构师 肖恩(肖恩 是尼恩团队 高级架构师,负责写此文的第一稿,初稿 )

- 第二作者 老架构师 尼恩 (45岁老架构师, 负责 提升此文的 技术高度,让大家有一种 俯视 技术、俯瞰技术、 技术自由 的感觉)

三大核心协议:MCP、A2A与AG-UI

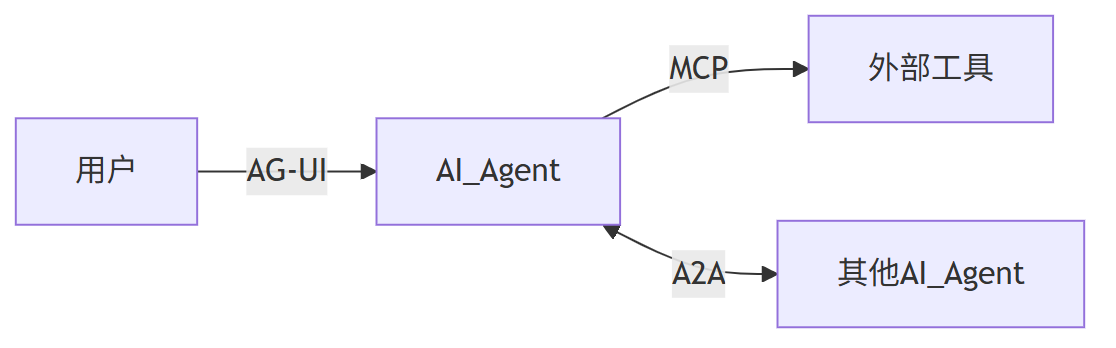

在AI应用中,我们通常会遇到三个角色:用户、AI Agent(智能助手)和外部工具。

要让这三者顺畅配合,就需要统一的沟通方式,也就是“协议”。

目前有三个主流协议正在被广泛应用:

(1)MCP协议 —— 让AI能用外部工具

MCP(Model Calling Protocol)解决AI Agent如何调用外部工具的问题。比如AI想查天气或操作数据库,MCP就像一个通用遥控器,让它可以顺利使用各种工具。

(2)A2A协议 —— 让AI之间能对话

A2A(Agent to Agent)是多个AI之间沟通的标准。当多个AI需要合作完成任务时,A2A确保它们能互相理解、协调工作。

(3)AG-UI协议 —— 让AI和界面友好互动

AG-UI(Agent to UI)规范了AI与前端界面之间的交互方式。这样用户通过网页或App使用AI功能时,体验更流畅、一致。

协议”三剑客“的意义

协议的 ”三剑客“

- MCP:AI调用工具的标准;

- A2A:AI之间协作的标准;

- AG-UI:AI与用户界面沟通的标准;

三者结合,构成了现代AI应用系统的通信骨架。

这些协议共同推动AI应用的发展,让开发更高效,用户体验更好。

现在AI基础模型的发展越来越集中,但AI应用层面依然充满机会。

有了这些标准协议,开发者可以更快地构建复杂系统,创造出更多实用的AI产品。

MCP协议

MCP全称是Model Context Protocol(模型上下文协议),由AI公司Anthropic在2024年11月开源推出。

从下图可以看到,从去年3月开始,MCP项目在GitHub上的关注度迅速上升,说明它越来越受到开发者和企业的重视。

MCP GitHub Star增长趋势

数据来源:star-history.com

MCP的发展背景

MCP的出现与“函数调用”功能密切相关。

早在2023年6月,OpenAI就在GPT-4和GPT-3.5中首次引入了Function Calling能力,让AI模型可以执行具体任务,比如查天气、搜索知识库、做数学计算等。

随后,谷歌和Anthropic也推出了类似的功能。

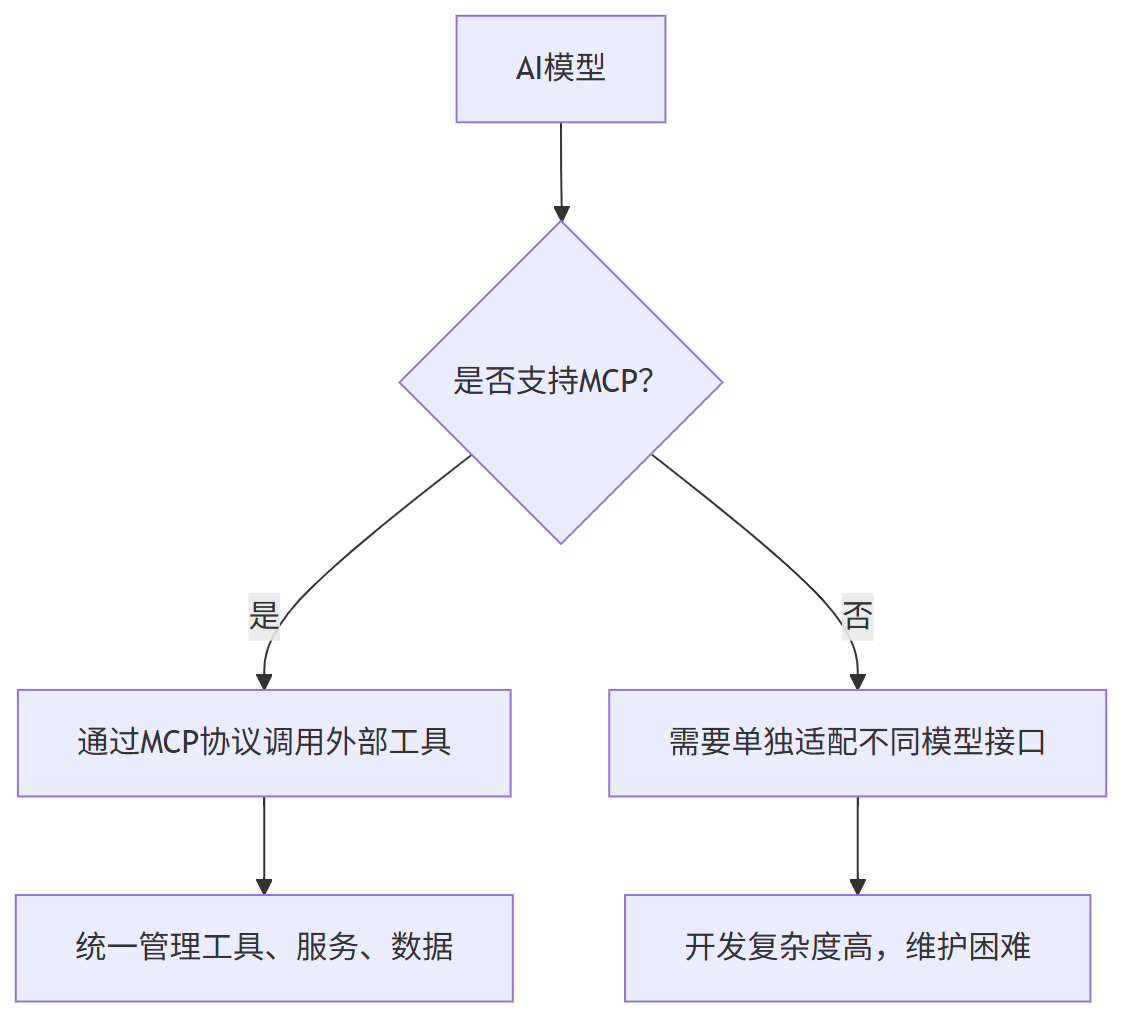

但问题来了:不同厂商的函数调用方式不统一,接口格式、参数设置都不一样。

举个例子:

这导致开发者要为每个模型单独写适配代码,开发成本很高。

MCP的作用

为了解决这个问题,MCP被提出来作为一个通用标准协议,让不同模型都能通过统一的方式访问外部工具和服务。

可以把它想象成电脑上的USB-C接口,不管插什么设备,只要支持这个接口就能直接用。

下图展示了MCP的基本架构,可以看出它如何帮助AI模型连接各种数据源和工具。

技术实现方式

虽然目前最常用的是通过Function Calling来实现MCP,但这不是唯一方式。

只要模型能理解并生成结构化的通信协议(如JSON-RPC、RESTful API等),就可以支持MCP。

Function Calling只是最主流、最推荐的做法。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

595

595

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?