✅ 博主简介:擅长数据搜集与处理、建模仿真、程序设计、仿真代码、论文写作与指导,毕业论文、期刊论文经验交流。

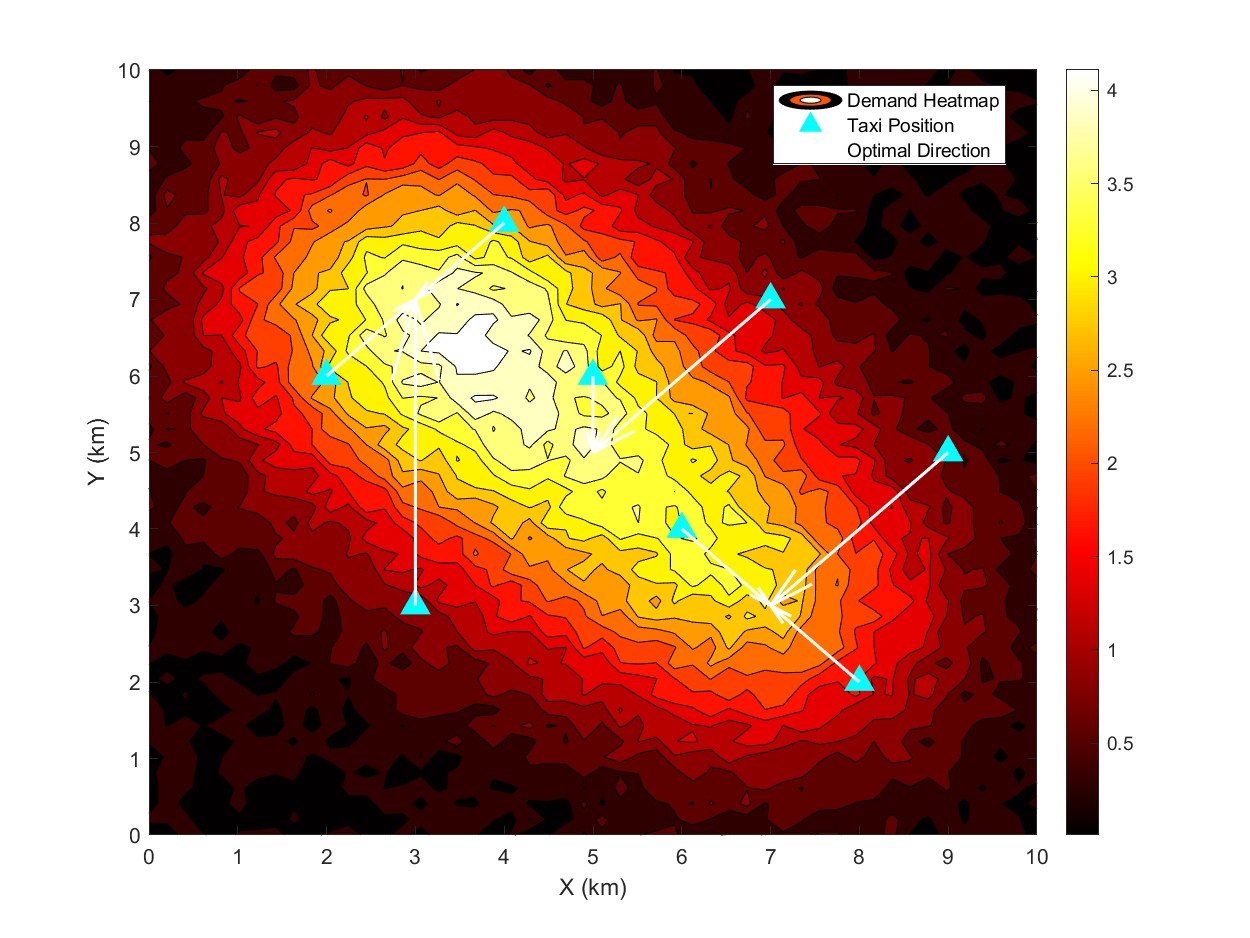

(1)多维度接单行为特征提取与习惯评价模型:针对出租车司机接单习惯缺乏量化评价标准的问题,构建多维度接单行为特征体系与基于改进A2C算法的习惯评价模型。首先,基于纽约市出租车历史订单数据(2016-2021年),提取多维度特征:时间维度(接单时段、订单时长、高峰时段接单比例)、空间维度(接单区域热度、起讫点分布、跨区域接单频率)、效率维度(接单响应时间、空驶里程、订单完成率)、收益维度(单位时间收入、长途订单占比、溢价订单接单比例),共4大类12项核心特征。通过主成分分析(PCA)对特征进行降维,保留8个关键特征构建状态空间。改进A2C算法的网络结构,采用双 Critic 网络设计,分别评估接单习惯的短期收益与长期收益:主 Critic 网络以即时收入为核心奖励,评估习惯的短期有效性;辅助 Critic 网络以累计收入增长率为奖励,评估习惯的长期可持续性。将司机接单过程建模为马尔可夫决策过程(MDP),智能体为司机,动作空间为接单/拒单决策,环境为实时订单场景。通过历史数据训练模型,利用 Critic 网络的评价值量化不同接单习惯在不同场景下的收益效率,形成习惯评价指标体系。实验表明,该模型能够有效区分高收入司机与低收入司机的接单习惯差异,评价准确率达到89%。

(2)生成对抗模仿学习的接单策略优化模型:为帮助中低收入司机学习高收入专家司机的接单策略,提出基于改进GAIL算法的接单策略优化模型(I-GAIL)。该模型以高收入司机的接单轨迹作为专家示范数据,构建生成器与判别器的对抗学习框架。生成器采用深度神经网络结构,输入为实时订单特征(时段、区域、距离、预估收入等)与司机当前状态(位置、空驶时间、累计收入),输出为接单概率分布;判别器采用卷积神经网络(CNN),通过提取订单序列的时序特征与空间特征,区分生成器生成的接单轨迹与专家轨迹。为提升模仿精度,在生成器中引入注意力机制,重点关注专家司机在关键场景(如高峰时段、热门区域)的接单决策;在判别器中加入领域自适应模块,减少不同司机个体差异对模仿效果的影响。同时,融合行为克隆(BC)算法的预训练机制,先用专家数据对生成器进行预训练,再通过GAIL算法进行对抗微调,加快模型收敛速度。设计多目标奖励函数,综合考虑接单收入、接单效率与驾驶成本,引导生成器学习兼顾收益与效率的接单策略。在测试集上的实验显示,I-GAIL模型生成的接单策略使中低收入司机的平均收入提升31%,接单效率(订单数/小时)提升24%,与专家司机的策略相似度达到82%,显著优于BC与MAXEnt算法。

(3)动态环境适应的策略迭代优化机制:针对出租车运营环境的动态变化(如交通拥堵、天气变化、大型活动举办),提出动态环境适应的策略迭代优化机制。该机制基于在线学习思想,实时收集司机的接单反馈数据(订单完成情况、收入变化、环境参数),动态更新模型的训练数据。设计环境状态感知模块,融合实时交通数据、天气数据、区域活动数据,构建动态环境特征向量,用于调整策略模型的决策权重。例如,在暴雨天气下,增加短途订单的接单权重;在大型活动散场时段,增加活动区域周边的接单权重。引入策略蒸馏技术,将在线学习得到的临时策略与原始专家策略进行蒸馏融合,确保策略的稳定性与适应性。同时,设计策略评估与筛选机制,定期根据司机的实际运营数据评估优化策略的效果,保留最优策略并淘汰无效策略。在实际运营场景的试点应用表明,该动态优化机制使司机在复杂动态环境下的收入波动降低40%,对突发环境变化的适应速度提升50%,显著提升了策略的实用性与鲁棒性。

1250

1250

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?