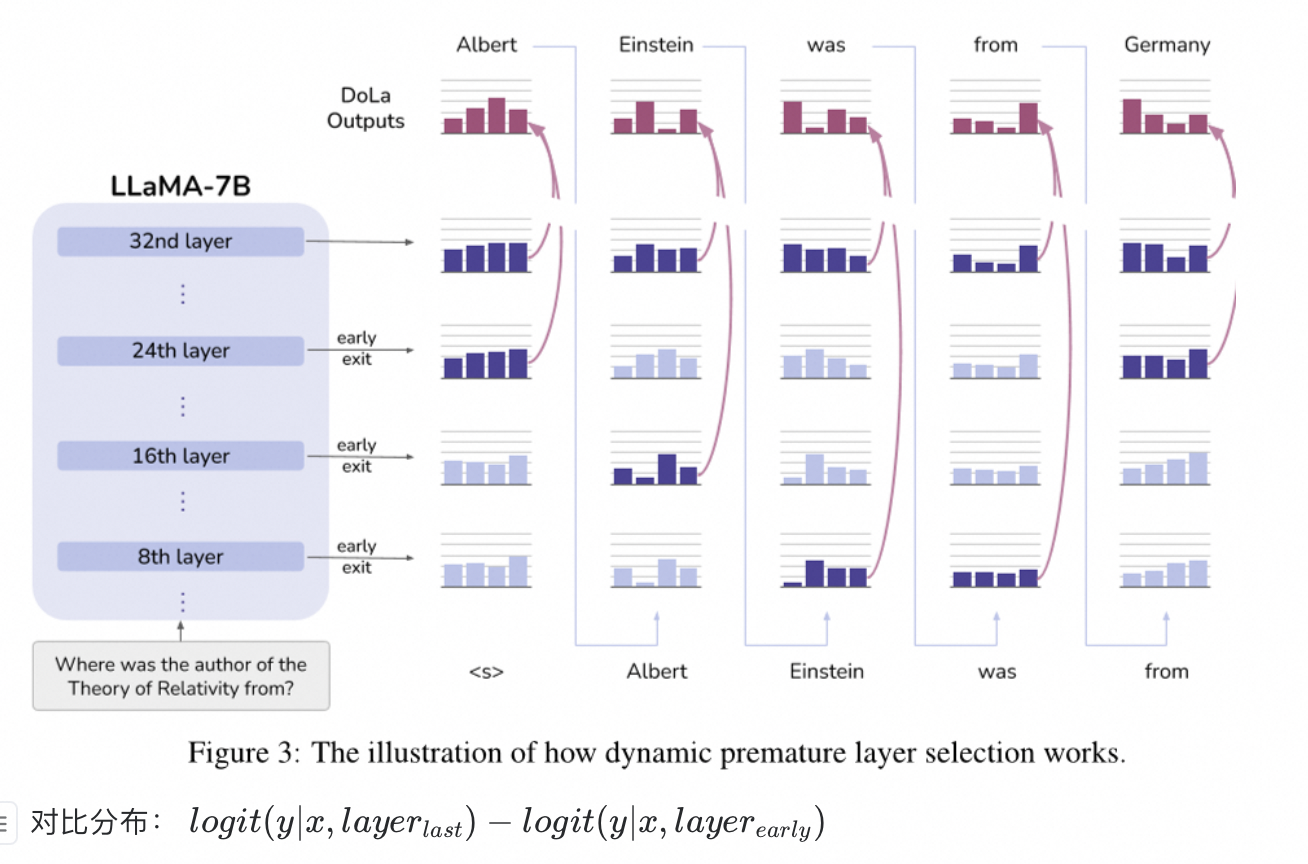

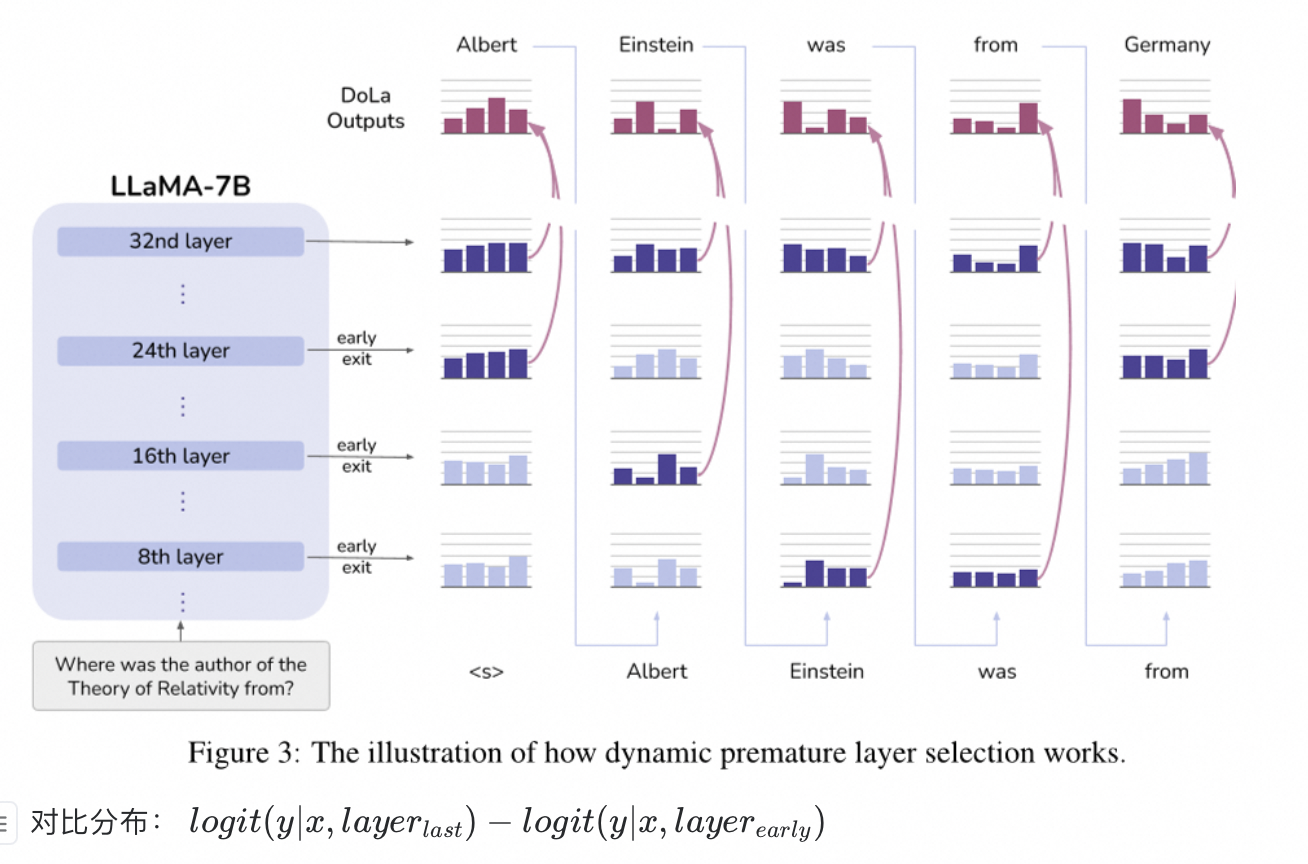

实现方式

对比最后一层出来的logit,和前面Layer出来的logit,消除差异过大的分布,从而降低幻觉:

-

最后一层Layer出来的logit容易的得到;

-

选择与最后一层的logit最不相似的分布的那层结果

实现原理

也是很简单的对比方式,最终的logit由最后一层的Layer输出的logit,减去前期选择的层的logit,

得到最终的logit

本文介绍了一种深度学习模型中减少幻觉现象的方法,通过比较最后一层的logit与其他层的结果,选择最不相似的分布进行融合,以此来改进模型的性能。这种方法通过简单的对比策略调整logit值,有助于提高模型的稳定性和准确性。

本文介绍了一种深度学习模型中减少幻觉现象的方法,通过比较最后一层的logit与其他层的结果,选择最不相似的分布进行融合,以此来改进模型的性能。这种方法通过简单的对比策略调整logit值,有助于提高模型的稳定性和准确性。

对比最后一层出来的logit,和前面Layer出来的logit,消除差异过大的分布,从而降低幻觉:

最后一层Layer出来的logit容易的得到;

选择与最后一层的logit最不相似的分布的那层结果

也是很简单的对比方式,最终的logit由最后一层的Layer输出的logit,减去前期选择的层的logit,

得到最终的logit

您可能感兴趣的与本文相关的镜像

Anything-LLM

AnythingLLM是一个全栈应用程序,可以使用商用或开源的LLM/嵌入器/语义向量数据库模型,帮助用户在本地或云端搭建个性化的聊天机器人系统,且无需复杂设置

2457

2457

623

623

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?