在数据安全与合规要求日益严苛的今天,企业拥抱AI的最大痛点在于如何平衡智能化与隐私保护。云端大模型虽强大,却让敏感数据暴露于不可控风险中。本地私有化部署,正从技术选项升级为企业智能化的战略刚需。

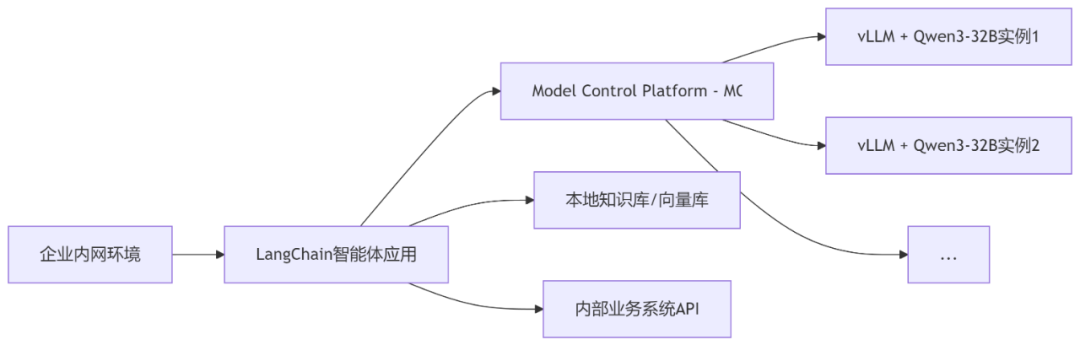

本文将手把手带你用 LangChain(智能体框架) + vLLM(高性能推理引擎) + Qwen3-32B(国产最强开源大模型之一),构建一套完全运行在内网环境的企业级智能体应用,实现数据不出域、响应低延迟、部署自主可控。

为什么是这套技术组合?

-

Qwen3-32B:国产翘楚,能力担当

-

通义千问团队开源的最新32B参数版本,中英文能力均衡,逻辑推理、代码生成、知识问答表现优异。

-

Apache 2.0协议,完全免费商用,规避版权风险。

-

提供GGUF量化版本,显著降低部署资源需求。

-

-

vLLM:推理加速神器

-

由加州伯克利大学开源的高性能LLM推理引擎。

-

核心利器 PagedAttention:像操作系统管理内存一样高效管理KV Cache,大幅减少显存浪费。

-

Continuous Batching(连续批处理):动态合并不同用户的请求,GPU利用率飙升。

-

官方支持Qwen系列,开箱即用。

-

-

LangChain:智能体组装框架

-

提供丰富的模块化组件(Models, Chains, Agents, Tools, Memory, RAG)。

-

轻松连接本地模型(vLLM)、本地知识库、业务系统API。

-

智能体(Agent)能力:让大模型学会调用工具、规划步骤,完成复杂任务。

-

-

MCP(Model Control Platform - 概念性组件)

-

代表企业内部的模型管理与服务层(可自研或选用开源方案如OpenLLM、Truss)。

-

核心功能:模型版本管理、服务监控、负载均衡、安全审计。

-

为上层LangChain应用提供稳定可靠的模型API端点。

-

实战构建:四步搭建本地智能体

第一步:部署vLLM + Qwen3-32B服务

# 1. 安装vLLM

pip install vllm

# 2. 启动vLLM服务 (以Qwen-32B-Chat的GGUF版本为例)

# 假设模型文件路径: /models/qwen1_5-32b-chat-q4_k_m.gguf

vllm-server --model /models/qwen1_5-32b-chat-q4_k_m.gguf \

--served-model-name qwen-32b-chat \

--port 8000 \

--quantization gptq \ # 根据GGUF类型调整

--max-model-len 8192 # 支持长上下文

第二步:配置LangChain连接vLLM服务

from langchain_community.llms import VLLMOpenAI

# 指向本地vLLM服务端点

llm = VLLMOpenAI(

openai_api_key="EMPTY", # vLLM不需要key

openai_api_base="http://localhost:8000/v1", # vLLM服务地址

model_name="qwen-32b-chat", # 与served-model-name一致

max_tokens=4096,

temperature=0.7,

top_p=0.9

)

第三步:组装智能体(Agent)

from langchain.agents import AgentType, initialize_agent, Tool

from langchain.tools import DuckDuckGoSearchRun, BaseTool

from langchain.memory import ConversationBufferMemory

# 示例工具1: 内部知识库检索 (需自行实现RAG)

class InternalKBSearchTool(BaseTool):

name = "Internal_KB_Search"

description = "查询公司内部产品文档、技术手册、政策文件知识库"

def _run(self, query: str) -> str:

# 实现对接本地Milvus/Chroma+Embedding模型的检索逻辑

return search_internal_kb(query)

# 示例工具2: 业务系统查询API

class SalesDataQueryTool(BaseTool):

name = "Query_Sales_System"

description = "查询当前季度的销售数据、客户订单状态"

def _run(self, customer_id: str) -> str:

# 调用内部Sales系统的API (假设已存在)

return get_sales_data(customer_id)

# 创建工具列表

tools = [

DuckDuckGoSearchRun(name="Web_Search"), # 可选,如需可控外网搜索

InternalKBSearchTool(),

SalesDataQueryTool()

]

# 创建带记忆的Agent

memory = ConversationBufferMemory(memory_key="chat_history")

agent = initialize_agent(

tools,

llm, # 上一步配置的vLLM-Qwen模型

agent=AgentType.CHAT_CONVERSATIONAL_REACT_DESCRIPTION, # 适合多轮对话

memory=memory,

verbose=True# 打印详细执行过程

)

第四步:构建应用接口 & 部署

-

Web API:使用FastAPI/Flask封装agent,提供RESTful接口。

-

前端交互:搭配Gradio/Streamlit构建聊天界面,或集成到企业微信/钉钉。

-

安全加固:

-

网络隔离:部署在研发内网,仅允许特定IP访问。

-

身份认证:集成企业AD/LDAP或JWT。

-

输入输出过滤:防范Prompt注入。

-

关键优势:为什么企业必须关注本地化部署?

-

数据绝对安全:核心业务数据、客户信息、商业秘密100%留存本地,无泄漏风险。

-

极致低延迟:模型推理在本地GPU完成,告别网络波动,关键业务响应毫秒级。

-

完全自主可控:模型选型、版本升级、系统扩缩容完全由IT团队掌控。

-

成本优化:长期使用下,避免按Token付费的云端模式,总拥有成本(TCO)更低。

-

深度定制集成:无缝对接企业内部数据库、ERP、CRM系统,打造真正懂业务的AI。

性能优化Tips

-

模型量化:使用GGUF格式的Q4_K_M或Q5_K_M量化版,显存占用降低50%+,速度损失极小。

-

vLLM参数调优:

-

调整

--tensor-parallel-size利用多卡。 -

根据显存设置

--gpu-memory-utilization(默认0.9)。

-

-

智能体缓存:对频繁查询(如产品FAQ)引入Redis缓存,减少大模型调用。

-

异步处理:使用LangChain的异步接口提升并发吞吐量。

开启企业智能化“安全模式”

LangChain + vLLM + Qwen3-32B的技术栈,为企业在数据安全与AI能力之间找到了最佳平衡点。这套方案不仅适用于对话机器人,更能扩展至智能客服、数据分析助手、代码生成、内部知识引擎等核心场景。

技术没有绝对壁垒,真正的竞争力在于如何让AI在安全的前提下深度融入业务血脉。本地私有化不是限制,而是企业智能化升级的基石。

附录:部署资源参考(供技术负责人评估)

-

最低配置(流畅运行Qwen-7B量化版):

-

GPU: NVIDIA A10 (24GB) / RTX 4090 (24GB)

-

RAM: 32GB

-

Disk: 100GB (用于模型、知识库)

-

-

推荐生产配置(运行Qwen-32B,支持并发):

-

GPU: 2x NVIDIA A100 40GB / H100

-

RAM: 64GB+

-

Disk: 200GB+ SSD

-

立刻动手,用开源的力量打造属于你的企业级智能大脑!

Playwright学习交流

推荐阅读:

手把手玩转本地大模型:Ollama+DeepSeek+Dify 零门槛全流程指南

Playwright系列

Playwright 自动化测试系列(7)| 第三阶段:测试框架集成Page Object 模式

Playwright 自动化测试系列(6)| 第三阶段:测试框架集成指南:参数化测试 + 多浏览器并行执行

Playwright自动化测试系列课(5) | 调试神器实战:Trace Viewer 录屏分析 + AI 辅助定位修复

Playwright自动化测试系列课(4) | 异步加载克星:自动等待 vs 智能等待策略深度解析

Playwright自动化测试系列课(3) | 第二阶段:核心技能与调试 交互操作大全

Playwright系列课(2) | 元素定位四大法宝:CSS/文本/XPath/语义化定位实战指南

Playwright 极速入门:1 小时搞定环境搭建与首个测试脚本

1799

1799

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?