文章核心总结与翻译

一、主要内容

本文提出原生并行推理器(Native Parallel Reasoner, NPR),这是一个无需教师模型的框架,旨在让大型语言模型(LLMs)自主进化出真正的并行推理能力,将模型从串行思维链(CoT)推理转变为原生并行认知。

核心背景与问题

现有LLM推理存在三大缺陷:1)算法与架构不兼容,主流推理引擎和强化学习(RL)算法无法支持原生分支推理;2)手工设计的并行机制效率低下,未充分利用KV缓存导致冗余计算;3)依赖有监督蒸馏,受限于教师模型的推理拓扑,存在“智能天花板”。

技术框架

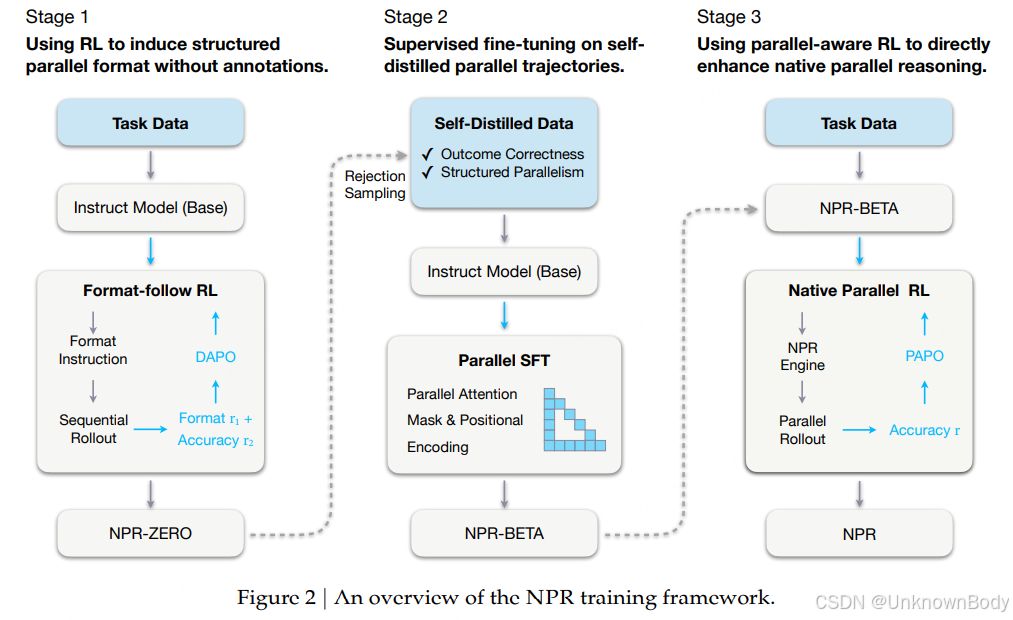

NPR通过三阶段渐进式训练实现并行推理能力:

- 格式遵循强化学习(Stage 1):基于DAPO算法,在无外部标注的情况下诱导模型发现有效的并行结构,生成结构化轨迹生成器NPR-ZERO(模拟并行);

- 拒绝采样与并行预热(Stage 2):对NPR-ZERO的输出进行筛选(保证结果正确性和格式规范性),通过并行位置编码和注意力掩码注入严格的拓扑约束,得到NPR-BETA(原生并行初始化);

- 原生并行强化学习(Stage 3)

订阅专栏 解锁全文

订阅专栏 解锁全文

2463

2463

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?