windows安装nvidia驱动

确保在cmd下可使用nvidia-smi命令,命令输出正常代表显卡驱动已经安装成功

并且记住自己的cuda版本,我这里是12.7,后面很多地方都要用到这个版本号

C:\Users\Administrator>NVIDIA-SMI

Sun Nov 30 10:21:57 2025

+-----------------------------------------------------------------------------------------+

| NVIDIA-SMI 566.43 Driver Version: 566.43 CUDA Version: 12.7 |

|-----------------------------------------+------------------------+----------------------+

| GPU Name Driver-Model | Bus-Id Disp.A | Volatile Uncorr. ECC |

| Fan Temp Perf Pwr:Usage/Cap | Memory-Usage | GPU-Util Compute M. |

| | | MIG M. |

|=========================================+========================+======================|

| 0 NVIDIA GeForce RTX 4050 ... WDDM | 00000000:01:00.0 On | N/A |

| N/A 44C P5 4W / 95W | 1355MiB / 6141MiB | 38% Default |

| | | N/A |

+-----------------------------------------+------------------------+----------------------+

+-----------------------------------------------------------------------------------------+

| Processes: |

| GPU GI CI PID Type Process name GPU Memory |

| ID ID Usage |

|=========================================================================================|

| 0 N/A N/A 3104 C+G ...n 2025.1.1.1\jbr\bin\cef_server.exe N/A |

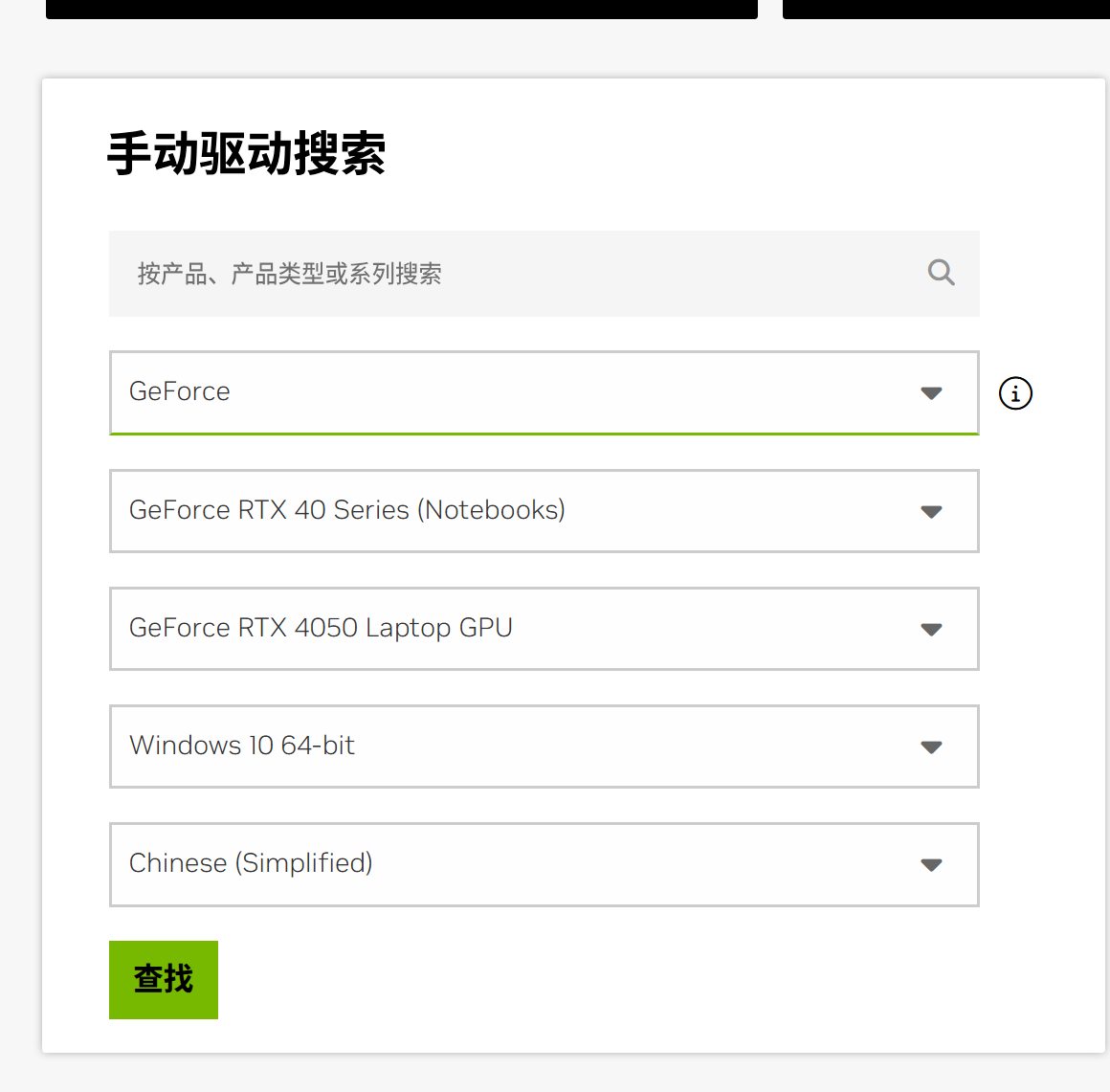

nvidia可以根据产品找到对应的驱动:

https://www.nvidia.cn/drivers/lookup/

需要使用studio版本的驱动.不要用game的驱动

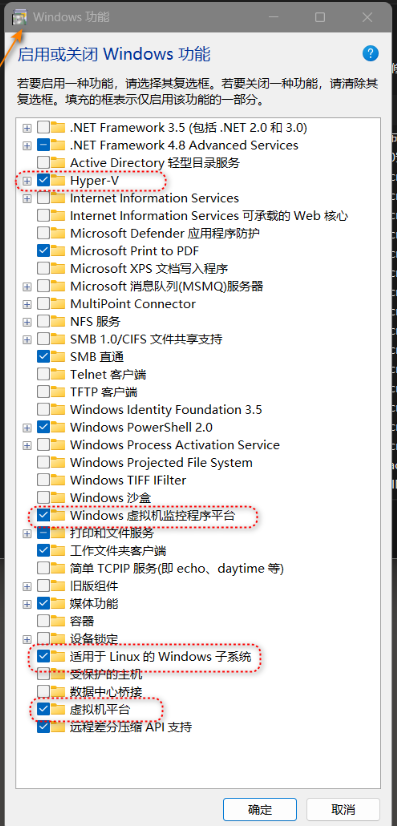

创建WSL2

windows自带的WSL是WSL1,我们需要升级成WSL2,升级WSL2的具体过程请自行百度方案,这里只记录几个关键过程

1要开启CPU虚拟化,

2 选择一个Ubuntu镜像,网上很多教程是需要在Microsoft store里面下载镜像,但是这个商店经常打不开,可以使用其他方式下载.

比如ubuntu的下载:https://ubuntu.com/desktop/wsl

然后使用命令:

wsl --install --from-file Ubuntu2404-250130_x64.wsl

3 wsl默认装在C盘,可以迁移到D盘

4 设置wsl默认使用的系统,

C:\Users\Administrator>wsl -l

适用于 Linux 的 Windows 子系统分发:

Ubuntu-24.04 (默认)

docker-desktop

更新和配置ubuntu系统

ubuntu创建完之后需要对系统进行配置才能更顺滑的安装NVIDIA等

设置ubuntu更新源到国内,加快网速:

我这里是24.04,和之前版本的ubuntu设置的方式不太一样,

更改/etc/apt/sources.list.d/ubuntu.sources这个文件,到如下(要根据自己下载的ubuntu的版本更改文件内容,请自行百度)

# 阿里云

Types: deb

URIs: http://mirrors.aliyun.com/ubuntu/

Suites: noble noble-updates noble-security

Components: main restricted universe multiverse

Signed-By: /usr/share/keyrings/ubuntu-archive-keyring.gpg

更新系统软件

sudo apt-get update

sudo apt-get upgrade

安装必要的软件

需要额外安装ubuntu的软件,执行下面的命令进行安装

sudo apt-get install -y build-essential dkms

build-essential 是编译相关的软件包,里面包含c++的相关东西,

dkms 与linux内核有关,可是让显卡驱动程序适配的更好

禁用开源nvdia的驱动程序

Nouveau 是一个开源的nvidia的显卡驱动,如果存在这个驱动会有问题,使用linux的内核黑名单机制进行禁用

创建文件:

/etc/modprobe.d/blacklist-nouv.conf

文件内容:

blacklist nouveau

blacklist lbm-nouveau

options nouveau modeset=0

blacklist表示禁用驱动,options表示禁用内核参数

文件编辑完成后需要对系统进行更新:

update-initramfs -u

update-initramfs 是在 Linux 系统中用于更新 initramfs 归档文件的一个命令。initramfs(初始内存文件系统)是一个临时的根文件系统,它在系统启动过程中加载到内存中。它包含了启动时直到可以挂载真正的根文件系统所必需的驱动程序和工具。这个机制允许内核在实际的根文件系统可用之前,访问硬件设备,如磁盘控制器和网络接口。

如果提示命令不存在,可以先用apt-get安装这个程序

然后对linux进行重启.

如果使用其他linux系统需要参考下面的文章:

https://support.huawei.com/enterprise/zh/doc/EDOC1100128448/3f25d09f

安装miniconda,管理python环境

在家目录创建一个miniconda3的文件夹

在文件夹中下载miniconda的安装脚本

wget https://repo.anaconda.com/miniconda/Miniconda3-latest-Linux-x86_64.sh

然后使用bash执行这个脚本

bash ~/miniconda3/miniconda.sh -b -u -p ~/miniconda3

安装完成之后激活miniconda3,

bash

~/miniconda3/bin/conda init bash

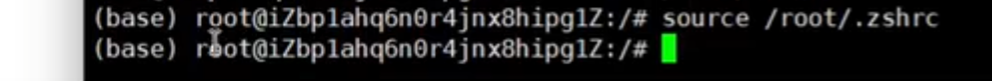

对于zsh文件

~/miniconda3/bin/conda init zsh

然后使用source命令让path命令得到更新,

对与bash: source /root/.bashrc

执行之后,会在命令行最前面出现一个base的只是,代表当前是base的python环境

使用conda创建一个3.12的python环境

conda create --name vllm python=3.12

conda activate vllm

这样命令行前面的base会变成vllm.

教程后面所有的命令执行都需要在vllm环境下进行.

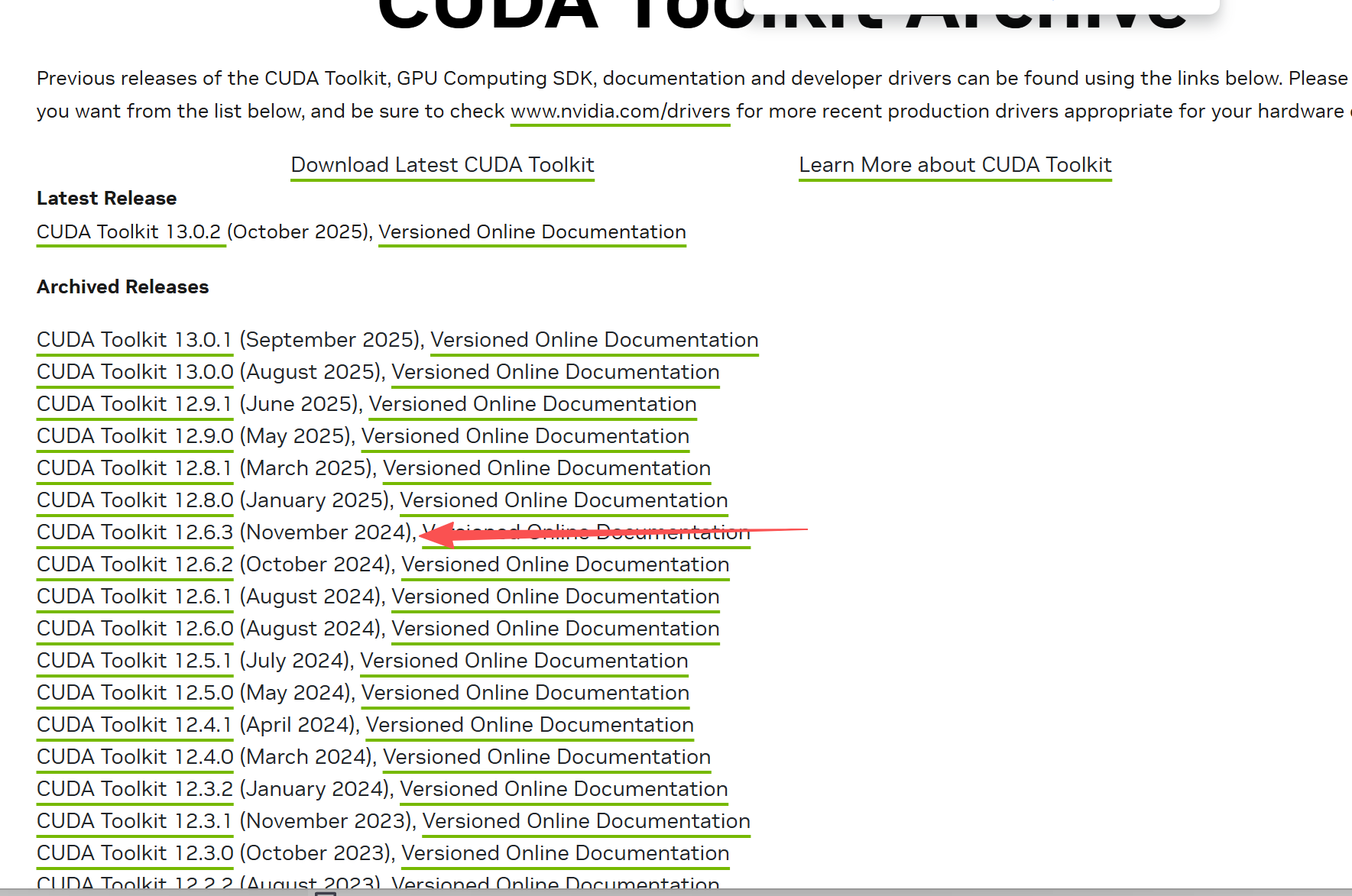

安装cuda

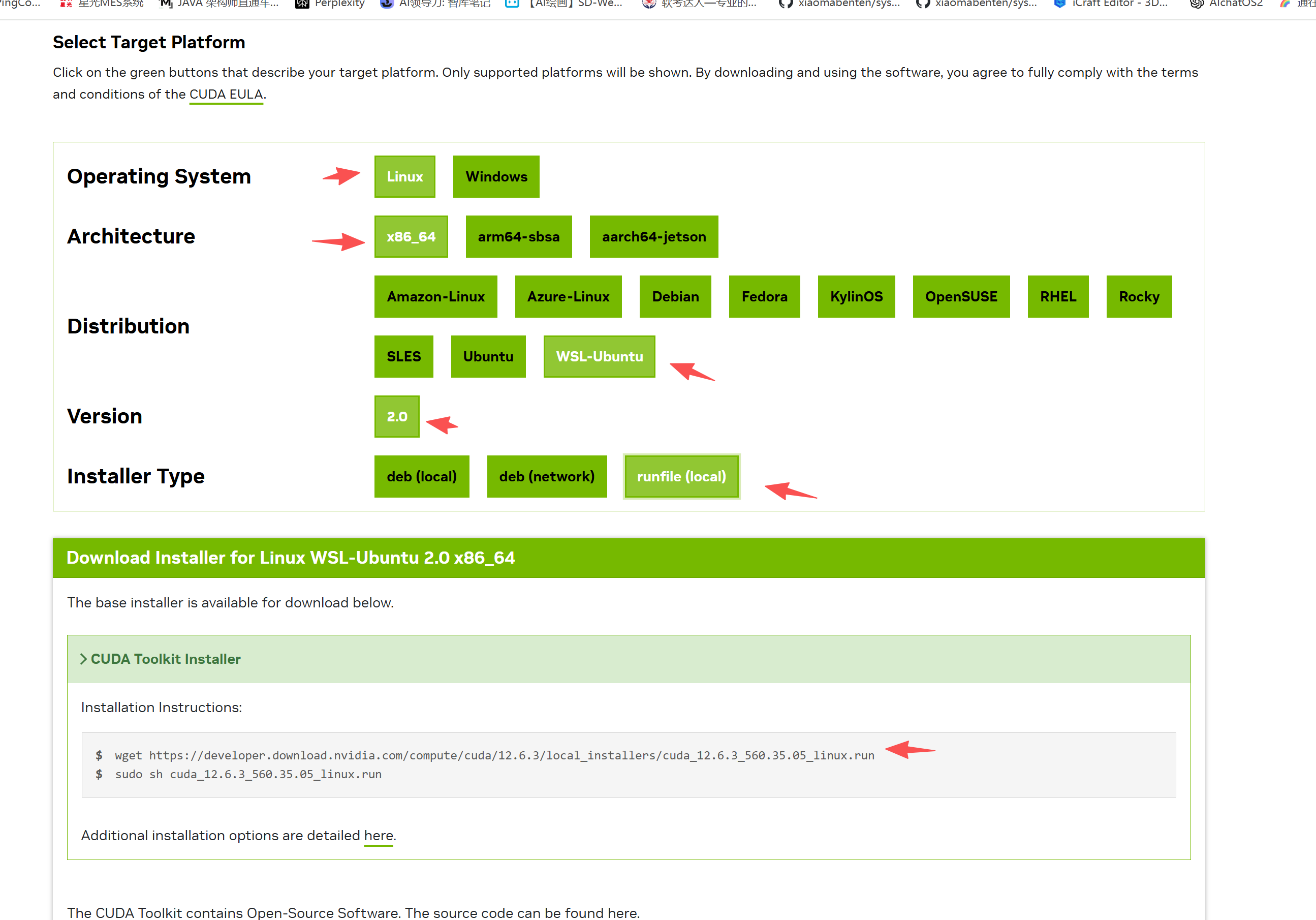

访问这个网站:

https://developer.nvidia.com/cuda-toolkit-archive

找到你对应的nvidia-smi命令下得到的cuda版本,如果有一样的就选一样,不一样就选低一个版本的,我是12.7…这边的tookit就只能选择12.6.3

然后选择对应的版本,把这个run文件下载下来.不要用wget下载,我使用迅雷下来的.

下载下来之后,需要在命令中运行, 下面的命令需要替换成具体的文件名,记得在文件的所在的目录执行命令

首先给文件增加运行权限 chmod a+x cuda*****.run

./cuda****.run

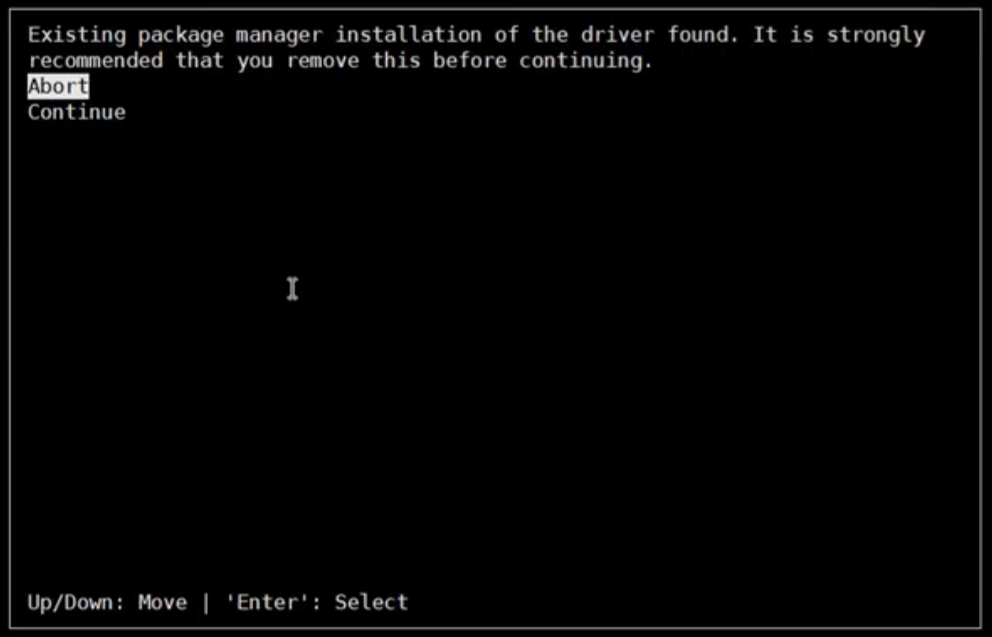

如果弹出下面的界面,选择continue,这是因为他找到了驱动,后面可以选择不另外安装驱动就好了

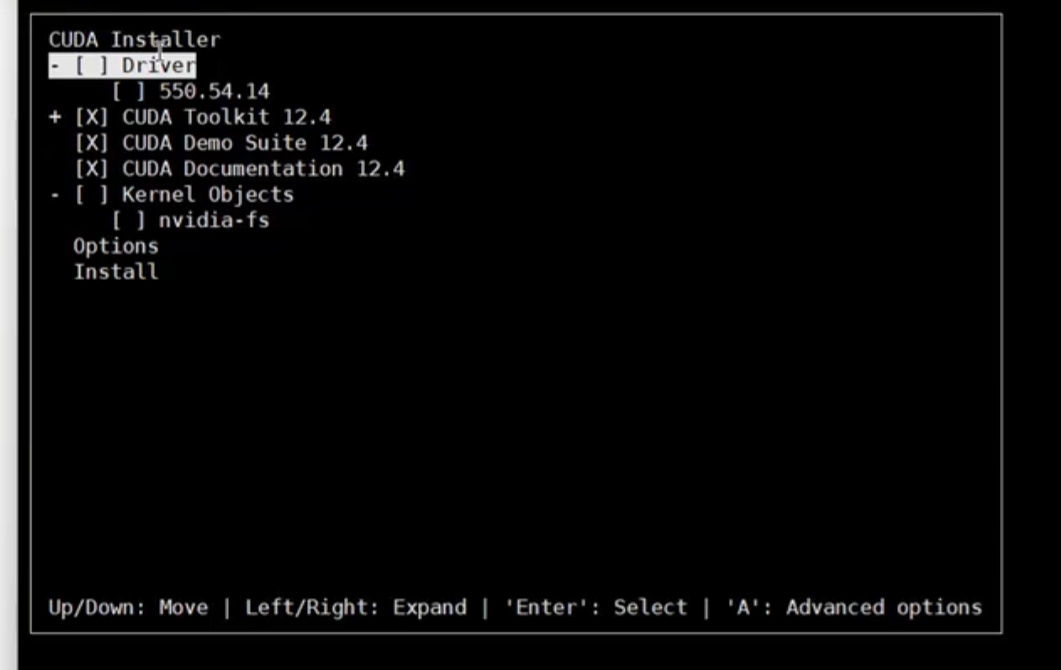

如果driver这边有X,代表重新安装驱动,我们按下回车把driver这行变空…然后继续选择install等待安装完成

安装完成之后需要配置环境变量. 文件内容的cuda版本需要根据实际安装的版本进行变更.

export LD_LIBRARY_PATH=$LD_LIBRARY_PATH:/usr/local/cuda-12.6/lib64

export PATH=$PATH:/usr/local/cuda-12.6/bin

export CUDA_HOME=$CUDA_HOME:/usr/local/cuda-12.6

安装完成之后,需要执行source ~/.bashrc命令更新命令行环境

确认安装完成,可以执行nvcc --version

(vllm) abc@MS-DFVZOBLLJNXI:/etc/modprobe.d$ nvcc --version

nvcc: NVIDIA (R) Cuda compiler driver

Copyright (c) 2005-2024 NVIDIA Corporation

Built on Tue_Oct_29_23:50:19_PDT_2024

Cuda compilation tools, release 12.6, V12.6.85

Build cuda_12.6.r12.6/compiler.35059454_0

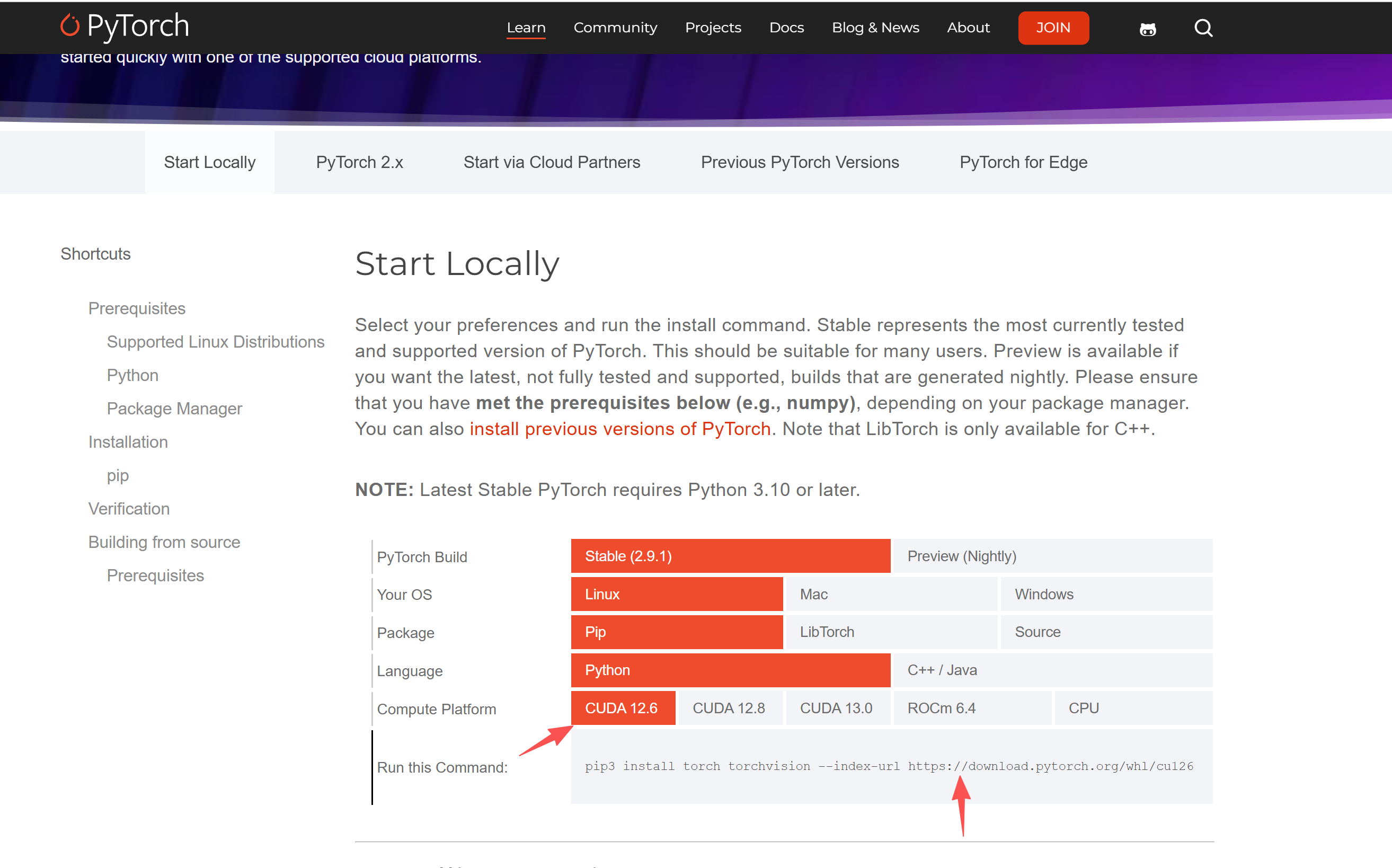

安装pytorch

pythorch不要用pip安装,因为pip无法解析cuda的版本.需要使用官方的工具安装.

https://pytorch.org/get-started/locally/

安装vllm

pip install vllm

确认安装成功

(vllm) abc@MS-DFVZOBLLJNXI:/etc/modprobe.d$ vllm --version

0.11.2

3229

3229

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?