提升远程呈现移动机器人在远程家庭护理协助中的自主性

摘要

在医疗保健领域,远程呈现机器人可用于让临床医生或护理人员在无需前往现场的情况下,协助老年人在其家庭中。然而,这些平台在该类应用中的可用性要求其具备一定程度的自主性,以实现导航和交互。例如,当电量不足或发生通信故障时,机器人应能够自主前往充电站。远程操作员可借助机器人在家庭环境中安全导航以及跟踪和跟随交互对象的能力获得辅助。这需要在一个配备适当感知与动作模态的平台上集成自主决策能力,并在实验室和真实家庭环境中进行验证。为了记录和研究这些转化问题,本文介绍了一种在Beam远程呈现平台上实现的集成方案,该方案使用了三个开源库,分别用于集成化机器人控制架构、自主导航和声音处理,这些库的设计满足实时性、有限计算资源和鲁棒性的要求,以便能够在真实生活场景中运行。所构建的平台被命名为SAM,其验证结果基于在10个家庭中开展的试验。观察结果为后续改进提供了指导,并将有助于识别面向老年人、临床医生和护理人员的可用性研究中的交互场景。

关键词 :移动机器人助手,辅助远程临场,自主导航,语音跟踪,机器人控制架构,家庭环境中的评估

1 引言

全球范围内,人口老龄化带来的问题推动了包括机器人技术在内的新技术的发展,以提供家庭护理[1,2],远程家庭医疗,或称家庭远程医疗,是指将医疗保健服务延伸到患者-的家中’,这无疑是远程呈现移动机器人感兴趣的领域[3] ——[4–9]例如,在远程家庭医疗访问、生命体征监测以及日常生活活动(ADL)辅助等任务中[9]。

移动远程临场机器人平台通常由移动底盘、摄像头、屏幕、扬声器和麦克风组成,使其成为移动视频会议系统,一些人常称之为“轮子上的Skype”[10]。过去十年中已有面向消费者的商用移动远程呈现机器人平台(参见参考文献[4,8,11–16]中的综述),这些平台为医院、办公室和家庭中的传感器、执行器和交互设备提供了移动能力[17], ,并提出了推动其在实际场景中应用的建议。大多数平台不具备自主性或仅有有限自主性[4,8,18],根据参考文献[4],,这归因于简化设计、可扩展性和经济性的考虑。对于远程家庭护理应用而言,远程操作员很可能是机器人新手用户(例如临床医生、护理人员),若能在操作环境中获得导航辅助,以及实现对交互对象的跟随与跟踪(通过视觉和声源定位),将大有裨益[4,16,19][4,18]。此类能力可最大限度减少远程操作员控制平台所需的操作,使其更专注于通过远程呈现完成交互任务[4,20]。

此外,大多数关于远程呈现的研究根本没有在真实环境中进行评估,也没有强调所遇到的困难及其设计的局限性。自主能力在实验室条件下可能表现良好,但在家庭环境中部署时仍可能存在局限性,因此这一点非常重要。

在这种条件下进行试验,以推进远程呈现移动机器人在远程家庭护理辅助中的应用[4]。

在真实家庭环境中利用远程呈现移动机器人解决自主性和试验问题,需要拥有具备目标自主能力的此类平台。本文介绍了我们如何通过开发SAM来应对这些设计考虑,SAM是一款来自Suitable Technologies Inc.公司的增强型远程呈现机器人,通过具有导航和声音处理能力的机器人控制架构进行编程。为了受益于这些领域的进展,并能够专注于为远程家庭护理辅助设计机器人时的集成挑战,我们方便地使用了研究社区设计并使用的开源库。这些库在设计时考虑了在线处理和现实世界约束,适用于在线处理能力有限的机器人;并且由于是开源的,它们为实验目的提供了可复制的实现。

文中展示了在10个家庭环境-中(公寓、住宅和老年居所)进行试验的结果。通过在房间内移动或前往不同房间,评估了自主导航能力,包括到达航路点或返回充电站的能力。同时也在安静和嘈杂环境中评估了自主对话跟随能力。这些试验的目的是在开展可用性研究之前,在真实家庭环境中评估SAM,以确定需要做出的改进以及其自主能力可在何种条件下使用。

本文组织如下。首先,第2节介绍了用于家庭护理的远程呈现机器人相关工作,以及我们在机器人平台、机器人控制架构和导航与声音处理能力方面的设计选择。第3节和第4节分别介绍了SAM的硬件和控制实现。第5节描述了用于测试SAM在家庭环境中自主能力的实验方法,随后第6节展示结果与观察。第7节阐述了本研究的局限性,第8节对全文进行总结。

2 相关工作和设计选择

据我们所知,ExCITE(Enabling SoCial Inter‐action Through Embodiment)项目——使用Giraff远程呈现机器人,是唯一一个针对家庭护理环境中的远程呈现问题开展的研究。该项目展现了非常用于远程家庭护理协助的移动机器人部署的有趣且详细的方法论、观察结果以及未来推进的需求。Gira-ff机器人平台是一个封闭系统,仅在瑞典境内以11,900美元的价格销售。1 它配备了一个带广角镜头的变焦摄像头、一个麦克风、一个扬声器、一个安装在底盘顶部的13.3′′液晶显示屏,以及用于为其电池充电的充电站[29]。

Giraff机器人用于为老年人提供安全防护、医疗随访以及日常活动协助。它拥有自己的中间件,用于连接传感器[29,30]。家庭传感器、医疗传感器和Giraff机器人连接到基于云的系统,以获取各类传感器采集的信息,用于监测患者活动,例如评估每日坐在椅子上的时间,检测老年人所处的房间,监测体重、血压和血糖水平。报告涵盖了在三个欧洲国家的21个测试点进行的为期42个月的短期和长期研究[4,25,28],,并结合了关于用户需求、验证-以及设计建议的深入定量与定性研究方法[20,26,27]和设计建议[4]。

其中一个建议如下:“面向老年人家庭使用的 MRP系统的开发者应努力提供障碍物检测功能,以及显示机器人位置的地图,以简化对接过程-”。[4]这一功能至关重要,可避免在会话结束时需要远程操作员远程操控机器人返回其充电站,或在电量低或远程通信-故障时由住户将机器人移开。[4]这要求机器人具备建图与定位能力,使其能够在家庭环境中高效且安全地导航。效率地安全导航所需的自主能力(使用二维激光雷达和摄像头)以及用户界面的高级描述已有所提供。然而,这些信息不足以重新实现相关功能,其性能表现也尚未明确表征。为了基于ExCITE项目中报告的研究成果进一步拓展,并在自主能力方面做出额外贡献,必须拥有一个远程呈现开发平台。为此,我们决定聚焦于三个与自主性相关的组件:机器人控制架构、自主导航和声音处理能力。每一项自主能力都带来了各自的独立挑战和集成挑战,每一项本身都是一个研究课题。由于对上述每个领域的技术现状进行详细综述超出了本文的范围,

2.1 机器人平台

对于家庭护理,远程呈现机器人应具备轻量化特点,以方便安装和操作,同时需具备稳定性,以防硬件故障或发生物理接触时造成潜在危险,并且价格应低廉。2015 年我们启动该项目时,首先对不同的远程呈现平台进行了综述[8],以确定是否需要自行设计,还是直接采用市场上已有的产品。大多数平台采用差速驱动方式,其中一些仅用两个轮子实现自平衡,这使得它们在有人倚靠时容易失去稳定。全向移动有助于在狭小空间内进行导航,在家庭环境中非常有用,前提是平台成本保持较低。

UBBO Maker机器人[32]具备此类能力,但其有效载荷有限,难以添加用于自主导航或生命体征监测的传感器。基于这些观察,我们选择使用Beam平台。当时,它是成本最低的平台之一(2000美元)。可通过参考文献中提供的库来与其接口,以通过速度指令控制电机并读取里程计信息。

2.2 机器人控制架构

为机器人提供更多的决策自主性需要使用机器人控制架构。机器人控制架构定义了应用程序所需的决策模块之间的相互关系。随着持续的技术进步以及更高处理和交互能力的可用性,机器人控制集成框架(又称架构)促进了可扩展性和可移植性。实现机器人控制架构的方式多种多样(参见参考文献中的综述),这使得它们之间的比较变得困难,因为关于机器人控制架构的研究更多是以可行性研究的形式进行的。例如,在 RoboCup@HOME等机器人竞赛中,正在探讨机器人控制架构的设计问题,旨在发展具有高度未来家庭个人应用相关性的服务型和辅助型机器人技术。一种常用的控制架构是分层式或层级式机器人控制架构,其层通常按照随着智能降低而精度提高的原则[36]。在此背景下,最常见的机器人控制架构包含三层:慎思层(高层、抽象推理和任务规划)、执行协调层(任务协调)和功能层(任务执行)。例如,Donaxi机器人[37,38] 包含一个用于符号表示和推理的慎思层、一个用于计划监控的执行协调层以及一个功能层。Siep‐mann 等人[39] 使用了硬件层、功能层和 BonSAI层。分层机器人控制架构的复杂性主要体现在这些层之间的接口设计与划分方式[40]。尽管目前尚未形成统一的架构共识,但如何设计一个能够有效集成所需功能的系统,仍是机器人技术[41], 领域中一个极为重要的开放性问题,且至今尚无主导性的解决方案[42]。

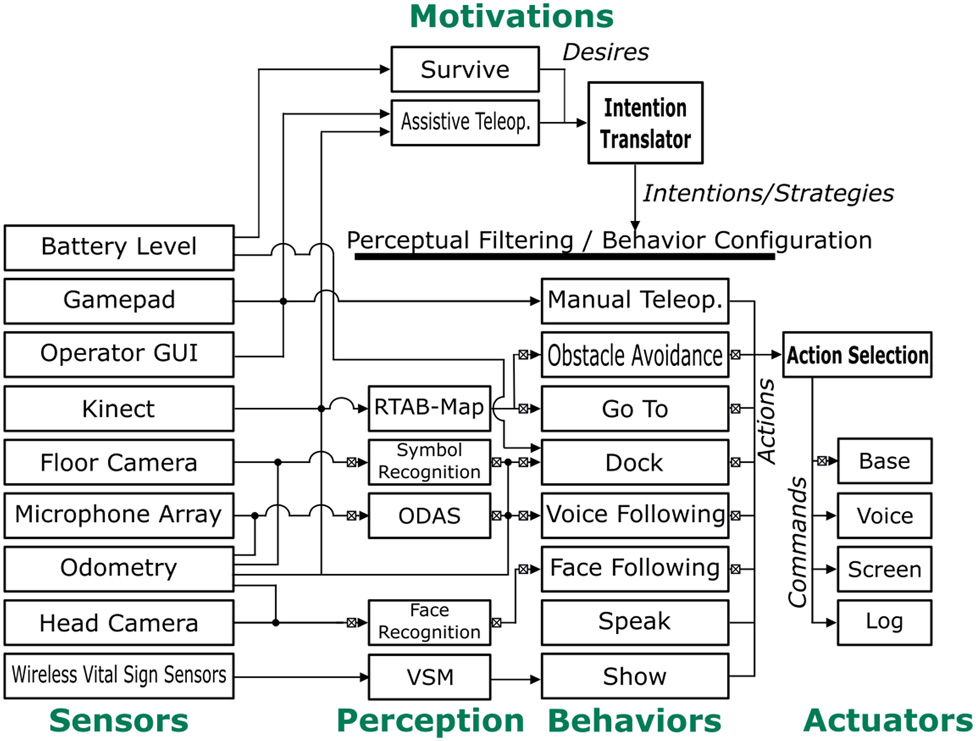

在我们的案例中,我们使用HBBA(Hybrid Behavior‐Based Architecture)[43,44], ——一个用于自主机器人集成设计的开源2统一框架。如图1所示, HBBA是一种基于行为的架构,没有中央表示,通过动机或感知模块提供高层建模、推理和规划能力的可能性。

基本上,它允许根据机器人所称的意图来配置和激活行为。意图是提供行为配置与激活(即行为策略)以及调节感知模块的数据结构。随着感知模块、行为和动机的数量和复杂性增加以应对更复杂的交互场景,意图工作区变得至关重要。虽然分层架构通常施加特定的慎思层结构(例如任务规划器)来协调低层行为,HBBA在其最高层可以使用多个并发且独立的模块,而不将这些模块限制于特定的决策方案。相比于Konidaris和Hayes [45],等更正式的规划方法,HBBA是一种机器人控制架构,为不同的处理模块提供设计指南和工作原理,而不对其实现强加形式化的编码结构。HBBA的行为通用协调机制已证明其能够通过协调感知和行为模块的激活与配置,实现从辅助遥操作到选择性注意和情景记忆等一系列认知能力。它也已被应用于人形机器人

例如,在情景记忆共享设置中使用NAO和Meka Robotics M1,以及将Robosoft Kompai和后来的PAL Robotics TIAGo作为轻度认知障碍老年人的服务机器人[46],[47]。

2.3 自主导航

SPLAM(同步规划、定位与建图)[48]是一种能够同时对环境进行建图、在环境中进行自定位,并利用这些信息规划路径的能力。当由计算资源有限的机器人在线执行该任务时,可能会特别复杂。SPLAM 的一个关键特征是检测先前访问过的区域,以减少地图误差,这一过程称为回环检测。在家庭环境中应用时,机器人必须能够应对所谓的机器人绑架问题和初始状态问题:当机器人启动时,它并不知道自身相对于先前创建的地图的位置,并且在启动时必须使用自身的参考系初始化一张新地图;当遇到先前访问过的位置时,可以计算出两张地图之间的变换关系。基于外观的回环检测方法通过比较之前的图像来利用图像的独特性与当前地图进行比较。当在地图之间发现回环时,可以通过将地图合并为一个来创建全局图。然而,对于大规模和长期运行而言,地图越大,在线处理数据所需的计算能力就越高,尤其是当检查所有采集的图像时。由于移动机器人上的计算资源有限,在线地图更新受到限制,因此地图的某些部分必须被部分遗忘。

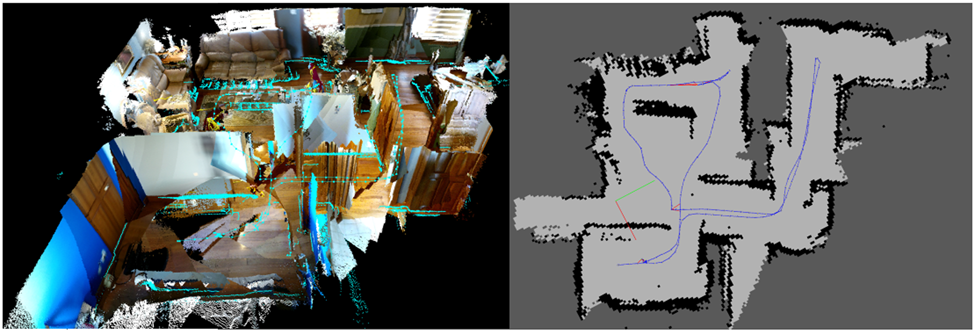

内存管理方法可用于限制地图的大小,从而确保回环检测始终在固定的时间限制内完成,满足长期、大规模环境建图的在线需求。RTAB‐Map(Real‐Time Appearance‐Based Mapping)[49–51]是一个开源库,实现了此类方法,利用操作环境的图像进行处理。由于基于视觉,RTAB‐Map还可以从视频数据中提供操作环境的三维可视化,有助于远程用户执行导航任务[4]。

RTAB‐Map 发布于 2013年,可用作跨平台的独立 C++ 库,并可通过其 ROS 软件包{v5} 实现二维或三维 SLAM。

Kinect摄像头生成与标准RGB图像耦合的深度图像,从而形成彩色三维点云。RGB图像还用于计算并存储在数据库中的图像特征。RTAB‐Map将多个点云与相邻点云之间的变换(三维旋转和平移)结合起来。这些变换的估计值通过机器人基于轮式编码器的里程计、视觉里程计或传感器融合计算得出。[52]当前图像的图像特征会与数据库中先前计算的图像特征进行比较。当特征之间存在强相关性时,即检测到回环。随后可通过新增的约束条件最小化地图中的累积误差,从而得到校正后的地图[53]。随着地图规模增大,回环检测和图优化所需的处理时间也越来越长。但RTAB‐Map的内存管理方法会在达到固定的实时限制时,将最久且较少访问的位置转移到长期内存中,在后续的回环检测和图优化中不再使用这些位置,从而使地图更新时间保持在确定的范围内-

2.4 声音处理

用于家庭辅助的机器人必须在嘈杂环境中运行,仅使用一个或两个麦克风时,在此类-条件下会表现出局限性[54]。例如,声源定位可用于定位住户[4]或在与多个用户对话时定位说话者[18]。麦克风阵列可通过允许机器人对多个声源进行定位、跟踪和分离,从而提升情境感知能力和用户体验[18]。声音处理能力结合面部追踪能力,可用于协助定位住户[4]并在与房间内的一人或多人对话时调整机器人位置,从而通过让远程操作员专注于与人员的交互来方便平台的导航任务。

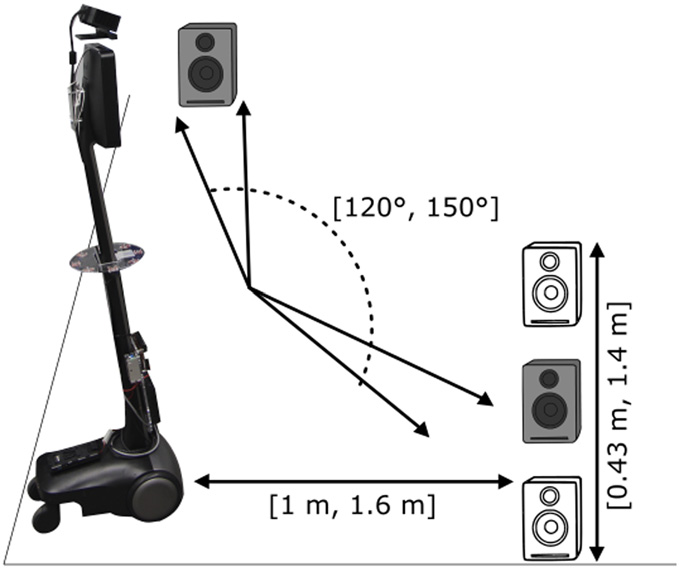

ODAS[55]是一个开源库-,用于实现声源定位、跟踪和分离。图3 显示了ODAS框架的主要组件。ODAS通过增加所用麦克风的数量来提高对噪声的鲁棒性,同时降低计算负载。该库依赖于一种称为基于方向性模型和自动校准的分层搜索的波束成形响应功率与相位变换(SRP-PHAT-HSDA)的定位方法。定位会产生嘈杂的潜在声源,然后通过基于改进型三维卡尔曼滤波器( M3K)的跟踪方法进行滤波(M3K),生成一个或多个被跟踪的声源。该模块的输出可用于持续调整机器人朝向扬声器的方向,且声源位置可在远程操作员的3D界面[56]上显示。随后使用定向几何源分离(DGSS)对声源进行过滤和分离,使机器人的注意力仅集中在语音上,并忽略环境噪声。ODAS库还将麦克风建模为具有定向极性模式的传感器,当麦克风与声源之间的直接路径被机器人本体遮挡时,这有助于提升声源的定位、跟踪和分离效果。

为了使用ODAS,需要配备声卡和麦克风。商用声卡在嵌入式机器人应用中存在局限性:它们通常价格昂贵;包含机器人声音处理不需要的功能;并且还需要较大的功耗和体积。为了便于在各种机器人平台上使用 ODAS,我们还提供了两款开源硬件声卡[57]: 8SoundsUSB6和16SoundsUSB,7 分别适用于8通道和 16通道的麦克风阵列。它们通过USB为机器人-麦克风信号提供同步采集功能,并传输至机器人的计算机’。

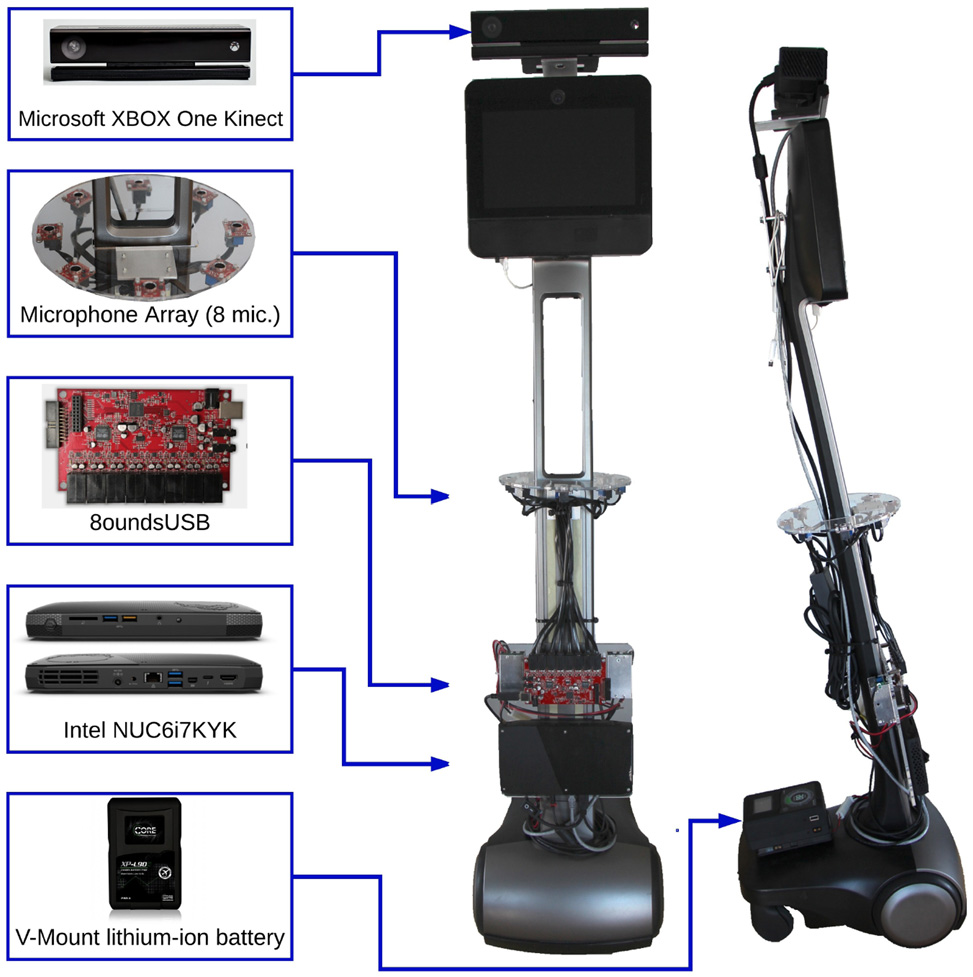

3 SAM,一种远程辅助机器人平台

标准的Beam平台配备了一个10′′ 液晶显示屏、低功耗嵌入式计算机、两个640 480 ×高动态范围(HDR)( HighDynamicRange)广角摄像头(分别朝向底部和前方)、扬声器、四个高质量麦克风、无线网络(WiFi)适配器,以及一块容量为20-AH的密封铅酸12V电池,可支持约2小时的自主性。酸12V电池,可支持约2小时的自主性。它还配有充电站:操作员只需将机器人定位在充电站前方并启动对接模式,机器人便会自动转向并倒车停靠到充电站上。该机器人’的

尺寸为 高×宽×深 134.4 厘米 × 31.3 厘米 × 41.7 厘米 ()。该平台还使用轮式编码器和惯性测量单元来估计机器人位置随时间的变化。电机控制和电源管理通过机器人底盘中的 USB 2.0 控制器实现,其最大速度为 0.45 米/秒。

如图4所示,我们使用定制的铝制支架将Kinect摄像头安装在液晶显示屏顶部,朝向前方并略微向地面倾斜。考虑到Kinect有限的视场角,将其安装在机器人顶部有助于避免碰撞悬挂物体或高架货架,同时能够感知桌子或台面上的物体。我们在距地面67厘米处安装了一个环形麦克风阵列,使用8SoundsUSB[57]声卡以及定制的铝制支架和亚克力支撑板。我们加装了一台英特尔 Skull Canyon NUC6i7KYK (NUC) 计算机,配备512 GB 硬盘、32 GB 内存、四核Core‐i7处理器、USB3 端口、以太网和WiFi 网络。我们将头部计算机的硬盘更换为128 GB mSATA 硬盘。两台计算机均运行Ubuntu 16.04操作系统及ROS(机器人操作系统[58]) Kinetic。我们通过使用SWX HyperCore 98Wh V型接口认证锂离子电池(具备过压/欠压和电流保护),将新增组件与原机器人电气隔离,该电池通过V型接口电池板安装在机器人的底盘上,以尽可能降低机器人的重心,并便于电池更换。

更换电池进行充电。使用额外的电池并不理想,因为它会使机器人的充电过程复杂化,限制了其仅能由经过培训的用户使用。然而,这使我们能够恢复任何更改,并尽可能减少对原始机器人平台的侵入性改动。结合 DC‐DC转换器,该电池为麦克风阵列、Kinect和NUC计算机供电。锂离子电池需手动单独充电。此配置在机器人构建环境地图时可提供50分钟的自主性,在使用导航模式(即自主导航、遥操作)时可提供75分钟的自主性。总体而言,附加组件加上原始机器人平台共计4300美元。

用于医疗保健的远程存在机器人-应用,例如 RP-VITA[59]和Giraff[60],可连接生命体征监测设备以进行医疗随访。为了实现这些功能,在SAM上安装了一个低成本USB加密狗,以从电池供电的蓝牙低功耗-(BLE)传感器获取以下生命体征:血压、SPO2和心率、体温、体重秤以及血糖仪[61]。在本例中,我们还为远程医疗应用设计了自身的远程通信框架,以满足远程家庭护理辅助应用的需求。

4 SAM的机器人控制架构

图5 展示了基于HBBA框架实现的SAM机器人控制架构,使SAM成为远程家庭护理辅助机器人。总体而言,其主要动机为生存和辅助遥操作。生存负责监控电池电量,并在电量过低时生成前往充电站的需求。通过该接口,远程操作员可激活由辅助遥操作管理的自主功能。这允许用户手动控制机器人、发送高层级目的地以实现自主导航、自主跟踪人脸,或自主将SAM朝向正在说话的人。

以下章节将详细介绍为SAM实现的传感器、感知、行为、执行器和动机模块。

4.1 传感器

SAM 具有以下输入传感模块,如图5所示。

- 电池电量水平以浮点数单位监控电池电压水平和电流消耗。

- 游戏手柄 是一种无线控制器,如图6所示,用于激活或停用轮式电机。它允许操作员手动导航机器人或激活 SAM’的自主模式。

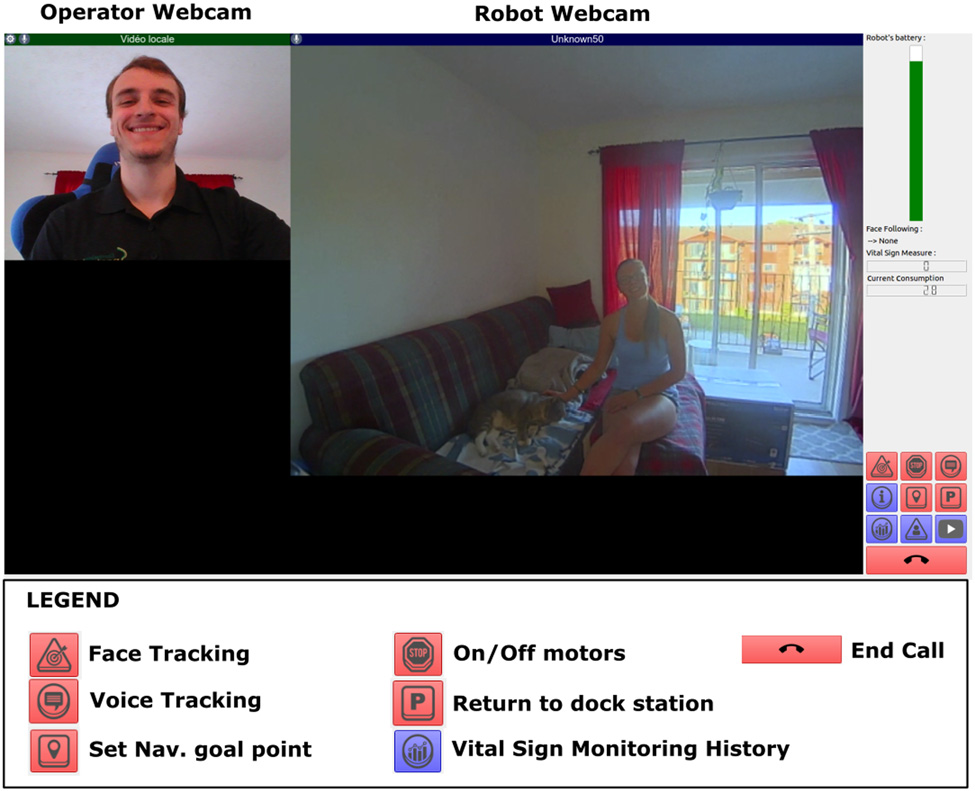

- 操作员图形界面 (图形用户界面) 如图7所示,允许操作员通过界面上左下部分的图标来遥控SAM并激活其自主模式。

- Kinect是Kinect摄像头生成的RGB‐D数据。

- 地面摄像头是一个朝向地面的网络摄像头,用于定位充电站。

- 麦克风阵列是安装在SAM上的8麦克风阵列。

- 里程计是Beam平台的轮式编码器和惯性测量单元提供的数据,用于估计其随时间推移的位置变化。

- 头部摄像头是安装在SAM前额、朝前的网络摄像头,用于与人进行视觉交互。

- 无线生命体征传感器是用于无线生命体征监测设备的蓝牙低功耗接口。

4.1.1 感知

感知模块将传感器数据处理为行为可用的信息。SAM’的感知模块如图5所示,包括:是:

– RTAB-Map用于第2.3节中介绍的建图与定位。–符号识别 使用地面摄像头 检测充电站上的符号,如图8所示,并使用ROS find_object_2d 包来识别其方向。该包使用 OpenCV9检测充电站。计算参考图像和场景图像对应特征之间的单应性矩阵。在参考图像中选择三个点以估计场景图像中物体的姿态:一个位于物体正中心,一个沿物体的x轴方向,另一个沿物体的y轴方向。已知地面摄像头的角度,可计算出相对于机器人的位置(x, y)。

– ODAS用于声源定位、跟踪和分离,如第2.4节所述。

– 面部识别使用SAM的头部摄像头,并结合OpenCV 3.0库中的FisherFace识别器。它将当前人脸与数据库中所有预先记录的人脸进行比较,然后通过置信度评分识别出最可能的人员。– VSM(生命体征监测)将生命体征数据转换为通用的JSON格式,以兼容Show和Log 所使用的软件。

4.1.2 行为

SAM’的行为,如图5所示,由我们设计,是采用基于优先级的动作选择方案组织的控制模式-如下:

• 手动遥控操作是最高优先级的行为,通过使用游戏手柄将完全控制权交给操作员。该行为用于安全干预以及建图会话期间。

• 避障根据机器人局部地图中检测到的障碍物规划一条绕行路径,以避免碰撞。

• 前往允许SAM使用RTAB‐Map模块提供的SPLAM进行自主导航。

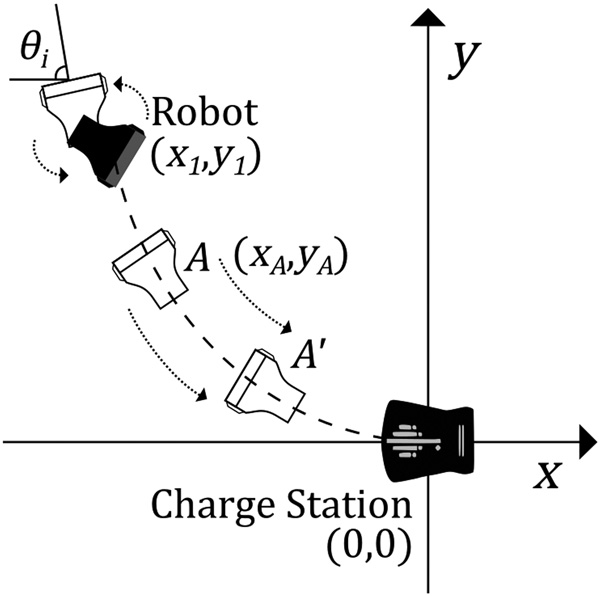

• 对接 允许机器人在检测到时自动连接到充电站。如图 8所示,充电站有一个平坦的部分可供机器人驶过,上面有一个符号用于计算充电站的距离和方向-。由于Bea m头部的硬盘被更换,我们无法将此行为与Beam平台现有的对接算法进行对接。因此,我们必须实现自己的对接算法。机器人充电连接器位于其底盘后部,且没有用于向后导航的传感器。因此,在转向后退对接之前,机器人必须生成一条路径-。如图9所示,我们的算法使用以充电站为中心的x y,()坐标表示,原点为0, 0(),指向左侧 x(−)以及机器人的位置 x y,1 1()。符号识别提供充电站相对于机器人的 位置x y,RS RS()和方向 θRS。然后求得机器人相对于充电站的位置x y,1 1():

x x θ y θ cos sin R S R S R S R S 1= − − (1)

y x θ y θ sin cos R S R S R S R S 1= − (2)

为了使机器人垂直连接到充电站,选择了一条二阶多项式路径: y y x x 1 12 2 = (3)

路径计算完成后,通过θi(3)的导数确定机器人的初始方向。机器人原地旋转以达到 θi。然后机器人开始沿路径倒退移动。为监控运动过程,里程计提供机器人相对于地图的位置(x y,M A MA)和方向(θM A)。该位置相对于充电站(xA, yA)通过应用齐次矩阵(A A,R M SR)获得,这些矩阵分别将坐标系从地图变换到机器人,以及从机器人变换到充电站。

x y A A x y 1 1 A A R M S R M A M A = (4)

使用100 Hz的循环频率,速度由0.4 m/s的平移速度和以下定义的旋转速度确定:

θ θ θ 100 A A twist( ) ° = − × ′ (5)

当里程计显示机器人未移动,但实际上已向底盘发送了非零速度指令时,这意味着机器人遇到了

一个障碍物,可能是充电站。然后机器人停止1秒;如果在此期间电池的电流消耗变为负值,则机器人完成自动对接并开始充电。否则,机器人将按照计算出的轨迹继续后退。

• 语音跟随使用ODAS来感知多个声源位置、幅度和类型(语音或非语音)。主要对话者被视为具有最高能量的语音源。利用其位置和机器人的里程计数据,机器人会转向并朝向主要对话者。

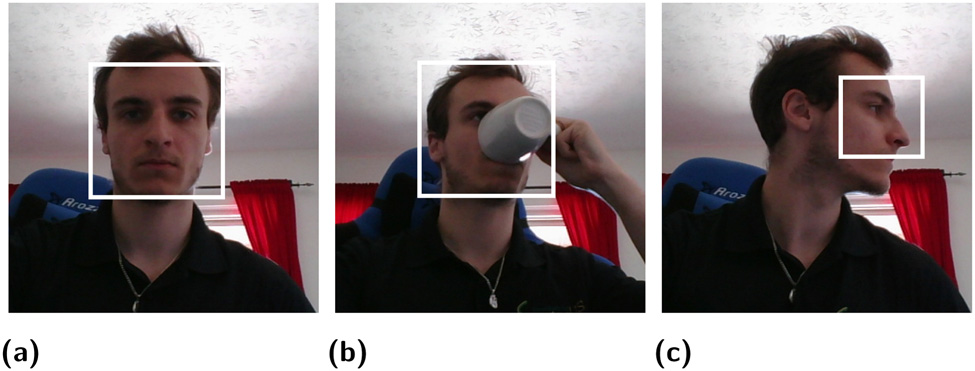

• 面部跟随 通过面部识别使用TLD捕食者 (跟踪学习与检测)[62]包来跟踪检测到的最近的人脸。如图10所示,一旦检测到人脸,面部跟随 即使人脸被遮挡或改变了方向,也能持续跟踪该人脸。当前实现仅同时跟踪一张人脸。

• Speak使用Festival语音合成和sound_play ROS包将预定义文本转换为语音。

• 显示 在机器人’的屏幕上显示远程操作员网络摄像头、生命体征以及机器人的’电池电量,如图7所示。

4.1.3 执行器

动作选择 模块接收所有由激活行为生成的动作,并为同一执行器保留来自最高优先级行为的动作。图5中显示的执行器包括:-执行器包括:是:

• 底盘将速度指令转换为轮式电机的控制数据。

• 语音播放来自Speak的声音或操作员语音传来的音频。

• 屏幕显示来自Show的信息。

• 日志将从VSM收集的所有生命体征保存到Firebase数据库 (一个谷歌网络应用)中。11 数据均带有时间戳记录。

4.1.4 动机

SAM的动机是:

• Survive会监控SAM的电池电量,并在电池电压低于 11.5 V时生成返回充电站的意愿。

• 辅助遥操作允许远程操作员通过图形用户界面启动用于导航、对话跟随或跟随的自主模式人脸。默认情况下,当操作员图形用户界面没有信号输入时,将生成返回充电站的意愿。

4.2 实验室条件下的验证

SAM的功能使操作员能够对环境进行建图,在生成的地图中实现自主导航并自动对接到充电站,让机器人朝向说话者的方向定位,并通过跟踪人脸来跟随人员。这些功能可以通过操作员图形用户界面单独激活。在真实家庭环境中开展试验之前,我们在实验室设施中验证了这些功能的效率和可靠性。使用RTAB‐Map创建走廊和房间的参考地图后,通过让SAM移动到不同的目标点位置来测试自主导航功能。机器人能够在走廊中安全移动,绕过人员、家具(工作台、桌子、椅子、各种设备)以及穿过门框。为了模拟类似家庭的条件,实验室的门框使用胶合板缩小至71厘米。充电站被放置在开放区域的一堵墙边,以验证“生存”动机,即让机器人返回充电站。该功能在1至20米的行驶距离范围内成功通过验证。

自主对话跟随功能在不同房间以及公开演示期间进行了测试。面部识别功能也针对不同参与者在不同房间内逐一验证。这些在受控条件下进行的试验全部取得成功,表明SAM已准备好进入更加开放和多样化的实验环境进行测试。

5 实验方法

如引言所述,目的是检验SAM的模式在实际应用中的效率和可靠性家庭环境。在每个新的家庭环境中,第一步是将充电站放置在墙壁旁,并确保周围有足够的空间(1 m2),以便机器人能够转身并自动对接。第二步,使用卷尺手动测量每个门框宽度、门槛高度和走廊宽度,以表征环境特征,并在SAM在这些区域遇到困难时提供观察数据。同时识别环境中的局限性,特别是楼梯、台阶(≥0.5 cm)以及住户禁止进入的房间。第三步,操作员使用游戏手柄和手动遥控操作,在各个房间内进行导航,通过查看rviz中显示的RTAB‐Map参考地图,确保完整地映射墙壁和家具,从而创建参考地图。如果操作员认为地图能充分代表家庭环境,则在地图上标定“前往”行为的目标位置。由于本文旨在考察SAM在真实家庭环境中的模式的效率和可靠性,为了保持一致性,所有实验均由同一位熟悉SAM操作的操作员完成。

早期,在遵循此流程时,我们注意到与实验室条件下的验证相比,SAM的配置和使用需要进行一些调整:

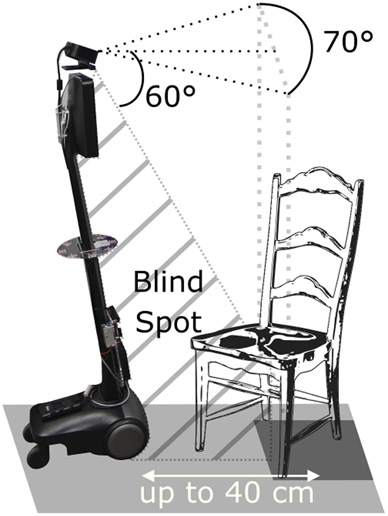

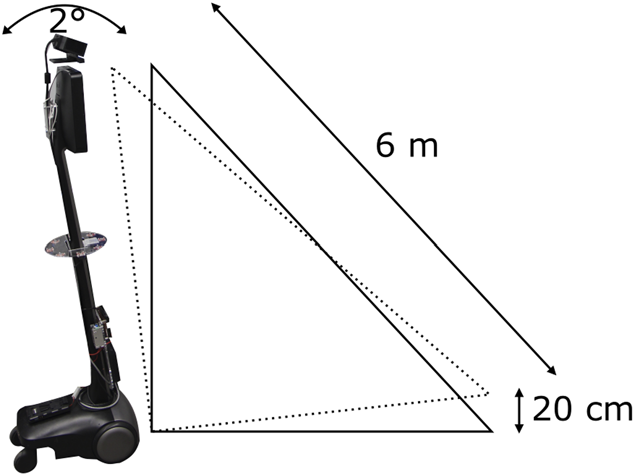

– Kinect摄像头的位置给建图和导航带来了局限性。如 图11所示,Kinect’s 垂直fi视场角(FOV)为60°时会产生盲区。该盲区在接近障碍物(如椅子和桌子)时会导致误识别。为了减少这种情况,操作员使机器人与因盲区而部分可见的障碍物保持至少40厘米的距离。此外,机器人’s 加速、-地面坡度以及fl地面裂缝会引起振动。并且如图12所示,Kinect’s 方向改变2°时可能引发误识别错误,例如将地面误判为障碍物。为防止此类情况,我们将最小障碍物高度设置为20厘米。

– Kinect摄像头在感知镜子或反光物体时存在问题:镜子反射的所有障碍物都会被当作通过窗户看到的一样。这会引入噪声或幻影障碍物。我们尝试先对有大型镜子的房间进行建图,然后再处理其他房间,以尽量减少这种影响,并尝试去除噪声和幻影障碍物。

– 在面部跟随方面发现了困难。由于每个房间之间的亮度水平以及一天中的时间变化,面部跟所在真实生活条件下表现出不可靠性,尽管其在实验室环境中表现良好。因此,我们决定在实验中不包含此功能,而是专注于自主导航和自主对话跟随。

5.1 自主导航

自主导航试验涉及SAM从初始位置移动到目标位置,这被称为一条路径。在每次试验中,操作员使用操作员图形用户界面选择“前往行为”以到达预设位置,或选择 “返回充电站行为”使SAM返回其充电站。当机器人在试验过程中移动时,操作员按住游戏手柄上的使能按钮,并观察RTAB‐Map的参考地图以及来自头部摄像头和地面摄像头的视频流,在必要时松开使能按钮进行干预。由于SAM是一种远程呈现机器人,我们认为此类干预是可以接受的,用以弥补机器人的局限性。随后,操作员使用手动远程操作模式重新调整机器人的位置。出于额外安全目的,另有一人会跟随SAM,随时准备在必要时进行干预。当机器人到达目标位置,并且操作员最多仅干预一次以应对以下情况时,该试验被视为成功。

6 结果与观察

表4 附录A展示了我们进行试验的10个不同的家庭环境。这些环境包括各种类型的房间、不同类型的地板、门宽和走廊,以及各种家具的布局。除了将门完全打开或关闭外,没有对环境进行任何修改或调整以协助机器人。附录A中提供的草图是对真实家庭环境的近似表示。还提供了由RTAB‐Map生成的参考地图示例。地图中的深色线条是障碍物,灰色区域是导航的安全区域。用于实验的家庭可用时间从2小时到2周不等。

6.1 自主导航

根据家庭的可用性和复杂性,为10个家庭环境中的每一个创建了一到五张参考地图,总计35张参考地图。对于每张参考地图测试了两到六条路径,每条路径至少重复三次试验。总共进行了400次自主导航试验。

如图14所示,试验持续时间为14至158秒,平均为38.5秒,标准差为19.5秒。自主完成的试验持续时间为14至87秒,平均为30秒,标准差为11.1秒。涉及操作员干预的试验持续时间为17至158秒,平均为53.7秒,标准差为24秒。行驶距离在3.4至11.9米之间,平均为6.9米,标准差为2.3米。

表1展示了第5.1节中定义的四种自主导航场景下试验的结果。允许操作员干预一次(如第5.1节所述)时,成功完成的试验为368次,相比完全自主完成的288次,增加了80次。仅有32次试验(400减去368,约8.0%)未成功。在(1)在房间内导航或(2)导航至另一个房间这两种情况下,SAM在有干预的情况下共进行了270次试验(97+173),其中264次成功(94+170)(即264/270,成功率97.8%),而完全自主情况下的成功率为76.7%(81+126=207)。在这些成功的试验中,操作员共干预了70次(11+5+36+18),涉及63次试验:其中47次()用于防止碰撞,23次(5+18)用于从因闭环问题导致的路径规划失败中恢复。此外,(2)导航至另一个房间被证明更具挑战性,其自主导航成功率为72.8%,低于(1)在房间内导航的83.5%。这些困难可由以下原因解释:

机器人的里程计影响导航性能。SAM的里程计由Beam底座通过轮式编码器和惯性测量单元计算得出。位姿误差约为2.8%,线性误差约为0.8%。每次原地旋转时,里程计累积的误差最高可达10°,这会降低RTAB-Map生成的地图质量。

-

在建图过程中,RTAB-Map会将图像及其视觉特征作为回环的参考信息进行记忆。当通过基于图像中视觉特征的相似性度量发现当前图像与内存中的某幅图像匹配时,就会发生回环。一个局限性在于,所有特征都被假定为静态且重要的。这在洗衣房和厨房的自主导航中带来了问题。例如,图17a中环境B的上方房间是一个洗衣房。第一次对该房间进行建图时,熨衣板上放着折叠好的彩色衣物。第二天,由于衣物被移走,彩色特征不再可见,导致RTAB‐Map无法完成回环。这类问题可能出现在家庭的各种场景中,例如餐具、食物、鞋子、衣物、宠物、椅子、植物或门(开启或关闭)的建图过程。当 RTAB-Map无法执行回环时,里程计误差会累积,导致局部地图偏离全局地图。如果偏差过大,RTAB-Map将无法找到一条同时满足局部地图和全局地图的可行路径,从而使自主导航无法进行。在这种情况下,操作员必须介入,手动操控机器人,直到RTAB-Map能够完成一次回环,重新同步SAM’s在地图中的位置。

-

过门框有时可能很困难。表2显示了试验中287次过门框与门宽相关的观察结果。门框宽度在58厘米至76厘米之间时结果相似,而83厘米的门宽可使成功率提高20%。这种83厘米宽的门框是为轮椅设计的,常见于养老院(环境D、F和G,见表4)。

更仔细地查看操作员进行的干预,表1 表明操作员总共干预了145次,包括未成功的试验:在54次试验中进行了64次 -干预(占400次试验的13.5%)以防止碰撞,在 30次试验中进行了37次 -(占400次试验的7.5%)用于帮助克服路径规划失败,以及在涉及充电站的130次试验中的 33次试验中进行了44次 -干预(占130次试验的25.4%)(( ),以帮助机器人自动对接到充电站。当)在房间内导航时,我们手动统计发现,在97次试验中,有11次 (9.3%)干预是为了防止碰撞,这部分是由于Kinect的盲区造成的。如果SAM过于靠近柜台、咖啡桌或椅子,局部地图就无法正确显示障碍物,从而增加了碰撞的风险。当机器人需要绕过这些物体时,操作员有时不得不进行干预以防止碰撞。此外,由于将最小障碍物高度设置为20厘米,导致在环境D中难以检测到助行器(如图15所示),并且会忽略地板上的小物体,例如鞋子。如果机器人规划的路径朝向被误识别或被忽略的物体,操作员就必须干预以调整轨迹,避免碰撞。(2) 在导航至不同房间时,为防止碰撞而进行干预的比例有所增加(从9.3%上升至17.3%),或因路径规划失败而干预的比例也有所上升(从4.1%上升至8.7%)。这种增长是由于穿过门框时发生里程计漂移所致。门框属于狭窄空间,几乎没有容错余地,如果局部地图与全局地图未对齐,机器人可能会规划出过于靠近门框的路径,甚至无法找到可行路径。在这种情况下,操作员必须进行干预。如果仅考虑在养老院(环境D、F和G)中进行的试验,则SAM在70次试验中的自主成功率将提高至89%,这可以解释为这些环境中几乎不存在狭小空间、狭窄转弯以及靠近门框的家具。这减少了障碍物处于机器人盲区的情况,即使局部地图存在漂移,也有助于找到有效路径。因此,如表2所示,为轮椅设计的较大门框对里程计漂移更具容忍性。

关于自主导航场景(3)和(4)表1 中涉及充电站的情况,除了需要面对上述导航挑战外,SAM在某些情况下对接也遇到困难,在涉及该模式的试验中,共需要干预44次,占试验总数的25.4%。如图8所示,根据光照条件的不同,充电站平坦部分上的符号可能不够清晰,导致方向误差最大达到20°。此外,充电站的平坦部分由金属制成,其具有低摩擦力:当SAM的驱动轮从高摩擦力表面(例如地毯、防滑油毡)移动到低摩擦力表面时,由于电机控制器暂时向电机输出了过多的功率,导致车轮有时会短暂打滑。这会使机器人偏离其规划轨迹,从而无法正确对接。为便于对接,应特别注意将充电站放置在低摩擦力表面上。

6.2 自主对话跟随

表3展示了在表4的环境A、B、E和J中进行的自主对话跟随的结果。在安静条件下,SAM有93%的时间成功将摄像头指向正在说话的人,其余7%的时间机器人保持静止。在嘈杂条件下,性能下降至62%。包括电视和音乐歌词在内的语音类干扰声源有时被误判为有效对话者,导致机器人转向这些声源。另一方面,抽油烟机和吸尘器噪音极少被检测为语音。这得益于ODAS的语音检测算法,该算法会分析声源的频率范围。成年男性的基频为 85-180 Hz,成年女性为165-255 Hz[63]。如果干扰声源的频率范围与85‐255 Hz区间重叠,则可能发生误识别。

总体而言,此功能层可增强远程体验,并已准备好在安静条件下进行可用性研究,但在嘈杂环境下仍需改进,或许可通过记忆可接受声音的特征来实现跟踪[64]。

7 局限性

本文详细介绍了SAM的实现过程,SAM是专为远程家庭护理协助设计的远程呈现移动机器人原型。文章揭示了在为移动机器人平台设计和集成自主决策能力,并在真实家庭环境中进行实验时所获得的见解和遇到的问题。然而,本文所报告的内容可被视为实现机器人远程护理援助自主化的第一步,因此有必要阐明本研究的以下局限性:

-

所呈现的结果受限于SAM的硬件和软件组件,这些限制影响了我们的实验方法论,我们不得不针对观察到的局限性进行调整(如第5节所述),从而使研究更具探索性质。若使用其他机器人平台以及不同的机器人控制架构、自主导航和声音处理算法,结果也会有所不同。然而,提供SAM实现方式及现场观察的详细描述,可为未来的比较研究提供参考。目前,我们正在改进SAM已实现的功能,并将其迁移到具备更优感知能力的其他机器人平台上(例如,增加激光雷达,在机器人顶部加装惯性测量单元,增加第二个RGB‐D相机以覆盖盲区,监测振动并实现更稳健的里程计;持续建图并加入语义建图[65]以去除可靠性较低的视觉特征,提升在光照变化条件下的视觉SLAM性能[66]),同时增强交互能力(例如,通过面部识别和声源定位实现人员寻找;利用声源分离过滤噪声)以及遥操作能力(例如,使用三维表示进行导航)。通过HBBA、RTAB‐Map和ODAS开发这些改进功能将有助于原型设计,并允许他人在其自身实现中加以利用。

-

SAM 被设计为一个研究原型,而非商业产品。要使其具备商业化条件并符合相关要求,还需要进行许多步骤。ISO 13482:2014 标准(机器人和机器人设备——个人护理机器人安全要求)。任何对现有平台的新设计或集成都必须考虑这些因素。

-

在10个家庭环境-中受控监督下进行的试验并不能代表真实的大规模和长期部署条件。需要在更具多样性的家庭环境-中与实际住户共同开展试验。除了提升机器人自主能力以适应此类试验外,我们目前正在开发基于云的中间件-,以实现端到端的远程医疗解决方案-,从而支持此类部署。[67]以支持此类部署。

-

所遵循的实验方法不涉及SAM在远程护理援助中的可用性和交互研究,也不涉及具有自主能力的遥操作,例如第2节中描述的ExCITE项目所进行的研究。当前的工作应被视为迈向此类实验的垫脚石。我们的重点将放在老年人居住场所,在这些场所中,机器人更有可能获得现场技术人员的支持。采用以用户为中心的设计方法,结合临床医生、老年人和护理人员的参与,我们的策略是首先向居民开展示范试验,以展示机器人能够完成的任务,协助共同构建与SAM及其他机器人平台进行的交互场景。

8 结论

本文概述了为远程呈现机器人提供自主能力所需的各个要素,从导航到交互模式,以及它们的硬件、软件和决策集成。在SAM上集成各种自主模式并确保其可靠性和鲁棒性是一项相当大的挑战,我们在真实家庭环境中的实验揭示了该平台的能力及其局限性,而这些在实验室条件下并未显现。尽管存在这些局限性,SAM在真实家庭环境中仍表现得相对良好,我们在真实家庭中进行试验收获颇多,指出了值得深入研究的有趣问题。这表明,在真实环境中开展评估机器人自主能力的试验具有重要意义。

家庭环境是一个重要的初步步骤,因为它有助于明确对机器人的预期,并根据机器人的能力推导出相应的交互场景。在开展可用性研究之前识别这些局限性尤为重要,因为可用性研究通常需要大量时间和资源,提前识别可以明确自主能力将如何影响方法论和结果:操作环境可能需要受到限制或进行特定设计,机器人及其自主能力需要得到改进以增强鲁棒性,或者在分析结果时必须考虑这些局限性。机器人平台将需要改变,以尽量减少这些局限性的发生。SAM的自主能力尚不完善,在规划和开展可用性研究时,如果不加以承认或理解,可能导致无效的观察结果。

在未来的工作中,我们将继续致力于在真实家庭环境中实现自主性和试验,我们相信这是满足机器人安全和故障安全操作的最低要求、远程操作员援助的关键,甚至可能是解决隐私伦理问题的一种方案[19]。我们还希望,通过持续公开我们的代码并促进技术的可访问性,将有助于建立新的合作伙伴关系和合作,共同推动远程呈现移动机器人在远程护理援助中的自主性提升。

2339

2339

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?