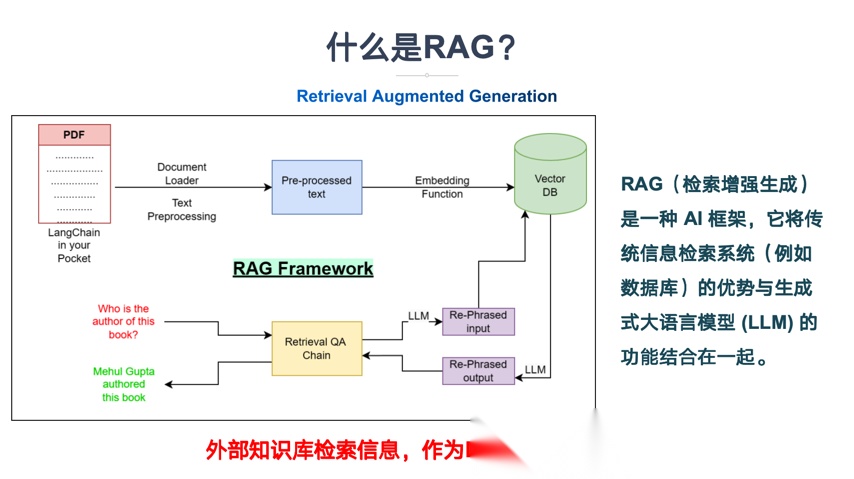

RAG通过架构重构解决了大模型的幻觉生成与知识边界模糊问题。传统大模型知识时效性差,且概率补全机制必然导致幻觉。RAG将知识外置于动态更新的向量数据库,使模型从静态知识容器转变为动态推理代理,实现知识存储与推理生成分离。混合检索策略和条件化生成机制确保了回答的准确性,同时支持拒答策略,构建了可持续演进的知识生态系统,让AI越用越聪明而非越用越过时。

前排提示,文末有大模型AGI-优快云独家资料包哦!

文章概要

作为AI从业者,我将分享RAG如何通过架构重构解决大模型的两大顽疾——幻觉生成与知识边界模糊,帮你构建可信赖的企业级AI系统,让模型在不知道时主动拒答。

想象一下,你问AI“公司最新财报数据”,它自信满满地编造了一串数字——这不是AI在撒谎,而是它在用2021年的知识回答2025年的问题。

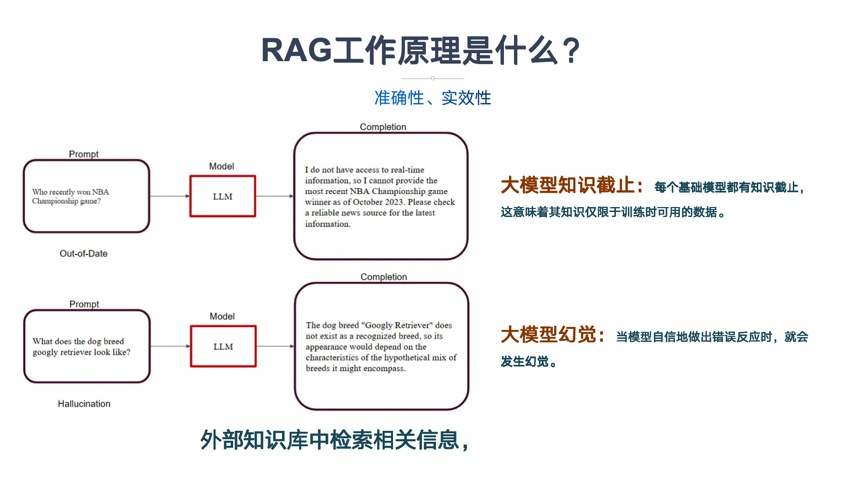

静态知识库如同过期的地图。主流大模型训练完成后,知识就凝固在那一刻。当员工询问最新报销标准时,模型可能还在引用去年的政策;当客户咨询今天刚发布的产品特性,模型只能根据过时信息猜测。训练数据截止日期之后的所有新事件、新法规、新产品,模型在架构上完全无知。

更致命的是,概率补全机制让幻觉成为必然。当模型遇到知识盲区,它不是承认“不知道”,而是基于统计规律“猜”一个最可能的答案。就像让一个没见过大象的人描述大象,他可能根据“大型动物”、“长鼻子”等关键词,拼凑出一个四不像的怪物。

模型输出实质上是一系列数值运算,所以它经常会一本正经地胡说八道

模型生成答案的置信度与事实真实性完全脱钩,这就是为什么错误答案听起来总是那么自信满满。在医疗、金融等高风险领域,这种不确定性足以让整个AI系统失去实用价值。

更讽刺的是,当模型真的不知道答案时,它很少主动承认“我不会”,而是用看似专业的废话填充回应。模型不知道自己在不知道什么——这才是最可怕的认知黑洞。

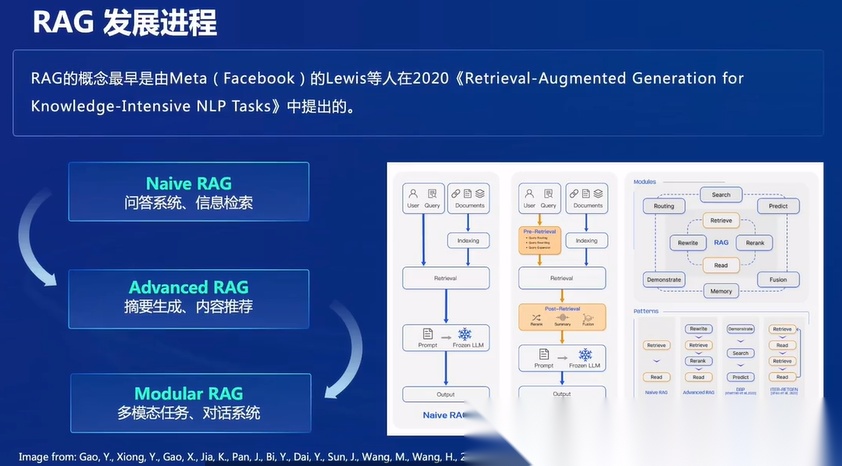

RAG架构哲学:从全知模型到动态推理代理

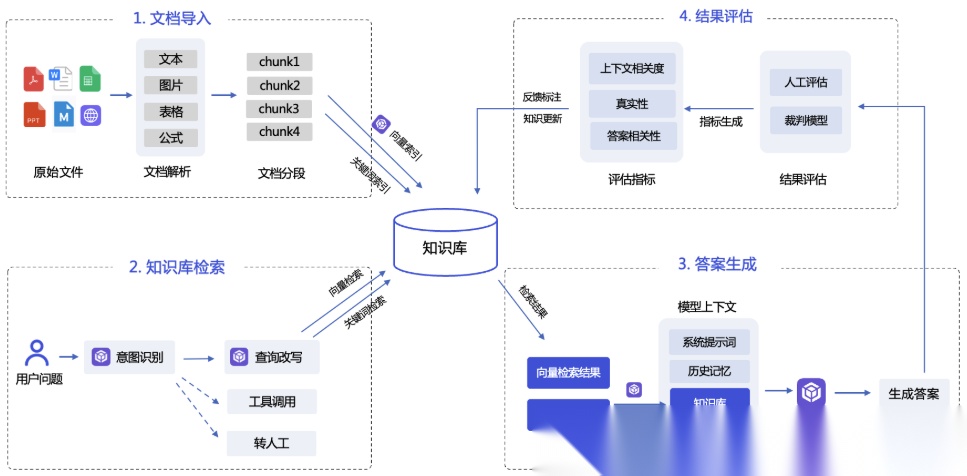

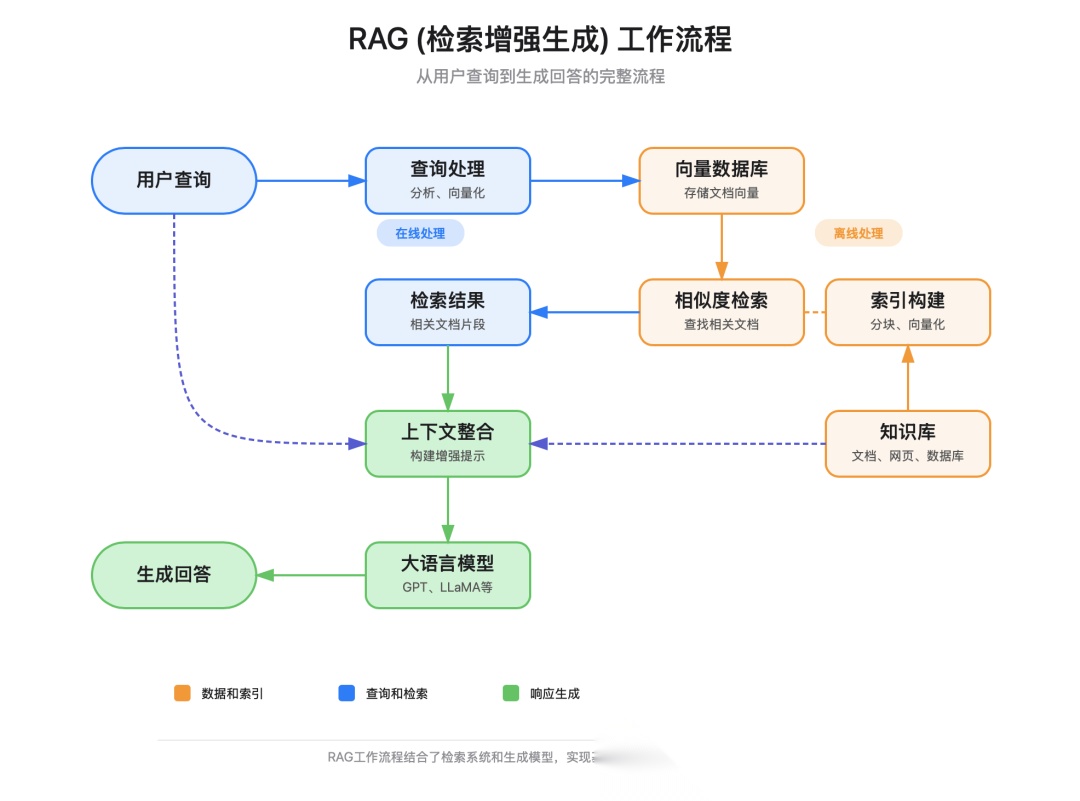

传统大模型试图在参数中固化所有知识,这种"全知"架构注定失败。RAG的核心突破在于承认模型无需全知,只需具备精准检索和可靠推理能力。通过将知识外置于动态更新的向量数据库,模型从静态的知识容器转变为动态的推理代理。

斯坦福研究表明,这种架构重构能将幻觉率降低96%。模型不再依赖训练时的过时记忆,而是实时检索最新信息进行推理,从根本上解决了知识时效性和准确性的双重挑战。

知识外置让模型专注于最擅长的事:理解、推理和生成,而非记忆

知识外置与推理解耦机制

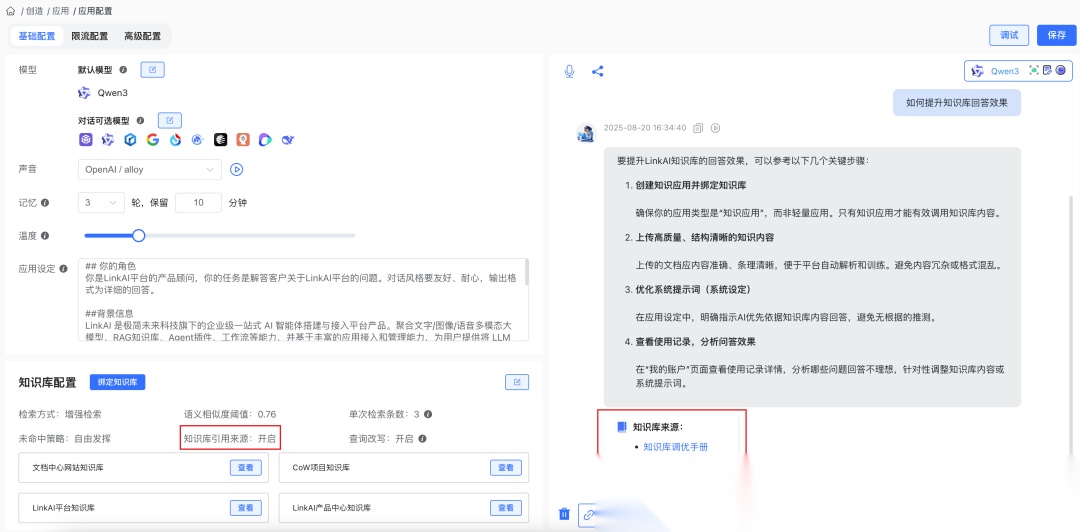

RAG将知识存储与推理生成彻底分离。知识库负责准确存储,模型专注逻辑推理,各司其职。LinkAI平台实践显示,通过智能文档解析和多模态提取,复杂格式文档的信息保留率提升40%以上。

这种解耦带来了关键优势:知识更新无需重新训练模型,检索失败时模型自动拒答而非编造。企业知识库可以按需更新,模型始终保持最新认知,同时明确知晓自身知识边界。

推理解耦让AI从"假装知道"变为"知道就知道,不知道就承认"

构建可持续演进的知识生态

RAG架构的本质是构建一个自我演进的知识生态系统。LinkAI平台通过定时更新和工作流更新两种机制,实现知识库的持续优化。外部文档变更自动同步,内部员工可通过自然语言对话动态写入知识。

这种生态的核心是数据闭环:用户反馈驱动知识库迭代,评估指标量化优化效果。平台建立的智能体评估中心支持客户自助构建测试集,通过系统裁判模型生成过程指标,实现端到端的持续优化。

可持续的知识生态让AI越用越聪明,而非越用越过时

工业级RAG实战:精准检索与可控生成

企业级RAG的核心价值在于精准控制——既要确保相关问题的准确回答,又要对边界外问题坚决拒答。传统单一检索方法召回率不足30%,而混合检索将准确率提升至90%以上,幻觉率控制在3%以下。

精准检索是基础,可控生成是保障——两者结合才能构建可信赖的企业AI系统

混合检索与智能路由决策

向量检索+关键词检索双引擎架构解决单一策略局限:向量搜索捕捉语义,关键词匹配处理专有名词。通过智能路由决策,系统自动选择最优策略——简单查询走向量检索,专业术语密集问题优先关键词匹配。

实测显示,混合检索在技术文档问答中误检率降低42%,平均响应时间缩短40%。路由机制还支持元数据过滤,基于用户身份和意图进行权限控制,确保信息安全。

检索质量决定上限,路由效率决定成本

条件化生成与拒答策略

生成环节的关键是证据约束机制。系统设置相似度阈值(如0.75),低于该值直接触发拒答流程。研究表明,良好的拒答策略能避免80%的幻觉错误。

实现上,模型被强制要求基于检索到的上下文生成答案,对证据不足的查询明确告知"依据现有信息无法回答"。这种设计在金融合规问答中错误率从25%降至3%以下。

敢于说"不知道"的AI更值得信赖

读者福利:倘若大家对大模型感兴趣,那么这套大模型学习资料一定对你有用。

针对0基础小白:

如果你是零基础小白,快速入门大模型是可行的。

大模型学习流程较短,学习内容全面,需要理论与实践结合

学习计划和方向能根据资料进行归纳总结

包括:大模型学习线路汇总、学习阶段,大模型实战案例,大模型学习视频,人工智能、机器学习、大模型书籍PDF。带你从零基础系统性的学好大模型!

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

👉AI大模型学习路线汇总👈

大模型学习路线图,整体分为7个大的阶段:(全套教程文末领取哈)

第一阶段: 从大模型系统设计入手,讲解大模型的主要方法;

第二阶段: 在通过大模型提示词工程从Prompts角度入手更好发挥模型的作用;

第三阶段: 大模型平台应用开发借助阿里云PAI平台构建电商领域虚拟试衣系统;

第四阶段: 大模型知识库应用开发以LangChain框架为例,构建物流行业咨询智能问答系统;

第五阶段: 大模型微调开发借助以大健康、新零售、新媒体领域构建适合当前领域大模型;

第六阶段: 以SD多模态大模型为主,搭建了文生图小程序案例;

第七阶段: 以大模型平台应用与开发为主,通过星火大模型,文心大模型等成熟大模型构建大模型行业应用。

👉大模型实战案例👈

光学理论是没用的,要学会跟着一起做,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

👉大模型视频和PDF合集👈

这里我们能提供零基础学习书籍和视频。作为最快捷也是最有效的方式之一,跟着老师的思路,由浅入深,从理论到实操,其实大模型并不难。

👉学会后的收获:👈

• 基于大模型全栈工程实现(前端、后端、产品经理、设计、数据分析等),通过这门课可获得不同能力;

• 能够利用大模型解决相关实际项目需求: 大数据时代,越来越多的企业和机构需要处理海量数据,利用大模型技术可以更好地处理这些数据,提高数据分析和决策的准确性。因此,掌握大模型应用开发技能,可以让程序员更好地应对实际项目需求;

• 基于大模型和企业数据AI应用开发,实现大模型理论、掌握GPU算力、硬件、LangChain开发框架和项目实战技能, 学会Fine-tuning垂直训练大模型(数据准备、数据蒸馏、大模型部署)一站式掌握;

• 能够完成时下热门大模型垂直领域模型训练能力,提高程序员的编码能力: 大模型应用开发需要掌握机器学习算法、深度学习框架等技术,这些技术的掌握可以提高程序员的编码能力和分析能力,让程序员更加熟练地编写高质量的代码。

👉获取方式:

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

978

978

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?