1. 背景:为什么大模型应用工程化如此重要?

人工智能进入 大模型(Large Language Model, LLM) 时代后,我们正在见证一场计算范式的转变。从最初的 NLP 研究工具,到如今成为通用智能体的基础,大模型正在改变软件工程、产品交互与企业流程。

但问题是:大模型≠产品。单纯调用 API 并不能直接构建稳定的应用。开发者在实际项目中会遇到大量工程问题:上下文管理、知识检索、调用链编排、成本控制、数据安全、评测体系……如果不加以工程化,大模型的潜力就会被浪费。

因此,“大模型应用工程化”成为当下最值得关注的主题。它不仅决定了 LLM 在企业中的落地速度,也关系到开发者能否真正从“玩具实验”走向“生产系统”。

2. 原理:大模型应用的核心要素

2.1 大模型的本质:概率分布生成

大模型的底层机制是基于 Transformer 架构 的自回归语言模型。它的核心目标是预测下一个 token 的概率分布:

P(wt∣w1,w2,…,wt−1)

这意味着 LLM 并不具备“逻辑推理”的内建能力,而是通过大规模训练数据与参数量来近似语言的统计分布。理解这一点非常关键,因为它解释了为什么大模型会产生“幻觉”(hallucination)。

2.2 应用层的三大挑战

在工程层面,LLM 应用面临三大核心挑战:

-

上下文长度限制:模型的输入上下文有限,如何在有限 token 内提供足够的信息?

-

知识对齐问题:模型的参数固化在训练集,如何接入企业内部的实时知识?

-

调用链与系统集成:LLM 本身是“函数”,但应用需要稳定的“系统调用链”。

这三点决定了为什么我们需要 RAG(检索增强生成)、函数调用(Function Calling)、智能体编排(Agent Orchestration) 等工程化手段。

2.3 工程化框架的角色

目前流行的工程化框架有:

-

LangChain:主打组件化与调用链拼接

-

LlamaIndex:主打知识检索与数据索引

-

Model Context Protocol (MCP):强调 标准化协议,让模型与外部工具对接更通用

理解这些框架的差异,可以帮助我们在不同场景选择合适的技术栈。

3. 实践:如何构建一个大模型应用?

3.1 基础案例:RAG 检索增强生成

下面的示例演示了如何用 Python + LangChain 实现一个简单的 RAG 应用:

from langchain.chains import RetrievalQA

from langchain.vectorstores import FAISS

from langchain.embeddings import OpenAIEmbeddings

from langchain.chat_models import ChatOpenAI

# 1. 加载向量数据库

embeddings = OpenAIEmbeddings(model="text-embedding-3-small")

vectorstore = FAISS.load_local("faiss_index", embeddings)

# 2. 构建检索器

retriever = vectorstore.as_retriever(search_type="similarity", search_kwargs={"k": 3})

# 3. 构建 RAG QA 系统

qa = RetrievalQA.from_chain_type(

llm=ChatOpenAI(model="gpt-4o-mini"),

retriever=retriever,

chain_type="stuff"

)

# 4. 提问

query = "我们公司的考核流程有哪些步骤?"

result = qa.run(query)

print("Answer:", result)

这个示例演示了最小可行的“文档问答”系统,适用于企业知识库、FAQ 系统。

3.2 函数调用:让大模型真正“能干事”

大模型本身只能输出文本,要让它与系统交互,就需要 Function Calling。以下是一个典型示例:

import openai

functions = [

{

"name": "get_weather",

"description": "获取某个城市的天气",

"parameters": {

"type": "object",

"properties": {

"city": {"type": "string", "description": "城市名称"}

},

"required": ["city"]

}

}

]

messages = [{"role": "user", "content": "帮我查一下北京的天气"}]

response = openai.ChatCompletion.create(

model="gpt-4o-mini",

messages=messages,

functions=functions

)

print(response["choices"][0]["message"])

当用户问“北京天气”时,模型不会直接编造,而是会调用 get_weather 函数,返回结构化参数。这种方式让 LLM 从“文字生成器”变成“智能 API 调度器”。

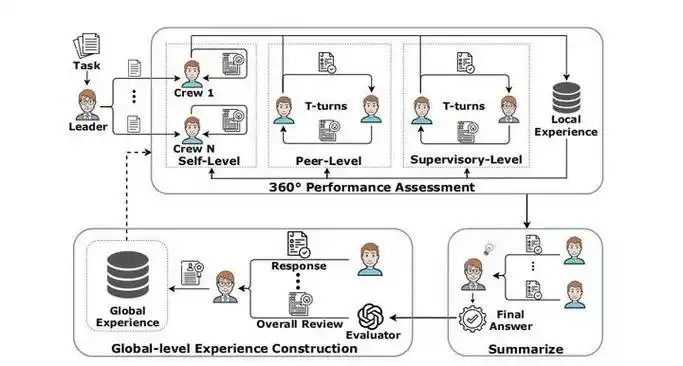

3.3 多智能体编排:复杂任务的未来

一个更复杂的场景是 多智能体协作。例如,在“财务报表核对”系统中,可能有以下角色:

-

数据读取智能体:解析 Excel/CSV

-

规则校验智能体:检查数据是否符合财务规则

-

汇报生成智能体:生成自然语言报告

示意图:

简化版伪代码:

class Agent:

def __init__(self, name, role, llm):

self.name = name

self.role = role

self.llm = llm

def act(self, message):

return self.llm.generate_response(self.role, message)

# 定义三个智能体

reader = Agent("Reader", "读取数据", llm)

checker = Agent("Checker", "校验数据", llm)

reporter = Agent("Reporter", "生成报告", llm)

# 协作流程

data = reader.act("解析2025年考核表格.xlsx")

validated = checker.act(f"校验数据: {data}")

report = reporter.act(f"生成报告: {validated}")

print(report)

这样的架构在 MCP 协议 推动下,正逐渐成为行业共识。

3.4 工程实践经验

在真实项目中,我总结出几条经验:

-

缓存上下文:减少 API 调用,避免重复 token 消耗

-

监控与评测:不仅要监控延迟与成本,还要引入自动化评测(如 BLEU、ROUGE、LLM-as-Judge)

-

人机协同:不要盲目自动化,关键环节要引入“人工确认”

这些经验往往决定了系统能否上线,而不仅仅是“能跑通 Demo”。

4. 总结与升华

大模型应用的未来,不仅仅是“调用 API”,而是走向一种 新型软件工程范式。这套范式的核心特征是:

-

协议化:像 MCP 一样,定义模型与工具的接口标准

-

组件化:像 LangChain 一样,把能力拆分成可组合的模块

-

多智能体化:像人类团队一样,多个智能体协作解决复杂问题

未来的大模型应用开发者,既要理解 深度学习原理,也要掌握 工程架构设计。在这个交叉地带,蕴含着巨大的机会。

💡 你是否也在尝试把大模型应用到实际业务中?欢迎在评论区分享你的探索,也别忘了点赞、收藏,这将帮助更多开发者看到本文。

860

860

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?