1. 背景:大模型为什么看似聪明,却不会推理?

在与大模型(Large Language Model, LLM)交互时,很多人都会遇到一个困惑:

它似乎懂很多知识,能写诗、能写代码、能聊天,但一旦进入严肃的逻辑推理(比如数学证明、多步因果推理),它就会“答非所问”,甚至编造出貌似合理但完全错误的答案。

原因在于:大模型的训练目标不是推理,而是拟合语言分布。

Transformer 模型的本质是自回归预测:

P(wt∣w1,w2,...,wt−1)

它更像是“超强的搜索引擎 + 自动补全系统”,通过在海量语料中学习相似模式来生成下一个词。因此,大模型本质上是 相似性驱动 的,而非逻辑演绎驱动的。

这就是为什么大模型能写出“像样”的文章,却常常在 数理逻辑 或 多步决策 中翻车。

2. 原理:推理缺陷的根源

2.1 统计模式 vs. 逻辑推理

-

统计模式:大模型基于词向量和注意力机制,找出训练数据中“最可能的下一个词”。

-

逻辑推理:需要在规则体系中进行推导(如“如果 A→B,且 B→C,则 A→C”)。

大模型天生缺乏 符号逻辑系统,因此无法保证推理正确性。

2.2 “幻觉”现象的必然性

由于它不具备“对错”机制,只要输出看起来合理,就会自信地给出答案。

例如:

问:质数 97 是不是偶数?

答(错误):97 是偶数,因为它可以被 2 整除。

这并不是 LLM “智障”,而是它的“预测目标”与“逻辑真值”不一致。

2.3 现有研究方向

目前学术界和工业界主要通过三种思路来解决:

-

Chain-of-Thought (CoT):引导模型分步推理

-

工具增强(Tool-Augmented LLM):把模型接入计算器、代码解释器

-

符号 + 神经混合系统(Neuro-Symbolic AI):结合逻辑推理器与大模型

3. 实践:如何增强大模型的推理能力?

3.1 Chain-of-Thought(思维链提示)

通过在 Prompt 中显式要求“逐步思考”,可以显著提升推理正确率。

示例代码(Python + OpenAI API):

from openai import OpenAI

client = OpenAI()

prompt = """

问题:如果火车从北京到上海需要 5 小时,从上海到广州需要 8 小时,

那么从北京到广州需要多久?

请一步一步思考再回答。

"""

response = client.chat.completions.create(

model="gpt-4o-mini",

messages=[{"role": "user", "content": prompt}]

)

print(response.choices[0].message["content"])

输出会更接近于:

-

北京→上海 = 5 小时

-

上海→广州 = 8 小时

-

北京→广州 = 13 小时

而不是直接“编造一个数”。

3.2 工具增强:让模型会“算”

大模型的弱点是算数和精确逻辑,但我们可以通过 函数调用(Function Calling) 来弥补。

例如,把模型接入 Python 计算器:

import openai

import math

functions = [

{

"name": "calculate",

"description": "执行数学计算",

"parameters": {

"type": "object",

"properties": {

"expression": {"type": "string", "description": "数学表达式"}

},

"required": ["expression"]

}

}

]

messages = [{"role": "user", "content": "计算 97 是否是质数"}]

response = openai.ChatCompletion.create(

model="gpt-4o-mini",

messages=messages,

functions=functions

)

print(response["choices"][0]["message"])

这样,模型会调用 calculate 来执行真正的计算,而不是“瞎猜”。

这类方法已经被 OpenAI Code Interpreter、ChatGPT Advanced Data Analysis 广泛应用。

3.3 符号推理器 + LLM

另一种更前沿的方式是 Neuro-Symbolic AI,即让 LLM 生成逻辑公式,再交给符号推理器求解。

示例流程(伪代码):

# LLM 生成逻辑规则

query = "如果 A → B 且 B → C,是否 A → C?"

logic_expression = llm.generate_logic(query)

# 可能输出: "A -> B, B -> C, prove A -> C"

# 交给符号推理器

result = symbolic_solver.prove(logic_expression)

print(result) # True

这类方法在 数学定理证明、法律推理、复杂规则判断 中非常有前景。

3.4 强化学习 + 推理优化

近两年学术界提出的 RLHF(人类反馈强化学习) 与 RLAIF(AI反馈强化学习),已经帮助模型在逻辑任务上进步明显。

例如 DeepSeek-R1 引入了 思维链强化(Chain-of-Thought RL),让模型在训练过程中学会逐步分解问题,而不仅仅依赖相似性检索。

4. 工程实践案例

4.1 金融报表核对场景

我在构建 财务审计数字员工 项目时,遇到一个问题:模型在“金额不匹配”时经常给错解释。

解决方案:

-

用 LLM 读取表格,提取字段

-

将金额校验交给 Python 计算函数

-

把结果再交给 LLM 生成自然语言说明

效果对比:

-

优化前:模型会直接编造“金额相符”

-

优化后:模型会明确指出:“应收账款字段相差 3200 元,可能是四舍五入导致”

4.2 医疗诊断推理

在医学场景中,模型常常会出现“过度自信的幻觉”。解决办法是接入 知识库 + 逻辑推理器:

流程:

-

LLM 抽取症状

-

知识库匹配可能疾病

-

逻辑推理器根据“必然条件 / 可能条件”做进一步筛选

-

LLM 输出诊断报告

5. 总结与升华

大模型的本质是 语言统计机器,它天生缺乏逻辑推理能力。

但这并不是不可解决的问题,而是需要通过 工程化增强 来补足:

-

用 Prompt 工程(CoT、Few-Shot) 引导思维链

-

用 工具调用 弥补模型的弱算力

-

用 符号逻辑系统 构建可验证的推理

-

用 强化学习与训练优化 逐步逼近真正的“推理能力”

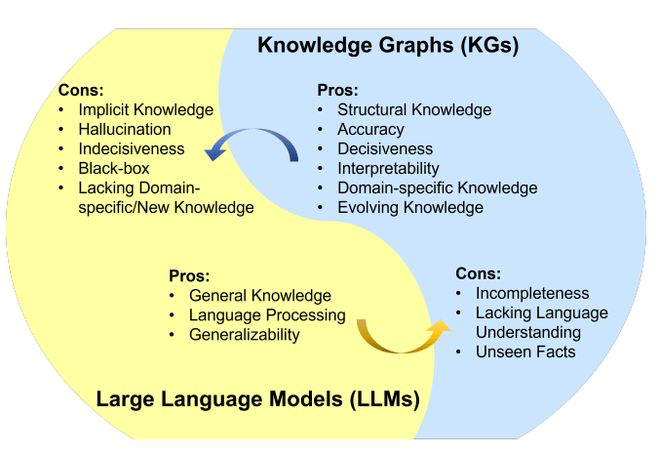

未来,大模型不会单独存在,而是作为 混合智能系统的核心模块。当它与 逻辑推理器、知识图谱、工具链 融合,我们将看到真正具备推理能力的 AI 2.0。

💡 你认为未来的大模型会完全学会逻辑推理,还是永远需要“外挂工具”?欢迎在评论区交流你的观点。

818

818

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?