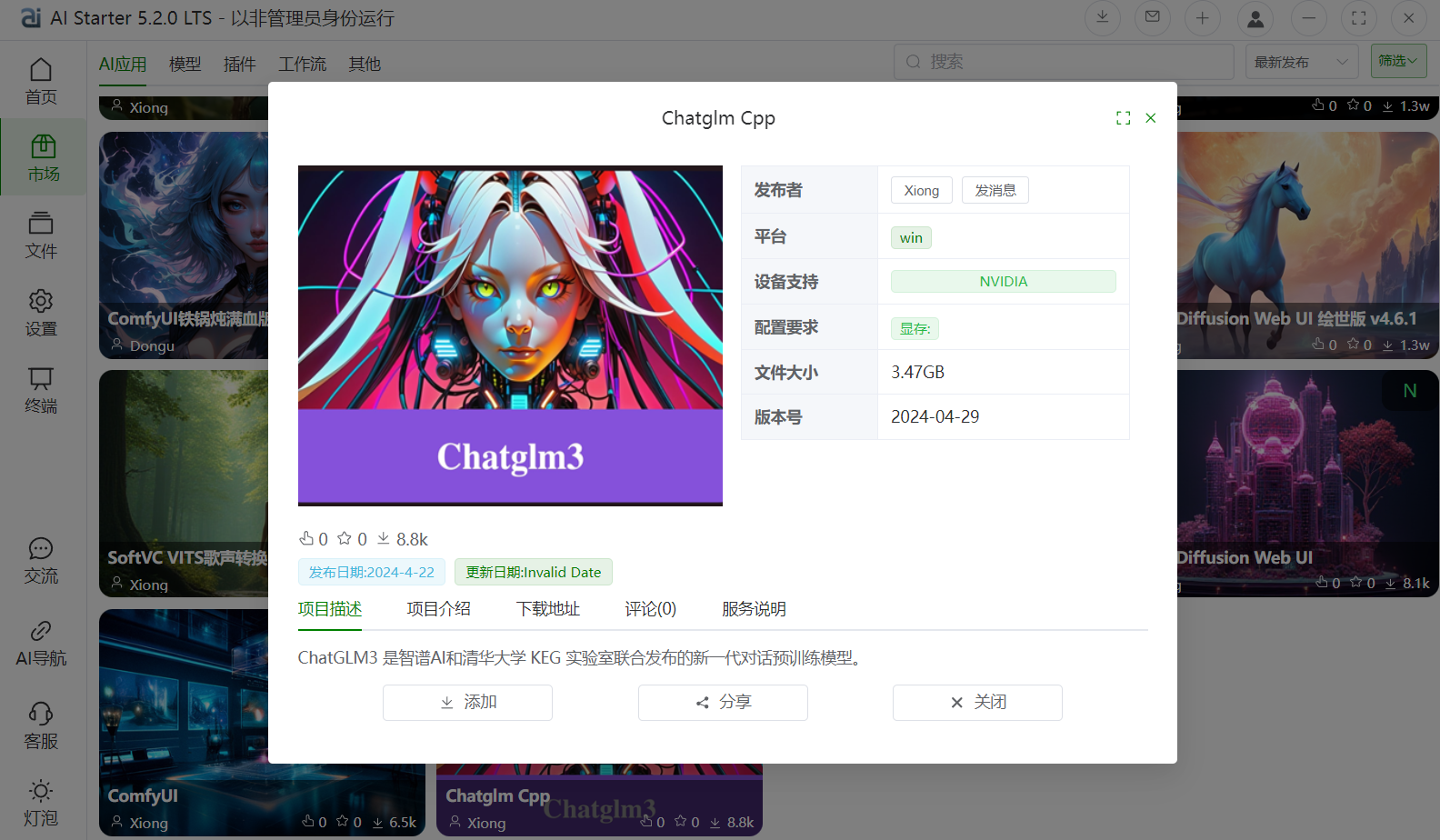

一个开源的本地化大语言模型(LLM)部署工具包,由社区开发者(如AI技术大本营或学术FUN团队)基于智谱AI(Zhipu AI)和清华大学KEG实验室的ChatGLM3系列模型打包而成。 它旨在简化ChatGLM3的本地安装与运行,让CPU用户也能轻松玩转AI聊天,无需复杂环境配置。

核心功能

- 对话生成:支持中英文实时聊天,流式输出(streaming),参数调整(如温度、top_p),并兼容量化模式(减少内存占用)和多GPU支持。

- 本地隐私:所有计算在本地运行,保护数据隐私,适用于科研、开发或个人使用。

- 桌面界面:提供简易GUI,支持文本输入/输出,类似于ChatGPT的桌面对话环境。

- 扩展性:可结合RAG(Retrieval-Augmented Generation)等插件,实现知识库问答或文档总结。

ChatGLM3模型亮点

- 开源双语LLM:ChatGLM3-6B是系列开源版,参数量6B,在对话流畅性和部署门槛上优于前代(如ChatGLM2)。

- 硬件友好:CPU/GPU兼容,6B模型在8GB显存或普通CPU上运行,响应速度快(<1s/轮)。

- 特性升级:引入更强的基础预训练,支持长上下文(~8K tokens),在GLUE等基准上表现突出。

部署与使用

- 一键安装:下载整合包(~5-10GB),解压后运行start.bat(Windows)或对应脚本。无需pip安装依赖,内置Python环境。

- 下载地址:【Chatglm Cpp】https://ipv4.starter.top/users/share?fid=14&type=0,

- GitHub源仓库:https://github.com/THUDM/ChatGLM3

- 运行示例:启动后输入文本,即生成回复。支持WebUI或命令行模式。

适用人群

- AI新手:零门槛体验开源LLM。

- 开发者:快速原型开发、微调模型。

- 企业/科研:本地部署,避免云端API限制。

1155

1155

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?