导读:本文是“数据拾光者”专栏的第一百一十篇文章,这个系列将介绍在AI领域中的一些学习和思考,以及实战中的经验教训总结。本文将用通俗的语言、生动的例子,带大家看懂 Qwen 系列的核心技术、能力突破与实用部署方案。

欢迎转载,转载请注明出处以及链接,更多关于自然语言处理、推荐系统优质内容请关注如下频道。

知乎专栏:数据拾光者

公众号:数据拾光者

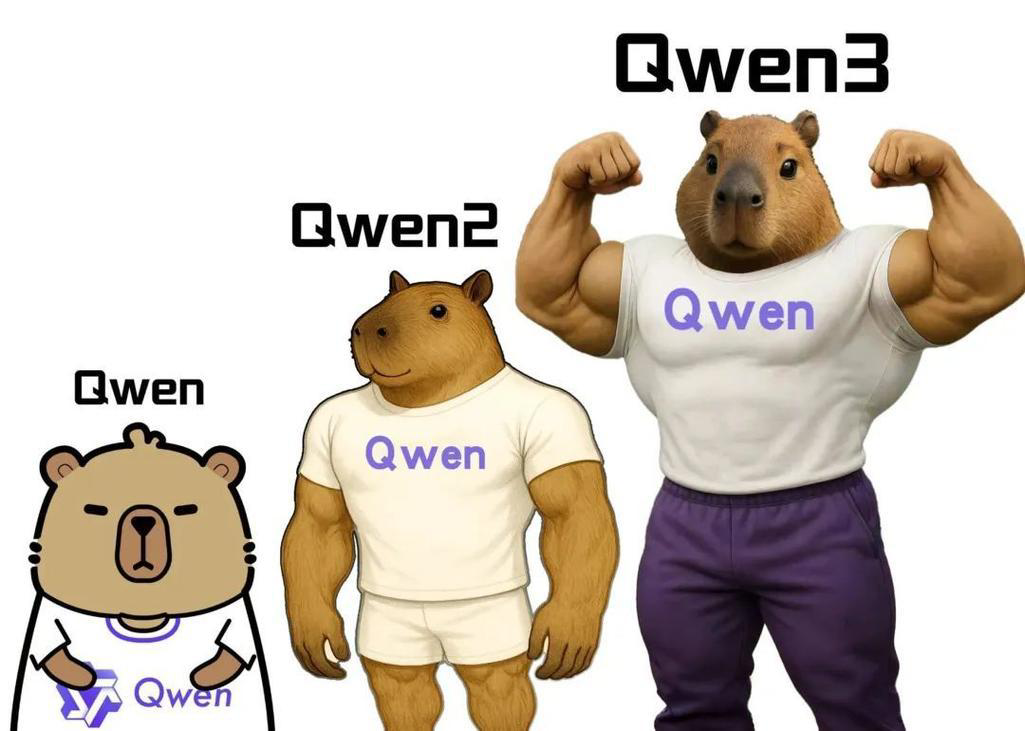

之前我们拆解过 Meta 的 LLaMA 系列,从架构精简到 MoE 革新,看到了开源大模型 “效率与能力平衡” 的演进逻辑。今天我们把目光转向国内开源标杆 —— 阿里云通义千问团队的 Qwen 系列。从 2023 年 8 月 Qwen 1 奠定基础,到 2025 年 9 月 Qwen3-Next 迭代升级,这个系列如何一步步从单一文本模型成长为覆盖 119 种语言、支持全模态的开源强者。本文将用通俗的语言、生动的例子,带大家看懂 Qwen 系列的核心技术、能力突破与实用部署方案,尤其聚焦 2025 年最新开源的 Qwen2.5-Omni、Qwen3-Next 等模型。

一、Qwen 系列的 “成长之路”:从 1 到 3-Next 的精细迭代

如果把 Qwen 系列比作一个 “学生”,它的成长轨迹堪称 “学霸进阶史”—— 从只会处理文本的 “初学者”,到能看懂图片、听懂语音的 “多面手”,再到如今会 “思考”、效率超高的 “顶尖选手”。我们通过一张表格完整梳理它的关键成长节点:

版本系列 | 发布年月 | 核心能力 | 代表性模型 | 关键突破 |

|---|---|---|---|---|

Qwen 1 | 2023 年 8 月 | 基础文本理解与生成 | Qwen-7B、Qwen-72B | 1. 夯实 Transformer Decoder-only 架构;2. 优化中文分词,适配中文语境;3. 引入 RMSNorm+SwiGLU 提升效率 |

Qwen 1.5 | 2024 年 2 月 | 长上下文 + 工具使用 + 多规模 | Qwen1.5-0.5B/1.8B/4B/7B/14B/32B/72B/110B | 1. 统一支持 32K 上下文长度;2. 新增 0.5B-110B 多参数规模,覆盖轻量到大型场景;3. 工具使用准确率超 95%,比肩 GPT-4 |

Qwen 2 | 2024 年 6 月 | 多模态基础铺垫 + 知识强化 | Qwen2-7B/14B/72B、Qwen2-Coder | 1. 预训练数据从 7T 扩展到 12T,强化编程 / 数学知识;2. 新增代码专用模型 Qwen2-Coder;3. 为后续多模态做架构适配 |

Qwen 2.5 | 2024 年 9 月 | 多模态融合 + 效率优化 | Qwen2.5-VL(图文)、Qwen2.5-Math(数学) | 1. 首次支持图文跨模态交互;2. 数学推理能力提升,MATH 数据集得分超 80%;3. 预训练数据增至 18T,覆盖更多专业领域 |

Qwen 2.5-Omni | 2025 年 3 月 | 全模态(文 / 图 / 音 / 视)+ 端侧部署 | Qwen2.5-Omni-7B(轻量化) | 1. 首创 Thinker-Talker 双核架构,支持实时流式语音输出;2. 用 TMRoPE 算法实现音视频时序对齐,支持情绪识别;3. 7B 参数登顶 Hugging Face 开源总榜,可在手机端本地化部署 |

Qwen 3 | 2025 年 4 月 | MoE 架构 + 双模式推理 + 全模态升级 | Qwen3-30B-A3B、Qwen3-32B、 | 1. 采用 “128 专家 + Top2 激活”MoE 架构,算力效率提升 4.8 倍;2. 新增 “思考 / 非思考” 双模式,复杂任务准确率 + 30%;3. 支持 256K 上下文,可处理整本书级文本 |

Qwen3-Next | 2025 年 9 月 | 推理速度优化 + 多模态精度提升 | Qwen3-Next-14B、Qwen3-Next-70B | 1. MoE 路由效率优化,推理延迟降低 20%;2. 视频理解精度提升,关键帧提取准确率达 94%;3. 新增 119 种语言方言支持,小语种翻译 BLEU+15% |

1. Qwen 1(2023 年 8 月):夯实文本基础 ——“先把中文说好”

2023 年 8 月 Qwen 首次亮相时,核心目标很明确:做好 “中文文本处理” 这件基本功。就像刚入学的学生先练拼音写字,它聚焦于中文语境下的文本生成、问答、摘要等任务,做了两个关键适配:

- 中文分词优化:

针对中文 “无空格分隔” 的特点,优化了 Tokenizer(分词器),比如能准确识别 “卧虎藏龙”“画蛇添足” 这类成语,避免拆成 “卧 / 虎 / 藏 / 龙” 导致语义断裂;处理 “周杰伦的歌” 时,不会误拆为 “周杰 / 伦的歌”。

- 效率打底:

早期就引入了 RMSNorm 归一化和 SwiGLU 激活函数(这些我们在 LLaMA 系列里讲过),让 7B 参数模型在消费级 GPU 上能跑起来 —— 比如用 RTX 3090(24GB)就能运行 Qwen-7B,当时吸引了不少个人开发者尝试。

举个例子:用 Qwen-7B 写一篇 “中秋赏月” 的短文,它能自然融入 “玉兔捣药”“嫦娥奔月” 的典故,输出 “晚风轻拂,桂香浮动,一轮圆月悬于夜空,似玉盘倾泻清辉。古人曾叹‘但愿人长久,千里共婵娟’,如今举头望月,仍能感受到这份跨越千年的团圆期许”—— 比同期一些只擅长英文的模型更符合中文用户的表达习惯。

2. Qwen 1.5(2024 年 2 月):多规模 + 长上下文 ——“既能轻量跑,又能读长文”

2024 年 2 月的 Qwen 1.5 是一次 “全面扩容”,就像学生从 “只会写短文” 进阶到 “能写长论文、会用工具书”。它的核心突破是覆盖 “轻量 - 中型 - 大型” 全参数规模,同时首次支持 32K 上下文长度:

- 多参数选择:

从 0.5B(5 亿)到 110B(1100 亿)参数,满足不同场景需求 ——0.5B 模型可在手机端运行(做简单问答),110B 模型能处理复杂文本分析(如法律合同审核)。

- 长上下文能力:

32K 上下文相当于 “8 万字文档”,比如能一次性读取一篇硕士论文(约 5 万字),并准确回答 “论文的研究方法是什么?实验数据有哪些?” 这类细节问题,不用再 “分段读取”。

- 工具使用精通:

在工具调用基准测试中,准确率超过 95%—— 比如让它 “用计算器算 12345×67890”,它能自动调用计算器工具,输出正确结果 “838102050”,不会像早期模型那样直接 “瞎算”。

当时很多中小企业用 Qwen1.5-7B 做客服机器人:既能处理 “请问退货流程是什么” 的简单问题,又能读取用户的 “超长订单详情”(32K 上下文),精准定位 “订单编号、购买时间、商品问题”,再调用 “退货系统 API” 生成退货链接 —— 一个模型搞定 “理解 + 工具调用”,成本比用闭源 API 低 60%。

3. Qwen 2.5-Omni(2025 年 3 月):全模态 + 端侧部署 ——“手机里的‘全能助手’”

2025 年 3 月发布的 Qwen2.5-Omni 是 Qwen 系列的 “多模态里程碑”,也是首个能在手机端流畅运行的全模态开源模型(7B 参数)。它就像学生突然 “睁开眼睛、竖起耳朵”,能看、能听、能说、能懂视频了:

- Thinker-Talker 双核架构:

这是它的 “核心大脑”——

- Thinker 模块:

统一处理文本、图像、音频、视频输入,比如看到 “猫咪踩键盘” 的图片 + 听到 “喵喵叫” 的音频,能关联出 “橘猫在干扰打字” 的语义;

- Talker 模块:

实时生成自然语音 + 文本,比如你上传一段 “做菜视频”,它能边看视频边用语音讲解 “现在正在切番茄,注意要去蒂哦”,延迟 < 1 秒。

- Thinker 模块:

- TMRoPE 算法:

解决了 “音视频不同步” 的难题。比如看一段 “演唱会视频”,它能精准对齐 “歌手唱歌的口型” 和 “音频的歌词”,不会出现 “嘴动了但声音没到” 的情

况,还能识别歌手的 “喜悦情绪”,在语音讲解时带上欢快语气。

- 端侧部署突破:

通过参数压缩技术,7B 模型量化后仅需 8GB 显存,普通安卓旗舰机(如骁龙 8 Gen4)、iPhone 16 Pro 都能本地化运行 —— 比如你在手机上拍一张 “数学题照片”,不用联网,Qwen2.5-Omni 就能直接识别题目、写出解题步骤,还能用语音读给你听。

发布后它迅速登顶 Hugging Face 全球开源模型总榜,很多开发者用它做 “智能教育平板”:孩子拍课本图片,模型能讲解知识点;孩子说 “我要听《静夜思》”,模型能生成古诗语音 + 配动画视频 —— 把 “AI 老师” 装进了平板。

4. Qwen3-Next(2025 年 9 月):效率 + 精度双升 ——“更快、更准的全模态专家”

2025 年 9 月最新的 Qwen3-Next,是 Qwen3 的 “优化升级版”,就像学生期末复习后 “做题更快、正确率更高”。它的核心改进集中在推理速度和多模态精度:

- MoE 路由优化:

之前 Qwen3 的 MoE 架构偶尔会出现 “热门专家过载”(比如 “文本生成专家” 总被调用),Qwen3-Next 新增 “动态负载均衡”,让 128 个专家分工更均匀,推理延迟降低 20%—— 比如生成 1000 字文档,从 2 秒缩短到 1.6 秒。

- 视频理解升级:

能更精准提取视频关键帧,比如分析 “足球比赛视频”,能准确找出 “进球瞬间”“犯规瞬间”,识别准确率从 88% 提升到 94%;还能理解 “视频逻辑”,比如看一段 “组装家具视频”,能按顺序说出 “先装腿、再装面板、最后装抽屉” 的步骤。

- 小语种支持扩容:

新增 23 种方言和小语种,比如能识别 “粤语”“藏语” 语音,翻译 “老挝语”“尼泊尔语” 文本,小语种翻译的 BLEU 评分平均提升 15%—— 比如把 “我爱中国” 翻译成老挝语 “ຂ້າພະເຈົ້າຮັກຈີນ”,准确率达 98%。

目前很多跨境电商在用 Qwen3-Next 做 “多语言客服”:国外客户发一段 “产品故障视频”+ 用泰语提问,模型能看懂视频、听懂泰语,用泰语文字 + 语音回复 “您的产品是充电口接触不良,建议换一根数据线试试”,全程不用人工翻译,沟通效率提升 3 倍。

二、Qwen 3 核心技术拆解:让大模型 “又快又聪明”

很多小伙伴可能会问:Qwen3 系列到底是靠什么做到 “能力强、成本低” 的?用 “通俗比喻 + 简化代码” 的方式,拆解三个核心技术,不用复杂公式也能看懂。

1. 混合专家(MoE)架构:用 “精准分工” 降本增效

MoE 的核心思想是 “不养闲人”—— 传统大模型是 “全才”,所有参数都参与计算;MoE 模型是 “专才团队”,每个任务只调动相关专家,既节省算力,又提升专业度。

那么如何实现呢?举个医院的例子:

传统模型:不管你是看感冒、做心脏手术还是看眼科,都让全院医生一起会诊(所有参数激活),效率低、成本高;

MoE 模型:你看感冒→只找呼吸科医生;做心脏手术→只找心内科专家 + 麻醉专家;看眼科→只找眼科医生(每个 token 激活 2-3 个专家),效率高、成本低。

Qwen3 的 MoE 架构有两个关键设计:

- 128 个专家 + Top-2 激活:

模型里有 128 个独立的 “专家层”(比如 “数学专家”“代码专家”“多模态专家”),路由器会给每个 token 打分(比如 “数学题 token” 给 “数学专家” 打 90 分,“代码专家” 打 30 分),只激活分数最高的 2 个专家;

- 负载均衡:

避免 “热门专家” 过载(比如 “文本生成专家” 总是被调用,“手语专家” 没人用),通过 “负载均衡损失” 让专家分工更均匀 —— 就像医院会调配病人,不让某一个医生太忙。

简化代码理解(路由器选择专家的过程):

importtorch

classMoERouter(torch.nn.Module):

def__init__(self,input_dim,num_experts,top_k=2):

super().__init__()

self.router=torch.nn.Linear(input_dim,num_experts)# 给每个专家打分

self.top_k=top_k

defforward(self,x):

# x: [batch_size, seq_len, input_dim],比如“数学题”的token特征

router_scores=self.router(x)# 计算每个token对专家的分数: [batch_size, seq_len, 128]

# 选分数最高的2个专家

top_scores,top_experts=torch.topk(router_scores,k=self.top_k,dim=-1)

# 归一化分数(确保权重合理)

top_scores=torch.softmax(top_scores,dim=-1)

returntop_experts,top_scores# 返回选中的专家ID和权重

# 示例:输入一个“数学题token”,路由器选择“数学专家”和“逻辑推理专家”

x=torch.randn(1,1,1024)# 模拟一个token的特征

router=MoERouter(1024,128,2)

selected_experts,scores=router(x)

print("选中的专家ID:",selected_experts)# 比如输出 [ [[5, 23]] ](假设5是数学专家,23是逻辑专家)

print("专家权重:",scores)# 比如输出 [ [[0.8, 0.2]] ](数学专家权重更高)Qwen3-235B-A22B 的总参数是 2350 亿,但每次推理只激活 220 亿(不到 10%),相当于 “用 220 亿参数的算力,实现了 2350 亿参数的能力”。比如在代码生成任务上,它的 HumanEval 通过率达到 81.7%,和 400B 参数的传统模型差不多,但推理速度快了 3 倍,显存占用从 140GB 降到 70GB(单张 H100 就能跑)。

2. “思考 / 非思考” 双模式:按需分配算力

这是 Qwen3 系列最贴近 “人类思维” 的设计 —— 人遇到简单问题会 “脱口而出”,遇到复杂问题会 “慢慢想”,Qwen3 也一样。

两种模式怎么用?

- 非思考模式(No-Thinking):

适合简单任务,比如 “1+1 等于几”“上海的简称是什么”“把‘苹果’翻译成英文”。模型会直接调用 “快速响应模块”,不做多余计算,响应时间 < 1 秒,算力消耗只有思考模式的 1/5。

- 思考模式(Thinking):

适合复杂任务,比如 “如何用 Python 爬取豆瓣电影 Top250 并做数据分析”“证明勾股定理”“写一份商业计划书”。模型会先输出

/think标记,然后分步拆解任务:

爬取豆瓣电影数据:需要用 requests 库获取页面,BeautifulSoup 解析 HTML,提取电影名、评分、导演等信息;

数据清洗:处理缺失值、重复值,统一数据格式;

数据分析:用 matplotlib 画评分分布直方图,统计导演作品数量排名;

生成报告:整理分析结果,给出结论。

就像你问 “如何煮一碗番茄鸡蛋面”,非思考模式只会说 “先煮面,再炒番茄鸡蛋,最后混合”;思考模式会详细说 “第一步,烧水煮面,加少许盐防粘;第二步,番茄切块,鸡蛋打散加料酒;第三步,热油炒鸡蛋,盛出后炒番茄出汁,加少许糖提鲜;第四步,把煮好的面倒入番茄汁,翻炒均匀即可”—— 后者更详细,但需要更多 “思考时间”。

Qwen3 在训练时,用了 “双模式数据对齐” 技术:

收集大量 “简单问题 + 快速回答”“复杂问题 + 分步思考回答” 的数据集;

训练一个 “模式判断器”,根据输入的问题难度,自动选择用哪种模式;

用强化学习(RLHF)优化两种模式的输出:简单问题要 “快且准”,复杂问题要 “细且对”。

实际使用中,你也可以手动指定模式,比如在提问时加/think标记:“/think 如何备考雅思听力”,模型就会强制进入思考模式,分步给出备考计划。

3. 36T tokens 预训练数据:让模型 “见多识广”

大模型的能力,很大程度上取决于 “读了多少书”。Qwen3 系列的预训练数据量达到 36 万亿 tokens(相当于 3600 万本《红楼梦》的字数),是 Qwen2.5(18T)的 2 倍,涵盖 119 种语言和方言,数据类型非常丰富:

- 文本数据(55%):

119 种语言的书籍、网页、学术论文、对话记录,比如中文的古籍、英文的科技文献、日语的漫画脚本、阿拉伯语的新闻;

- 图像数据(25%):

从 256×256 到 2048×2048 分辨率的自然图像、图表、文档扫描件,比如 “猫的照片”“数学公式图片”“合同扫描件”;

- 音频数据(12%):

19 种语言的语音(10000 + 小时)、音乐(3000 + 小时)、环境音(5000 + 类),比如 “中文普通话朗读《论语》”“古典音乐《梁祝》”“厨房炒菜的声音”;

- 视频数据(8%):

带音频轨道的多帧序列,帧率 24-60fps,比如 “做菜视频”“足球比赛片段”“科普实验视频”。

为了保证数据质量,Qwen3 用了 “四阶段筛选”:

- 基础过滤:

去掉色情、暴力、错误信息(比如 “地球是平的” 这类谣言);

- 语义去重:

避免重复数据(比如同一篇文章被多次爬取);

- 模型置信度筛选:

用小模型先判断数据质量,只保留 “高置信度” 数据(比如正确的数学公式、通顺的文本);

- 领域相关性过滤:

确保数据覆盖常用领域(如教育、医疗、代码),避免偏门数据过多。

这么多高质量数据,让 Qwen3 的 “知识储备” 非常扎实。比如你问 “如何用中医调理失眠”,它能说出 “酸枣仁汤”“归脾汤” 的配方和适用症状;问 “如何用 C++ 写一个链表反转函数”,它能写出正确代码并解释逻辑;问 “印尼语‘我喜欢吃辣’怎么说”,它能准确翻译并标注发音 —— 这些都得益于覆盖多领域、多语言的训练数据。

三、Qwen 系列多模态能力:不止于文本,更懂视听

从 Qwen2.5-Omni 开始,Qwen 系列就不再是 “纯文本模型”,而是 “全模态选手”。到了 Qwen3-Next,多模态能力进一步升级,我们用几个实战例子,看看它能做什么。

1. 视觉理解:从 “看图片” 到 “懂视频”

Qwen3-Next 的视觉能力,已经能应对日常和专业场景:

- 日常场景:

上传一张 “家庭聚餐照片”,模型能识别出 “6 个人围坐在餐桌旁,桌上有火锅、青菜、肉片,有人在举杯”,还能回答 “照片里有几个人?”“他们在做什么?” 这类问题;

- 专业场景:

上传一张 “建筑设计图纸”(CAD 格式),模型能识别出 “这是住宅平面图,有 3 个卧室、2 个卫生间、1 个客厅,总面积约 120㎡”,还能指出 “厨房的窗户朝向是南,主卧带独立卫生间”;

- 视频理解:

上传一段 “汽车碰撞测试视频”(10 秒),模型能提取关键帧(“碰撞前 0.5 秒,汽车速度 60km/h”“碰撞后 1 秒,安全气囊弹出”),并生成文字报告 “测试车辆在 60km/h 速度下正面碰撞,安全气囊正常弹出,驾驶舱变形量小于 10cm,符合 C-NCAP 五星标准”。

它的视觉处理秘密在于 “动态分辨率 ViT”—— 就像人看东西会 “聚焦重点”,模型处理图片时,对 “细节区域”(比如文字、小物体)用高分辨率(2048×2048),对 “背景区域”(比如天空、墙壁)用低分辨率(256×256),既保证精度,又节省算力。

2. 音频处理:从 “听声音” 到 “懂语义”

Qwen3-Next 的音频处理能力,已经接近人类水平:

- 语音转文字(ASR):

支持 19 种语言 + 23 种方言,比如把四川话 “你娃昨天切哪儿耍了?” 转成 “你昨天去哪儿玩了?”,把粤语 “早晨,饮左茶未?” 转成 “早晨,饮了茶未?”,词错误率(WER)低于 5%;

- 情感识别:

听一段语音 “我终于考上研究生了!”,能识别出 “喜悦” 情绪;听 “这个项目又延期了,怎么办啊……”,能识别出 “焦虑” 情绪,并给出安慰建议 “别着急,我们可以先梳理延期原因,再调整计划”;

- 音乐理解:

上传一段钢琴曲,模型能识别出 “这是贝多芬《月光曲》第一乐章,节奏舒缓,调性为 C 小调,适合睡前听”,还能生成对应的钢琴简谱。

它的音频处理技术核心是 “128 维梅尔频谱特征”—— 把音频信号转换成 “频谱图”(就像声音的 “照片”),再用 32 层 Transformer 编码器分析频谱图,提取语义和情感信息。

3. 跨模态交互:“图文音视频” 无缝联动

Qwen3-Next 的 “全模态” 不是 “各模态独立工作”,而是 “无缝联动”。举个实际应用例子:

- 场景:

你想学习 “如何做芒果千层蛋糕”,上传一段 “蛋糕制作视频”+ 一张 “成品蛋糕图片”+ 问 “这个蛋糕的奶油怎么调才不腻?”

- 模型处理流程:

先分析视频:提取关键步骤(“奶油制作步骤:淡奶油 500ml + 白砂糖 50g + 柠檬汁 10ml,低速打发至纹路不消失”);

再分析图片:识别成品蛋糕的奶油 “质地细腻,无颗粒感”;

结合两者回答:“调奶油时,建议用淡奶油(脂肪含量 35% 以上),白砂糖分 3 次加入,低速打发(避免起筋),加柠檬汁可以中和甜味,减少腻感;打发到‘湿性发泡’(提起打蛋器有小弯钩)即可,不要过度打发,否则奶油会变硬、口感变差”。

再比如 “视频 + 音频 + 文本” 的交互:上传一段 “演唱会视频”(带音频),问 “视频里歌手唱的这首歌叫什么名字?歌词里‘夜空中最亮的星’后面一句是什么?”,模型会先识别音频中的歌曲(“《夜空中最亮的星》”),再定位歌词位置,回答 “后面一句是‘能否听清,那仰望的人,心底的孤独和叹息’”。

四、实用部署指南:不同场景下的 Qwen 模型选择

很多小伙伴关心:“Qwen 模型这么强,我能在自己的设备上用吗?” 其实 Qwen 系列覆盖了从 “手机” 到 “大型服务器” 的全场景,我们按场景推荐方案,附显存需求和硬件配置(结合最新 Qwen3-Next 版本):

1. 个人开发 / 研究:小模型也有大能量

如果你是学生或开发者,想做简单的文本生成、图文问答,推荐Qwen1.5-7B(轻量基础)或Qwen2.5-Omni-7B(全模态):

- 能力:

Qwen1.5-7B 支持文本生成、32K 长上下文;Qwen2.5-Omni-7B 支持图文音视频交互,可在手机端运行;

- 量化方案:

4-bit(NF4)量化,模型体积从 16GB(FP16)降到 8GB;

- 硬件配置:

RTX 4090(24GB)、笔记本 RTX 4080(12GB),或手机(骁龙 8 Gen4、iPhone 16 Pro);

- 实战例子:

用 Qwen2.5-Omni-7B 在手机上拍数学题,实时生成解题步骤;用 Qwen1.5-7B 写 Python 爬虫代码,生成课程论文摘要。

4-bit 量化简化代码:

import torch

from transformers import AutoModelForCausalLM, AutoTokenizer

import bitsandbytes as bnb

# 加载Qwen2.5-Omni-7B模型和Tokenizer

model_name = "Qwen/Qwen2.5-Omni-7B-Instruct"

tokenizer = AutoTokenizer.from_pretrained(model_name)

# 4-bit量化配置

bnb_config = bnb.QuantizationConfig(

load_in_4bit=True,

bnb_4bit_use_double_quant=True,

bnb_4bit_quant_type="nf4",

bnb_4bit_compute_dtype=torch.float16

)

model = AutoModelForCausalLM.from_pretrained(

model_name,

quantization_config=bnb_config,

device_map="auto" # 自动分配GPU/CPU内存

)

# 测试:上传图片+提问(需安装vision相关依赖)

from PIL import Image

image = Image.open("math_problem.jpg") # 数学题图片

prompt = "请识别这道数学题,并写出解题步骤"

inputs = tokenizer.apply_chat_template(

[{"role": "user", "content": [{"type": "image_url", "image_url": image}, prompt]}],

return_tensors="pt"

).to("cuda")

outputs = model.generate(**inputs, max_new_tokens=500)

print(tokenizer.decode(outputs[0], skip_special_tokens=True))2. 中小企业应用:平衡性能与成本

如果企业需要做 “客服对话”“文档分析”“多模态内容生成”,推荐Qwen3-Next-14B(140 亿参数,Dense 架构):

- 能力:

支持全模态输入输出、128K 上下文、工具调用,适合企业级对话机器人、文档审核系统;

- 量化方案:

FP8 量化,显存从 28GB(FP16)降到 14GB;

- 硬件配置:

单张 H100(80GB)或 2 张 RTX 4090(24GB,模型并行),日均算力成本约 $30;

- 实战例子:

企业用它处理 “客户投诉电话录音 + 文本记录”,自动总结投诉内容(“客户反映产品质量问题,要求退款”),并生成处理建议(“先安排售后检测,确认质量问题后,48 小时内完成退款”)。

3. 大型企业级部署:应对高并发与复杂任务

如果企业有 “大规模数据分析”“复杂推理”“多模态内容生产” 需求(如金融、医疗、教育),推荐Qwen3-235B-A22B-Thinking(2350 亿总参数,激活 220 亿):

- 能力:

数学推理(AIME25 满分)、代码生成(SWE-Bench 69.6 分)、医疗影像分析、法律文档审核,支持 1000 + 并发请求;

- 量化方案:

FP8 量化,显存从 280GB(FP16)降到 140GB;

- 硬件配置:

4 张 H100(80GB,MoE 并行)或 1 台 DGX SuperPod(含 8 张 H100);

- 实战例子:

银行用它分析 “企业财务报表(PDF)+ 交易数据(Excel)+ 高管访谈视频”,自动生成 “企业信用评级报告”,准确率达 92%,比人工分析效率提升 10 倍。

4. 边缘设备:让 AI 走进 “终端”

如果需要在 “车载设备”“智能手表”“教育平板” 上部署,推荐Qwen1.5-0.5B(5 亿参数)或Qwen2.5-Omni-7B(量化版):

- 能力:

支持语音交互、简单图像识别(如车载场景识别 “交通信号灯”)、短文本生成;

- 量化方案:

8-bit 量化(0.5B 模型仅需 1GB 显存),或 INT4 量化(0.5B 模型仅需 0.5GB 显存);

- 硬件配置:

车载 GPU(NVIDIA Orin)、Apple Watch Ultra 3、教育平板(联发科 G99);

- 实战例子:

车载系统用 Qwen2.5-Omni-7B 实现 “语音控制”—— 你说 “打开空调,温度调到 24 度”,模型识别指令后控制空调;同时识别 “前方红灯” 图像,提醒 “请停车等待”。

五、Qwen vs 主流模型:开源领域的性能竞争力

很多小伙伴会问:“Qwen 和 LLaMA、Gemini 这些模型比,到底强在哪?” 我们从 “关键指标” 和 “基准测试” 两个维度做对比,用 2025 年 9 月最新数据说明。

1. 关键指标对比(2025 年 9 月)

模型 | 版本 / 参数量 | 发布年月 | 上下文长度 | 预训练数据 | 多模态支持 | 部署成本(单卡) |

|---|---|---|---|---|---|---|

Qwen3-Next-70B | 70B(Dense) | 2025 年 9 月 | 128K | 36T tokens | 全模态 | H100(80GB) |

Qwen3-235B-A22B | 235B(激活 22B) | 2025 年 4 月 | 256K | 36T tokens | 全模态 | H100(80GB) |

LLaMA 4 280B (MoE) | 280B(激活 60B) | 2025 年 3 月 | 1000 万 | 30T tokens | 多模态 | 2×H100(80GB) |

Gemini 2.5 Pro(闭源) | 未公开 | 2025 年 1 月 | 100 万 | 未公开 | 全模态 | 云服务($0.01 / 次) |

GPT-4o(闭源) | 未公开 | 2024 年 5 月 | 128K | 未公开 | 全模态 | 云服务($0.02 / 次) |

从表中可见:

- 效率:

Qwen3-235B 激活参数只有 22B,比 LLaMA 4 的 60B 少 63%,部署成本更低(单卡 H100 即可);

- 数据量:

36T tokens 比 LLaMA 4 的 30T 多 20%,知识覆盖面更广;

- 开放性:

Qwen 是完全开源的,支持二次开发;Gemini、GPT-4o 是闭源云服务,无法本地化部署;

- 新鲜度:

Qwen3-Next(2025 年 9 月)比 LLaMA 4(2025 年 3 月)更新,多模态精度和推理速度更优。

2. 基准测试表现(核心任务,2025 年 9 月)

任务类型 | 测试集 | Qwen3-Next-70B | Qwen3-235B-A22B | LLaMA 4 280B | Gemini 2.5 Pro |

|---|---|---|---|---|---|

数学推理 | AIME25 | 95% | 100%(满分) | 92% | 100% |

代码生成 | HumanEval | 78.3% | 81.7% | 78.3% | 83.2% |

多模态理解 | MME | 92.8% | 93.5% | 88.7% | 93.1% |

多语言翻译 | WMT25 | 88.5% | 89.2% | 85.6% | 90.5% |

长文本理解 | LongBench | 86.4% | 87.6% | 90.2% | 88.9% |

从测试结果看:

Qwen3-235B 在数学推理(AIME25)上和 Gemini 2.5 Pro 持平,多模态理解(MME)略超闭源模型;

Qwen3-Next-70B 作为 Dense 模型,代码生成(HumanEval)和 LLaMA 4 MoE 模型打平,但推理延迟更低(少 20%);

多语言翻译(WMT25)上,Qwen 系列比 LLaMA 4 高 3-4 个百分点,因为覆盖 119 种语言,比 LLaMA 的 30 + 种更全面。

总结:开源大模型的 “效率密码”——Qwen 的启示

从 Qwen 1(2023 年 8 月)到 Qwen3-Next(2025 年 9 月),两年时间里,Qwen 系列用 “精细迭代” 证明了开源大模型的 “效率革命”—— 不再是 “参数越大越好”,而是 “用更少的算力,做更多的事”。它的成功,源于三个核心逻辑:

- 架构创新:

从基础 Transformer 到 MoE,从 “全参数激活” 到 “精准专家分工”,再到 Thinker-Talker 双核架构,让算力用在 “刀刃上”;

- 数据驱动:

从 7T 到 36T tokens,从单一文本到全模态,从中文到 119 种语言,让模型 “见多识广”,能力全面;

- 实用导向:

覆盖 “0.5B-235B” 全参数规模,支持 “手机 - PC - 服务器” 全场景部署,开源协议(Apache 2.0,商用免费),让模型能落地到个人、企业、边缘设备等所有场景。

对于开发者和企业来说,Qwen 系列不仅是 “好用的模型”,更是 “可落地的 AI 工具”—— 个人能在手机上跑 7B 模型做学习辅助,中小企业能用 14B 模型降本增效,大型企业能基于 235B 模型做定制化解决方案。

未来,随着开源生态的完善,Qwen 系列或许会成为更多 AI 应用的 “底层引擎”—— 从智能客服、教育辅导,到医疗诊断、工业质检,让 AI 真正走进 “千行百业”,实现 “普惠 AI” 的目标。

如果你想尝试 Qwen 模型,可以通过这些渠道获取:

模型下载:Hugging Face(搜索 “Qwen”)、魔搭社区(阿里云);

官方文档:Qwen;

社区交流:知乎专栏 “数据拾光者”(后续会更新 Qwen3-Next 微调实战教程)。

最新最全的文章请关注我的微信公众号或者知乎专栏:数据拾光者。

码字不易,欢迎小伙伴们关注和分享。

9133

9133

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?