一、论文理论

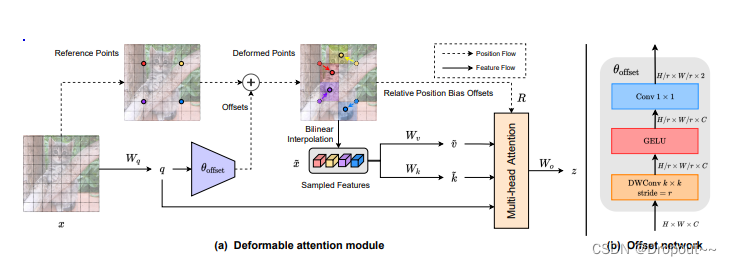

可变形自注意力模块根据数据需要选择自注意力中的关键点和值,使模型专注于相关区域并捕捉更重要的特征。

论文地址:Vision Transformer with Deformable Attention

1.理论思想

可变形注意力机制

2.创新点

(1)可变形注意力:解决传统自注意力机制处理图像中所有像素导致计算量较大等问题,本文所设计的模块只关注部分关键区域,减少计算量。

(2)动态采样点:动态选择采样点,使模型关注当前任务重要特征部分

(3)即插即用

操作过程:

对于每个注意力模块,首先将参考点生

本文介绍了YOLOv5中引入的可变形注意力机制(DAT),该机制通过动态采样点减少计算量,增强模型对关键区域的关注。论文详细阐述了DAT的理论思想和创新点,并提供了代码部署教程,包括在模型中的实现位置和yaml文件配置。通过DAT,可以提高模型的效率和信息捕获能力。

本文介绍了YOLOv5中引入的可变形注意力机制(DAT),该机制通过动态采样点减少计算量,增强模型对关键区域的关注。论文详细阐述了DAT的理论思想和创新点,并提供了代码部署教程,包括在模型中的实现位置和yaml文件配置。通过DAT,可以提高模型的效率和信息捕获能力。

订阅专栏 解锁全文

订阅专栏 解锁全文

1286

1286

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?