Dropout为什么可以减少过拟合?

(1)它会随机丢弃掉一些结点,所以看起来是在更小的网络上训练。

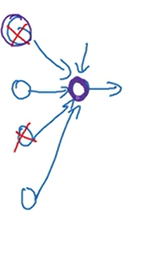

(2)以下图紫圈的神经元为例,由于在中间做了dropout,所以向它输入的四个神经元可以随机失活,所以紫圈神经元不能把所有权重都压在一个输入神经元上面,以此来控制权重。(和L2正则化达到的效果类似)

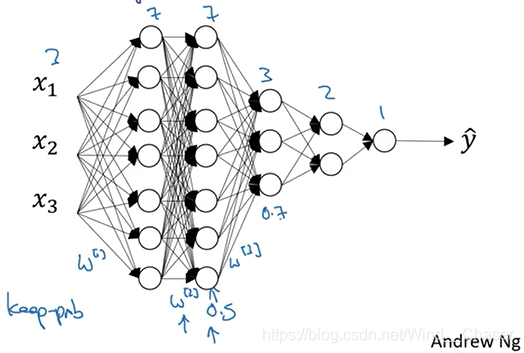

举例:如下图,可以对不同的层使用不同的留存率。对于7*7的权值矩阵,使用0.5的留存率(过拟合的概率高),而其他层设置较小的留存率。

其他:

dropout在计算机视觉中使用较多。(像素数据多)

使用dropout使得损失函数的效果不那么明确,而且无法作图观察模型表现。

PS:

L2正则化即在权值上加惩罚项的方法。

731

731

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?