本章系统讨论构建可复现的科研数据集与基准评测的理论基础与工程实现要点。内容分为三部分:数据与元数据标准化、基准评测与统计检验的严谨设计、以及开源复现流程(代码组织、容器化、CI 测试)。每一小节从定义出发给出定理/命题并证明必要结论,旨在作为教材中“原理与实践”章节的正式教材内容。

14.1 数据集标准化字段与元数据模板

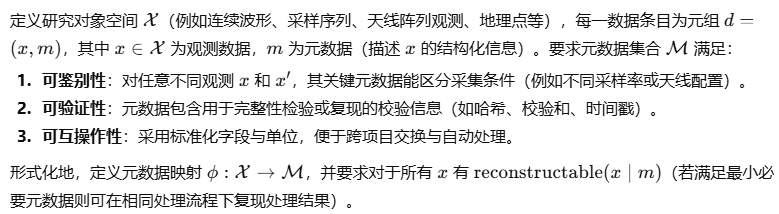

14.1.1 目标与形式化表述

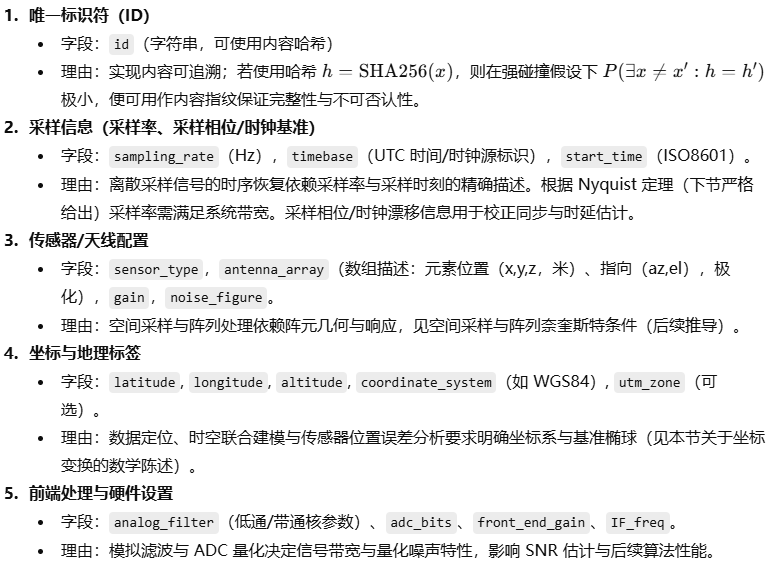

14.1.2 核心字段清单与数学说明

下面给出推荐的最小字段集合与其理论理由。

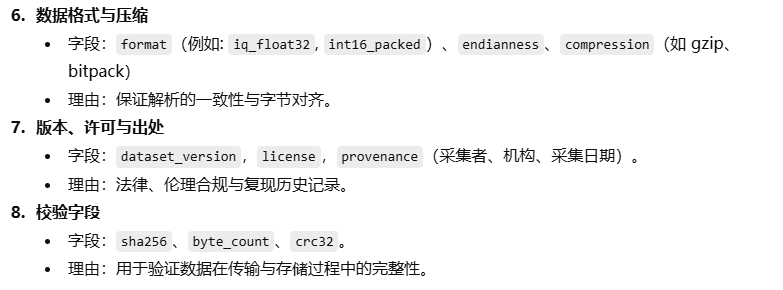

14.1.3 采样率与时钟详细说明(Nyquist 与同步)

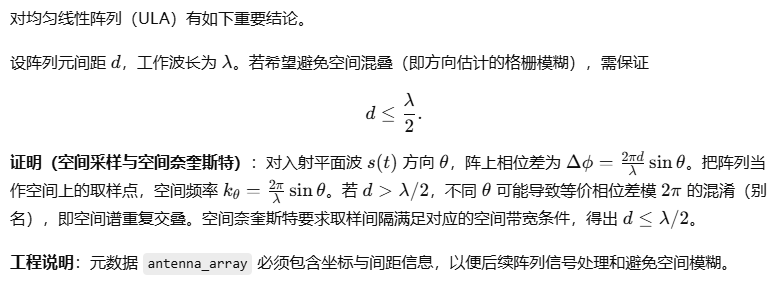

14.1.4 阵列与空间采样:阵元间距的限制

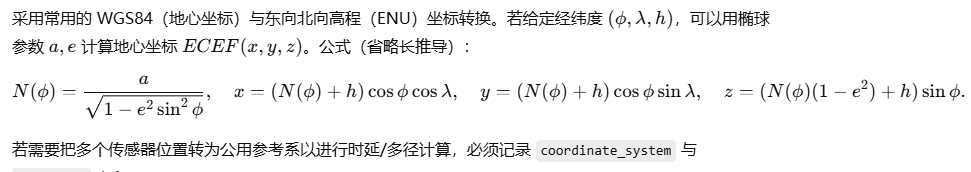

14.1.5 地理坐标与参考系转换(简要公式)

14.2 基准评测设计:训练/验证/测试划分与统计显著性检验

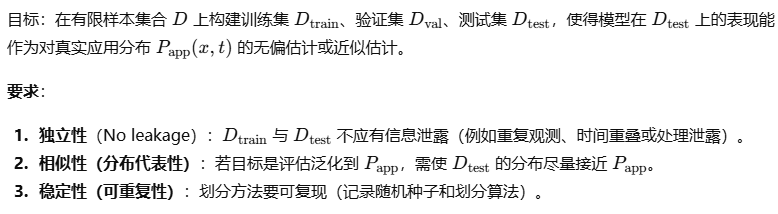

14.2.1 划分原则的形式化

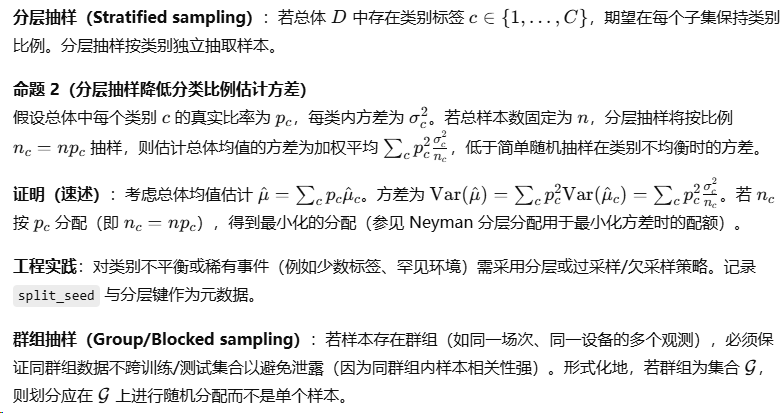

14.2.2 随机划分、分层抽样与群组抽样

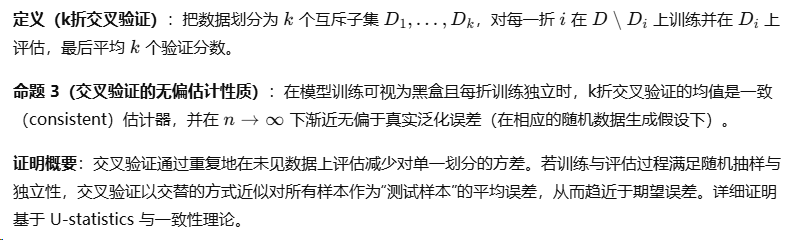

14.2.3 交叉验证与估计器无偏性

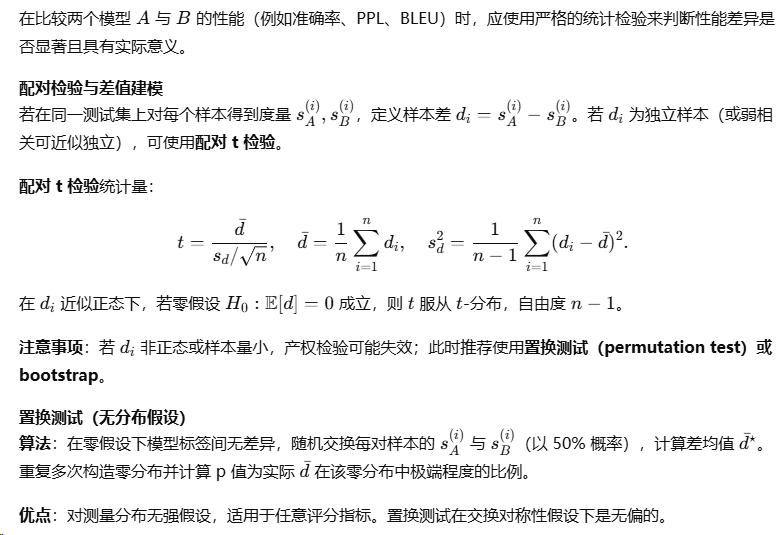

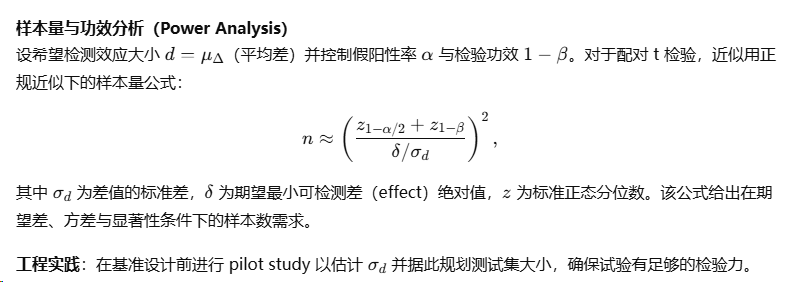

14.2.4 统计显著性检验与样本量计算

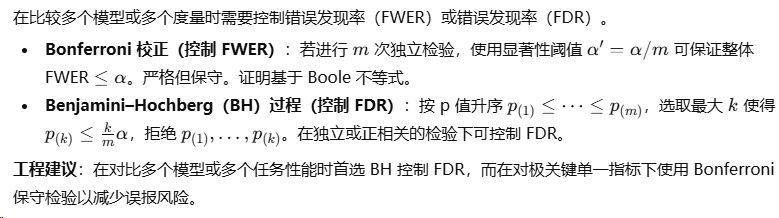

14.2.5 多重比较与控制误差率

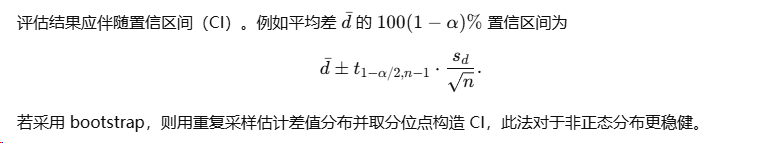

14.2.6 置信区间与不确定性度量

14.3 开源复现流程:代码组织、Docker/容器化、CI 测试模板

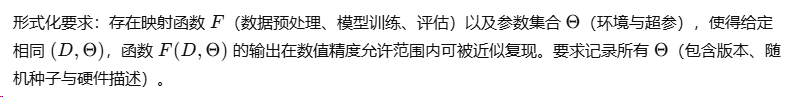

14.3.1 可复现性的形式化定义

将复现分为三层:

-

可重复性(Repeatability):在相同实验条件下同一研究者可重复得到相似结果。

-

重现性(Reproducibility):不同研究者在不同硬件/环境下可重复实现结果。

-

可扩展重现性(Robust Reproducibility):在合理变化(随机种子、微小超参)下结果稳定。

14.3.2 环境锁定:依赖可追溯与内容地址化

方法:

-

记录依赖清单并固定版本(

requirements.txt或pip的hash),或使用包管理器锁文件(pip的requirements.txt+--hash,或poetry.lock)。 -

使用容器镜像并用**镜像摘要(digest)**锁定基础镜像(例如 Docker 使用

ubuntu@sha256:...),避免拉取浮动的latest标签引入变化。

14.3.3 确定性构建与随机性的控制

要点:

-

控制 PRNG 种子:在代码与训练脚本中将所有 PRNG(Python

random、NumPy、PyTorch、TensorFlow、CUDA)设定固定种子。 -

禁用不可控的并行非确定性:例如某些 GPU 后端在不同线程/计算顺序下产生非确定浮点结果,需在可行时启用 deterministic 模式(例如 PyTorch 的

torch.use_deterministic_algorithms(True)),或在论文/基准中记录不可避免的非确定性项。

理论说明:若运算图与数值操作严格按定义域(算子顺序)确定且输入与 PRNG 状态固定,则函数 FFF 的输出是确定的;浮点舍入与并行性可能导致次序相关的舍入偏差,故要记录与控制这些因素来提高可重复性。

14.3.4 容器化(Docker)与可复现镜像的构建模板

关键原则:

-

固定基础镜像

FROM ubuntu@sha256:<digest>。 -

在 Dockerfile 中使用显式包版本安装并清理缓存以减少非确定因素。

-

将代码与依赖写入镜像并再生成环境快照(例如

pip freeze --all > requirements.txt),并把该快照提交至代码库。 -

对于大型数据,避免把数据嵌入镜像,而是提供数据下载脚本并同时提供数据校验(sha256)。在 CI 中可使用小型“烟雾测试”数据子集以节省资源。

示例(精简 Dockerfile):

FROM python:3.10.12@sha256:<digest>

ENV PYTHONUNBUFFERED=1

WORKDIR /app

COPY requirements.txt .

RUN pip install --no-cache-dir -r requirements.txt

COPY . /app

CMD ["python", "train.py", "--config", "configs/default.yaml"]

在 requirements.txt 中使用 package==x.y.z --hash=sha256:... 来锁定二进制包。

14.3.5 CI 测试模板与分层测试策略

测试金字塔(小而快 -> 大而慢):

-

单元测试(Unit tests):测试函数级别正确性(速度极快,运行于每次提交)。

-

集成测试(Integration tests):验证模块间接口(例如数据加载、模型前向输出尺寸)。使用小型模拟数据(fixture)避免长时间训练。

-

回归/性能烟雾测试(Regression/Smoke tests):运行轻量训练或验证流程,确保训练不崩溃并达成最小性能阈值(例如 loss 在前 10 步下降)。

-

端到端(E2E)与长期基准(Nightly):完整训练/评估在专门 runner 上定期执行(如每夜),用于捕获漂移或性能退化。

CI 步骤(示例顺序):

-

checkout repo

-

verify code formatting & lint

-

run unit tests

-

build docker image (using locked digest)

-

run integration tests inside container

-

run smoke training on synthetic data and check loss decreases

-

run model serialization & checksum verification

-

deploy artifacts (image digest, model checkpoint hash) to artifact store

数学/工程保证:分层测试覆盖不同抽象层的错误类型;短测试快速反馈,长测试周期性验证模型性能收敛与数值稳定。将关键产物(镜像 digest、模型 checkpoint sha256)作为反馈闭环,能从根本上保证产物的可追溯性。

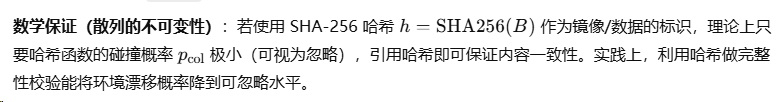

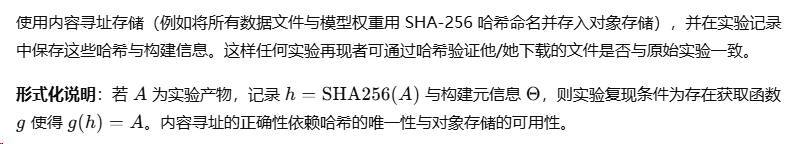

14.3.6 数据与实验产物的内容寻址(Artifact Management)

14.3.7 自动化报告与可审计日志

每次 CI 运行与实验都生成机器可读日志(JSON),包含字段:run_id、commit_hash、image_digest、dataset_hash、config_hash、start_time、end_time、metrics。这些日志用于审计、回滚决策与元分析。

数学好处:通过存储键值对序列,可以用图数据库或数据框计算实验之间的相似度与性能变迁趋势,并利用统计方法(趋势检验、控制图)识别出显著漂移。

本章小结与操作清单

本章给出可直接用于教材的理论与实践规范:

-

数据元数据必须包含:唯一 ID(hash)、采样信息(采样率、时钟)、天线/传感器几何、坐标参考系、前端与 ADC 设置、数据格式、版本与完整性校验。记录这些能保证信号的可恢复性与空间/时间上的一致性。

-

基准设计需遵守不泄露原则、分层/群组抽样、交叉验证与适当的统计检验(配对 t 检验、置换测试、bootstrap)、样本量与功效分析、多重比较校正方法。每一步需记录随机种子与划分算法以实现复现。

-

开源复现流程应包括:依赖与环境锁定(包与镜像 digest)、确定性构建与随机性控制(PRNG、并行可重复性)、容器化 Dockerfile 模板、CI 分层测试(单元 -> 集成 -> 烟雾 -> E2E)、内容寻址存储与实验日志。通过哈希校验与镜像 digest 可将复现风险降到可忽略水平。

本章提供了从理论证明到工程落地的完整链条,使读者既能理解为何要采集与记录特定元数据、如何设计统计上严谨的基准实验,也能掌握工程上保证可复现性的关键技术与流程。若需要,我可以把其中任一子节扩展为可执行的代码示例(如 JSON Schema、CI YAML 模板、Dockerfile 完整范例)并给出对应的最佳实践检查清单。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?