DeepSeek是最近很火的一款AI大模型,可以用多种工具进行部署。本次我们用Ollama软件进行在线和离线两种部署方式部署,图文详细教程如下。

Ollama软件安装

下载软件

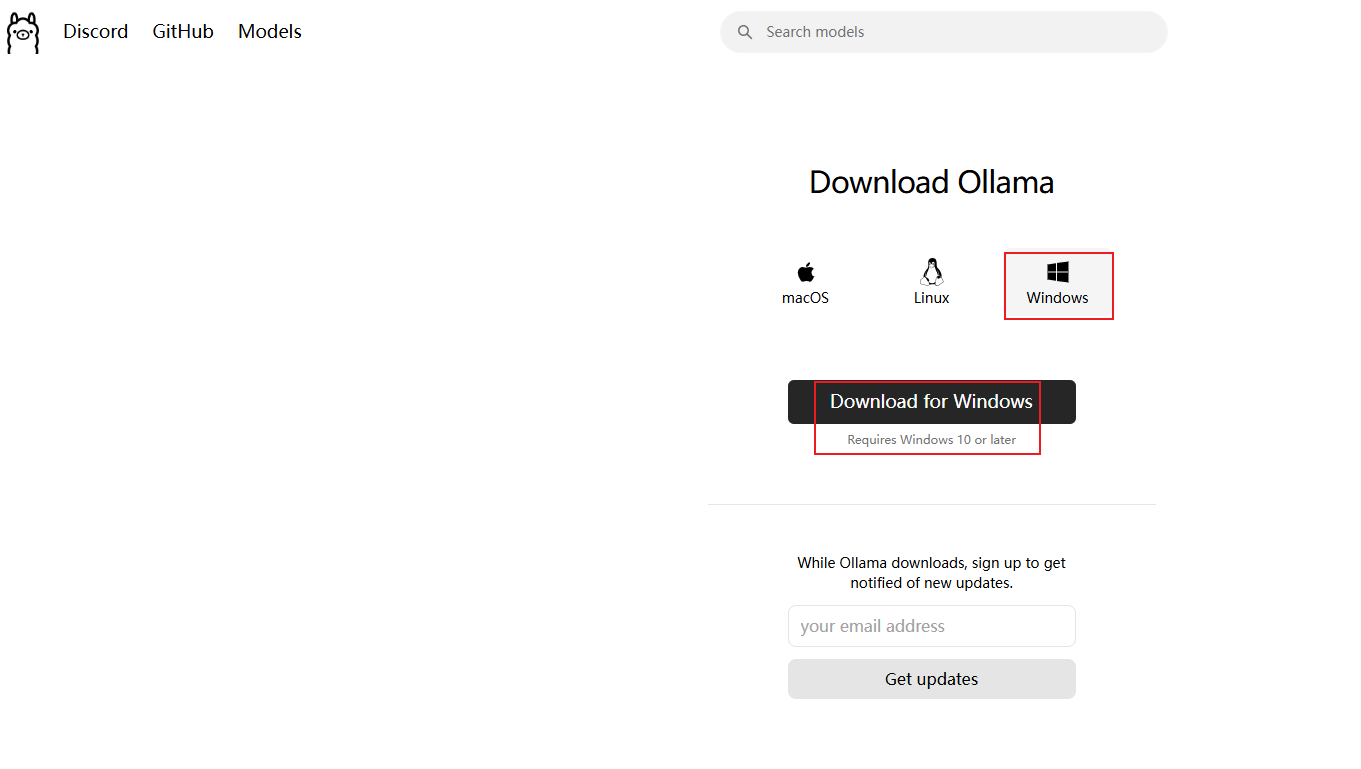

首先我们需要下载ollama软件,可以访问官网Download Ollama on Windows

我这里选择windows版本进行下载

如果这里下载较慢,也可以从这里下载:windows版本Ollama0.5.7资源-优快云文库

图下就是已经下载好的Ollama软件安装程序,是个羊驼的图标

安装软件

由于Ollama默认安装到C盘,且无法选择安装路径,这里教大家一种可以将Ollama安装在D盘的方法

首先在D盘新建一个文件夹,我这里命名为Ollama,然后把Ollama软件安装包也放在D盘下

在导航栏输入cmd回车,打开命令行工具

然后在命令行输入 OllamaSetup.exe /DIR=要安装的路径 然后回车

就可以看到图下所示界面,点击Install

可以看到Ollama软件正在 D:\Ollama 路径下安装,稍等一会

待命令行执行完毕,且右下角任务栏出现Ollama的羊驼图标,说明Ollama已经安装完成,正在运行中

验证

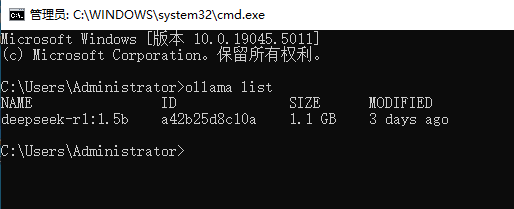

在命令行输入命令ollama list,出现图下所示界面,说明Ollama可以正常使用

更改大模型下载位置

由于Ollama默认是把模型下载在C盘,这样对于系统的使用非常不便。所以这里提供了一个将模型更改下载位置的办法

首先在D盘新建一个文件夹用来存放模型

然后搜索环境变量,点击编辑系统环境变量

点击环境变量

如图下所示,点击新建

然后按照图下所示填写。变量名是OLLAMA_MODELS,变量值是刚才新建的文件夹路径,点击确定

然后再依次点击对话框的确定

更改完环境变量,为确保生效,建议重启计算机。

在线部署方式

进入Ollama官网Ollama,点击DeepSeek-R1

按照图下所示,我这里选择最小的蒸馏版本1.5b模型进行安装,复制安装命令 ollama run deepseek-r1:1.5b

然后粘贴在cmd命令行回车运行即可,等待其下载完成

离线部署方式

如果觉得在线安装deepseek-r1模型太慢,或者无法联网的话,可以采用离线部署的方式

可以拷贝其他人部署好的模型到自己的电脑中,模型文件包含 blobs 和 manifests 两个文件夹

我这里上传了一份链接: https://pan.baidu.com/s/1tIgTJXyCtlQd1TX1wP3tJA 提取码: cv64

其中 blobs 文件夹包含的文件如下

其中 manifests 文件夹下包含了多层子文件夹,如下所示

将 blobs 和 manifests 文件夹放到你创建的模型文件夹 OllamaModels 下

此时在命令行输入命令 ollama list,可以看到deepseek-r1:1.5b直接就在里面了

然后执行命令 ollama run deepseek-r1:1.5b 即可成功调出deepseek的对话框

561

561

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?