最近在Jetson Orin Nano Super部署模型,遇到很多问题,网上很多参考资料不能解决,尤其是Jetpack6.2版本中,几乎没有资料。

第一个问题:

Pytorch版本问题

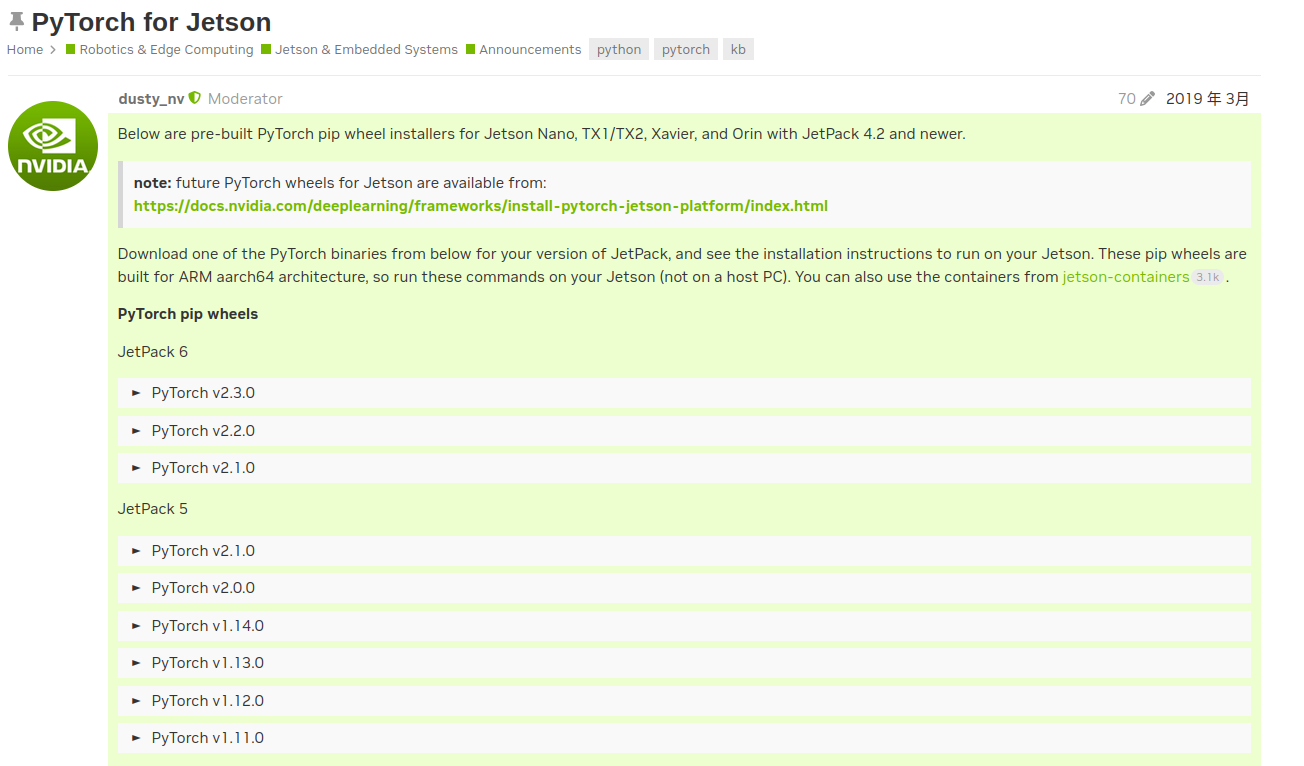

Pytorch for Jetson 网页有不同Jetpack版本对应的Pytoch,如下所示:

在Jetpack6.2 中无论安装2.3、2.2、2.1都会报错:

ImportError: libcudnn.so.8: cannot open shared object file: No such file or.......

如果安装Pytorch2.5会报错缺少libcusparseLT.so*文件,发现在

订阅专栏 解锁全文

订阅专栏 解锁全文

2106

2106

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?