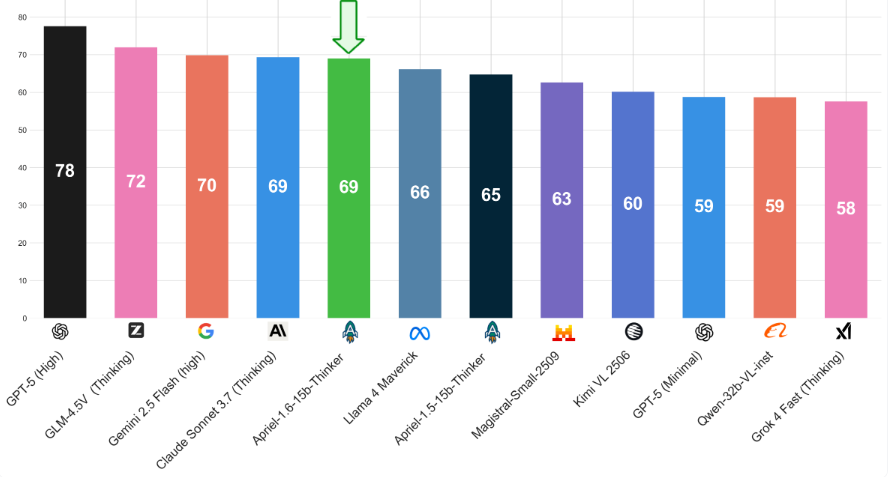

Apriel-1.6-15b-Thinker以150亿参数的轻量级体量,在多模态推理能力上击败了体量大其十倍的对手,并将推理Token的消耗量降低了30%以上,精准卡位企业级应用的高效甜蜜点。

ServiceNow人工智能团队最新发布的Apriel-1.6-15b-Thinker,作为Apriel SLM(小型语言模型)系列的最新力作,在文本与视觉推理的深度上实现了质的飞跃。

这款模型在NVIDIA DGX Cloud(英伟达DGX云)平台上,依托GB200训练而成。

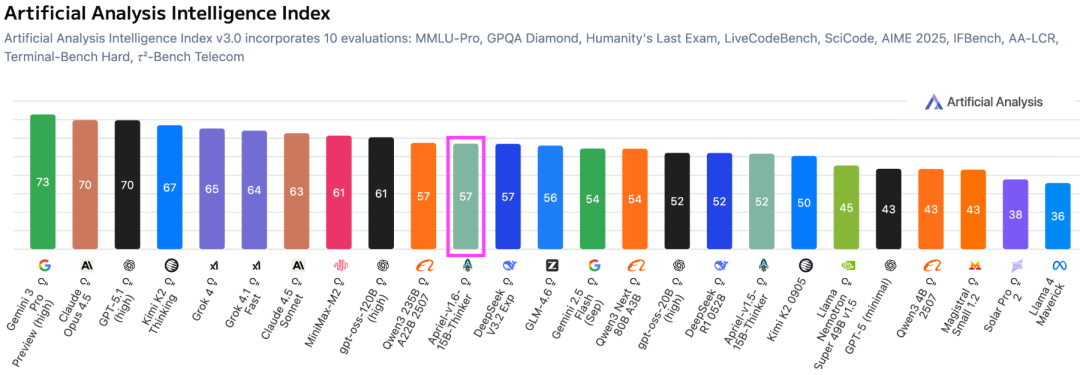

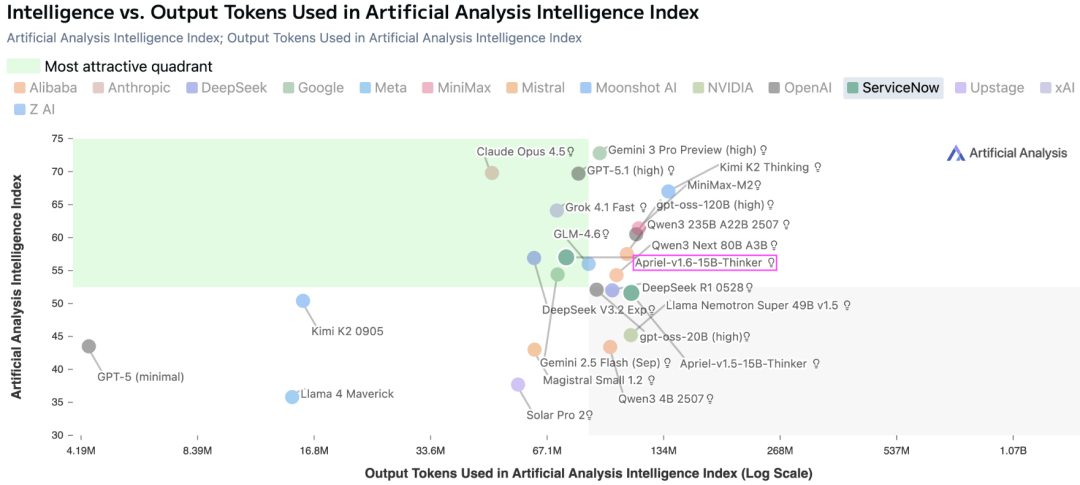

它在Artificial Analysis Index(人工智能分析指数)中获得了57分的高分,这一成绩不仅超越了Gemini 2.5 Flash、Claude Haiku 4.5以及GPT OSS 20b等知名模型,更在保持极高能效比的同时,达到了与Qwen3 235B A22B相当的水准。

Apriel-1.6显著优化了计算成本,为资源受限但追求极致性能的企业环境提供了绝佳选择。

精准的数据配方与训练策略

训练大模型并非单纯的算力堆砌,而是一场关于数据筛选与策略调优的精密工程。

Apriel-1.6沿用了前代产品行之有效的整体训练流程,即深度上采样阶段配合两个持续预训练阶段。

在深度上采样阶段,团队构建了一个高度多元化的语料库:35%的数据来自高质量网页内容、科学技术文献、数学题集及程序代码;15%源自NVIDIA Nemotron的高质量合成数据集;剩余50%则采用预训练风格的数据进行回放,以巩固模型的基础知识。

进入第一阶段持续预训练,团队针对Apriel-1.6的特性,扩展了数据混合配方。

为了强化文本推理与图像理解能力,新配方中加入了全合成的文本样本与图文对。

这些合成文本覆盖了通用推理、知识问答、代码编写及创意写作等领域;多模态数据则涵盖了文档与图表理解、OCR(光学字符识别)、视觉推理任务以及SVG/Web代码合成。

这种全方位的数据覆盖,确保了模型在面对复杂任务时不仅能看懂,更能理解。

随后进行的纯文本持续预训练将序列长度扩展至49K,紧接着的第二阶段则专注于打磨模型的视觉推理能力。

这套中期训练流程仅在NVIDIA GB200s上消耗了约10,000个GPU时。

中期训练赋予了模型坚实的底座,随后的监督微调则赋予了它解决问题的逻辑。

ServiceNow-AI构建了一个包含240万个高信号文本样本的精选数据集。

与传统数据集不同,这里的每一个样本都包含了显式的、分步骤的推理轨迹。

为了打造这个高质量数据集,团队结合了可执行验证的合成样本,涵盖数学、编程及科学问题解决,同时融入了指令遵循、对话交互、API/函数调用、创意写作及安全知识等多种样本。

数据质量被视为最高优先级:所有样本均经过多级去重、内容过滤、启发式质量修剪、LLM-as-Judge(大模型作为裁判)验证以及基于执行的验证,并严格剔除了评估基准中的污染数据。

监督微调分为两个阶段,均在32K上下文长度下进行。

第一阶段是对240万个样本进行4个周期的纯文本大规模训练。

团队简化了聊天模板,移除了冗余标签,并引入了四个特殊Token(令牌):<tool_calls>、</tool_calls>、[BEGIN FINAL RESPONSE]、<|end|>,极大提升了输出解析的便捷性。

第二阶段则是一个轻量级的多模态运行,训练时长为3个周期,利用从前代模型中拒绝采样的数据,确保模型在引入新Token后仍能保持强大的图像处理能力,为后续的强化学习打下基础。

Apriel-1.6的强化学习环节采用多阶段设置,旨在同步提升推理能力与运行效率。

训练数据覆盖了视觉推理、通用视觉问答、OCR等图像领域,以及简单问答、数学数值推理、STEM(科学、技术、工程、数学)多选题及结构化工具使用等跨域数据。

奖励机制的设计充满了巧思:模型不仅因为回答正确而获得奖励,还会因为冗长、格式错误等不良行为受到惩罚。

这套机制鼓励模型在面对简单问题时直截了当,避免不必要的中间步骤;在确信时尽早停止,从而大幅减少推理Token的消耗。

训练过程采用了GSPO(群组序列策略优化)损失函数,依托VeRL(验证强化学习)框架及基于规则的验证进行。

Apriel-1.6在保持甚至提升推理深度的同时,成功将推理Token的使用量减少了30%以上。

多维度的性能实测

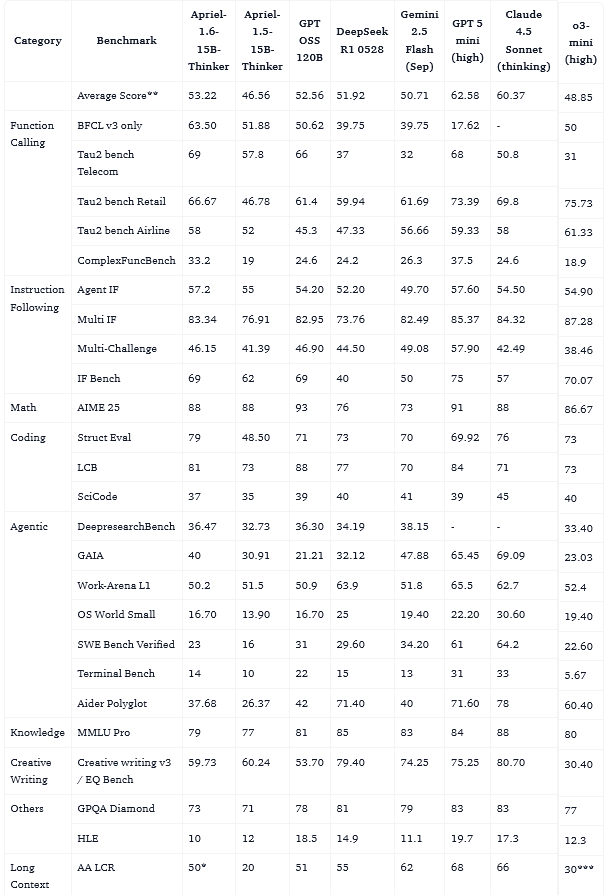

在文本评估方面,Apriel-1.6在工具使用、数学、编程、指令遵循及长上下文等多个领域展现了卓越性能。

各项基准测试数据显示,它在多个维度上不仅超越了同等体量的对手,甚至在部分指标上优于参数量更大的模型。

在图像评估方面,Apriel-1.6同样表现不俗。

通过VLMEvalkit工具,在数学推理、视觉问答、逻辑推理及图表分析等关键领域进行了测试。

结果显示,它在包含MathVision、MathVista、MMMU等13个基准的Image Index(图像指数)平均分上,比前代提高了4分。

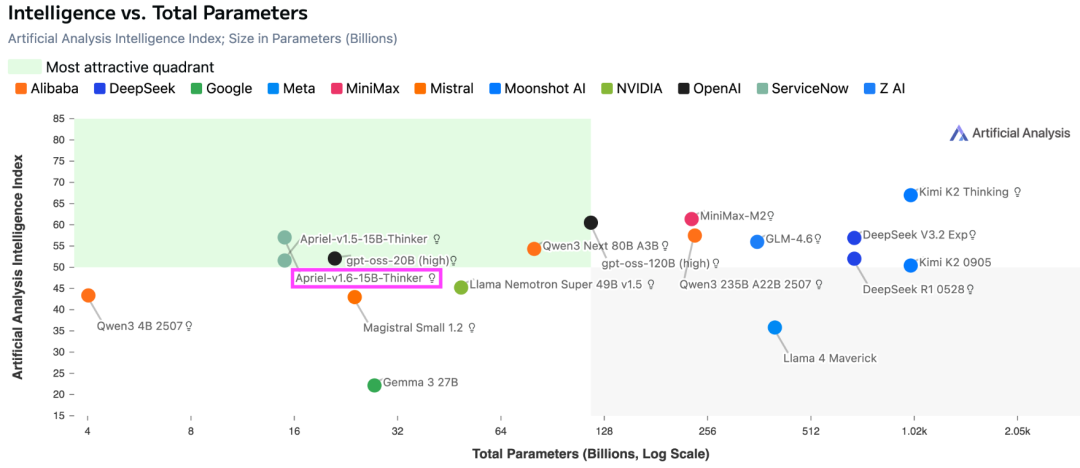

Apriel-1.6-15B-Thinker不仅是一个高性能的推理者,更是一个成本效益的典范。

在智力与参数量的对比图表中,它位于最吸引人的象限:以150亿参数提供了媲美巨型模型的智力分数。

作为资源相对有限的实验室,ServiceNow-AI坦诚地指出了模型的局限性。

1,虽然它在推理效率上表现出色,但面对复杂或低质量的图像,OCR的准确率可能会下降;

2,在人群或相似物体密集的场景中,细节捕捉和计数能力面临挑战;

3,对于高度详细或格式异常的图表,解释可能不够完美;

4,在细粒度的视觉定位上,边界框预测有时也可能不够精确。

Apriel-1.6用有效的数据策略和训练方法,让小规模计算也能诞生SOTA级别的模型,用更少的资源做更聪明的事,这正是AI进化的方向。

参考资料:

https://huggingface.co/blog/ServiceNow-AI/apriel-1p6-15b-thinker

https://huggingface.co/ServiceNow-AI/Apriel-1.6-15b-Thinker

END

163

163

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?