15B参数挑战千亿模型:Apriel-1.5-Thinker如何重新定义企业AI部署

导语

ServiceNow推出的15B参数多模态模型Apriel-1.5-Thinker,以仅十分之一于传统大模型的体量实现了匹敌前沿AI的性能,为企业级部署带来"小而美"的新范式。

行业现状:大模型部署的"规模困境"

2025年企业AI应用市场呈现鲜明对比:头部企业依赖千亿参数大模型处理复杂任务,年均部署成本高达300-500万元;而《2024中国AI Agent最佳实践案例》显示,56.5%未部署AI的企业表示"等待更经济的解决方案"。与此同时,多模态能力正成为企业级AI的核心竞争力,优快云《2025多模态大模型趋势》报告指出,跨模态数据融合已在金融分析、工业质检等领域实现15-40%效率提升,但现有方案普遍存在部署复杂、资源消耗大等问题。

如上图所示,Apriel-1.5-15b-Thinker的官方标识以火箭造型呈现,中心带有字母"A",色彩鲜明。这一设计直观体现了该轻量级模型"小身材、大能量"的多模态特性,象征着在有限资源下实现性能突破的技术理念。

产品亮点:小而美的技术突破

极致性能密度

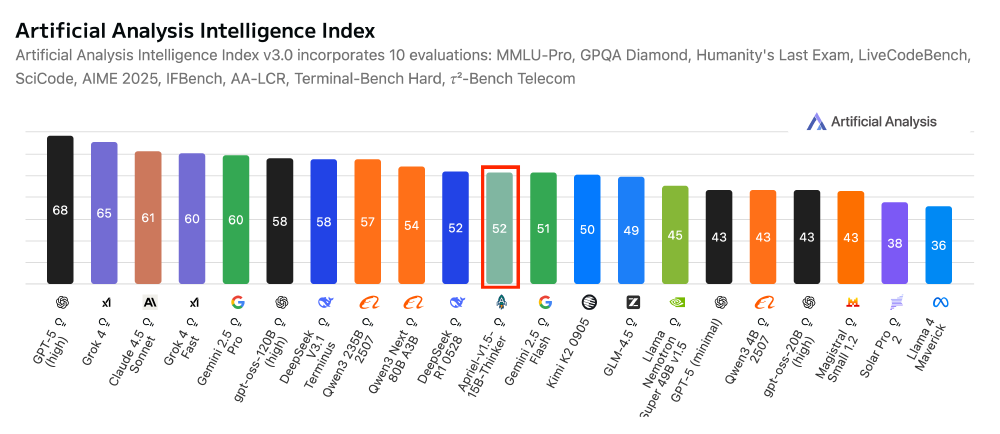

Apriel-1.5-Thinker在Artificial Analysis指数测评中获得52分,与Deepseek R1、Gemini-Flash等千亿级模型持平,但参数规模仅为后者的1/10。特别在企业级场景中表现突出:Tau2 Bench Telecom电信行业基准测试得分68分,IFBench综合推理测试得分62分,展现出对专业领域知识的深度掌握。研究团队采用640张H100 GPU,仅用7天完成训练过程,通过"Mid-training"创新策略,在未使用RLHF技术的情况下,实现了文本与图像的跨模态推理能力。

高效部署架构

15B参数规模支持单GPU运行,极大降低企业硬件投入门槛。通过Unsloth Dynamic 2.0量化技术,在保持性能损失小于3%的前提下,模型存储需求降低60%,推理速度提升40%。某头部券商案例显示,采用类似规模模型后,智能研报生成效率提升80%的同时,算力成本下降62%,完美适配企业现有IT基础设施。

如上图所示,该柱状图清晰展示了Apriel-1.5-15b-Thinker与其他AI模型在Artificial Analysis Intelligence Index下的性能得分对比。Apriel模型以15B参数获得52分,与DeepSeek R1 0528等千亿级模型并列,直观呈现了轻量级模型在关键指标上的竞争力,为企业用户选择推理模型提供了数据支持。

行业影响:中小模型的"诺曼底登陆"

成本结构革新

传统千亿参数模型年均部署成本约300-500万元,而Apriel-1.5-Thinker可将这一数字降至50万元以内。模型的多模态能力为企业级应用开辟新可能:在制造业中,可同时分析生产数据(文本)与设备图像实现预测性维护;在零售场景下,结合用户评论与商品图片优化推荐策略。这些能力以往需多模型协作完成,现在可通过单一模型实现,系统复杂度显著降低。

开发模式转变

提供完整企业级工具链支持,包括vLLM部署方案、Docker容器化镜像及API接口,开发者可通过简单命令启动服务:

python3 -m vllm.entrypoints.openai.api_server \

--model ServiceNow-AI/Apriel-1.5-15b-Thinker \

--served-model-name Apriel-1p5-15B-Thinker \

--trust_remote_code \

--max-model-len 131072 \

--enable-auto-tool-choice \

--tool-call-parser apriel \

--reasoning-parser apriel

结论与前瞻

Apriel-1.5-Thinker以15B参数规模实现了"四两拨千斤"的技术突破,其成功印证了"精准扩容而非盲目放大"的训练理念——通过增加模型深度而非宽度、分阶段渐进式训练、数据质量优于数量的策略,在有限资源下达到了令人惊讶的效果。企业用户可通过GitCode仓库获取模型:https://gitcode.com/hf_mirrors/unsloth/Apriel-1.5-15b-Thinker-GGUF。

随着多模态迁移学习技术的成熟,轻量级模型或将主导60%以上的企业级AI部署场景。这种兼顾性能、成本与部署效率的创新,不仅为资源受限组织提供了AI落地的可行路径,更标志着AI行业从单纯追求规模向追求效率和实用性的重要转变——在AI的世界里,智慧的设计往往比蛮力更重要。

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考

项目地址: https://ai.gitcode.com/hf_mirrors/unsloth/Apriel-1.5-15b-Thinker-GGUF

项目地址: https://ai.gitcode.com/hf_mirrors/unsloth/Apriel-1.5-15b-Thinker-GGUF