刚刚,阿里千问团队把两个更轻量级的Qwen3-VL模型开源了。

强大的视觉大模型,现在可以跑在你的个人设备上了。

9月23日,Qwen团队发布了Qwen3-VL系列,这是一个多模态视觉语言模型家族。当时发布的主要是基于MoE(混合专家)架构的大家伙,总参数高达2350亿的Qwen3-VL-235B-A22B。这种规模的模型,性能是顶级的,但门槛也高,想跑起来至少得备上8张A100或H100这样的高端计算卡。

一个月没到,团队放出了两个Dense(密集)架构的小兄弟:Qwen3-VL-4B和Qwen3-VL-8B。

现在,这个家族里既有需要庞大算力集群支撑的云端巨无霸,也有能在单张消费级显卡上运行,甚至可以在边缘设备上部署的轻量级选手。

Qwen3-VL的技术细节

Qwen3-VL系列的目标不只是让模型能“看见”图片和视频,而是要它能真正看懂,理解事件,甚至做出行动。为了实现这个从“感知”到“认知”的跨越,团队在底层架构上做了三件关键升级。

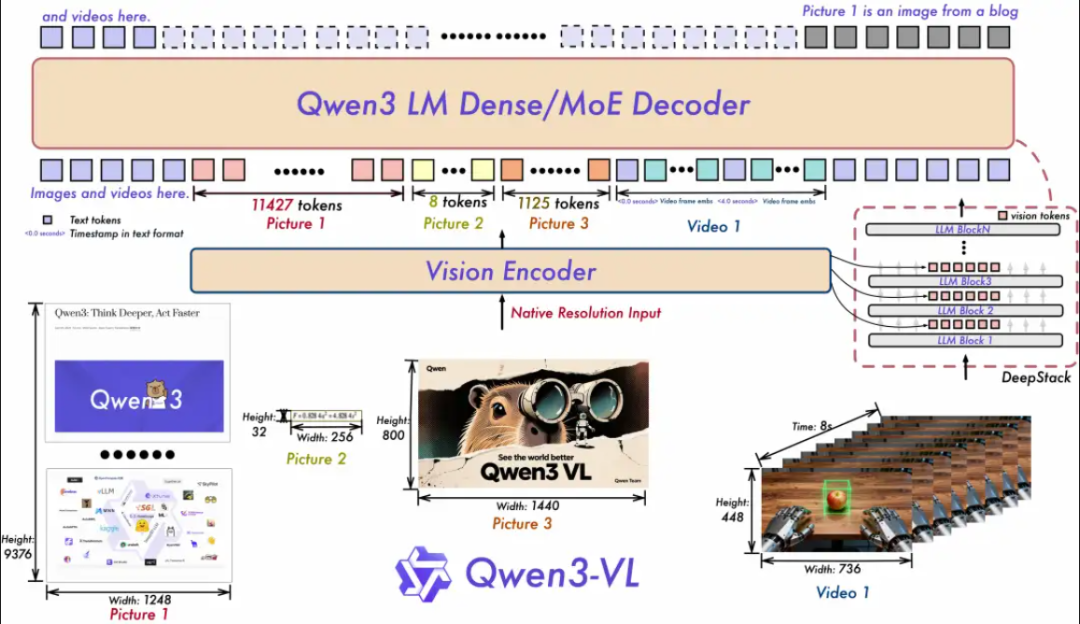

第一个叫交错MRoPE(多维旋转位置编码)。

之前的位置编码方式,是把时间(t)、高度(h)和宽度(w)三个维度的信息分成一块一块的,时间信息全挤在高频区。这样处理图片还行,一遇到长视频就容易出问题,模型对时间流逝的感知会变得迟钝。Qwen3-VL改成了交错分布,把t、h、w的信息像编辫子一样均匀地编织在一起,覆盖所有频率。这么一改,模型看图片的能力没下降,理解长视频的本事却实打实地提升了。

第二个叫DeepStack(深度堆栈)技术。

过去的多模态大模型,通常是在语言模型的最底层输入一次视觉特征就完事了。这好比你看一张画,只看个整体轮廓,不关心笔触和细节。DeepStack技术的思路是,不能这么草率。它把ViT(视觉变换器)在不同层次提取到的视觉特征都拿过来用。从低层次的轮廓、颜色,到高层次的物体、场景,这些丰富的视觉信息被分别“token化”,然后在语言模型的不同深度层面注入进去。这样做的好处是,模型对图像的理解变得极其精细,图文对齐的精度也高了。

第三个是文本时间戳对齐机制。

这个技术是专门为视频理解升级的。它用一种“时间戳-视频帧”交错输入的形式,把精确到帧的时间信息和那一帧的视觉内容死死地绑在一起。模型输出时间的时候,原生就支持“秒”或者“时:分:秒”这两种格式。这让Qwen3-VL在处理复杂的视频任务时特别准。比如,你要它找出视频里某个动作开始和结束的精确时间点,或者回答某个特定时刻发生了什么,它都能稳稳地定位到,响应非常精准。

从云端巨兽到桌面精灵,总有一款适合你

Qwen3-VL现在是一个完整的家族,成员高矮胖瘦各不相同,以适应不同的工作环境和需求。每个参数级别有Instruct、Thinking两个版本,我们下面以Instruct版本为例。

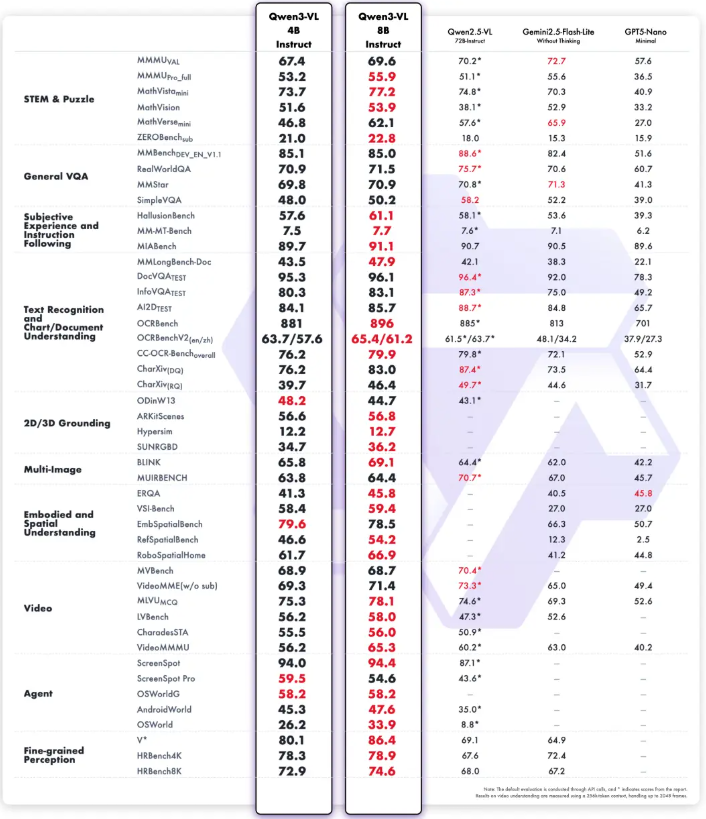

两个轻量级选手,Qwen3-VL-4B和Qwen3-VL-8B。它们是Dense架构,参数分别是4亿和8亿。别看它们小,Qwen3-VL的核心能力一个都没落下。官方评测里,8B模型的表现全面领先Gemini 2.5 Flash Lite和GPT-5 Nano。

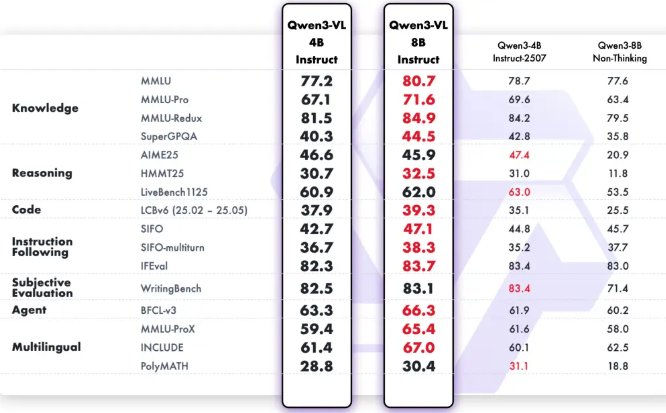

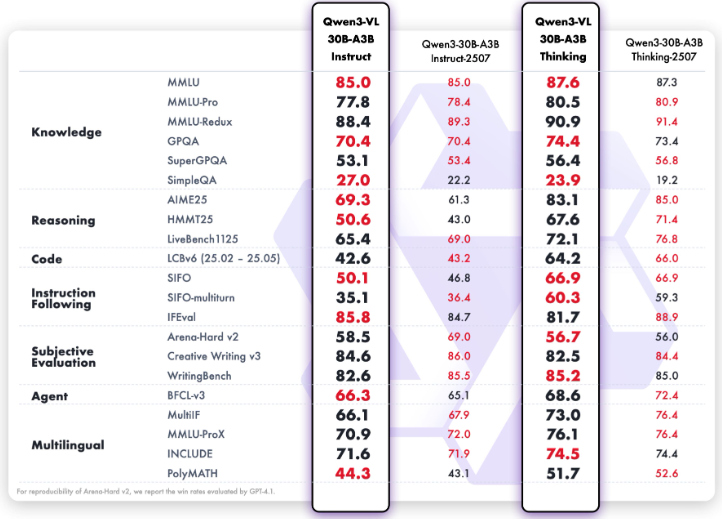

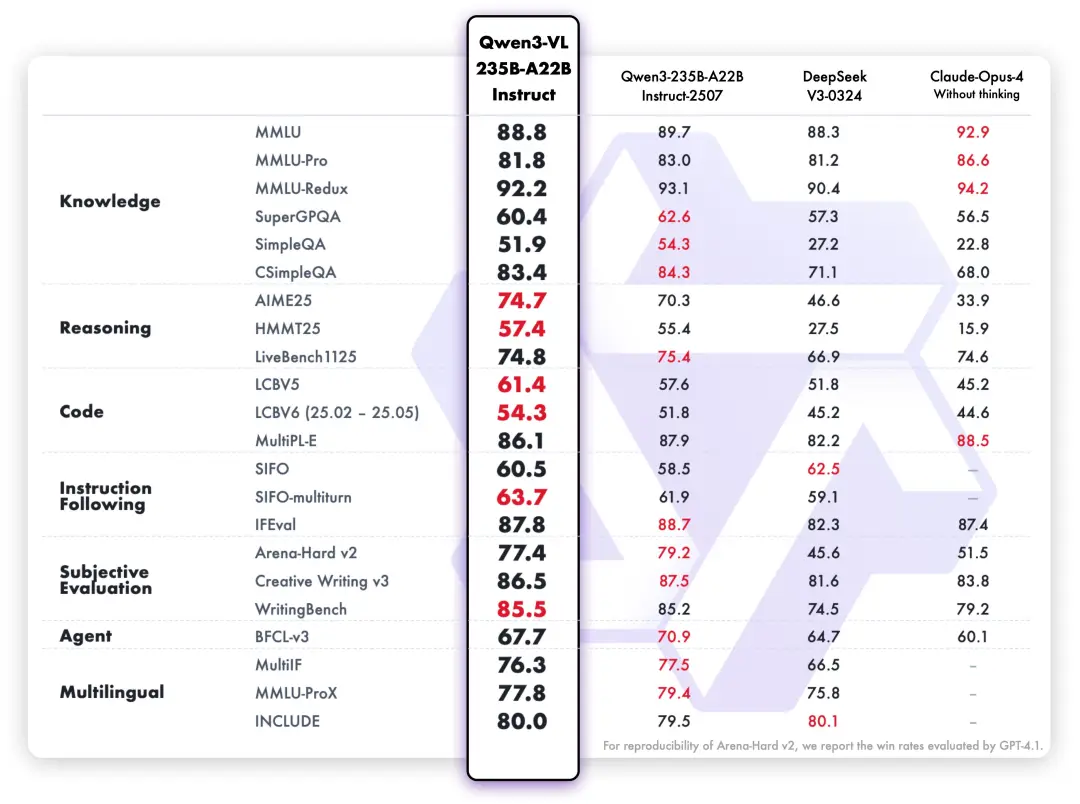

纯文本能力没有因为多模态而打折扣,多项基准反而领先。

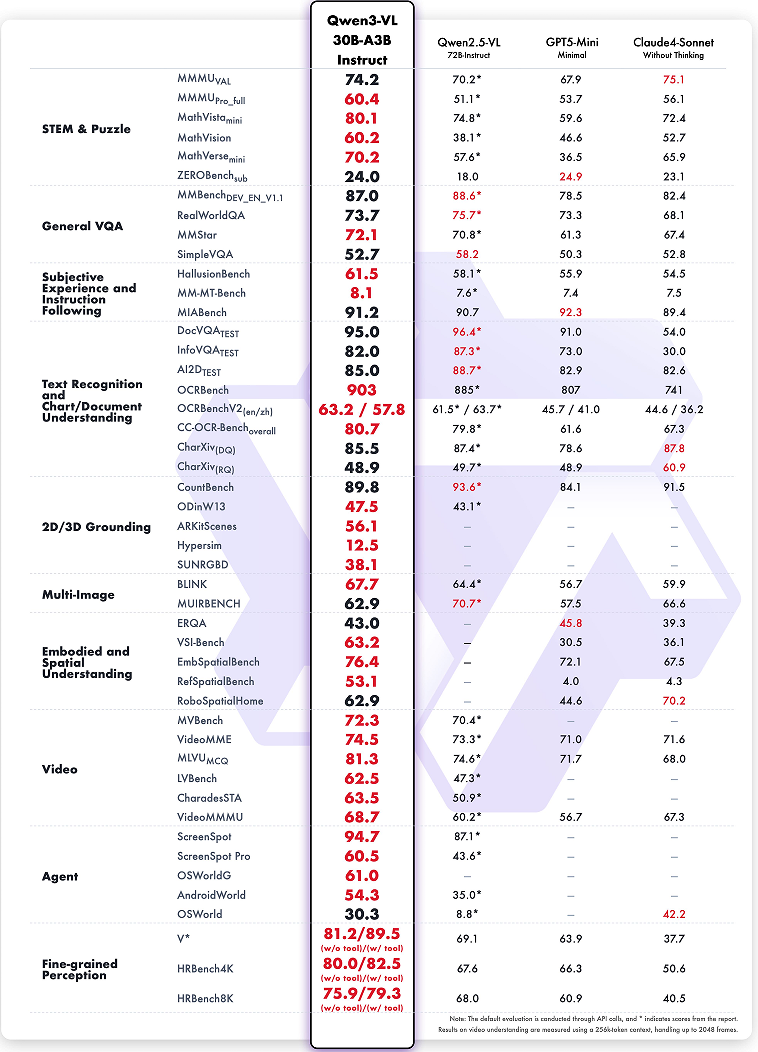

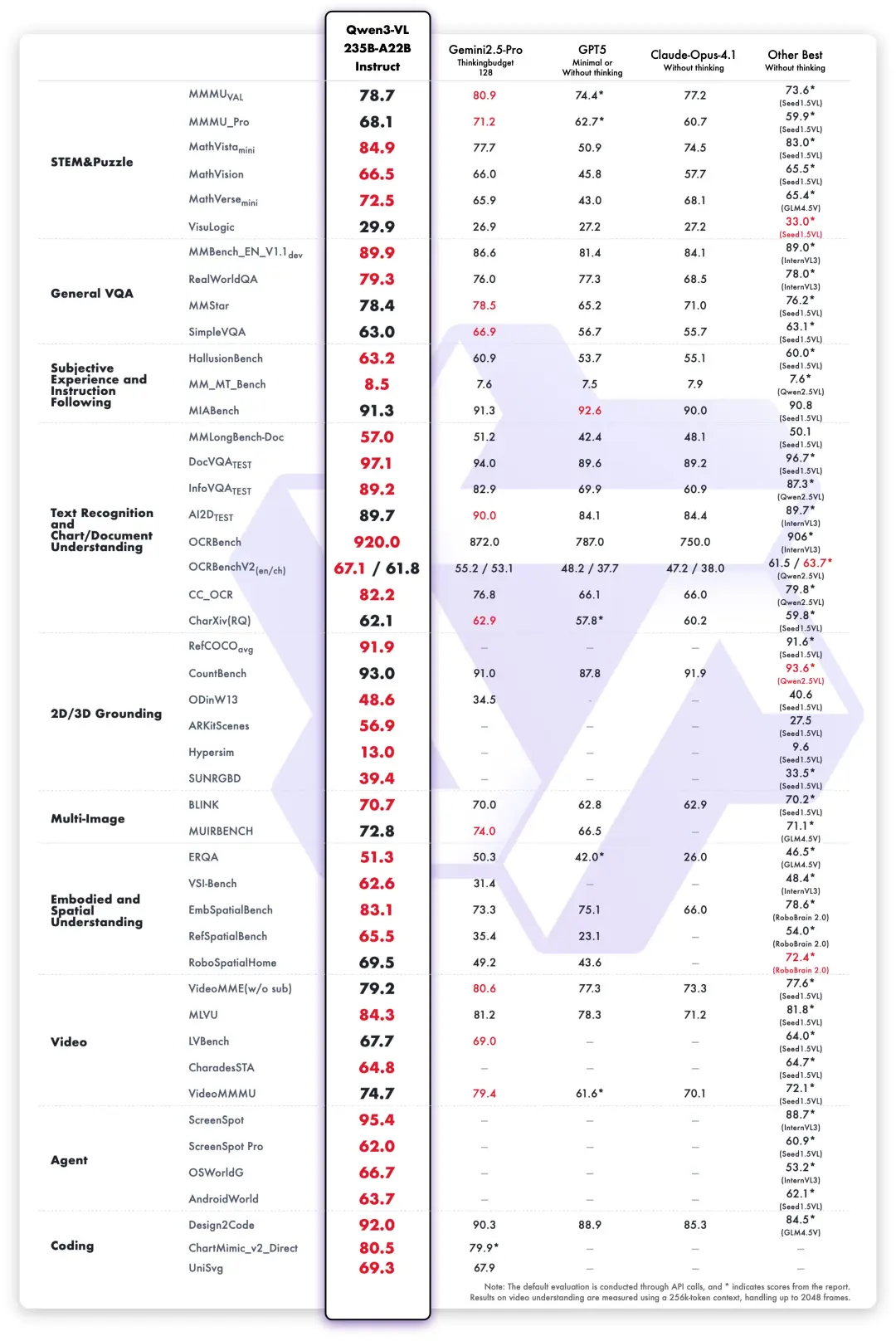

之前发布的两个MoE架构大家伙,Qwen3-VL-30B-A3B和Qwen3-VL-235B-A22B。在非推理类模型中多数指标表现最优,显著超越了 Gemini 2.5 Pro 和 GPT-5 等闭源模型,同时刷新了开源多模态模型的最佳成绩。

纯文本能力同样强。

所有这些模型,无论大小,都原生支持256K token的上下文长度,还能扩展到100万token。几百页的技术文档、一本厚厚的教材,或者一部电影,都可以一次性喂给模型,它能全部记住,并且能精准地检索到任何一个细节。

它不止能看,还能思考和动手

Qwen3-VL的能力提升是全方位的,它不只是个读图工具,越来越像一个有认知能力的智能体。

它可以操作你的电脑和手机。在OS World这类操作系统任务的评测基准上,它的水平是世界顶级的。它能识别界面上的图标和按钮,理解它们的功能,然后调用工具去完成你交代的任务。这种视觉智能体(Visual Agent)的能力,让它有潜力成为真正的个人助理。

它的纯文本能力没有因为多模态而打折扣。Qwen3-VL在预训练早期就把文本和视觉数据混合训练,最终它的文本能力和纯文本旗舰模型Qwen3-235B-A22B-2507不相上下。这是一个既能看懂万物,又能写出锦绣文章的全能选手。

它还能“看图写代码”。你给它一张设计图,它能直接生成Draw.io的流程图代码,或者HTML、CSS、JS的网页代码,实现“所见即所得”的视觉编程。

它的空间感也变强了。它现在能理解物体的相对位置、视角变化和遮挡关系,甚至能做3D定位。这对机器人导航、增强现实这些需要与物理世界交互的应用场景非常重要。

另外,它认东西的范围更广了。从名人、动漫角色,到商品、地标,再到各种动植物,几乎是“万物识别”。它的OCR(光学字符识别)能力也更强,支持的语言从10种扩展到32种,就算图片里的光线不好、文字模糊倾斜,或者遇到生僻字、古籍字,识别准确率都很高。

Instruct版本注重指令遵循,你说什么它做什么。Thinking版本则重点优化了在数理科学(STEM)和数学领域的推理能力,面对专业问题,它能一步步分析因果,给出有逻辑的解答。在MathVision、MMMU、MathVista这些权威评测中,Thinking模型的表现都是顶尖水平,甚至在一些复杂的多模态数学题上超过了Gemini 2.5 Pro。

对于普通开发者和研究者来说,如果想自己部署和微调,尤其是新发布的4B和8B模型,门槛并不高。

使用魔搭社区官方的ms-swift框架,就可以在自己的数据集上进行微调。这个框架支持各种主流硬件,包括消费级的RTX系列显卡,也支持LoRA、QLoRA等各种轻量级微调方法。

根据官方数据,微调一个8B的Dense模型,大约需要20GB的显存,这在很多个人开发者的能力范围之内。

而且官方还提供了每个参数级别的FP8量化版,4B参数,笔记本都能跑的飞起。

参考资料:

https://github.com/QwenLM/Qwen3-VL

https://modelscope.cn/collections/Qwen3-VL-5c7a94c8cb144b

https://huggingface.co/collections/Qwen/qwen3-vl-68d2a7c1b8a8afce4ebd2dbe

https://qwen.ai

END

1782

1782

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?