谷歌发布了XR Blocks开源框架,为AI+XR的创新加速。

2021年被称为“元宇宙元年”,这一年,Roblox成功上市,Facebook改名为“Meta”,扎克伯格赌上全部身家宣称要打造“未来的社交平台”。

字节跳动90亿收购Pico,微软、腾讯纷纷组建团队,虚拟地产被炒到天价,相关产业市值一度飙升至万亿。

据速途元宇宙研究院数据,高达99.9%的“元宇宙”商标都是在2021年之后进行注册申请的,仅2021年6月至2022年1月,元宇宙商标的申请数量就多达9965个。

然而,2022年下半年起,元宇宙和XR的热度开始逐渐消退。

2022年,Meta的元宇宙业务亏损超130亿美元,其HorizonWorlds因画面粗糙、交互单一被吐槽,Quest头显的销量未达预期。

2023年,“元宇宙第一股”Robolox股价跌超70%,Meta不间断裁掉近两万人,微软将裁员重点集中在虚拟现实相关部门,解散工业元宇宙团队、停止生产HoloLens2头戴设备并完全退出HoloLens硬件业务,谷歌也解散了AR眼镜研发产品团队。

国内方面,腾讯几乎解散了XR团队,快手元宇宙负责人马英武离职、全景视频业务暂停。

现在的元宇宙工具链七零八落,生态系统四分五裂。

XR Blocks的出现,利用AI,为XR带来了新的希望。

它由谷歌的两位大牛,Ruofei Du和Benjamin Hersh带队开发,并在计算机领域的顶级会议ACM UIST 2025上首次亮相。

谷歌就是想提供一套统一的、简洁的工具,让开发者不用再关心那些烦人的底层“管道”工作,把精力全部集中在创造真正牛掰的用户体验上。

XR Blocks框架解读

XR Blocks遵循大道至简的设计哲学。

它有三个核心原则。

拥抱简洁和可读性。代码写出来得像一首诗,而不是一本天书。简单的任务就要简单地实现,复杂的逻辑也要清晰明了。

创作者体验至上。一切为了让创作者爽,让他们能专注于用户体验,而不是去跟传感器、AI模型集成、跨平台兼容这些破事儿死磕。

实用主义。AI和XR领域发展变化太快,搞一个大而全的完美框架,等发布的时候可能已经过时了。所以他们选择了一个简单、模块化、适应性强的架构,先跑起来再说。

为了实现这个目标,XR Blocks的架构被分成了两部分:Reality Model(现实模型)和Core Engine(核心引擎)。

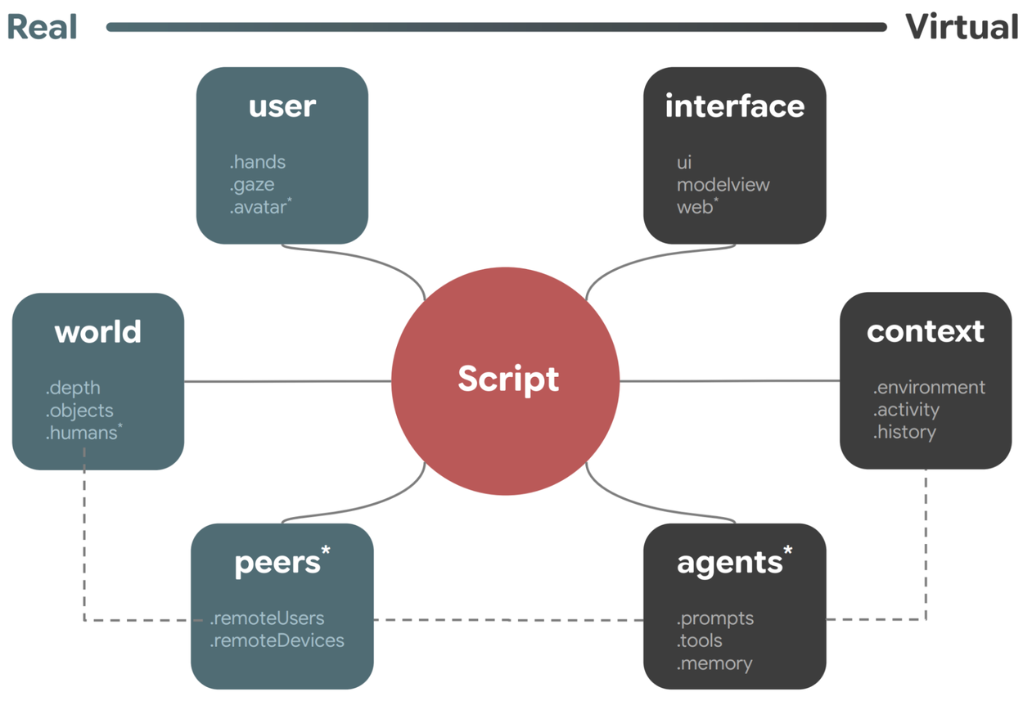

Reality Model是个高级的抽象概念。它把一个XR应用里所有可能涉及的元素都归纳成了几个基本模块。最核心的是一个叫Script(脚本)的东西,它就是你整个应用的故事大纲和逻辑中心。这个脚本操作着六个“基本粒子”:

-

用户:包括你的手、你的眼神、你的虚拟化身。

-

物理世界:就是你周围的真实环境,比如空间的深度信息、光照情况、有什么物体等等。

-

虚拟界面:你在XR世界里看到的各种UI元素,从简单的2D面板到复杂的3D模型。

-

上下文:系统会分析你当前的环境、正在做什么、过去的交互历史,来理解你当下的情境。

-

智能:AI驱动的各种代理,可以跟你对话,为你服务。

-

社会实体:跟你一起在XR世界里的其他真人伙伴。

你看,有了这个模型,开发者思考问题的方式就变了。他不再是想“我需要调用哪个摄像头API来获取数据”,而是想“当用户看到一个物体时,我希望AI代理能为这个物体写一首诗”。这种从“如何实现”到“想要什么”的转变,就是XR Blocks的精髓。

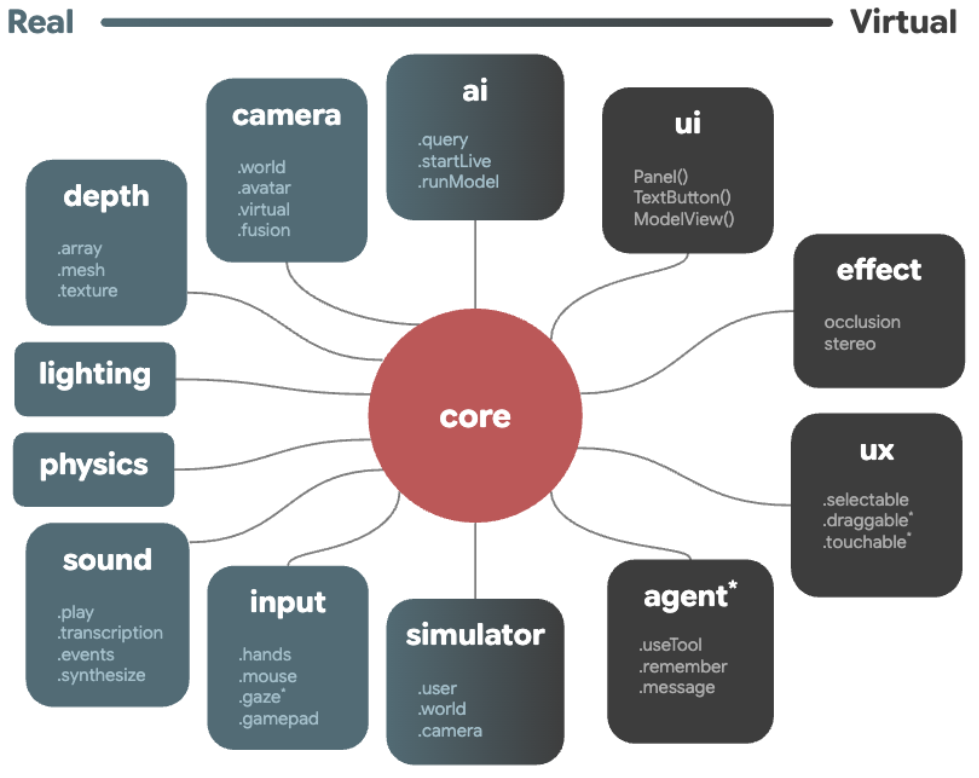

而Core Engine(核心引擎)就是把上面那个玄乎的Reality Model变成现实的苦力。它是个模块化的引擎,把所有脏活累活都打包好了,通过简单的API提供给开发者。

这个引擎里有几个关键的子系统:

-

感知和输入管道:摄像头、深度传感器、麦克风这些硬件会持续不断地把真实世界的数据喂给Reality Model,让它知道外面发生了什么。同时,它会把来自不同设备的用户操作,比如手柄按键、手势操作,都标准化。

-

AI作为核心工具:这里面有个叫ai的模块,像个中央处理器。它提供了非常简单的函数,比如

.query(查询)和.runModel(运行模型),让调用强大的AI大模型变得像喝水一样简单。 -

体验和可视化工具包:为了让开发者能快速出活,它还提供了一个现成的工具库。比如ux模块里有

.selectable(可选中)和.draggable(可拖拽)这种常用的交互行为。ui和effect模块则负责界面的渲染和一些复杂的视觉效果,比如虚拟物体被真实物体遮挡的效果。

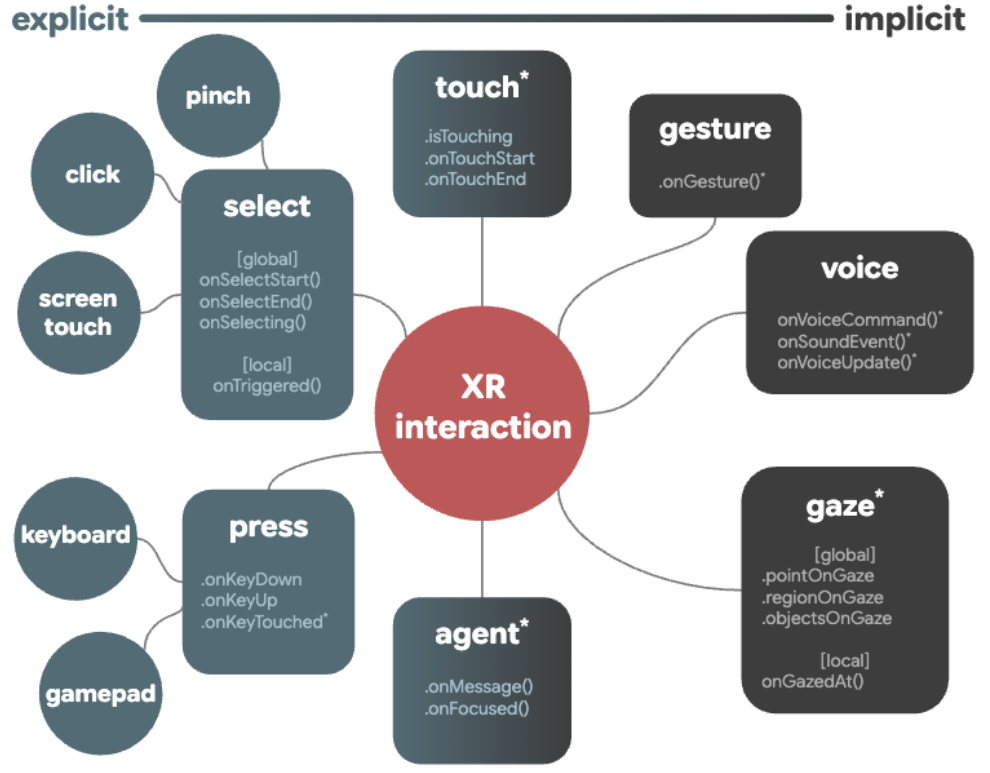

在交互层面,XR Blocks也做了一个聪明的区分。它把用户的输入分成了两种:显式事件和隐式意图。

-

显式事件:就是那些直接的、底层的输入,比如你按了一下按钮,或者触摸了一下屏幕。

-

隐式意图:是更高层次的解读,比如你做了一个“赞”的手势,或者说了一句“打开地图”的语音命令。

这种区分让开发者可以针对用户的“意图”来编程,而不是纠结于具体的输入方式。无论用户是用手势、语音还是手柄来表达“确认”,开发者都可以用同样的方式来处理,这大大简化了交互逻辑的开发。

支撑起这套优雅架构的,是谷歌精挑细选的一套技术栈,全都是开放和成熟的Web技术。

-

WebXR:这是个Web标准,让浏览器可以直接和VR、AR设备打交道。有了它,你的XR应用就能像一个普通网页一样被访问,不用下载安装APP,极大地降低了用户的使用门槛。

-

three.js:这是Web 3D领域的常青树,一个非常强大的JavaScript 3D库。基本上,你在网页上看到的大部分酷炫的3D效果,背后都有它的身影。它为XR Blocks提供了坚实的图形渲染基础。

-

LiteRT:这玩意儿以前叫TensorFlow Lite,是谷歌专门为端侧设备(比如手机、XR眼镜)打造的高性能AI运行时。它的核心价值在于,能让AI模型直接在你的设备上跑,而不是传到云端服务器上。这样做有五大好处:低延迟(不用等网络来回传)、保护隐私(你的个人数据不会离开设备)、离线可用(没网也能用)、体积小(模型和应用都更轻量)、省电。

-

Gemini:这就是给XR Blocks提供“大脑”的那个AI模型了。作为谷歌目前最强大的多模态AI,Gemini能听、能看、能理解、能推理,为XR世界里的智能交互提供了无限可能。

因为基于Web技术,XR Blocks天生就具备跨平台的能力。你写的同一套代码,既可以在电脑的浏览器上用模拟器跑,也可以直接部署到真正的Android XR设备上。

看看都能玩出什么花样

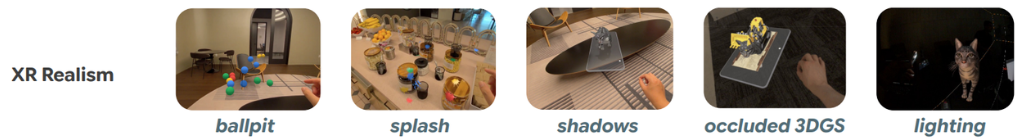

XR Blocks团队做了一系列交互式的演示应用,来展示这个框架的优势。这些例子个个都很有趣,而且在以前,想快速做出这样的原型,是不可能的。

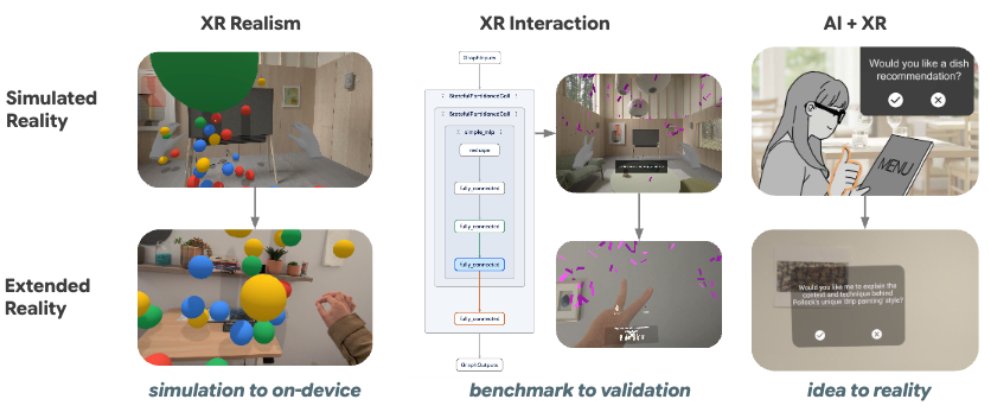

在“XR真实感”这个系列里,他们展示了如何让虚拟世界和真实世界无缝融合。

有个叫“Ballpit”(球坑)的演示。它会先用传感器扫描你所在的房间,建立一个3D地图。然后,它会在这个空间里凭空创造出一个满是小球的虚拟球坑。神奇的是,这些虚拟小球会和你的真实环境发生物理碰撞。你可以把球扔到墙上,它们会弹回来;你可以把它们堆在你的桌子上,它们会从桌子边缘滚落。这种感觉,就像是把游戏世界搬进了你的客厅。

还有像“几何感知阴影”,虚拟物体投射出的影子会根据真实环境的几何形状动态变化,显得无比真实。以及“光照估计”,系统能实时分析你房间的光照情况,让虚拟物体的光影效果和真实环境完全匹配,不会有那种一看就很“假”的出戏感。

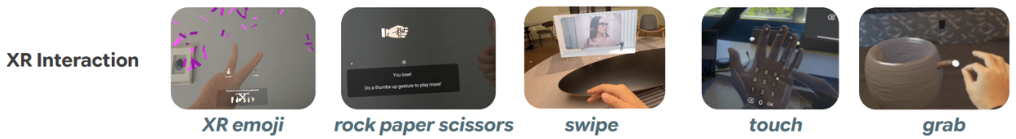

在“XR交互”系列里,重点展示了手势识别和自定义交互。

一个叫“沉浸式表情符号”的演示,你可以通过做出不同的手势,在空中发射出对应的Emoji表情。还有一个“石头剪刀布”游戏,完全通过手势来玩。最酷的是一个手势识别的实验,你就像一个指挥家,做一个简单的手势,就能触发瀑布般的彩色条纹;或者竖起一个大拇指,屏幕上就会下起“气球雨”。这种直观的、充满魔法感的交互,背后都是LiteRT在设备上实时运行的ML(机器学习)模型在支撑。

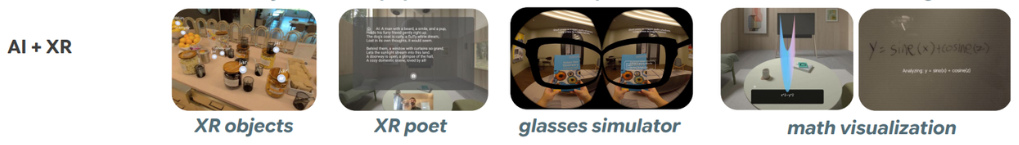

重磅的还是“AI+XR集成”系列。

他们做了一个叫“Gemini破冰者”的应用,让你可以在电脑和XR设备上跟Gemini AI助手聊天。这展示了AI助手在不同平台上的体验一致性。还有一个演示,你可以把摄像头对准真实世界里的任何一个物体,然后让AI为它即兴创作一首诗。

此外,XR Blocks还成为了一个叫“Sensible Agent”的学术研究项目的基础。这是一个由马里兰大学和谷歌的研究人员共同开发的系统,目标是创造一种“懂事儿的”AR助手。这个助手能根据你当前的上下文环境,主动地、而且是以一种不打扰你的方式提供帮助。比如,你正在做饭,它可能会在你旁边的墙上投射出下一步的菜谱,而不是突然在你眼前弹出一个窗口。XR Blocks为这类前沿的人机交互研究提供了强大的工具,让研究者可以跳过繁琐的底层开发,直接去探索更高层次的认知和协作问题。

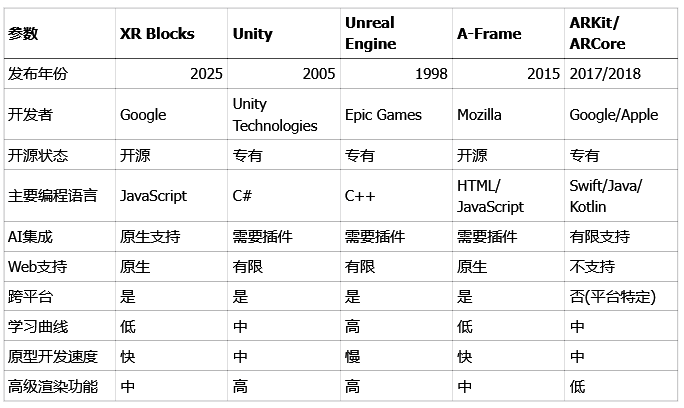

XR Blocks与传统框架对比

说了这么多,XR Blocks在整个行业里到底处于一个什么位置?把它和市面上已有的工具对比一下,就一目了然了。

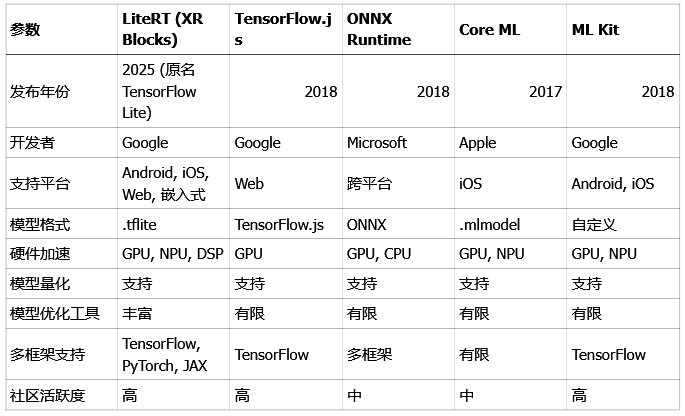

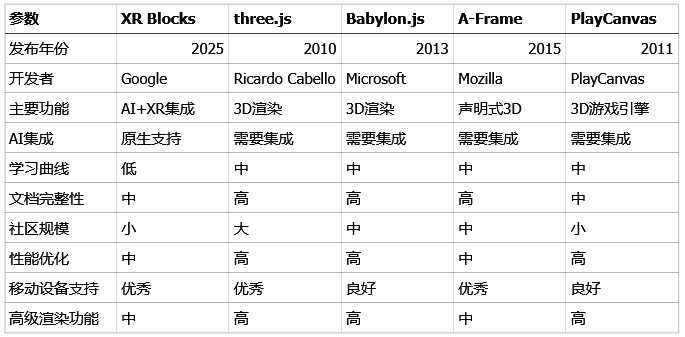

先看看XR开发框架的对比。

和Unity、Unreal Engine(虚幻引擎)这些老牌的、功能强大的游戏引擎相比,XR Blocks显得非常轻量。它不像那两位大哥一样追求大而全,而是专注于AI+XR这个细分领域,主打一个快速原型开发。它的优势在于开源、原生支持Web、学习曲线低。对于想快速验证一个AI+XR创意的团队或个人来说,XR Blocks显然是更敏捷的选择。

再看看它内置的AI运行时LiteRT。跟TensorFlow.js、ONNX Runtime这些工具比,LiteRT的优势在于它是谷歌亲儿子,与TensorFlow生态结合紧密,并且在模型优化工具方面做得非常出色。这意味着开发者可以更容易地把复杂的AI模型压缩、优化,然后塞进资源有限的XR设备里高效运行。

在WebXR库这个赛道,XR Blocks的定位也非常清晰。像three.js和Babylon.js是纯粹的3D渲染库,功能强大但本身不涉及AI。A-Frame则是一个声明式的框架,对新手很友好。XR Blocks的核心差异化在于它从一开始就是为AI+XR的融合而设计的,在AI集成方面是原生的,这是其他库无法比拟的。

最后是它背后的大脑——Gemini。谷歌提供了不同尺寸和性能的模型,从最强大的Pro版本到更轻量的Flash版本,开发者可以根据自己的应用场景和成本预算灵活选择。

XR Blocks的发布,降低了开发的门槛,让更多有创意但可能技术背景不够深厚的开发者也能进入这个领域。

它通过快速原型设计的能力,加速了整个行业的创新循环。

作为一个基于Web标准的开源项目,它有助于推动XR技术的标准化,并围绕它建立一个健康的开发者生态。

谷歌对XR Blocks的未来也有清晰的规划。

他们希望未来能集成一个由LLM驱动的编译器,让开发者可以直接用自然语言来描述想要的体验,然后由AI自动生成代码,实现所谓的“意图驱动创作”。

同时,他们也会集成更多的AI模型,支持更多的XR设备,并提供更强大的开发工具。

参考资料:

https://research.google/blog/xr-blocks-accelerating-ai-xr-innovation

https://arxiv.org/html/2509.25504v1

https://uist.acm.org/2025/papers

https://github.com/google/xrblocks

https://xrblocks.github.io

https://github.com/google/xr-objects

https://visualblocks.withgoogle.com

https://ai.google.dev/edge/litert

https://developers.googleblog.com/en/tensorflow-lite-is-now-litert

END

AI+XR意图驱动创作新框架

AI+XR意图驱动创作新框架

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?