习题

10-1 解决稀疏奖励的方法有哪些?

- 设计奖励

- 好奇心驱动的奖励

- 课程学习 / 逆课程学习

- 分层强化

10-2 设计奖励方法存在什么主要问题?

需要预先拥有领域知识,需要经验积累

10-3 内在好奇心模块是什么?我们应该如何设计这个内在好奇心模块?

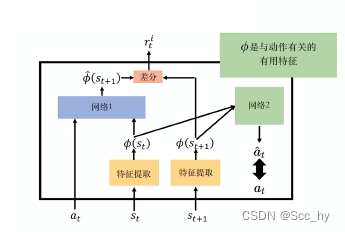

内在好奇心模块: 输入状态s1、动作a1和状态s2, 输出另一个奖励ri1。总奖励包含r和ri

设计内在好奇心模块:

- 一般网络构建

- 输入s1, a1, 输出s’t+1;

- 评估: similar(s’t+1, st+1) 越大则奖励越大。

- 简述: 倾向于让智能体做一些风险比较大的动作,从而增加其探索的能力

- 增强表达的网络构建

- 内在好奇心优化为特征提取器

- feature + head

- feature 层进行特征提取 将 s -> imp_s

- head 进行优化

- forward:

- imp_s = feature(s)

- imp_s1 = feature(s1)

- a’=head(imp_s, imp_s1)

- 评估 进行下一次动作的

- similar(a1, a’) 动作跟真正的动作越接近越好

- ri = imp_s1 - Q(a, imp_s)

本文探讨了强化学习中解决稀疏奖励问题的各种方法,包括设计奖励、好奇心驱动奖励、课程学习及分层强化等策略,并深入讨论了设计奖励存在的挑战与内在好奇心模块的设计方法。

本文探讨了强化学习中解决稀疏奖励问题的各种方法,包括设计奖励、好奇心驱动奖励、课程学习及分层强化等策略,并深入讨论了设计奖励存在的挑战与内在好奇心模块的设计方法。

3386

3386

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?