目录

前言

本篇主要介绍,最近新出的YOLO-World如何在Ultralytics中简单使用。由于楼主也是小白,如果错误地方欢迎大家指正。

一、前置环境搭建

1.Pytorch的安装

由于本文是在Ultralytics版本上使用YOLO-World所以我们要先下载好Pytorch,才能使用。详细安装过程参考如下文章:

学会了上面内容之后,我们需要创建一个新的虚拟环境(安装好Pytorch)用于使用YOLO-World。

二、YOLO-World使用

1.下载Ultralytics

其实就是YOLO系列的框架,在GitHub上下载好,解压完用Pycharm打开

2.下载依赖环境

先在设置里的Python解释器选择我们新创建好的虚拟环境,再配置下终端,方便再Pycharm中直接进入虚拟环境,安装YOLO-World需要的依赖包(不会的参考YOLO系列部署)

然后在终端输入指令下载需要的依赖环境

pip install ultralytics

3.下载YOLO-World权重

第一个链接是YOLO-World的GitHub源码地址链接,里边有不同的权重文件

GitHub - AILab-CVC/YOLO-World: [CVPR 2024] Real-Time Open-Vocabulary Object Detection

这里楼主选用yolov8s-world.pt(下载好后直接放下根目录下即可),需要其他权重,去上边链接下载

https://github.com/ultralytics/assets/releases/download/v8.1.0/yolov8s-world.pt

4.检测使用(不含训练,只检测coco中有的80类)

(1)不指定特定检测类

在根目录下创建一个新的python文件,复制下边代码放进去。直接运行即可。

from ultralytics import YOLOWorld

# 加载模型 放你下载好的YOLOWorld权重文件路径

model = YOLOWorld('yolov8s-world.pt')

# 推理预测 选择一张图片,放你图片路径

results = model.predict('data/images/bus.jpg')

# 显示结果

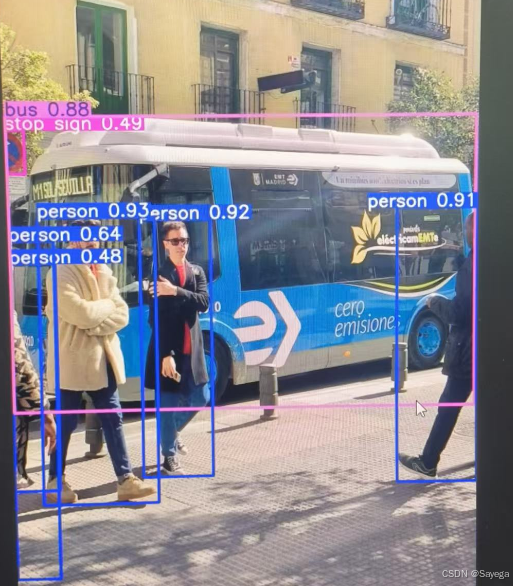

results[0].show()检测结果如下:

(2)指定检测类

指定检测类,就涉及了文本embedding的模块,需要用到CLIP,在终端安装clip

pip install openai-clip

然后使用下面代码运行,即可

from ultralytics import YOLOWorld

# Initialize a YOLO-World model

model = YOLOWorld('yolov8s-world.pt') # or choose yolov8m/l-world.pt

# Define custom classes 这里设置指定检测的类

model.set_classes(["person"])

# Execute prediction for specified categories on an image

results = model.predict('data/images/bus.jpg')

# Show results

results[0].show()检测结果如下:

总结

由于网上目前关于这部分内容比较少,等楼主多探索下,再回来分享下其他学到的东西,祝大家学习愉快!

688

688