VMamba模型代码地址:MzeroMiko/VMamba: VMamba: Visual State Space Models,code is based on mamba![]() https://github.com/MzeroMiko/VMamba

https://github.com/MzeroMiko/VMamba

默认前提是,已经配置好了linux+Anaconda环境,这里只介绍怎样配置用于VMamba模型的虚拟环境以及vscode链接测试模型。

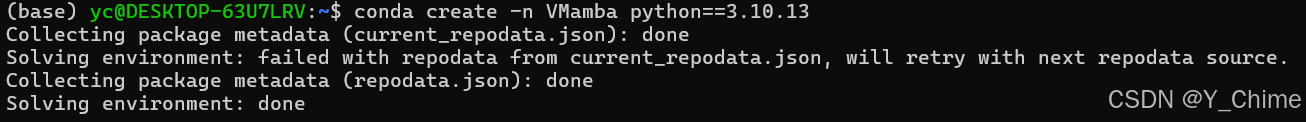

1.创建虚拟环境,直接在Ubuntu终端输入指令

conda create -n VMamba python==3.10.13

2.激活虚拟环境

conda activate VMamba

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

2487

2487

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?