衡宇 昕祎 发自 凹非寺

量子位 | 公众号 QbitAI

刚刚,就在WAIC现场的一个展台,我亲眼看到一只机器狗,在完全离线断网的情况下,学会了一个新动作。

是一位中年男性观众现场教的。让它先转个圈,再立起来做了个经典的小狗拜拜。

教完过后没两分钟,狗子自己就原模原样复现出来了——

没有预定程序,没人遥控操纵,狗子全程离线。

一扭头,这展台还摆着几只灵巧手,一会儿在愉快地玩黄金矿工,一会儿又玩推箱子推得正起劲。

听展台工作人员说,玩儿得这么溜的灵巧手,也是纯离线,全靠它本地部署模型的视觉能力,看得懂画面,也玩得转策略。

其实灵巧手、机器狗、机器人等是本届WAIC不少展位吸引目光的招牌产品。

之所以想和大家分享刚刚的所见所闻,一方面是因为在真·离线的状态下,这俩端侧设备表现得实在是不错;另一方面,是因为部署在它们身上的模型,是非Transformer架构的大模型。

展台负责介绍的小姐妹告诉我们,背后是设备原生智能:能离线跑、会多模态,还能边用边学。

这套体系的幕后推手,是一家成立刚满两年的公司——RockAI。

早在ChatGPT名动全球之前的2022年初,这家公司就开始全心押注非Transformer架构大模型,从最底层重构AI模型的运行逻辑。

今年WAIC期间,RockAI创始人刘凡平公开表示:

目前AI的发展需要推翻两座大山,一个是反向传播,一个是Transformer。

当大模型具备“原生记忆”能力

在RockAI展台上自学新动作的机器狗、会玩游戏的灵巧手,都运行着RockAI最新推出的Yan 2.0 Preview大模型。

这个版本,相比初代Yan 1.0的语言能力、Yan 1.3的多模态理解能力,最大的突破在于它开始具备“记忆”了——引入了原生记忆模块。

这里的“记忆”,不是对某个长度上下文的窗口限制,而是Yan 2.0 Preview具备了边用边学、可持续进化的能力。

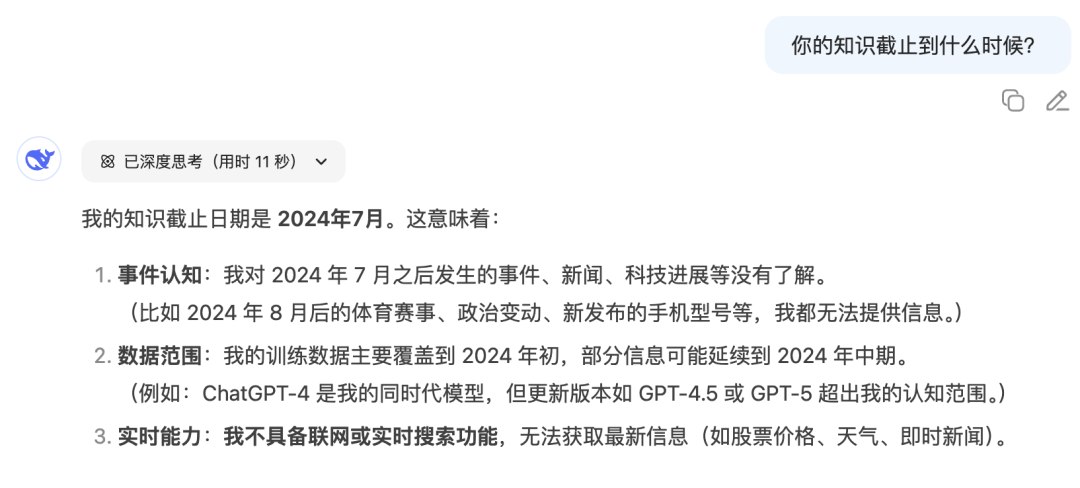

现在大家用大模型,都会遇到这样一种情况:提的问题超出了Chatbot的训练数据覆盖范围,得到一句“很抱歉,我的知识截至于2024年x月,无法提供相关信息”,要么就是得到一顿瞎编的结果,令人头秃。

这是传统大模型“先训练→再部署→使用过程不能更新”导致的。

所以,现在联网搜索功能几乎成了Chatbot们的标配。

但相比于原生记忆,联网搜索、外挂记忆库、拓展长上下文等解决方案其实没有解决根本问题。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

29

29

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?