提到大型语言模型的推理能力,大家最先想到的肯定是 “思维链”—— 让模型像人一样 “一步步拆解问题”,从数学题到编程任务都能搞定。

但用过的人都懂,这种 “慢思考” 的代价有点大:解一道题要生成几千个 “中间思考 token”,延迟高不说,遇到简单题还会 “想太多”(比如算 2+3 还要列步骤),反而容易出错。

更麻烦的是,想让 CoT 发挥作用,还得靠大规模监督数据或强化学习,落地门槛不低。

不过现在,浙江大学的团队提出了一个新方案,直接给 LLM 推理装了个 “智能加速器”:既能保持思维链的高准确率,又能把 token 消耗砍半,甚至小模型也能用上!

这篇题论文的核心就是让模型学会 “抓重点”—— 不用每次都从头推导,靠 “过往经验” 快速解决问题,难搞的任务再切换到 “慢思考” 模式。

1 摘要

面向推理任务的大型语言模型通常依赖逐步生成显式tokens,其效果往往取决于大规模监督微调或强化学习。

尽管CoT技术显著提升了复杂推理任务的性能,但效率较低,需要较长的推理轨迹,这会增加延迟和标记消耗。

本文提出Latent Codebooks for Fast Thinking框架,该框架仅在训练阶段使用简洁的思维链草稿,以学习离散策略先验的码本。

在推理阶段,模型通过单次前向传播,基于从码本中提取的少量连续推理向量进行条件生成,无需生成显式推理标记即可实现策略级引导。

为补充该设计,本文还提出了GainRouter——一种轻量级路由机制,能自适应地在码本引导的快速推理与显式的慢速推理之间切换,从而抑制过度推理,减少不必要的标记生成。

在多个推理基准上的实验表明,该方法在大幅降低推理成本的同时,实现了具有竞争力或更优的准确率,为大型语言模型中高效且可控的推理提供了切实可行的路径。

2 背景

LLMs在自然语言理解、代码生成和数学推理等领域已取得优异性能。为进一步提升其复杂推理能力,研究界广泛采用CoT及相关多步提示策略,将任务分解为组合子目标,在算术、归纳推理和长依赖问题中提升了鲁棒性与可解释性;此外,基于探索的变体(如自一致性、树或图结构搜索、工具增强流水线)通过对中间状态采样或搜索,进一步优化了问题求解过程。

然而,思维链式的“慢速推理”存在明显缺陷:一是需生成大量中间“推理标记”才能得到答案,导致延迟和标记成本显著增加;二是在简单任务实例中,扩展推理会引发“过度推理”,产生不必要、关联性弱的步骤,甚至加剧错误;三是实践中强大的多步推理常依赖过程监督或基于偏好的策略优化(包括基于强化学习的方法如PPO/GRPO风格的RLHF,以及无强化学习方法如DPO),这为大规模部署带来了数据和工程障碍,本文将这类显式多步生成过程定义为“慢速推理”。

实际上,许多初看复杂的问题无需枚举冗长推导,通过快速回忆并应用已有解决方案模式即可快速解决,这与人类解决问题时“提前识别场景并确定高概率方案”的思路类似。基于此,本文提出核心问题:大型语言模型能否内化一组紧凑、可复用的离散先验,并在推理时提取少量针对性引导以实现单次前向传播的条件解码?若能实现,模型可通过“快速推理”生成高质量答案,避免冗长逐步生成带来的开销与潜在不稳定性。

3 技术方案

本文技术方案围绕“LC-FT”和“GainRouter”展开,核心包含数据构建码本设计两阶段训练LoRA适配及路由机制五大模块,具体如下:

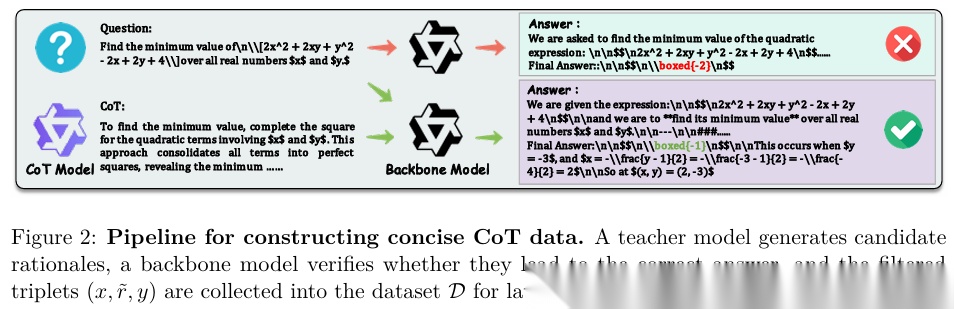

3.1 用于潜在先验学习的简洁思维链

构建仅作为训练信号的简洁教师推理数据集(如图2所示):给定问题和正确标签,由教师模型生成提示,仅当提示不泄露答案且学生模型基于该提示能正确预测答案时,提示才被接受。若提示验证失败,结合错误历史重新查询教师模型获取新提示,直至验证成功并保留首个有效提示,最终形成数据集,实现无需测试阶段长推理的潜在先验监督。

3.2 LC-FT

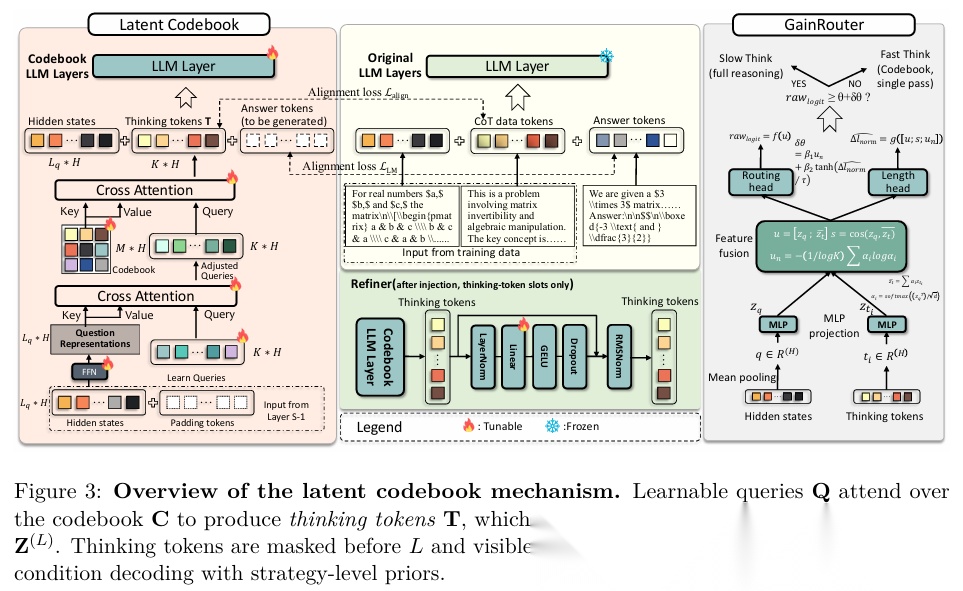

将简洁推理规则提炼到模型中,引入存储离散先验并生成连续推理标记以进行条件解码的潜在码本(如图3所示):

码本与推理标记生成:设置可学习码本(包含多个原型条目),通过跨输入共享的可学习查询对码本进行注意力计算,生成推理标记向量。注意力计算能从多个原型中组合先验,码本充当推理策略的有限基础,推理标记向量则是策略的软组合。

推理标记注入:在Transformer的指定层(插入层)预留推理标记槽位,将生成的推理标记与输入的上下文嵌入组合,形成该层的隐藏序列。推理标记在插入层前被遮蔽插入层后可见,确保后续层计算受推理标记影响。

推理标记优化:在注入后,仅对推理标记槽位应用轻量级残差MLP优化器,在引入策略级先验的同时,不增加推理时输出生成长度。

3.3 两阶段训练

阶段1(对齐训练):冻结参考大型语言模型,让其处理附加简洁推理规则的输入,并对推理规则对应的隐藏状态进行均值池化;同时,本文模型在插入层注入推理标记,对推理标记对应的隐藏状态也进行均值池化。通过计算两类均值池化结果的余弦相似度损失,实现推理标记与参考模型推理规则表示的对齐。

阶段2(监督微调):移除显式推理规则,让模型基于推理标记求解任务,优化语言模型的自回归损失,同时更新基础模型码本,并解冻插入层及之后的适配器。

3.4 基于LoRA的插入层感知微调

为高效适配基础模型,仅在推理tokens插入层及之后的层应用LoRA,冻结更早的层,将适配能力集中于与推理标记交互的子网络。对插入层及之后层的线性变换,通过低秩因子调整权重。在监督微调阶段,仅解冻插入层及之后的适配器,优化自回归目标。

3.5 增益路由器

特征提取与聚合:从非推理模式的传播中获取问题的池化向量和推理标记向量,将两者投影到同一维度后,通过注意力聚合推理标记的证据,形成综合特征向量;同时计算问题向量与聚合后推理标记向量的余弦相似度注意力熵作为辅助特征。

决策与训练:通过小型MLP将综合特征向量映射为原始对数概率,结合辅助特征计算归一化长度差(快速与慢速推理的输出长度差异),并基于此设定自适应阈值。路由器默认选择快速推理,仅当原始对数概率超过自适应阈值时,切换到慢速推理。训练时,根据快速与慢速推理的成功情况标注标签,优化分类损失长度预测损失及参数正则化损失。

5 实验结果

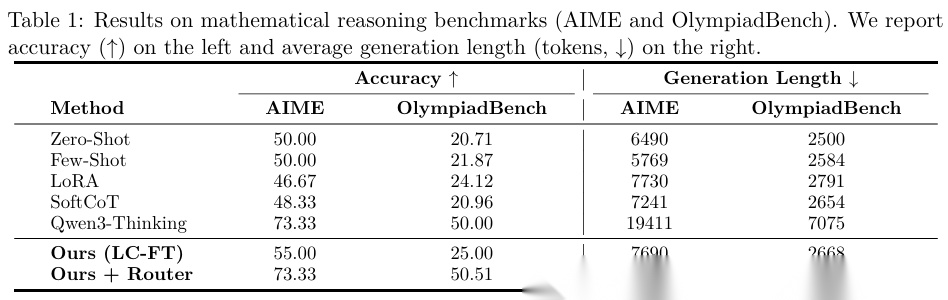

数学推理任务(表1):

与零样本/少样本提示LoRA微调SoftCoT相比,LC-FT(本文快速推理框架)在AIME准确率达55.0%OlympiadBench达25.0%,均优于基线(零样本AIME 50.0%OlympiadBench 20.71%;SoftCoT AIME 48.33%OlympiadBench 20.96%)。

加入GainRouter后,性能进一步提升:AIME准确率达73.33%(与Qwen3-Thinking持平),OlympiadBench达50.51%(略高于Qwen3-Thinking的50.0%);同时标记消耗大幅降低,AIME从Qwen3-Thinking的19411 tokens降至12797 tokens,OlympiadBench从7075 tokens降至5332 tokens。

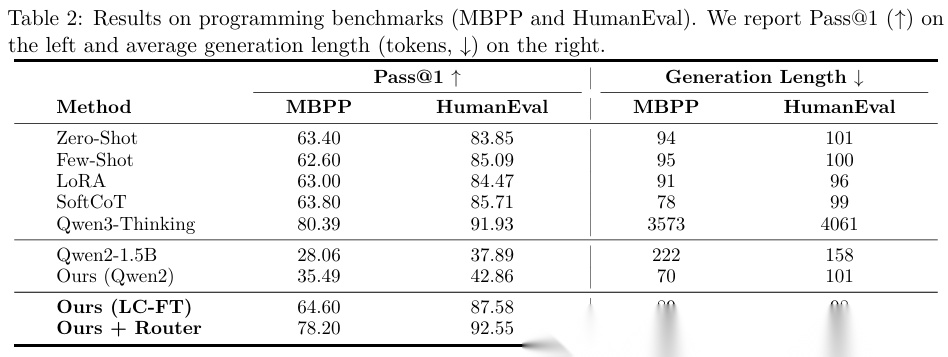

编程任务(表2):

LC-FT在MBPP的Pass@1达64.60%HumanEval达87.58%,优于零样本(MBPP 63.40%HumanEval 83.85%)LoRA微调(MBPP 63.00%HumanEval 84.47%)SoftCoT(MBPP 63.80%HumanEval 85.71%)。

加入GainRouter后,MBPP Pass@1达78.20%HumanEval达92.55%(接近Qwen3-Thinking的80.39%91.93%),标记消耗从Qwen3-Thinking的MBPP 3573 tokensHumanEval 4061 tokens,分别降至1348 tokens1401 tokens。

跨规模蒸馏:将LC-FT蒸馏到Qwen2-1.5B(更小模型),在MBPP Pass@1达35.49%HumanEval达42.86%,显著优于原始Qwen2-1.5B的28.06%37.89%,证明策略先验可跨模型规模迁移。

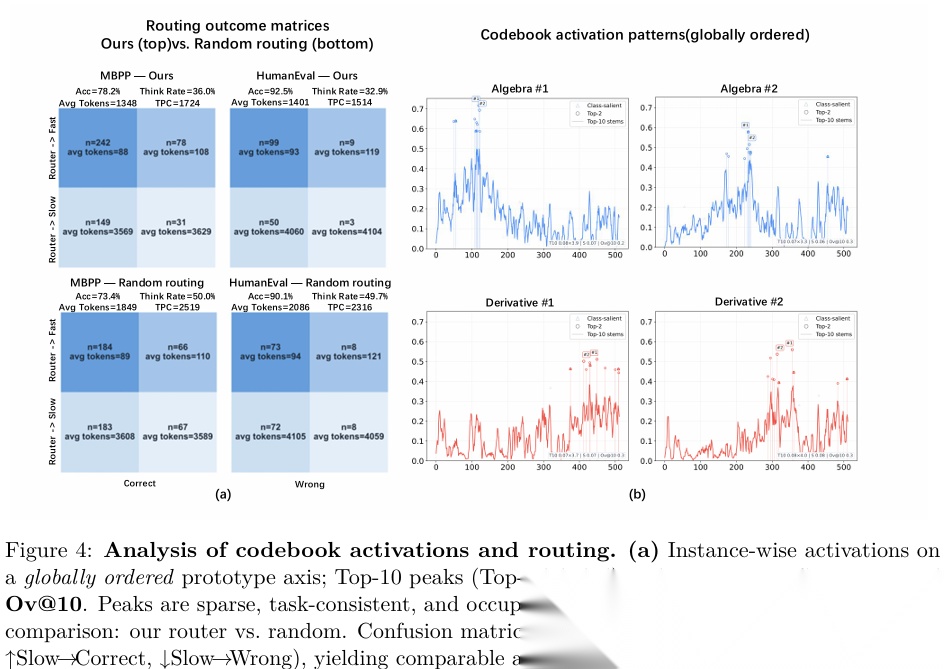

码本与路由分析(图4):

码本激活具有稀疏性和任务一致性:实例激活集中在少量原型上,且代数导数等不同任务的激活集中在码本的不同区域。

与随机路由相比,GainRouter能更精准选择推理模式:在MBPP上,GainRouter准确率78.2%(随机路由73.4%),平均标记1348 tokens(随机路由1849 tokens);在HumanEval上,GainRouter准确率92.5%(随机路由90.1%),平均标记1401 tokens(随机路由2086 tokens)。

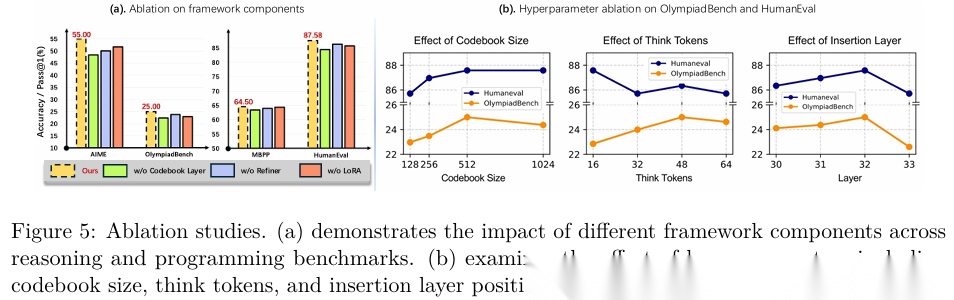

4.3 消融实验(图5)

码本层:移除码本后,数学推理和编程任务的准确率均大幅下降,且编程任务生成结果更冗长不稳定,证明码本是快速推理的核心机制。

推理标记优化器(Refiner):移除后,推理任务准确率中度下降,因推理标记的噪声和错位无法被修正,影响求解路径引导。

LoRA适配:移除后,模型无法充分适配推理标记的影响,尤其在编程任务中, token级输出精度下降,证明LoRA对利用推理标记先验至关重要。

4.4 超参数影响(图5)

码本大小:从128个条目增至512个时,OlympiadBench准确率从22.97%升至25.00%,HumanEval从85.71%升至87.58%;增至1024个时性能趋于平稳,512个条目为准确率与成本的最优平衡点。

推理标记数量:OlympiadBench在48个标记时性能最优(25.00%),编程任务在16个标记时最优(HumanEval 87.58%),因编程任务受语法约束强,过多标记易引入干扰。

插入层位置:在第32层注入推理标记时性能最佳,注入过早则语义上下文不足,注入过晚则缺乏足够层传播和整合先验。

6 结论

本文提出LC-FT框架,通过简洁思维链监督学习紧凑的策略级先验,并在推理时以连续推理向量的形式引导生成,避免显式多步推理的低效性。

同时,引入GainRouter,自适应切换快速与慢速推理模式,有效抑制过度推理并减少标记消耗。

实验表明,LC-FT在数学推理和编程基准上,均优于提示学习LoRA微调SoftCoT等方法,且加入GainRouter后能接近慢速思维链的准确率,同时大幅降低标记消耗。

此外,LC-FT可有效蒸馏到更小模型,证明其策略先验的跨规模迁移能力,为大型语言模型实现可扩展数据高效且可部署的推理提供了实用路径。

如何学习大模型 AI ?

我国在AI大模型领域面临人才短缺,数量与质量均落后于发达国家。2023年,人才缺口已超百万,凸显培养不足。随着Al技术飞速发展,预计到2025年,这一缺口将急剧扩大至400万,严重制约我国Al产业的创新步伐。加强人才培养,优化教育体系,国际合作并进,是破解困局、推动AI发展的关键。

但是具体到个人,只能说是:

“最先掌握AI的人,将会比较晚掌握AI的人有竞争优势”。

这句话,放在计算机、互联网、移动互联网的开局时期,都是一样的道理。

我在一线互联网企业工作十余年里,指导过不少同行后辈。帮助很多人得到了学习和成长。

我意识到有很多经验和知识值得分享给大家,也可以通过我们的能力和经验解答大家在人工智能学习中的很多困惑,所以在工作繁忙的情况下还是坚持各种整理和分享。但苦于知识传播途径有限,很多互联网行业朋友无法获得正确的资料得到学习提升,故此将重要的AI大模型资料包括AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频免费分享出来。

2025最新大模型学习路线

明确的学习路线至关重要。它能指引新人起点、规划学习顺序、明确核心知识点。大模型领域涉及的知识点非常广泛,没有明确的学习路线可能会导致新人感到迷茫,不知道应该专注于哪些内容。

对于从来没有接触过AI大模型的同学,我帮大家准备了从零基础到精通学习成长路线图以及学习规划。可以说是最科学最系统的学习路线。

针对以上大模型的学习路线我们也整理了对应的学习视频教程,和配套的学习资料。

大模型经典PDF书籍

新手必备的大模型学习PDF书单来了!全是硬核知识,帮你少走弯路!

配套大模型项目实战

所有视频教程所涉及的实战项目和项目源码等

博主介绍+AI项目案例集锦

MoPaaS专注于Al技术能力建设与应用场景开发,与智学优课联合孵化,培养适合未来发展需求的技术性人才和应用型领袖。

这份完整版的大模型 AI 学习资料已经上传优快云,朋友们如果需要可以微信扫描下方优快云官方认证二维码免费领取【保证100%免费】

为什么要学习大模型?

2025人工智能大模型的技术岗位与能力培养随着人工智能技术的迅速发展和应用 , 大模型作为其中的重要组成部分 , 正逐渐成为推动人工智能发展的重要引擎 。大模型以其强大的数据处理和模式识别能力, 广泛应用于自然语言处理 、计算机视觉 、 智能推荐等领域 ,为各行各业带来了革命性的改变和机遇 。

适合人群

- 在校学生:包括专科、本科、硕士和博士研究生。学生应具备扎实的编程基础和一定的数学基础,有志于深入AGI大模型行业,希望开展相关的研究和开发工作。

- IT行业从业人员:包括在职或失业者,涵盖开发、测试、运维、产品经理等职务。拥有一定的IT从业经验,至少1年以上的编程工作经验,对大模型技术感兴趣或有业务需求,希望通过课程提升自身在IT领域的竞争力。

- IT管理及技术研究领域人员:包括技术经理、技术负责人、CTO、架构师、研究员等角色。这些人员需要跟随技术发展趋势,主导技术创新,推动大模型技术在企业业务中的应用与改造。

- 传统AI从业人员:包括算法工程师、机器视觉工程师、深度学习工程师等。这些AI技术人才原先从事机器视觉、自然语言处理、推荐系统等领域工作,现需要快速补充大模型技术能力,获得大模型训练微调的实操技能,以适应新的技术发展趋势。

课程精彩瞬间

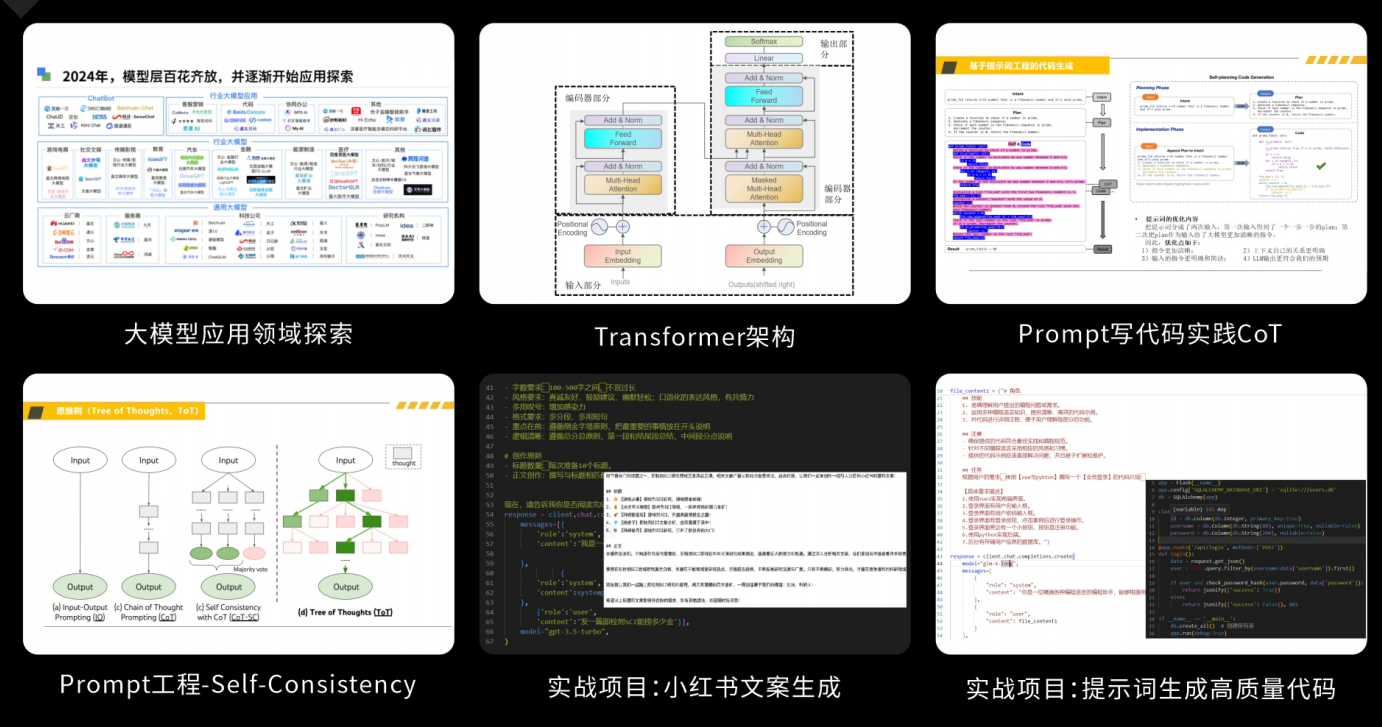

大模型核心原理与Prompt:掌握大语言模型的核心知识,了解行业应用与趋势;熟练Python编程,提升提示工程技能,为Al应用开发打下坚实基础。

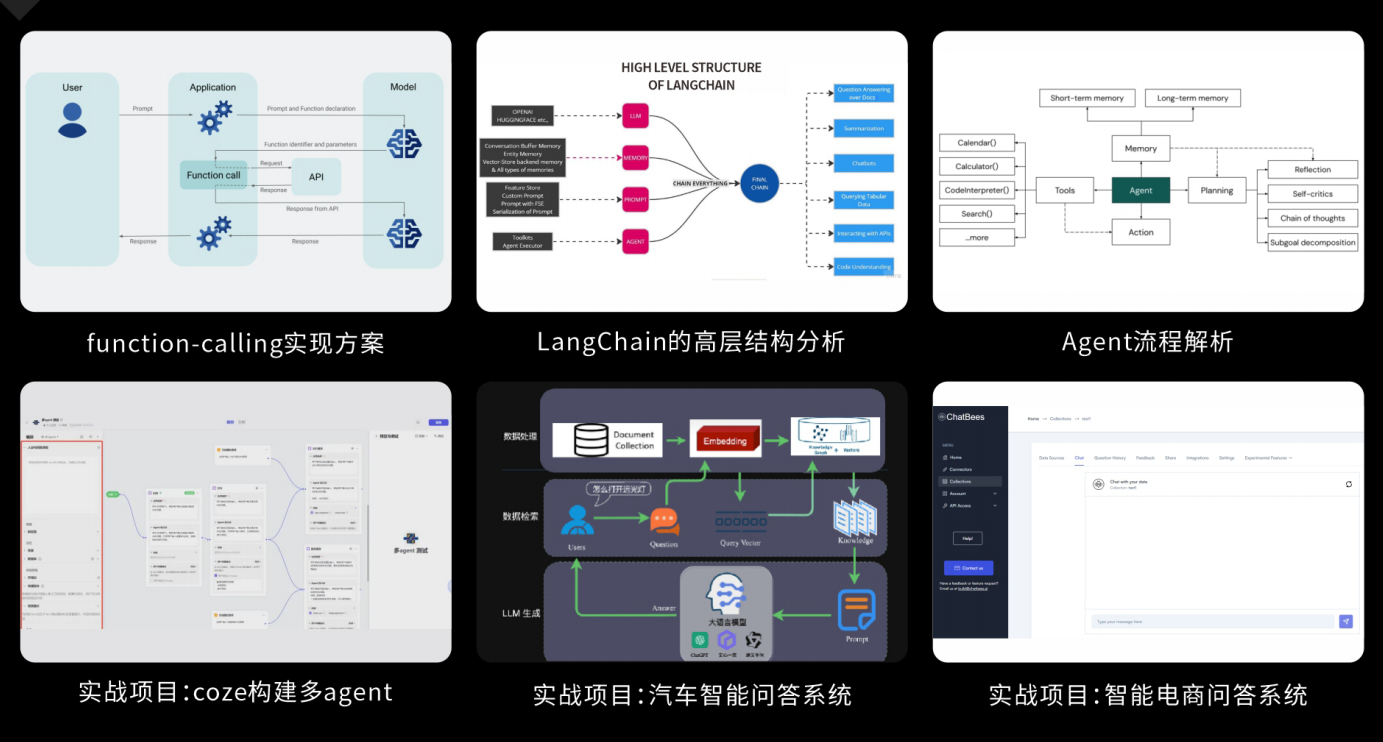

RAG应用开发工程:掌握RAG应用开发全流程,理解前沿技术,提升商业化分析与优化能力,通过实战项目加深理解与应用。

Agent应用架构进阶实践:掌握大模型Agent技术的核心原理与实践应用,能够独立完成Agent系统的设计与开发,提升多智能体协同与复杂任务处理的能力,为AI产品的创新与优化提供有力支持。

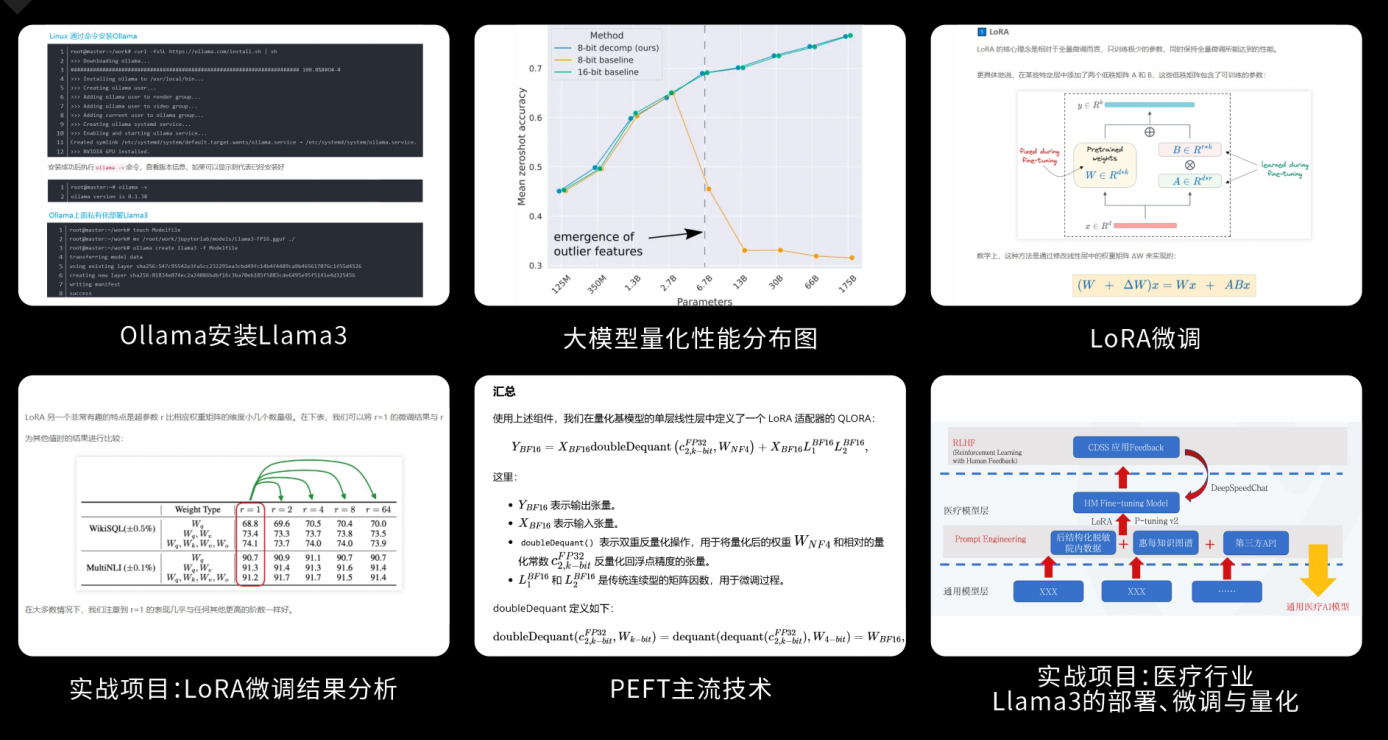

模型微调与私有化大模型:掌握大模型微调与私有化部署技能,提升模型优化与部署能力,为大模型项目落地打下坚实基础。

顶尖师资,深耕AI大模型前沿技术

实战专家亲授,让你少走弯路

一对一学习规划,职业生涯指导

- 真实商业项目实训

- 大厂绿色直通车

人才库优秀学员参与真实商业项目实训

以商业交付标准作为学习标准,具备真实大模型项目实践操作经验可写入简历,支持项目背调

大厂绿色直通车,冲击行业高薪岗位

文中涉及到的完整版的大模型 AI 学习资料已经上传优快云,朋友们如果需要可以微信扫描下方优快云官方认证二维码免费领取【保证100%免费】

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?