旺晓通:深入浅出,轻松通晓

搭建跨模态检索系统时,有两个难题:一是处理图文混合候选集时,token数量爆炸导致GPU直接内存溢出;二是用RL训练模型时,要么收敛不了,要么推理过程漏洞百出,检索准确率始终上不去。直到看到这篇 NeurIPS 2025 的 Retrv-R1 论文,才发现原来不用复杂架构,只要针对性解决“信息冗余”和“训练不稳定”两个核心痛点,就能让多模态检索的准确率和效率同时突破瓶颈——这篇研究给出了新的技术方案,更提供了“推理驱动检索”的全新思路。

我们解读最新技术,文末有相关信息。

作者:张长旺,图源:旺知识

一、AI多模态检索的核心痛点:准确率与效率的两难困境

信息检索早已不是单一文本或图像的匹配任务,现在的搜索引擎、推荐系统、RAG应用,都需要处理“文本查图像”“图文混合查视频”等多模态场景。但实际落地中,科研和工程团队都会遇到两个绕不开的难题:

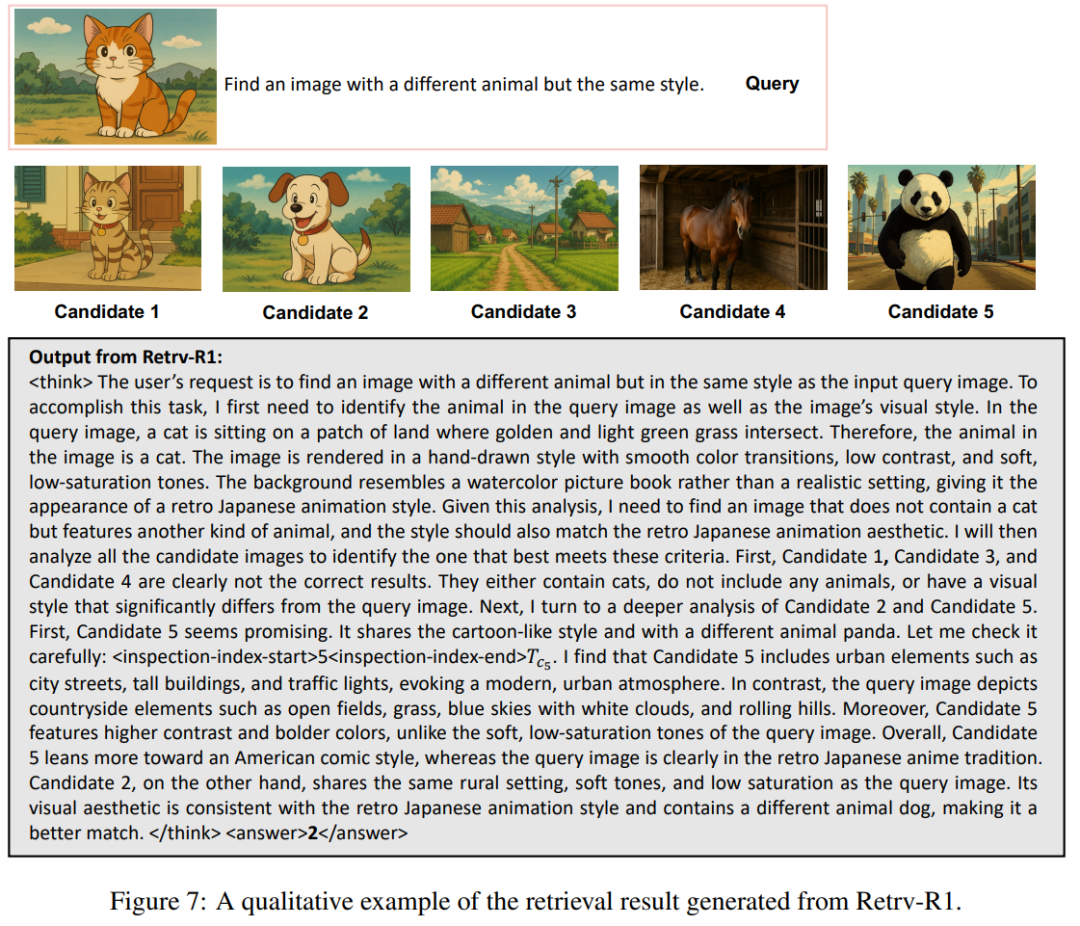

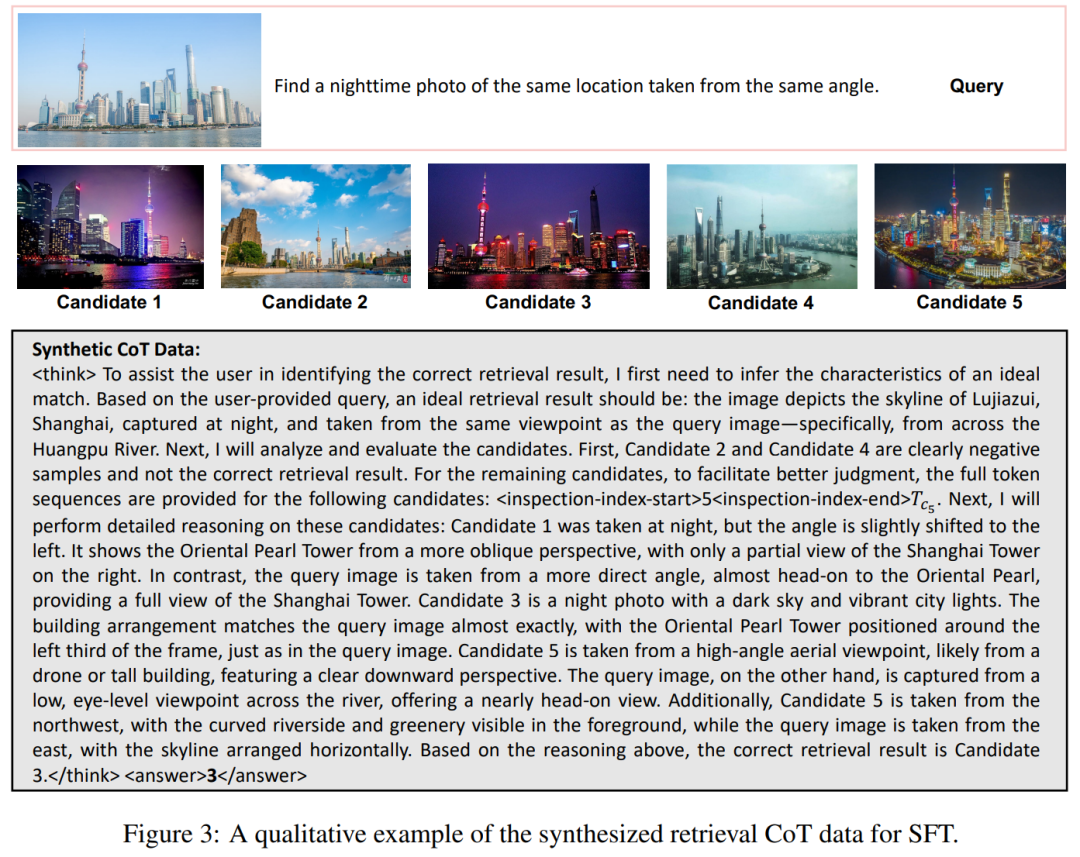

- 复杂场景检索不准:传统MLLM做检索,要么靠嵌入向量计算相似度(像盲人摸象,容易忽略关键关联),要么直接当QA任务处理(跳过推理过程,复杂查询根本扛不住)。比如在“找一张和白天照片同角度的夜景图”这类任务中,传统模型要么分不清角度差异,要么忽略“夜景”这个核心约束。

- 多候选场景效率极低:当候选样本超过20个,尤其是包含图像、视频等模态时,token数量会呈指数级增长,不仅推理时间拉长(我们之前测试过,K=50时单条查询要10秒),还容易超出模型上下文窗口,导致检索失败。

- RL训练水土不服:之前DeepSeek-R1用RL提升LLM推理能力的思路很火,但直接套用到检索任务上完全行不通——一方面多候选+推理过程的token消耗太大,计算成本扛不住;另一方面模型容易生成错误推理链,越训练越跑偏,准确率反而下降。

这些问题本质上是“检索任务的特殊性”与“通用MLLM框架”的不匹配:检索需要快速筛选海量候选,而MLLM的推理过程天然需要充足上下文,两者就像“要快速跑马拉松”和“带着沉重背包”的矛盾。

二、传统方案的局限:为什么之前的尝试都失败了?

我们在Retrv-R1之前,也试过三种主流方案,结果都不尽如人意:

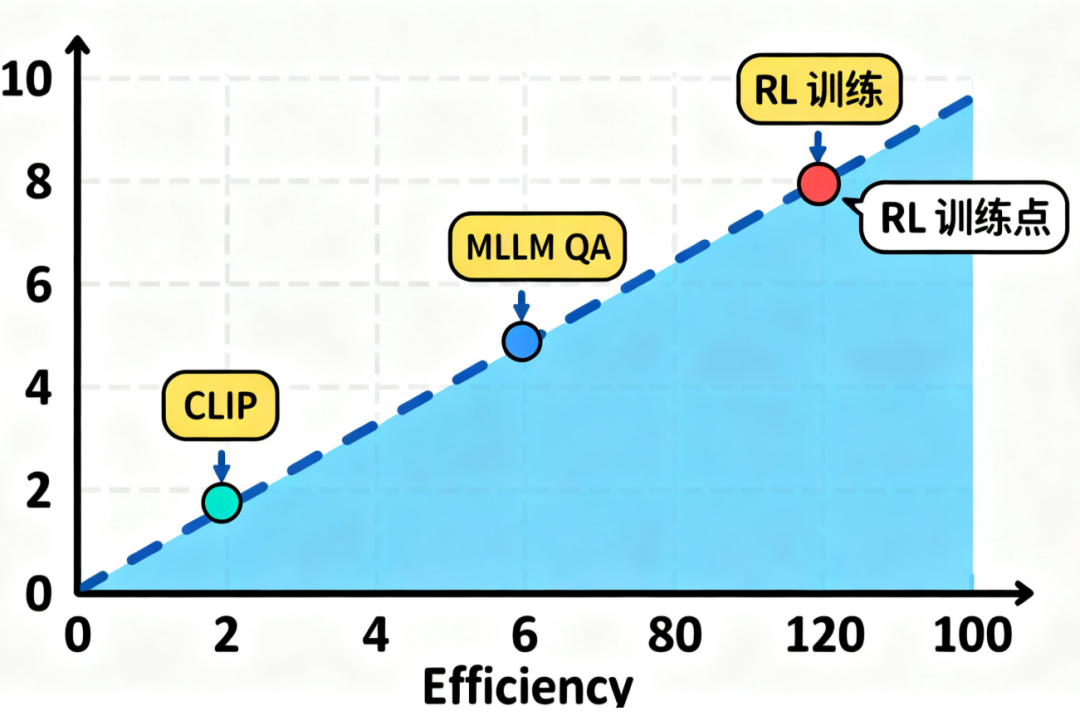

- 方案1:基于CLIP的嵌入检索:优点是快,但只能捕捉表面特征,比如无法理解“同角度不同时间”这种深层关联,在M-BEIR数据集的复杂任务上,根本达不到实用标准。

- 方案2:MLLM直接QA式检索:把查询和候选拼成指令,让模型直接输出结果。这种方式准确率稍高,但完全没有推理过程,遇到“排除明显负样本后再对比相似候选”的场景就歇菜,而且候选超过10个就会严重卡顿。

- 方案3:直接套用DeepSeek-R1的RL训练:我们用GRPO算法训练Qwen2.5-VL,结果训练了3个epoch都没收敛,而且错误推理链占比高达30%——就像让新手直接上战场,不仅不会打仗,还会拖慢整体节奏。

这些失败让我们意识到:检索任务需要的“推理”,不是像数学题那样的复杂推导,而是“快速筛选-重点核查-精准匹配”的高效流程;同时,多模态候选的信息必须“瘦身”,但不能丢关键信息。而Retrv-R1恰好踩中了这两个关键点。

三、Retrv-R1的核心创新:用“信息压缩+分阶段训练”破局

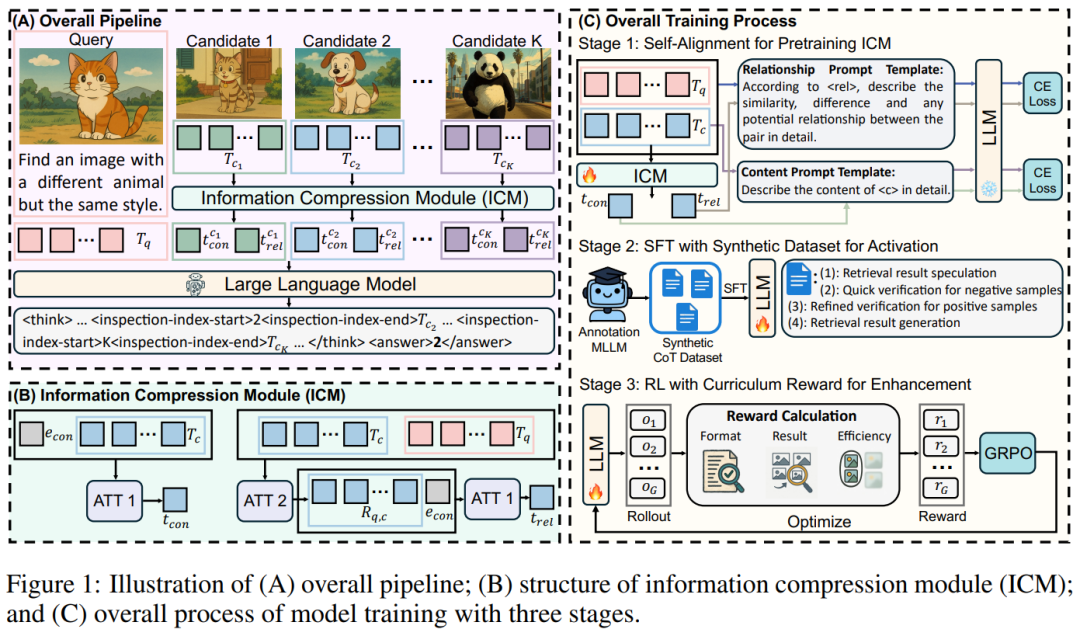

Retrv-R1的本质是“为检索任务量身定制的R1风格MLLM框架”,核心思路很简单:让模型只处理关键信息,让训练循序渐进贴合检索场景。整个框架的创新点集中在两个模块,既好理解又好实现:

1. 信息压缩模块(ICM):给候选样本“瘦身后备重点”

如果把每个候选样本比作一篇实验报告,传统模型会逐字逐句读完所有报告,而ICM做的是“提炼摘要+标注重点”——既减少阅读量,又不会错过关键信息。

- 核心设计:把每个候选样本压缩成2个token:

- 内容token(t_con):提炼样本核心内容,比如一张夜景图的“地点+构图+光线”,就像实验报告的“核心发现”;

- 关系token(t_rel):捕捉样本与查询的关联,比如“这张图和查询的角度一致但时间不同”,就像实验报告的“与研究目标的相关性分析”。

- 自对齐预训练:为了避免压缩后丢关键信息,作者用了一个巧妙的方法:让MLLM根据压缩后的2个token,还原出完整样本的描述。这就像让研究员根据摘要还原实验报告,确保摘要里包含所有关键信息——这个预训练过程让ICM的压缩损失降到最低。

- 细节检查机制:最妙的是,模型在推理时如果发现某个候选“不好判断”(比如两个样本看起来都符合查询),会自动触发“查原文”机制,调用该候选的完整token序列进一步分析。这就像研究员看摘要拿不准时,再翻完整实验记录,既保证效率又不牺牲准确率。

用生活化的比喻来说,ICM就像快递分拣系统:大部分包裹(候选样本)通过标签(压缩token)快速分流,只有少数模糊包裹(难判断样本)需要拆开检查,既快又准。

2. 三阶段训练:让模型“先会做再做好”

直接用RL训练检索模型,就像让新手直接参加竞赛;而Retrv-R1的训练过程,更像科研人员的成长路径:先打基础,再练技巧,最后冲成绩。

- • 阶段1:ICM预训练:先冻结MLLM,单独训练ICM的压缩能力,确保它能提炼出关键信息——这一步解决“信息冗余”的基础问题。

- • 阶段2:合成CoT的SFT激活:由于没有现成的“检索推理数据集”,作者用Qwen2.5-VL-72B生成了10万条合成CoT数据,每条数据包含四步推理:

- 推测理想结果(比如“用户要的是同角度夜景图,应该有XX特征”);

- 快速排除负样本(比如“这张是白天的,直接排除”);

- 重点核查难样本(比如“这两张都是夜景,调用完整信息对比角度”);

- 输出最终结果。

这一步让模型先学会“检索该怎么推理”,避免RL训练时跑偏。

- • 阶段3:课程奖励RL增强:用GRPO算法训练,但设计了一个“渐进式奖励”:

- • 奖励包含两部分:结果准确率(有没有找对)+ 效率(少调用完整token);

- • 效率权重λ从0逐渐增加到1:训练初期让模型优先保证准确率,后期再强调效率。

这就像科研任务:初期先把实验做对,熟练后再优化流程提效率,避免一开始就追求速度而犯低级错误。

四、实验验证:准确率和效率双突破,泛化性拉满

作者在16张A100上做了全面实验,无论是核心指标还是泛化能力,都证明了方案的有效性—。

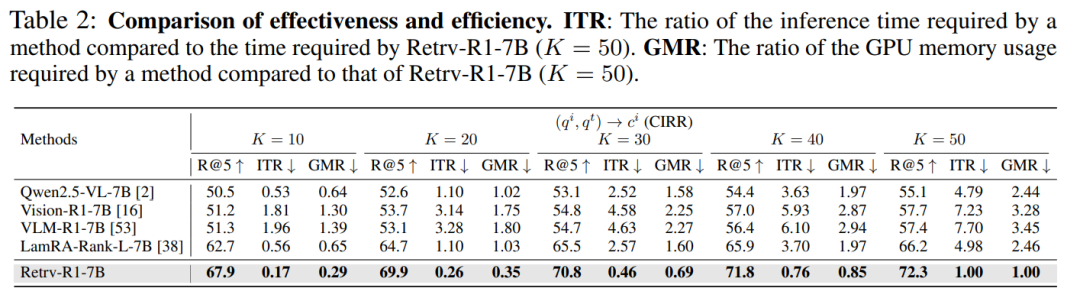

1. 核心指标:M-BEIR数据集SOTA

在包含16个亚任务的多模态检索基准M-BEIR上,Retrv-R1-7B在K=50时的R@5达到72.3,比之前的SOTA模型LamRA高6.1个百分点;而推理时间只有1秒,是Qwen2.5-VL的1/4.79,GPU内存占用也只有后者的1/2.44。

更关键的是,即使是3B参数的Retrv-R1-3B,也能超过7B参数的LamRA——这说明“推理驱动+信息压缩”的架构,比单纯堆参数更有效。在“图文混合查图像”这种最难的任务上,Retrv-R1的优势更明显,R@5比Vision-R1高14.6个百分点,因为它能通过推理排除角度、时间等干扰因素。

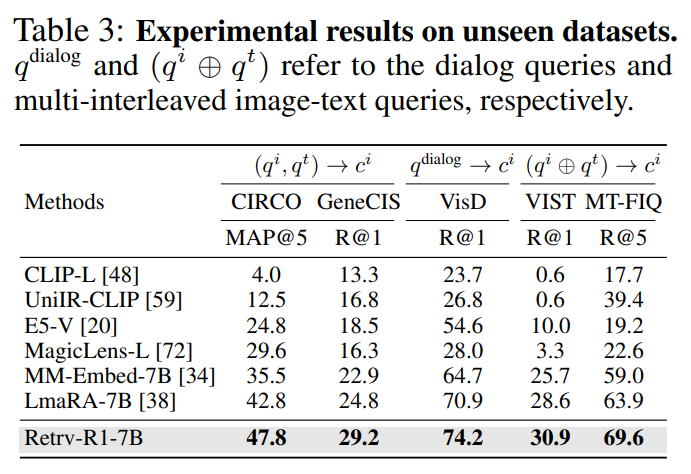

2. 泛化性:跨任务、跨数据集都能打

- 不可见数据集:在没训练过的对话检索、 interleaved图文检索任务上,Retrv-R1的R@5比基线模型高10个百分点以上,说明它学到的推理能力可以迁移。

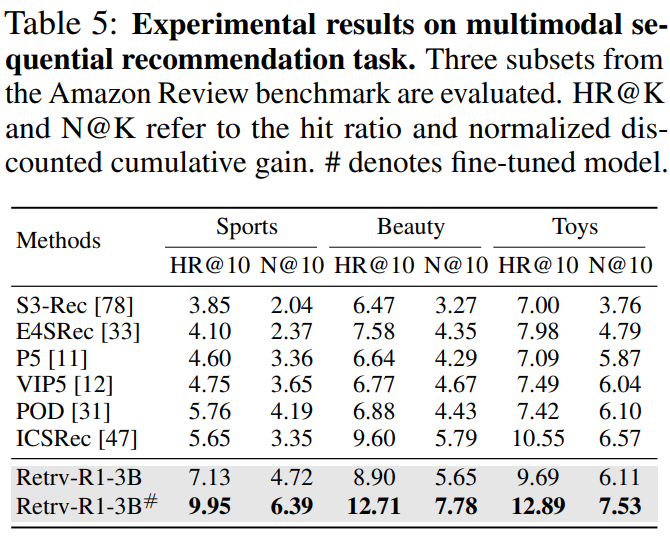

- 推荐系统任务:把Retrv-R1用到多模态推荐上,不用改模型结构,只调整输入指令,HR@10就达到12.71,比专门的推荐模型ICSRec高3.11个百分点——这意味着它不仅能做检索,还能适配需要关联匹配的其他任务。

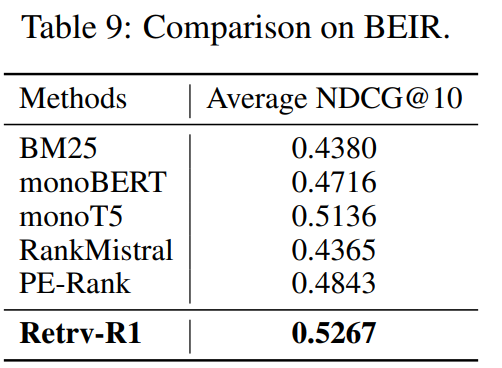

- 文本检索任务:在BEIR文本检索基准上,Retrv-R1的平均NDCG@10达到0.5267,超过专门的文本检索模型,证明它的框架是“通用”的,不是只适用于多模态。

3. 消融实验:关键模块不可或缺

作者做的消融实验,也验证了我们之前的猜想:

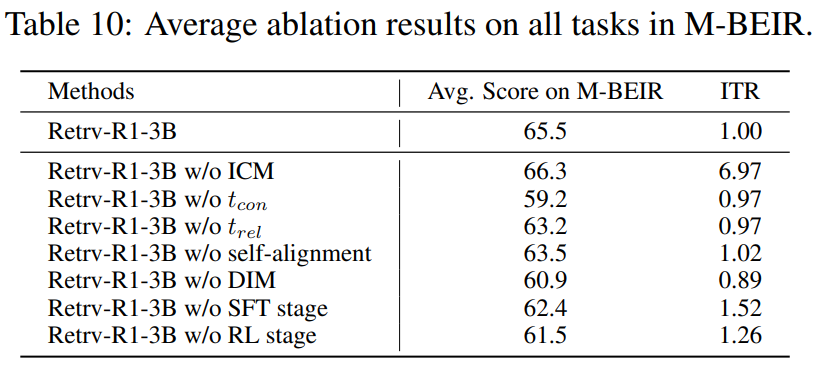

- 去掉ICM:推理时间增加7倍,R@5只提升0.9个百分点,完全得不偿失;

- 去掉细节检查机制:R@5下降5.6个百分点,说明难样本的完整信息对准确率至关重要;

- 跳过SFT直接RL:模型收敛不了,R@5下降6.8个百分点,证明“先激活推理能力”是必要的;

- 不用课程奖励:R@5下降4.2个百分点,说明渐进式优化能平衡准确率和效率。

五、落地前景与挑战:谁该用Retrv-R1?

这篇研究的价值,不仅在于提出了一个SOTA模型,更在于提供了一套“推理驱动检索”的工程化方案——无论是科研团队还是产业界,都能值得借鉴:

1. 适用场景

- 搜索引擎:处理图文混合查询、跨模态检索(比如“找一个和这段文字描述相符的视频片段”);

- 推荐系统:多模态商品推荐、内容推荐(比如根据用户浏览的图文内容,推荐相关视频);

- RAG应用:处理多模态知识库检索(比如在包含论文、图表、数据的知识库中,查找相关信息);

- 低资源场景:3B参数的Retrv-R1性能就足够强,中小团队不用堆大算力也能部署。

2. 现存挑战

- 轻微性能损失:ICM压缩会导致部分场景的R@5下降0.9%-1.1%,虽然效率提升7倍,但对极致准确率场景(比如医疗检索)可能需要权衡;

- 合成数据依赖:SFT阶段依赖Qwen2.5-VL-72B生成CoT数据,没有大模型的团队可能难以复现——不过作者提供了详细的生成prompt,用其他大模型也能尝试;

- 长视频检索适配:目前实验主要针对图像和文本,长视频的token压缩和推理逻辑可能需要进一步优化。

六、总结:推理驱动检索的未来方向

Retrv-R1的成功,本质上是“任务适配”的胜利——它没有盲目跟风大模型堆参数,而是针对检索任务的“效率+准确率”核心需求,做了精准的架构和训练优化。这给我们的启发是:未来的多模态检索,不再是“嵌入匹配”或“单纯推理”的二选一,而是“高效筛选+精准推理”的结合。

对于科研人员来说,这篇论文提供了两个可复用的思路:一是用“压缩+按需解压”解决多模态信息冗余问题;二是用“合成CoT激活+课程RL”解决检索模型的训练不稳定问题。对于产业界来说,Retrv-R1的工程化成本低,3B参数版本就能满足大部分场景需求,部署门槛远低于其他大模型检索方案。

最后想问大家:你们在做检索模型时,是否遇到过token爆炸或训练不收敛的问题?如果用Retrv-R1的方案,你觉得最需要调整的是哪个模块?欢迎在评论区交流你的复现经验或改进思路!

如何高效转型Al大模型领域?

作为一名在一线互联网行业奋斗多年的老兵,我深知持续学习和进步的重要性,尤其是在复杂且深入的Al大模型开发领域。为什么精准学习如此关键?

- 系统的技术路线图:帮助你从入门到精通,明确所需掌握的知识点。

- 高效有序的学习路径:避免无效学习,节省时间,提升效率。

- 完整的知识体系:建立系统的知识框架,为职业发展打下坚实基础。

AI大模型从业者的核心竞争力

- 持续学习能力:Al技术日新月异,保持学习是关键。

- 跨领域思维:Al大模型需要结合业务场景,具备跨领域思考能力的从业者更受欢迎。

- 解决问题的能力:AI大模型的应用需要解决实际问题,你的编程经验将大放异彩。

以前总有人问我说:老师能不能帮我预测预测将来的风口在哪里?

现在没什么可说了,一定是Al;我们国家已经提出来:算力即国力!

未来已来,大模型在未来必然走向人类的生活中,无论你是前端,后端还是数据分析,都可以在这个领域上来,我还是那句话,在大语言AI模型时代,只要你有想法,你就有结果!只要你愿意去学习,你就能卷动的过别人!

现在,你需要的只是一份清晰的转型计划和一群志同道合的伙伴。作为一名热心肠的互联网老兵,我决定把宝贵的AI知识分享给大家。 至于能学习到多少就看你的学习毅力和能力了 。

第一阶段(10天):初阶应用

该阶段让大家对大模型 AI有一个最前沿的认识,对大模型 AI 的理解超过 95% 的人,可以在相关讨论时发表高级、不跟风、又接地气的见解,别人只会和 AI 聊天,而你能调教 AI,并能用代码将大模型和业务衔接。

- 大模型 AI 能干什么?

- 大模型是怎样获得「智能」的?

- 用好 AI 的核心心法

- 大模型应用业务架构

- 大模型应用技术架构

- 代码示例:向 GPT-3.5 灌入新知识

- 提示工程的意义和核心思想

- Prompt 典型构成

- 指令调优方法论

- 思维链和思维树

- Prompt 攻击和防范

- …

第二阶段(30天):高阶应用

该阶段我们正式进入大模型 AI 进阶实战学习,学会构造私有知识库,扩展 AI 的能力。快速开发一个完整的基于 agent 对话机器人。掌握功能最强的大模型开发框架,抓住最新的技术进展,适合 Python 和 JavaScript 程序员。

- 为什么要做 RAG

- 搭建一个简单的 ChatPDF

- 检索的基础概念

- 什么是向量表示(Embeddings)

- 向量数据库与向量检索

- 基于向量检索的 RAG

- 搭建 RAG 系统的扩展知识

- 混合检索与 RAG-Fusion 简介

- 向量模型本地部署

- …

第三阶段(30天):模型训练

恭喜你,如果学到这里,你基本可以找到一份大模型 AI相关的工作,自己也能训练 GPT 了!通过微调,训练自己的垂直大模型,能独立训练开源多模态大模型,掌握更多技术方案。

到此为止,大概2个月的时间。你已经成为了一名“AI小子”。那么你还想往下探索吗?

- 为什么要做 RAG

- 什么是模型

- 什么是模型训练

- 求解器 & 损失函数简介

- 小实验2:手写一个简单的神经网络并训练它

- 什么是训练/预训练/微调/轻量化微调

- Transformer结构简介

- 轻量化微调

- 实验数据集的构建

- …

第四阶段(20天):商业闭环

对全球大模型从性能、吞吐量、成本等方面有一定的认知,可以在云端和本地等多种环境下部署大模型,找到适合自己的项目/创业方向,做一名被 AI 武装的产品经理。

- 硬件选型

- 带你了解全球大模型

- 使用国产大模型服务

- 搭建 OpenAI 代理

- 热身:基于阿里云 PAI 部署 Stable Diffusion

- 在本地计算机运行大模型

- 大模型的私有化部署

- 基于 vLLM 部署大模型

- 案例:如何优雅地在阿里云私有部署开源大模型

- 部署一套开源 LLM 项目

- 内容安全

- 互联网信息服务算法备案

- …

学习是一个过程,只要学习就会有挑战。天道酬勤,你越努力,就会成为越优秀的自己。

如果你能在15天内完成所有的任务,那你堪称天才。然而,如果你能完成 60-70% 的内容,你就已经开始具备成为一名大模型 AI 的正确特征了。

这份完整版的大模型 AI 学习资料已经上传优快云,朋友们如果需要可以微信扫描下方优快云官方认证二维码免费领取【保证100%免费】

1105

1105

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?