HuggingFace还是CSGHub?AI平台选型终极指南

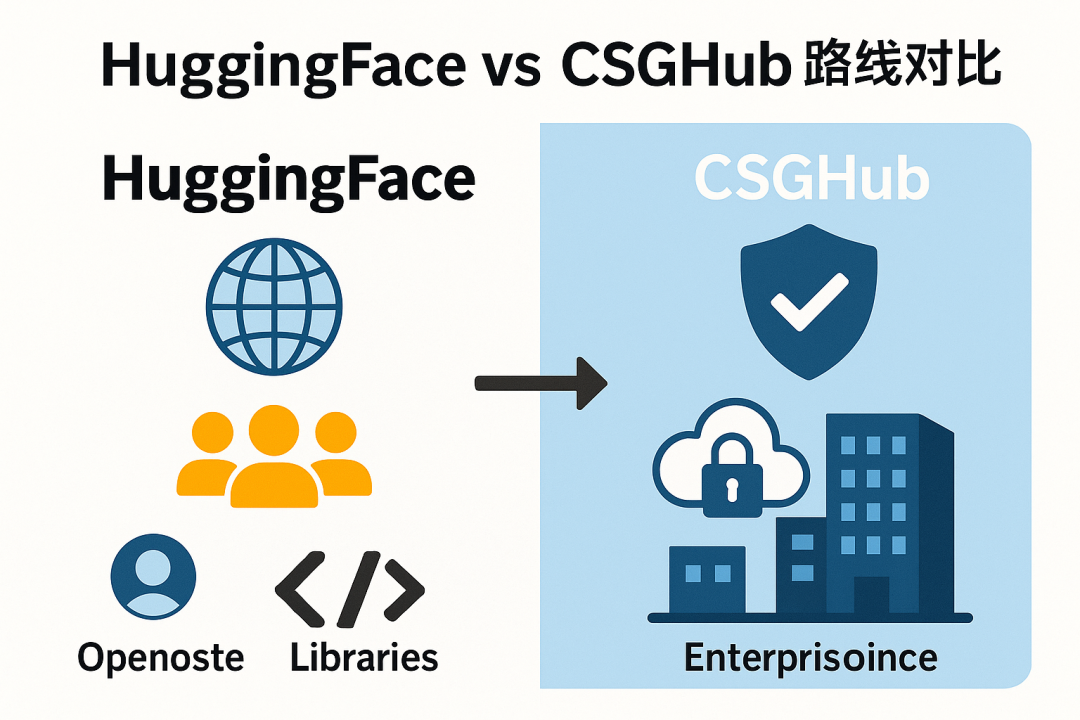

在人工智能领域,HuggingFace 和 CSGHub 代表了两种不同的平台理念与发展路径。

HuggingFace 以开放社区为核心,构建了庞大的AI资源生态,涵盖海量模型、数据集及工具库。其通过标准化框架和云原生部署,显著降低了AI应用门槛,推动了技术民主化。

CSGHub 则聚焦企业需求,主打私有化部署与AI资产管理。它在兼容 HuggingFace 工作流的基础上,重点解决了企业在数据主权、安全合规和内部管控方面的痛点,支持多源同步与私有化部署,为客户提供安全可控的内部AI环境。

两者并非竞争关系,而是互补选择:

如追求技术前沿、社区资源与开放协作,HuggingFace 更为合适;如优先考虑数据安全、私有化部署与企业级管控,CSGHub 更具优势。

最终选择取决于组织的核心诉求:是拥抱开放生态,还是强化内部管控。

随着人工智能技术的快速发展,全球范围内涌现出众多AI社区,成为推动创新与技术演进的重要力量。在这片充满活力的领域中,OpenCSG 社区凭借其独特优势逐渐崭露头角,目前已成长为全球第二大 AI 模型生态社区,规模仅次于 HuggingFace。

HuggingFace 还是 CSGHub?最终选择并非取决于技术本身,而更多取决于组织的根本诉求:是优先拥抱开放、共享与快速迭代的社区生态,还是更需要安全、可控、合规的企业级私有化环境。没有绝对的“更好”,只有“更合适”。在AI落地的道路上,明确自身的战略与边界,才能做出最明智的选择。

HuggingFace生态系统:一个全面的基准

HuggingFace 通过构建多层次、全栈化的开源生态系统,已成为AI开发领域的事实标准。

其核心能力体现在以下五个方面:

1. Hub资源生态

托管超过170万个模型、40万个数据集和60万个演示应用(Spaces),全部采用Git版本控制。通过模型卡片和门控机制平衡开放性与合规性,形成“资源增长-用户增加-内容产出”的自我强化循环。Meta、Google等企业的参与进一步强化了网络效应。

2. 标准化开发工具链

以Transformers库为核心统一模型架构与调用规范,提供Pipeline、Trainer等高级抽象。通过与Diffusers、Datasets、Tokenizers等工具库深度集成,形成高度协同的开源生态,显著降低开发门槛。

3. 多层次推理服务

- 免费交互式Widget和本地Pipeline API

- 无服务器推理服务:集成20万+模型,按需付费,兼容OpenAI接口

- 专业托管端点(Inference Endpoints):提供专属硬件部署,与AWS/Azure深度集成

- 专有大模型推理工具包(TGI/TEI)支持高并发场景

4. 应用开发与数据工具

- 通过Gradio/Streamlit快速构建交互应用,Spaces实现一键部署

- AutoTrain提供无代码模型微调

- Argilla支持协作数据标注,Distilabel提供合成数据生成

- 开发智能体框架(smolagents)和开源聊天界面(HuggingChat)

CSGHub的独特价值主张

1. 私有化部署与数据主权:核心差异化优势

CSGHub以私有化部署为核心价值主张,精准切入了HuggingFace生态的空白领域。其技术实现采用微服务架构(包含门户、Git后端、对象存储等模块),通过Docker Compose和Helm Charts支持Kubernetes环境部署,严格遵循"不依赖互联网和云厂商"的设计原则。这一特性从根本上重构了AI平台的价值逻辑——对政府、金融等受监管行业而言,CSGHub将HuggingFace的全球社区优势转化为可控资产:物理隔离的部署方式虽然牺牲了开放创新,但换取了绝对的数据主权和合规保障。这种战略定位使CSGHub成为"安全优先"企业的必然选择,其本质是提供了一种与HuggingFace截然不同的技术治理范式。

2. 多源同步

多源同步是CSGHub提供的一项极具战略价值的功能,它充当了连接公共AI世界与私有企业环境的桥梁。

功能描述:

CSGHub支持“配置和启用远程仓库以进行自动数据同步”,并明确提到了如OpenCSG社区和HuggingFace等数据源。

应用场景:

该功能允许企业创建一个经过策划和审查的内部“镜像”公共模型中心。企业的内部MLOps团队可以从OpenCSG等公共平台上筛选、验证和批准模型,然后将它们同步到私有的CSGHub实例中,再提供给内部开发者使用。

战略价值:

此功能解决了私有Hub面临的“冷启动”问题,为其提供了填充有价值资产的机制。它使企业能够在不直接暴露其内部基础设施的情况下,安全地利用全球社区的创新成果。这是作为主要源头的HuggingFace没有动力去构建的功能。

3. 新兴的以企业为中心的功能

企业级安全与权限管理:

CSGHub 在设计上深度融合了企业IT与安全团队的核心诉求,提供包括细粒度权限控制、完整的安全合规审计链路以及与现有企业身份系统的无缝集成。平台支持对内部AI资产进行精确的访问管理,确保敏感数据仅在授权范围内共享,同时所有操作行为均可追溯、可审计,满足金融、政务等高监管行业的合规要求。

深度融合与原生管控:

尽管 HuggingFace 也通过其企业版产品提供部分安全功能,但对 CSGHub 而言,企业级安全与管控能力从架构设计之初就是产品的核心基因与默认能力。这种原生化的设计使其在私有化部署环境中能够提供更彻底的数据隔离和更灵活的管控策略配置。

结论

HuggingFace和CSGHub并非简单的功能优劣之争,而是代表了两种不同的AI平台发展哲学和市场定位。为技术领导者提供以下参考选择:

HuggingFace:开放创新的首选平台

适用场景:当组织希望快速跟进全球前沿开源AI技术、吸引和赋能顶尖AI人才,并融入活跃的全球协作生态时,HuggingFace是理想的选择。其丰富的模型与数据集资源、成熟的工具链以及低门槛的协作环境,特别适合研究探索与快速原型开发。

布局视角:选择HuggingFace意味着拥抱开放与共享,同时也需接受其云原生、多租户的服务模式。企业可通过付费计划获得更强的安全性、技术支持与协作功能,但核心基础设施仍由平台托管。

CSGHub:数据主权与企业自主的核心选项

适用场景:当组织面临严格的数据合规要求、处理高敏感专有数据,或需在隔离内网中开展AI研发时,CSGHub的私有化部署能力成为关键优势。尤其适用于金融、政务、医疗、国防等对数据管控有严苛需求的行业。

布局视角:选择CSGHub代表将数据主权与管控权放在首位。其多源同步机制支持企业在封闭环境中可控地引入外部资源,集成的提示词管理等工具则进一步优化了内部大模型研发流程。

采用CSGHub是一项关键投入,旨在构建安全、合规、自主可控的企业级AI基础设施。

决策者应基于以下核心问题进行权衡:

- 数据与安全:我们的数据能否离开自有环境?我们面临哪些合规性要求?

- 创新与社区:我们是希望从全球社区中汲取养分,还是希望在一个受控环境中进行内部创新?

- 控制与便利:我们是需要对底层基础设施有完全的控制权,还是更看重云平台提供的便利性和托管服务?

总而言之,HuggingFace是全球AI社区的公共广场和标准制定者,而CSGHub则是一个为企业构建私有、安全的AI堡垒而设计的专业工具。

关于 CSGHub

CSGHub 是由OpenCSG推出的企业级模型与数据资产管理平台,旨在为组织提供 Hugging Face 式的高效协作体验,同时满足本地化部署、数据安全与法规合规。平台支持与 Hugging Face 工作流无缝兼容,并提供多源同步、私有镜像、全离线运行等特性,帮助企业在安全可控的环境中实现 AI 研发与部署的全生命周期管理。

官网链接:https://opencsg.com/csghub

开源项目地址:https://github.com/OpenCSGs/CSGHub

1215

1215

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?