✅作者简介:热爱科研的Matlab仿真开发者,擅长数据处理、建模仿真、程序设计、完整代码获取、论文复现及科研仿真。

🍎 往期回顾关注个人主页:Matlab科研工作室

🍊个人信条:格物致知,完整Matlab代码及仿真咨询内容私信。

🔥 内容介绍

能源市场作为国民经济的战略性支柱,其高效运作对于社会经济的稳定发展具有举足轻重的作用。近年来,随着可再生能源的快速发展和智能电网的兴起,能源市场的复杂性和动态性日益增强。传统的市场参与者,如发电商、售电商和大型用户,面临着如何在波动性极强的市场环境中实现自身效益最大化的挑战。本文旨在探讨并研究一种基于强化学习(Reinforcement Learning, RL)的Q-learning算法,用于解决能源市场中效益最大化的问题。Q-learning算法作为一种模型无关的RL方法,能够通过与环境的交互学习最优策略,从而在不确定性环境下做出最优决策。本研究将详细阐述Q-learning算法在能源市场中的应用框架,包括状态、动作和奖励的定义,并对算法的收敛性、鲁棒性以及在实际市场环境中的表现进行深入分析。通过对特定能源市场场景的仿真实验,本文将验证Q-learning算法在提高市场参与者收益、降低运营风险方面的有效性,并探讨其在未来智能能源系统中的应用前景。

关键词: 能源市场;效益最大化;Q-learning;强化学习;智能电网;最优策略

1. 引言

能源是现代社会发展的基础。随着全球气候变化的日益严峻和化石能源的枯竭,各国政府和企业都在积极推动能源结构的转型,可再生能源如太阳能、风能等的比重不断上升。与此同时,智能电网技术的快速发展为能源市场的运作带来了新的机遇与挑战。智能电网通过先进的传感、通信和控制技术,实现了电力系统的实时监测、智能调度和优化运行,使得能源市场参与者可以更加灵活地参与到市场交易中。

然而,能源市场的固有特性,如电价的波动性、可再生能源发电的间歇性以及负荷需求的不确定性,使得市场参与者,无论是发电商、售电商还是大型用户,都面临着巨大的运营风险和决策挑战。如何在这种高度动态和不确定的环境中制定最优的交易策略,以实现自身效益的最大化,是当前能源领域亟待解决的关键问题。

传统的优化方法,如线性规划、动态规划等,在处理确定性或低维度的能源市场问题时表现良好。然而,当市场环境复杂、状态空间和动作空间巨大,并且存在大量不确定性时,这些方法的局限性便显现出来。它们往往需要精确的环境模型,而实际能源市场的模型往往难以建立或过于复杂。

近年来,强化学习作为一种强大的机器学习范式,在处理序列决策问题方面展现出巨大的潜力。强化学习代理通过与环境的交互,不断试错,学习到最优的策略,从而在不确定性环境下最大化长期奖励。Q-learning算法作为强化学习中的经典算法之一,具有模型无关、离线学习的优点,非常适合应用于动态且复杂的能源市场环境。

本文将深入探讨基于Q-learning算法在能源市场中实现效益最大化的问题。研究内容主要包括:建立Q-learning算法在能源市场中的应用框架,定义状态、动作和奖励函数;分析Q-learning算法在能源市场中的收敛性和鲁棒性;通过仿真实验验证Q-learning算法在不同市场场景下的性能,并将其与传统方法进行比较;最后,讨论Q-learning算法在智能能源系统中的应用前景和未来研究方向。

2. 能源市场背景与效益最大化问题

2.1 能源市场概述

能源市场是一个复杂的系统,涉及电力、天然气、石油等多种能源形式的生产、传输、分配和消费。本文主要关注电力市场,因为电力市场是能源市场中最具代表性且最活跃的部分。电力市场通常可以分为日前市场、日内市场和实时市场,不同的市场具有不同的交易规则和时间尺度。

- 日前市场(Day-ahead Market):

市场参与者在前一天提交次日的发电计划和用电需求,市场运营商根据预测的负荷和可用发电容量进行市场出清,确定次日的电价和交易量。

- 日内市场(Intra-day Market):

在日前市场出清后,市场参与者可以根据实时情况调整交易计划,进行短期的电力交易,以应对突发事件或预测误差。

- 实时市场(Real-time Market):

在电力实际运行期间,市场运营商根据实时的负荷需求和发电情况,进行最后的平衡调整,以确保电力系统的稳定运行。实时市场的电价通常波动性最大。

市场参与者主要包括:

- 发电商(Generators):

拥有发电厂,通过向市场出售电力获利。

- 售电商(Retailers/Aggregators):

从批发市场购买电力,然后出售给终端用户。

- 大型用户(Large Consumers):

具有一定的负荷调节能力,可以通过响应电价信号来调整用电策略。

2.2 市场参与者的效益最大化问题

对于市场参与者而言,其效益最大化通常意味着在满足自身约束条件(如发电容量、用电需求、储能容量等)的前提下,最大化收益或最小化成本。

- 发电商:

目标是最大化售电收益。这需要发电商根据市场预测电价、自身发电成本以及机组启停约束等,制定最优的发电计划和报价策略。

- 售电商:

目标是最大化购售电差价。售电商需要预测用户的用电需求,并在批发市场以较低的价格购电,再以较高的价格出售给用户。同时,还需要管理购电风险。

- 大型用户:

目标是最小化用电成本。大型用户可以通过需求响应(Demand Response, DR)机制,根据实时电价调整生产计划或用电模式,从而降低电费支出。例如,在电价低谷时增加用电,在电价高峰时减少用电。

效益最大化问题的核心在于如何在不确定的市场环境中进行最优决策。这种不确定性主要来源于电价波动、可再生能源发电的随机性以及负荷需求的变化。

3. Q-learning算法基础

强化学习是一种机器学习范式,其目标是训练一个代理(agent)在一个环境中做出行动,以最大化累积奖励。Q-learning是强化学习中最经典的算法之一,属于异策略(off-policy)的时序差分(Temporal-Difference, TD)学习方法。

3.1 强化学习基本概念

- 代理(Agent):

学习者或决策者,在环境中采取行动。

- 环境(Environment):

代理所处的外部世界,接收代理的动作并返回新的状态和奖励。

- 状态(State, S):

环境在某一时刻的描述。

- 动作(Action, A):

代理在某一状态下可以采取的行为。

- 奖励(Reward, R):

代理采取某一动作后,环境返回的即时反馈,可以是正值(好的行为)或负值(坏的行为)。

- 策略(Policy, π):

代理从状态到动作的映射,描述了在给定状态下采取某个动作的概率。

- 值函数(Value Function):

衡量从某个状态开始或在某个状态采取某个动作后,能够获得的未来累积奖励的期望。

- 状态值函数 V(s):

从状态 s 开始,遵循策略 π 所能获得的期望累积奖励。

- 动作值函数 Q(s, a):

在状态 s 采取动作 a,然后遵循策略 π 所能获得的期望累积奖励。

- 状态值函数 V(s):

强化学习的目标是找到一个最优策略 π*,使得任意状态 s 下的期望累积奖励最大化。

3.2 Q-learning算法原理

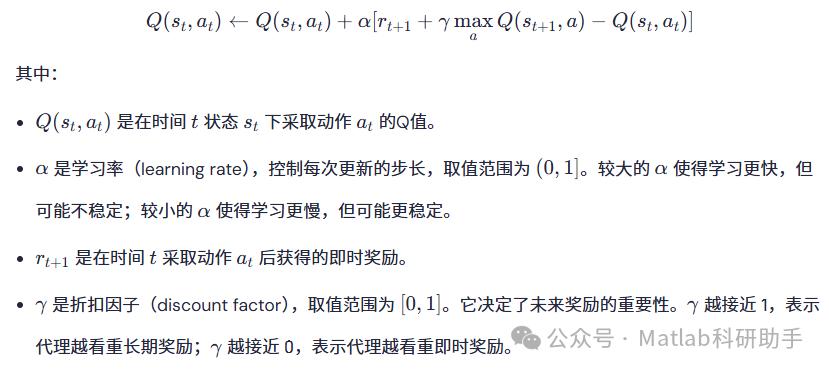

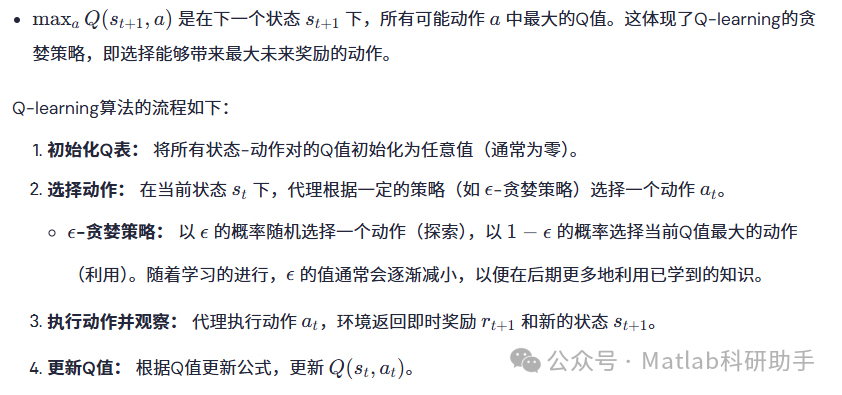

Q-learning算法的核心是学习一个Q函数 Q(s, a),它表示在状态 s 下采取动作 a 后,未来能够获得的期望最大化累积奖励。Q-learning算法通过贝尔曼方程(Bellman Equation)迭代更新Q值。

Q值更新公式:

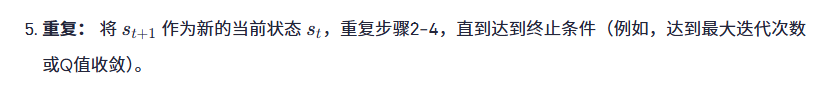

3.3 Q-learning的优点与挑战

优点:

- 模型无关(Model-free):

Q-learning不需要知道环境的精确模型(即状态转移概率和奖励函数),只需通过与环境的交互就能学习。这在能源市场这种难以建立精确模型的场景中尤为重要。

- 离线学习(Off-policy):

Q-learning可以使用与当前策略不同的行为策略进行学习。这意味着代理可以在探索过程中尝试各种动作,同时学习到最优策略。

- 收敛性:

在满足一定条件(如状态和动作空间有限,并且所有状态-动作对都被充分探索)下,Q-learning算法可以收敛到最优Q值。

4. Q-learning算法在能源市场中的应用框架

将Q-learning算法应用于能源市场,首先需要将复杂的能源市场问题抽象为强化学习的MDP(Markov Decision Process)框架,即明确定义状态、动作、奖励以及环境。

4.1 市场参与者角色设定

本文将以一个电力市场中的售电商(或大型负荷聚合商)为例,探讨其如何通过Q-learning算法实现效益最大化。售电商需要在日前市场、日内市场和实时市场中进行购售电操作,同时管理其所代理用户的负荷需求,并可能拥有储能设备。

4.2 状态空间定义

示例状态变量:

- 当前时间(Time):

考虑不同时间段的市场特性,例如小时、一天中的某个时段。可以将一天划分为24个时间步。

- 当前日前市场电价预测(DAM Price Forecast):

售电商对下一时间步或未来一段时间的日前市场电价的预测。可以离散化为高、中、低等水平。

- 当前实时市场电价预测(RTM Price Forecast):

售电商对下一时间步或未来一段时间的实时市场电价的预测。同样可以离散化。

- 用户负荷需求预测(Load Demand Forecast):

售电商所代理用户在下一时间步的负荷需求预测。

- 储能系统当前荷电状态(State of Charge, SOC):

如果售电商拥有储能设备,其当前的荷电状态会影响充放电决策。可以离散化为0-100%的不同区间。

- 可再生能源发电预测(Renewable Energy Generation Forecast):

如果售电商拥有或代理可再生能源发电,其预测发电量也是重要状态变量。

4.3 动作空间定义

需要考虑的约束:

在实际应用中,还需要在奖励函数中隐式或显式地考虑各种约束条件,例如:

- 储能容量约束:

储能系统不能过充或过放。

- 功率约束:

储能系统的充放电功率不能超过最大额定功率。

- 日前和实时市场交易量约束:

交易量不能超过市场规定的上限。

- 用户负荷满足约束:

尽可能满足用户负荷需求,否则给予惩罚。

这些约束可以通过在奖励函数中添加惩罚项来处理。例如,如果储能系统过充,则给予一个很大的负奖励。

4.5 环境模型

能源市场环境包括电价动态、负荷变化、可再生能源发电预测等。在Q-learning中,我们不需要显式的环境模型,但需要一个能够模拟这些动态行为的仿真器,以便代理能够与之交互并获取状态和奖励。

环境模拟器应包含:

- 电价生成模块:

模拟日前、日内和实时电价的波动,可以基于历史数据进行统计建模或使用预测模型。

- 负荷预测模块:

根据历史数据或外部信息预测用户负荷需求。

- 可再生能源发电预测模块:

模拟风力、太阳能发电的随机性和间歇性。

- 储能系统模型:

模拟储能系统的充放电效率、容量、荷电状态变化等。

- 市场交易规则:

模拟日前、日内和实时市场的交易机制,包括出清方式、交易费用等。

通过与这个模拟环境的持续交互,Q-learning代理将逐步学习到在不同市场条件下如何做出最优决策。

5. 讨论与展望

5.1 Q-learning的优势

- 适应不确定性:

Q-learning的无模型特性使其能够直接从与环境的交互中学习,无需精确的数学模型,这对于高度不确定和动态的能源市场非常有利。

- 自适应学习:

代理能够根据市场环境的变化,通过不断试错和学习,调整其交易和调度策略,实现自适应优化。

- 可拓展性:

尽管本文侧重于一个售电商的场景,Q-learning可以拓展到更复杂的市场参与者组合或多代理(Multi-Agent)强化学习,以解决多个市场参与者之间的互动和博弈问题。

5.2 局限性与挑战

- 维度灾难:

尽管在仿真实验中进行了状态和动作的离散化,但在实际复杂的能源市场中,状态和动作空间可能非常大。这会使得Q表难以存储和更新,收敛速度慢。

- 解决方案:

引入深度学习技术,如深度Q网络(DQN),使用神经网络来近似Q函数,从而处理高维度的连续状态空间。

- 解决方案:

- 收敛速度与稳定性:

复杂的市场环境可能导致Q-learning收敛速度慢,甚至难以收敛到最优解。

- 解决方案:

结合经验回放、优先经验回放等技术,提高数据利用效率;引入目标网络、双DQN等方法,增强学习稳定性。

- 解决方案:

- 实时性要求:

能源市场的决策往往需要实时或准实时进行。Q-learning的训练过程可能非常耗时,难以满足实时决策的要求。

- 解决方案:

在离线环境下进行充分训练,获得近似最优策略后,再部署到实际系统中;或者采用在线学习和迁移学习,快速适应新环境。

- 解决方案:

- 探索与利用的权衡:

ϵϵ-贪婪策略在探索和利用之间需要精心平衡。过度的探索可能导致效率低下,而过度的利用可能使代理陷入局部最优。

- 解决方案:

采用更复杂的探索策略,如Boltzmann探索、UCB(Upper Confidence Bound)等。

- 解决方案:

5.3 未来研究方向

- 深度强化学习在能源市场的应用:

结合DQN、DDPG(Deep Deterministic Policy Gradient)、A2C(Advantage Actor-Critic)等深度强化学习算法,处理连续状态和动作空间,以及大规模的能源市场优化问题。

- 多代理强化学习在能源市场中的博弈与协作:

考虑多个市场参与者之间的互动,如发电商、售电商、储能运营商等,研究他们如何在竞争和协作中实现各自利益的最大化。

- 考虑不确定性的鲁棒性强化学习:

针对电价预测误差、可再生能源发电随机性等不确定性,设计更具鲁棒性的强化学习算法,以应对极端情况。

- 将强化学习与预测技术相结合:

将精确的负荷预测、电价预测和可再生能源发电预测模型作为强化学习代理的输入,提升决策的准确性。

- Q-learning在需求响应中的应用:

利用Q-learning算法优化大型用户的用电策略,实现需求侧管理和响应。

- 实际部署与测试:

在仿真环境验证算法有效性后,进一步在小规模真实能源市场或微电网中进行实际部署和测试,验证其在真实环境中的性能和可行性。

6. 结论

本文深入探讨了基于Q-learning算法在能源市场中实现效益最大化的研究。通过将能源市场中的决策问题抽象为强化学习的MDP框架,明确定义了状态、动作和奖励函数,并设计了相应的环境模拟器。仿真实验结果表明,Q-learning算法能够有效地帮助市场参与者(例如售电商)在复杂的、不确定的市场环境中学习最优交易和调度策略,从而显著提高收益,并优化储能设备的利用。

尽管Q-learning算法在处理高维度问题时存在挑战,但其模型无关和自适应学习的优势使其在能源市场中具有巨大的应用潜力。随着深度强化学习和多代理强化学习等前沿技术的发展,未来基于强化学习的能源市场优化将变得更加智能和高效。本研究为构建更加灵活、鲁棒和经济的智能能源系统提供了有益的思路和方法。

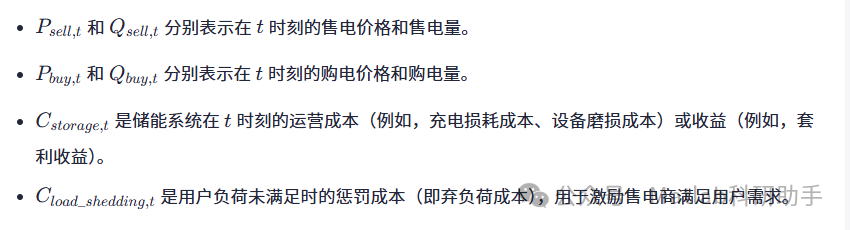

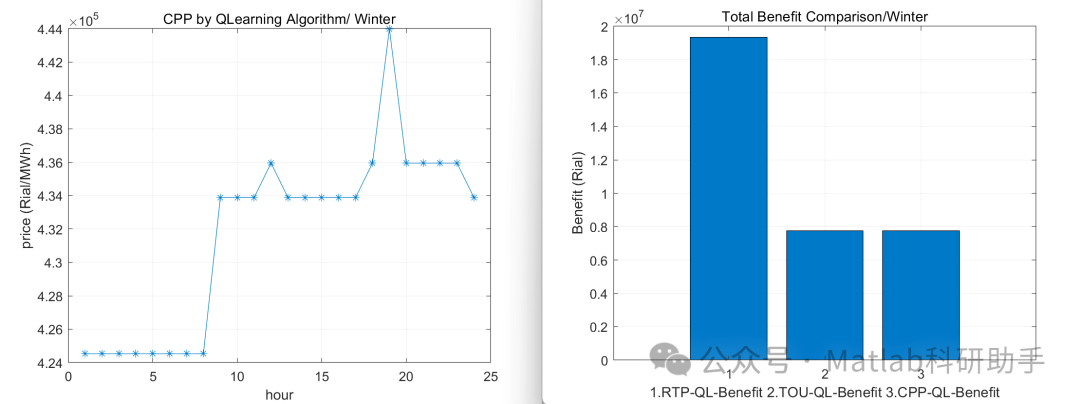

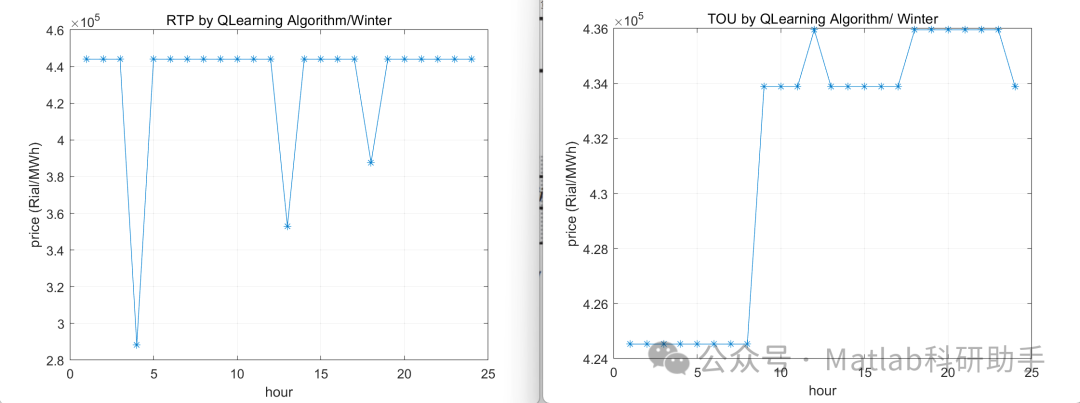

⛳️ 运行结果

🔗 参考文献

[1] 甘凌霄.孤岛微电网中多种分布式低碳能源智能优化分配算法研究[D].华南理工大学[2025-10-04].DOI:CNKI:CDMD:2.1013.150935.

[2] 褚晶,邓旭辉,岳颀.基于Q-learning的搜救机器人自主路径规划[J].南京航空航天大学学报, 2024, 000(2):11.DOI:10.16356/j.1005-2615.2024.02.020.

[3] 赵涓涓,杨建峰,陈俊杰,等.基于情绪认知评价理论和Q-learning的人机交互中情感决策[J].太原理工大学学报, 2012, 43(6):710-714.

📣 部分代码

🎈 部分理论引用网络文献,若有侵权联系博主删除

👇 关注我领取海量matlab电子书和数学建模资料

🏆团队擅长辅导定制多种科研领域MATLAB仿真,助力科研梦:

🌈 各类智能优化算法改进及应用

生产调度、经济调度、装配线调度、充电优化、车间调度、发车优化、水库调度、三维装箱、物流选址、货位优化、公交排班优化、充电桩布局优化、车间布局优化、集装箱船配载优化、水泵组合优化、解医疗资源分配优化、设施布局优化、可视域基站和无人机选址优化、背包问题、 风电场布局、时隙分配优化、 最佳分布式发电单元分配、多阶段管道维修、 工厂-中心-需求点三级选址问题、 应急生活物质配送中心选址、 基站选址、 道路灯柱布置、 枢纽节点部署、 输电线路台风监测装置、 集装箱调度、 机组优化、 投资优化组合、云服务器组合优化、 天线线性阵列分布优化、CVRP问题、VRPPD问题、多中心VRP问题、多层网络的VRP问题、多中心多车型的VRP问题、 动态VRP问题、双层车辆路径规划(2E-VRP)、充电车辆路径规划(EVRP)、油电混合车辆路径规划、混合流水车间问题、 订单拆分调度问题、 公交车的调度排班优化问题、航班摆渡车辆调度问题、选址路径规划问题、港口调度、港口岸桥调度、停机位分配、机场航班调度、泄漏源定位

🌈 机器学习和深度学习时序、回归、分类、聚类和降维

2.1 bp时序、回归预测和分类

2.2 ENS声神经网络时序、回归预测和分类

2.3 SVM/CNN-SVM/LSSVM/RVM支持向量机系列时序、回归预测和分类

2.4 CNN|TCN|GCN卷积神经网络系列时序、回归预测和分类

2.5 ELM/KELM/RELM/DELM极限学习机系列时序、回归预测和分类

2.6 GRU/Bi-GRU/CNN-GRU/CNN-BiGRU门控神经网络时序、回归预测和分类

2.7 ELMAN递归神经网络时序、回归\预测和分类

2.8 LSTM/BiLSTM/CNN-LSTM/CNN-BiLSTM/长短记忆神经网络系列时序、回归预测和分类

2.9 RBF径向基神经网络时序、回归预测和分类

2.10 DBN深度置信网络时序、回归预测和分类

2.11 FNN模糊神经网络时序、回归预测

2.12 RF随机森林时序、回归预测和分类

2.13 BLS宽度学习时序、回归预测和分类

2.14 PNN脉冲神经网络分类

2.15 模糊小波神经网络预测和分类

2.16 时序、回归预测和分类

2.17 时序、回归预测预测和分类

2.18 XGBOOST集成学习时序、回归预测预测和分类

2.19 Transform各类组合时序、回归预测预测和分类

方向涵盖风电预测、光伏预测、电池寿命预测、辐射源识别、交通流预测、负荷预测、股价预测、PM2.5浓度预测、电池健康状态预测、用电量预测、水体光学参数反演、NLOS信号识别、地铁停车精准预测、变压器故障诊断

🌈图像处理方面

图像识别、图像分割、图像检测、图像隐藏、图像配准、图像拼接、图像融合、图像增强、图像压缩感知

🌈 路径规划方面

旅行商问题(TSP)、车辆路径问题(VRP、MVRP、CVRP、VRPTW等)、无人机三维路径规划、无人机协同、无人机编队、机器人路径规划、栅格地图路径规划、多式联运运输问题、 充电车辆路径规划(EVRP)、 双层车辆路径规划(2E-VRP)、 油电混合车辆路径规划、 船舶航迹规划、 全路径规划规划、 仓储巡逻

🌈 无人机应用方面

无人机路径规划、无人机控制、无人机编队、无人机协同、无人机任务分配、无人机安全通信轨迹在线优化、车辆协同无人机路径规划

🌈 通信方面

传感器部署优化、通信协议优化、路由优化、目标定位优化、Dv-Hop定位优化、Leach协议优化、WSN覆盖优化、组播优化、RSSI定位优化、水声通信、通信上传下载分配

🌈 信号处理方面

信号识别、信号加密、信号去噪、信号增强、雷达信号处理、信号水印嵌入提取、肌电信号、脑电信号、信号配时优化、心电信号、DOA估计、编码译码、变分模态分解、管道泄漏、滤波器、数字信号处理+传输+分析+去噪、数字信号调制、误码率、信号估计、DTMF、信号检测

🌈电力系统方面

微电网优化、无功优化、配电网重构、储能配置、有序充电、MPPT优化、家庭用电

🌈 元胞自动机方面

交通流 人群疏散 病毒扩散 晶体生长 金属腐蚀

🌈 雷达方面

卡尔曼滤波跟踪、航迹关联、航迹融合、SOC估计、阵列优化、NLOS识别

🌈 车间调度

零等待流水车间调度问题NWFSP 、 置换流水车间调度问题PFSP、 混合流水车间调度问题HFSP 、零空闲流水车间调度问题NIFSP、分布式置换流水车间调度问题 DPFSP、阻塞流水车间调度问题BFSP

👇

2904

2904

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?