说明:每个节点上的Hadoop配置文件相同,所以在master节点配置hadoop文件夹,然后复制到slave01、slave02节点。

目录

master节点

#将/home/zkpk/tgz/hadoop目录下的Hadoop压缩包解压到/home/zkpk目录下

[zkpk@master ~]$ tar -xzvf /home/zkpk/tgz/hadoop/hadoop-2.7.3.tar.gz –C /home/zkpk

配置hadoop-env.sh文件

#使用gedit命令修改hadoop-env.sh文件

[zkpk@master ~]$ ls

[zkpk@master ~]$ cd hadoop-2.7.3/etc/hadoop/

[zkpk@master hadoop]$ gedit hadoop-env.sh

#如下图中红框部分,将JAVA_HOME环境变量修改成jdk实际所在路径,保存、退出。

export JAVA_HOME=/usr/java/jdk1.8.0_131/

配置yarn-env.sh文件

1.9.3.1使用gedit命令修改yarn-env.sh文件

[zkpk@master hadoop]$ gedit yarn-env.sh

1.9.3.2修改JAVA_HOME环境变量,保存、退出

export JAVA_HOME=/usr/java/jdk1.8.0_131/

1.9.4配置core-site.xml 文件

1.9.4.1使用gedit命令修改core-site.xml文件

[zkpk@master hadoop]$ gedit core-site.xml

1.9.4.2用下面的代码替换core-site.xml中的内容,保存、退出

<?xml version="1.0" encoding="UTF-8"?>

<?xml-stylesheet type="text/xsl" href="configuration.xsl"?>

<!-- Put site-specific property overrides in this file. -->

<configuration>

<property>

<name>fs.defaultFS</name>

<value>hdfs://master:9000</value>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>/home/zkpk/hadoopdata</value>

</property>

</configuration>

配置hdfs-site.xml文件

1.9.5.1使用gedit命令修改hdfs-site.xml文件

[zkpk@master hadoop]$ gedit hdfs-site.xml

1.9.5.2用下面的代码替换hdfs-site.xml中的内容,保存、退出

<?xml version="1.0" encoding="UTF-8"?>

<?xml-stylesheet type="text/xsl" href="configuration.xsl"?>

<!-- Put site-specific property overrides in this file. -->

<configuration>

<property>

<name>dfs.replication</name>

<value>2</value>

</property>

</configuration>

配置yarn-site.xml文件

1.9.6.1使用gedit命令修改yarn-site.xml文件

[zkpk@master hadoop]$ gedit yarn-site.xml

1.9.6.2用下面的代码替换yarn-site.xml中的内容,保存、退出

<?xml version="1.0"?>

<configuration>

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<property>

<name>yarn.resourcemanager.address</name>

<value>master:18040</value>

</property>

<property>

<name>yarn.resourcemanager.scheduler.address</name>

<value>master:18030</value>

</property>

<property>

<name>yarn.resourcemanager.resource-tracker.address</name>

<value>master:18025</value>

</property>

<property>

<name>yarn.resourcemanager.admin.address</name>

<value>master:18141</value>

</property>

<property>

<name>yarn.resourcemanager.webapp.address</name>

<value>master:18088</value>

</property>

</configuration>

配置mapred-site.xml文件

1.9.7.1复制mapred-site-template.xml文件:

[zkpk@master hadoop]$ cp mapred-site.xml.template mapred-site.xml

1.9.7.2使用gedit编辑mapred-site.xml文件:

[zkpk@master hadoop]$ gedit mapred-site.xml

1.9.7.3用下面的代码替换mapred-site.xml中的内容,保存、退出

<?xml version="1.0"?>

<?xml-stylesheet type="text/xsl" href="configuration.xsl"?>

<configuration>

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

</configuration>

配置slaves文件

1.9.8.1使用gedit编辑slaves文件:

[zkpk@master hadoop]$ gedit slaves

1.9.8.2将原内容替换成如下内容,保存、退出

slave01

slave02

创建Hadoop数据目录

[zkpk@master hadoop]$ cd

[zkpk@master ~]$ mkdir hadoopdata

#1.9.10将配置好的hadoop文件夹复制到slave01、slave02两个从节点

#1.9.10.1使用scp命令将文件夹复制到slave01、slave02上:

#说明:因为之前已经配置了免密钥登录,这里可以直接免密钥远程复制。

[zkpk@master ~]$ scp -r hadoop-2.7.3 zkpk@slave01:~/

[zkpk@master ~]$ scp -r hadoop-2.7.3 zkpk@slave02:~/

#1.10在三台节点分别配置Hadoop环境变量(zkpk用户)

master节点上

[zkpk@master ~]$ gedit ~/.bash_profile

#1.10.2在.bash_profile末尾添加如下内容:

#HADOOP

export HADOOP_HOME=/home/zkpk/hadoop-2.7.3

export PATH=$HADOOP_HOME/bin:$HADOOP_HOME/sbin:$PATH

1.10.3使环境变量生效:

[zkpk@master ~]$ source ~/.bash_profile

#1.11格式化Hadoop文件目录

#注意:1、只在master上执行;2、只在搭建hadoop集群时,运行格式化命令

#1.11.1格式化命令如下;若结果中出现“Storage directory /home/zkpk/hadoopdata/dfs/name has been successfully formatted.”,说明格式化成功;否则失败。只有此步骤成功后,才可以继续往下做

[zkpk@master ~]$ hdfs namenode -format

slave01节点

ssh slave01

vim ~/.bash_profile #(使用gedit编辑slave01的~/.bash_profile文件,按i在.bash_profile末尾添加如下内容:

#HADOOP

export HADOOP_HOME=/home/zkpk/hadoop-2.7.3

export PATH=$HADOOP_HOME/bin:$HADOOP_HOME/sbin:$PATH

#,按ESC后输入:wq存盘后退出)

source ~/.bash_profile #(使环境变量生效)

exit # (退出slave01,回到master)

slave02节点

ssh slave02

vim ~/.bash_profile #(使用gedit编辑slave01的~/.bash_profile文件,按i在.bash_profile末尾添加如下内容:

#HADOOP

export HADOOP_HOME=/home/zkpk/hadoop-2.7.3

export PATH=$HADOOP_HOME/bin:$HADOOP_HOME/sbin:$PATH

#,按ESC后输入:wq存盘后退出)

source ~/.bash_profile #(使环境变量生效)

exit # (退出slave01,回到master)

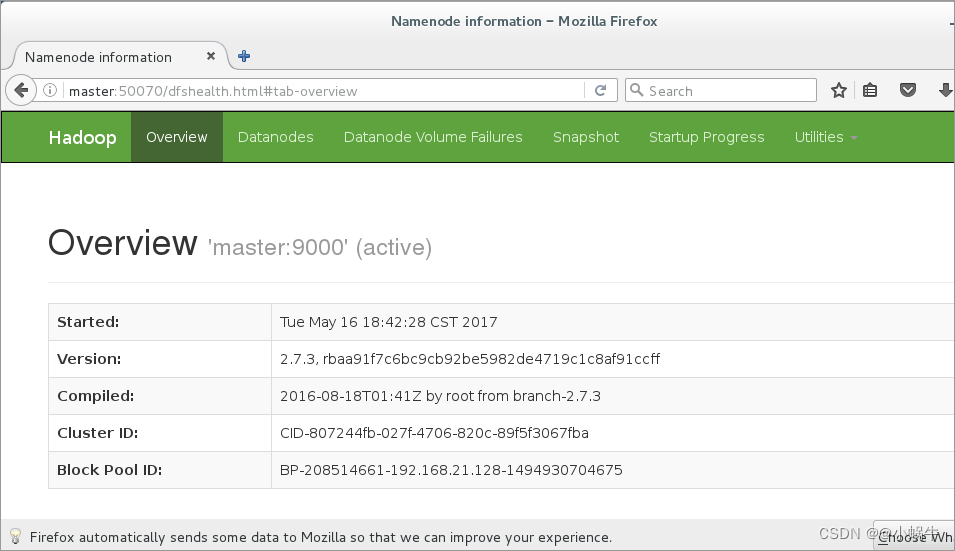

Web UI查看集群是否成功启动

在左上角Applications中打开火狐浏览器,在浏览器地址栏中输入http://master:50070/,检查namenode 和datanode 是否正常。

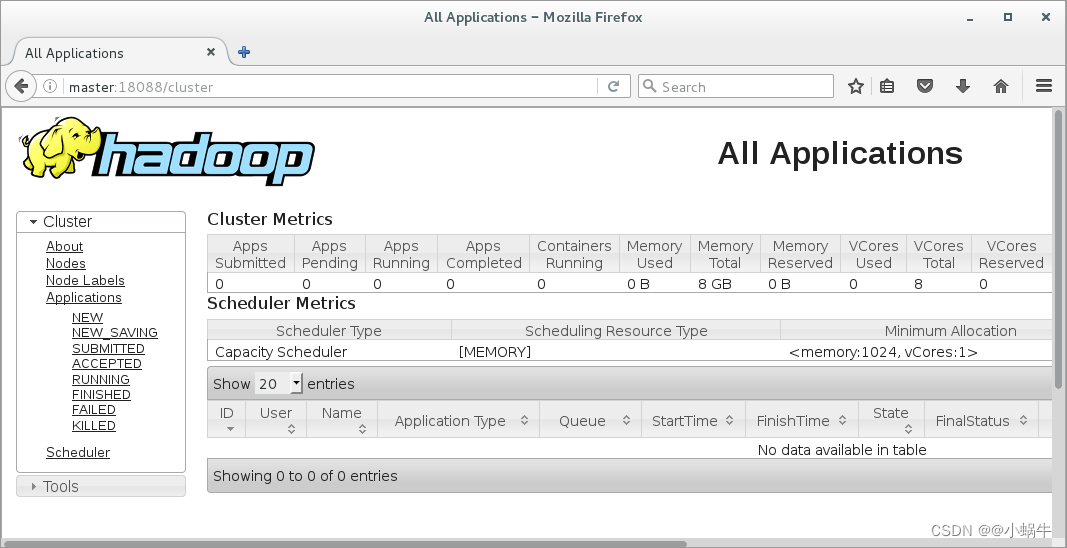

打开浏览器新标签页,地址栏中输入http://master:18088/,检查Yarn是否正常,如下图所示

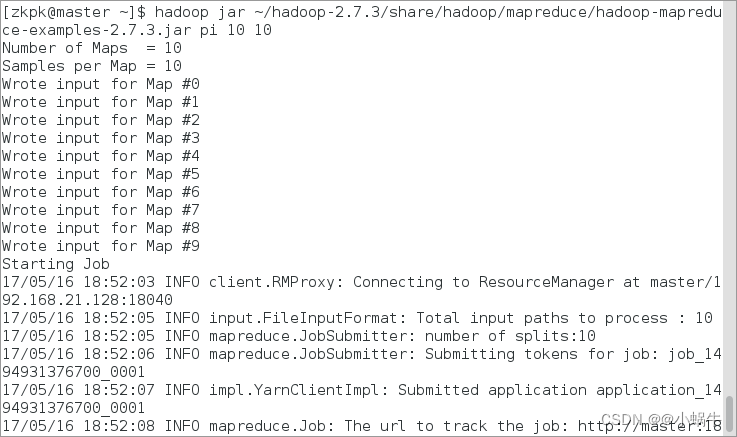

运行PI实例检查集群是否成功

1执行下面的命令:

[zkpk@master~]$ hadoop jar ~/hadoop-2.7.3/share/hadoop/mapreduce/hadoop-mapreduce-examples-2.7.3.jar pi 10 10

说明:如果出现以上3个验证步骤图片结果,也说明Hadoop集群启动正常。

该教程详细介绍了如何在master、slave01和slave02节点上配置Hadoop集群。首先在master节点解压Hadoop安装包,然后配置hadoop-env.sh、yarn-env.sh、core-site.xml、hdfs-site.xml、yarn-site.xml、mapred-site.xml和slaves文件,并创建Hadoop数据目录。接着,通过scp命令将配置好的Hadoop文件夹复制到slave节点,并在所有节点上设置环境变量。最后,进行Hadoop文件目录的格式化,并通过WebUI检查集群是否成功启动。

该教程详细介绍了如何在master、slave01和slave02节点上配置Hadoop集群。首先在master节点解压Hadoop安装包,然后配置hadoop-env.sh、yarn-env.sh、core-site.xml、hdfs-site.xml、yarn-site.xml、mapred-site.xml和slaves文件,并创建Hadoop数据目录。接着,通过scp命令将配置好的Hadoop文件夹复制到slave节点,并在所有节点上设置环境变量。最后,进行Hadoop文件目录的格式化,并通过WebUI检查集群是否成功启动。

726

726

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?