从稳态误差的角度入手。

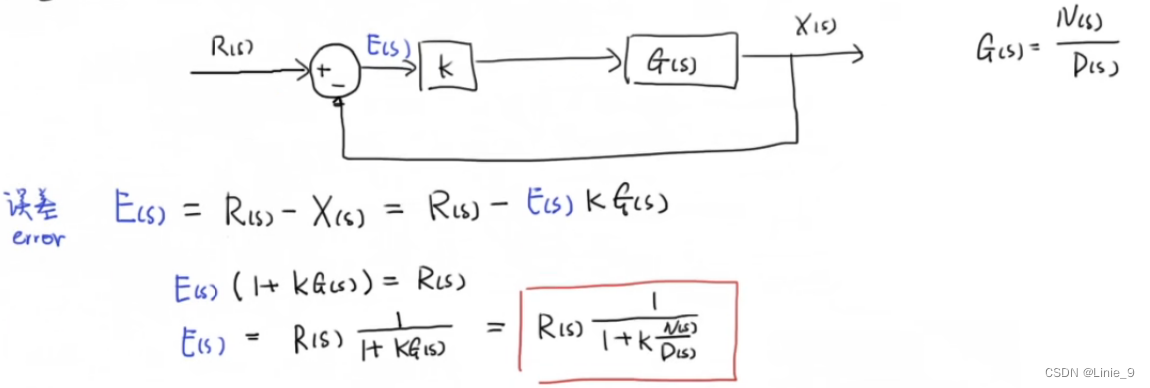

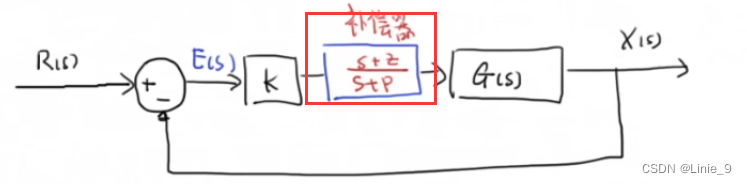

先来看一个简单的单位反馈系统

求它的稳态误差,要用到终值定理

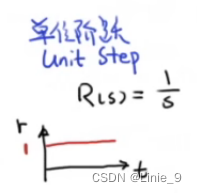

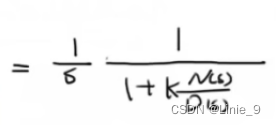

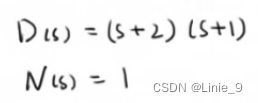

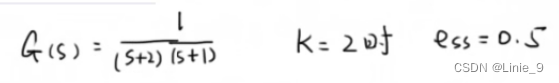

例如:一个系统的传递函数为![]()

则

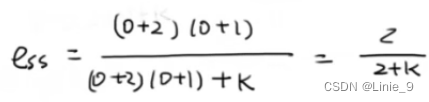

它的稳态误差为

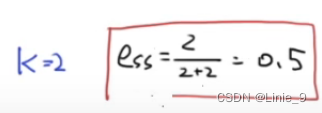

我们把这个系统在simulink里看一下。

下面考虑加一个补偿器。

即前边所有式子都要乘上一个 .

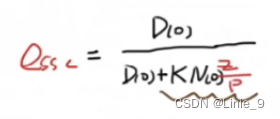

稳态误差为

![]()

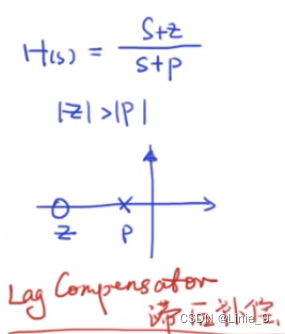

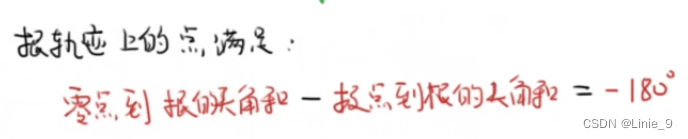

滞后补偿器

把博德图画出来我们就可以知道相位是有滞后的。

![]()

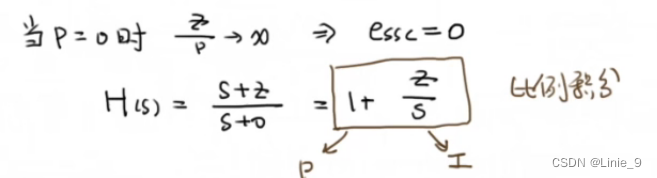

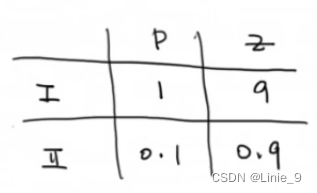

分很多种情况,下面列出两种:

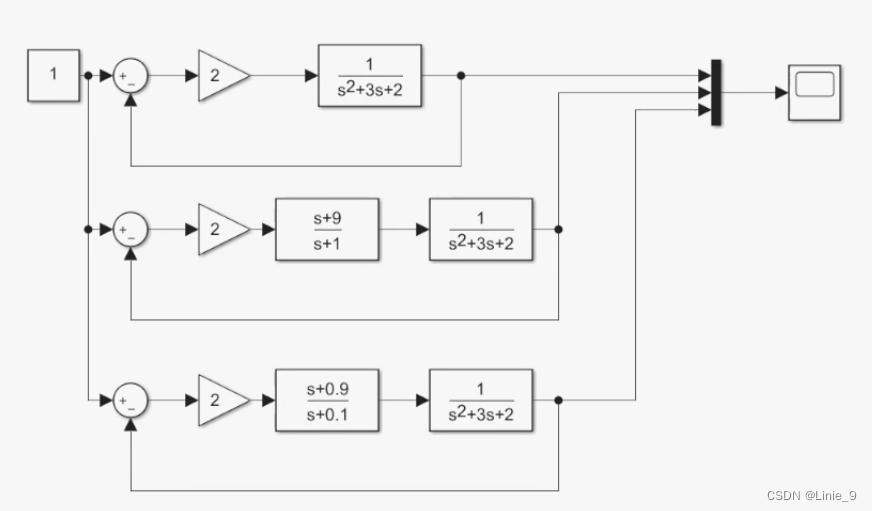

然后放到simulink中,整体👇

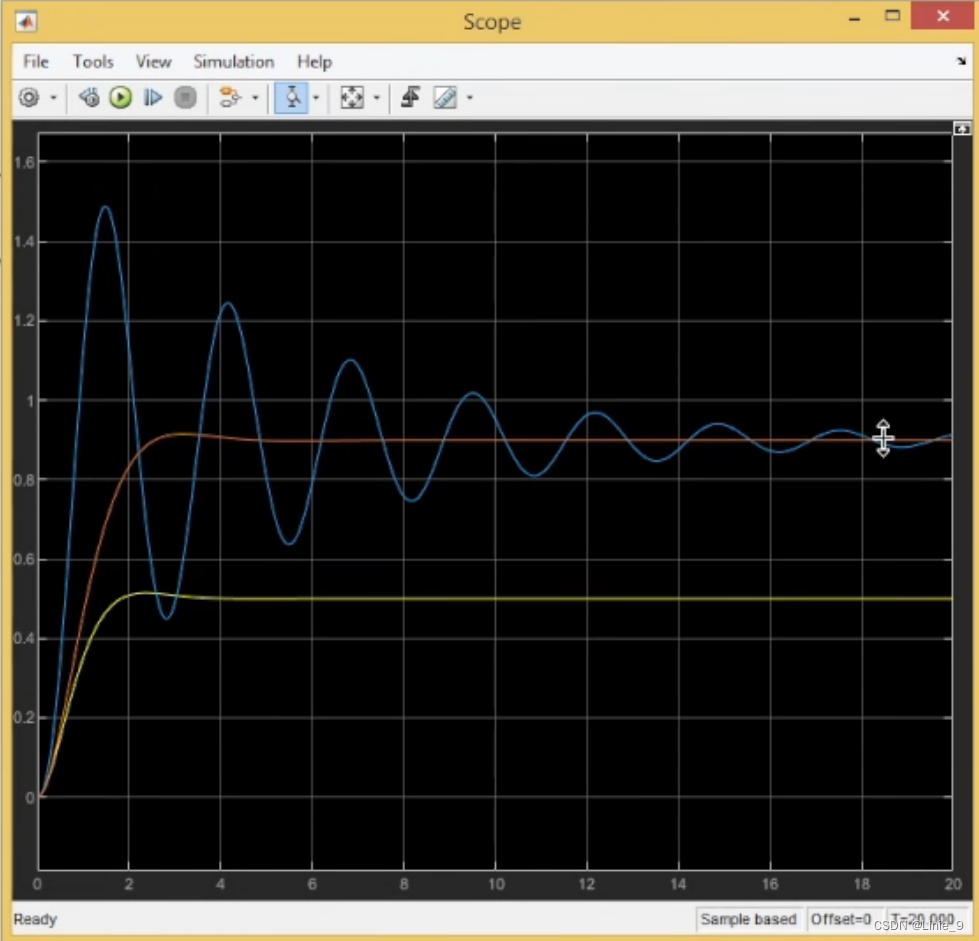

运行👇

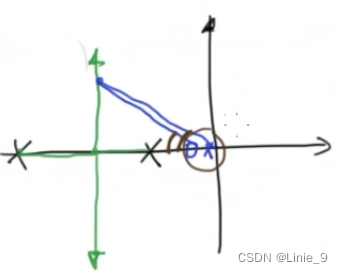

新增的极点和零点到根上的一个点,产生的角度是差别不大的。

即,新增的一对零点和极点靠近虚轴时,不会对原有系统的根轨迹产生大的影响。

这样就能尽可能地保持原有瞬态响应。

相反,如果两个点距离差别非常大,就会对原有瞬态响应产生非常大的影响。

本文探讨了如何通过稳态误差分析单位反馈系统,利用终值定理计算传递函数的稳态误差,并通过Simulink模拟补偿器对系统进行改进。着重讲解滞后补偿器对系统动态特性的影响,以及不同补偿策略对瞬态响应的影响。

本文探讨了如何通过稳态误差分析单位反馈系统,利用终值定理计算传递函数的稳态误差,并通过Simulink模拟补偿器对系统进行改进。着重讲解滞后补偿器对系统动态特性的影响,以及不同补偿策略对瞬态响应的影响。

4145

4145

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?