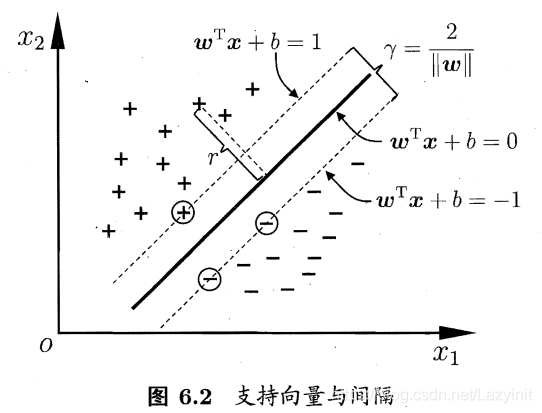

1.间隔与支持向量

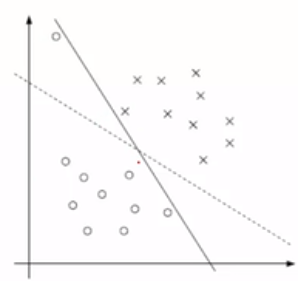

分类学习 最基本的想法就是基于训练集在样本空间中找到一个划分超平面,将不同类别的样本分开。

在样本空间中,划分超平面可通过如下线性方程来描述:

![]()

其中![]() 为法向量,决定了超平面的方向;b为位移项,决定了超平面与原点之间的距离。

为法向量,决定了超平面的方向;b为位移项,决定了超平面与原点之间的距离。

显然,划分超平面可被法向量 w 和位移 b 确定,记为(w,b)。

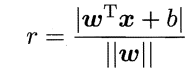

样本空间中任意点 x 到超平面的距离可写为

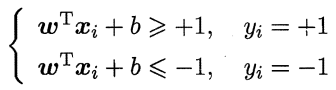

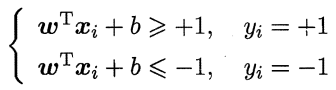

假设超平面能将训练样本正确分类,则

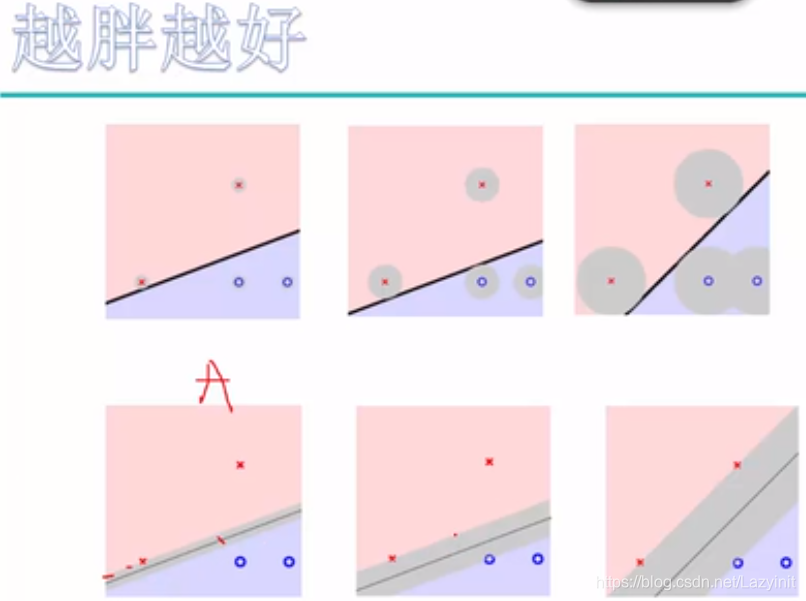

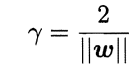

距离超平面最近的这几个训练样本点,使上式等号成立,它们被称为 支持向量 ,两个一类支持向量到超平面的距离之和称为 间隔 表示为:

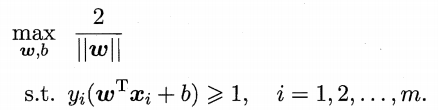

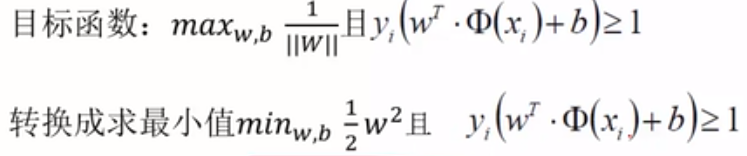

欲找到具有 “最大间隔” 的划分超平面,也就是找到能满足 中约束的参数 w 和 b ,使得 间隔 最大

中约束的参数 w 和 b ,使得 间隔 最大

2.对偶问题

3.核函数

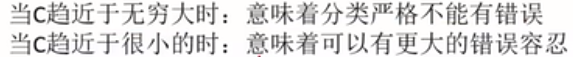

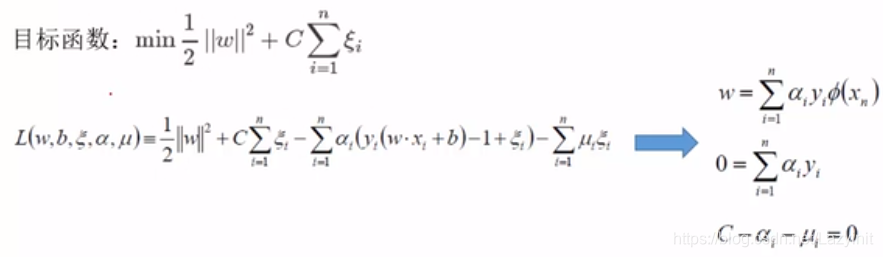

4.软间隔与正则化

对于绝大多数样本都是友好的,个别样本不符合;前面介绍的支持向量机形式是要求所有样本均满足约束,即所有样本都必须划分正确,这称为 “硬间隔” ,而 软间隔 则允许某些样本不满足约束![]()

为了解决该问题,引入 松弛因子 ![]()

5.支持向量回归

6.核方法

本文详细介绍了支持向量机的概念,包括间隔与支持向量的定义,如何通过最大化间隔寻找最优超平面。接着,探讨了对偶问题,核函数在非线性分类中的应用,以及如何通过软间隔和正则化处理异常样本。此外,还提到了支持向量回归和核方法的重要性。

本文详细介绍了支持向量机的概念,包括间隔与支持向量的定义,如何通过最大化间隔寻找最优超平面。接着,探讨了对偶问题,核函数在非线性分类中的应用,以及如何通过软间隔和正则化处理异常样本。此外,还提到了支持向量回归和核方法的重要性。

392

392

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?