精确率和召回率的权衡

精确率:指分类正确的正样本个数占分类器判定为正样本的样本个数的比例

召回率:指分类正确的正样本个数占真正正样本个数的比例

在排序问题中,通常没有一个固定阈值把得到的结果直接判定为正样本或负样本,而是采用TopN返回结果的Precision值和Recall值来衡量排序模型的性能,即认为模型返回的TopN的结果就是模型判定的正样本,然后计算前N个位置上的精确率PrecisionN和召回率RecallN。

为了综合评估一个排序模型的好坏,不仅要看模型的precision和recall,最好绘制出模型的P-R曲线。

P-R曲线的横轴是召回率,纵轴是精确率。对于一个排序模型来说,PR曲线上的一个点代表着在某一阈值下,模型将大于该阈值的结果判定为正样本,小于该阈值的结果判定为负样本,此时返回结果对应的召回率和精确率。

PR曲线可以对模型进行更为全面的评估。

另外,P-R曲线围起来的面积就是AP值,通常来说一个越好的分类器,AP值越高。在目标检测中,每一类都可以根据 recall 和 precision绘制P-R曲线,AP就是该曲线下的面积,mAP就是所有类AP的平均值。

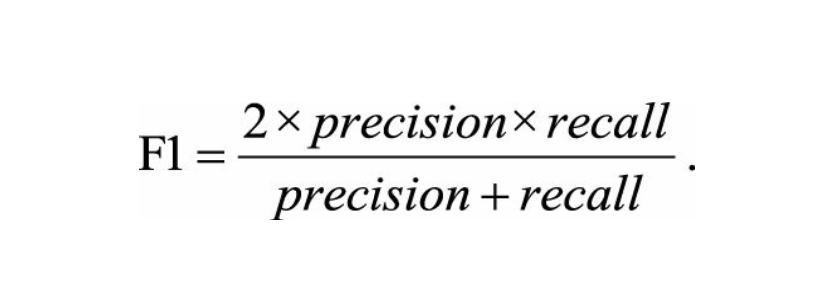

F1 score也能反映一个排序模型的性能,F1是precision和recall和调和平均值。

平方根误差

一般情况下,RMSE能够很好的反映回归模型预测值与真实值的偏离程度。但在实际问题中,如果存在个别偏离程度非常大的离群点时,即使离群点数量非常少,也会让RMSE的指标变得很差。

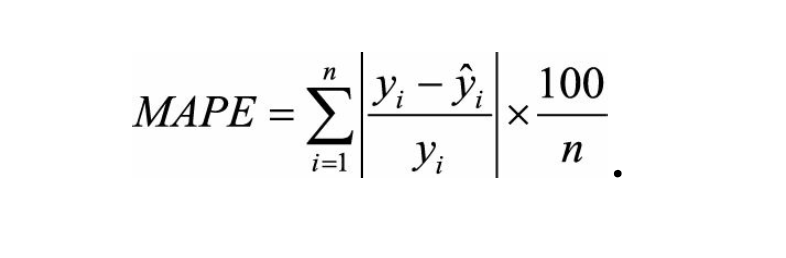

关于评估指标,存在比RMSE鲁棒性更好的指标,如平均绝对百分比误差

相当于把每个点的误差进行了归一化,降低了个别离群点带来的绝对误差的影响。

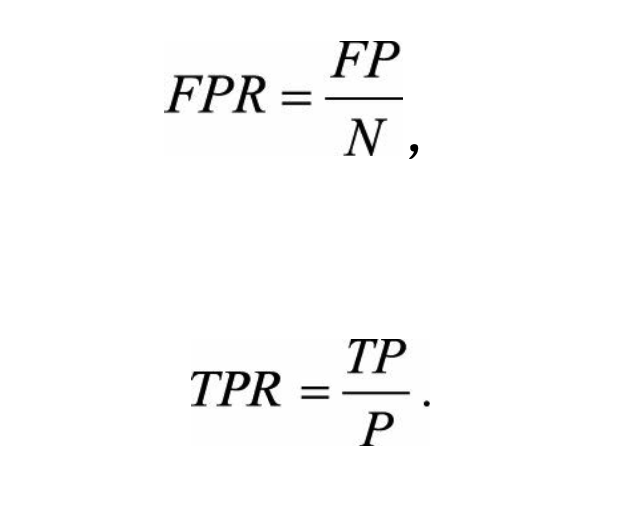

ROC曲线

ROC曲线的横坐标为假阳性率(False Positive Rate,FPR);纵坐标为真阳性率(True Positive Rate,TPR)。计算方法分别为:

P是真实的正样本的数量,N是真实的负样本的数量,TP是P个正样本中 被分类器预测为正样本的个数,FP是N个负样本中被分类器预测为正样本的个 数。

AUC指的是ROC曲线下的面积大小,该值能够量化的反映基于ROC曲线衡量出的模型性能。AUC的值只需要沿着ROC横轴做积分。由于ROC曲线一般都位于y=x的上方,所以AUC的值一般在0.5-1之间。AUC越大,说明分类器越可能把真正的正样本排在前面,分类性能越好。

ROC和PR的区别

当正负样本的分布发生变化时,ROC曲线的形状能够基本保持不变,而PR曲线则会发生较剧烈的变化。

模型评估的方法

- Holdout检验

- 交叉验证

- 自助法

Holdout检验

将原始的样本集合随机划分成训练集和验证集两部分。

缺点很明显,即在验证集上计算出来的最后评估指标与原始分组有很大关系。

交叉验证

k-fold交叉验证:首先将全部样本划分成k个大小相等的样本子集;依次遍历 这k个子集,每次把当前子集作为验证集,其余所有子集作为训练集,进行模型的 训练和评估;最后把k次评估指标的平均值作为最终的评估指标。在实际实验 中,k经常取10。

自助法

自助法是基于自助采样法的检验方法。对于总数为n的样本集合,进行n次有 放回的随机抽样,得到大小为n的训练集。n次采样过程中,有的样本会被重复采 样,有的样本没有被抽出过,将这些没有被抽出的样本作为验证集,进行模型验 证,这就是自助法的验证过程。

超参数调优

网格搜索

通过查找搜索范围内的所有点来确定最优值。

实际应用中,网格搜索法一般先使用较广的搜索范围和较大的步长,来寻找全局最优值可能的位置,然后来逐渐缩小搜索范围和步长,来寻找更精确的最优值。

随机搜索

在搜索范围中随机选取样本点。

贝叶斯优化算法

网格搜索和随机搜索在测试一个新点时,会忽略前一个点的信息; 而贝叶斯优化算法则充分利用了之前的信息。贝叶斯优化算法通过对目标函数形 状进行学习,找到使目标函数向全局最优值提升的参数。具体来说,它学习目标 函数形状的方法是,首先根据先验分布,假设一个搜集函数;然后,每一次使用 新的采样点来测试目标函数时,利用这个信息来更新目标函数的先验分布;最 后,算法测试由后验分布给出的全局最值最可能出现的位置的点。对于贝叶斯优 化算法,有一个需要注意的地方,一旦找到了一个局部最优值,它会在该区域不 断采样,所以很容易陷入局部最优值。为了弥补这个缺陷,贝叶斯优化算法会在 探索和利用之间找到一个平衡点,“探索”就是在还未取样的区域获取采样点; 而“利用”则是根据后验分布在最可能出现全局最值的区域进行采样。

过拟合和欠拟合

过拟合是指模型对于训练数据拟合呈过当的情况,反映到评估指标上,就是 模型在训练集上的表现很好,但在测试集和新数据上的表现较差。欠拟合指的是 模型在训练和预测时表现都不好的情况。

降低过拟合

1.数据方面,获得更多的训练数据。

2.降低模型复杂度。

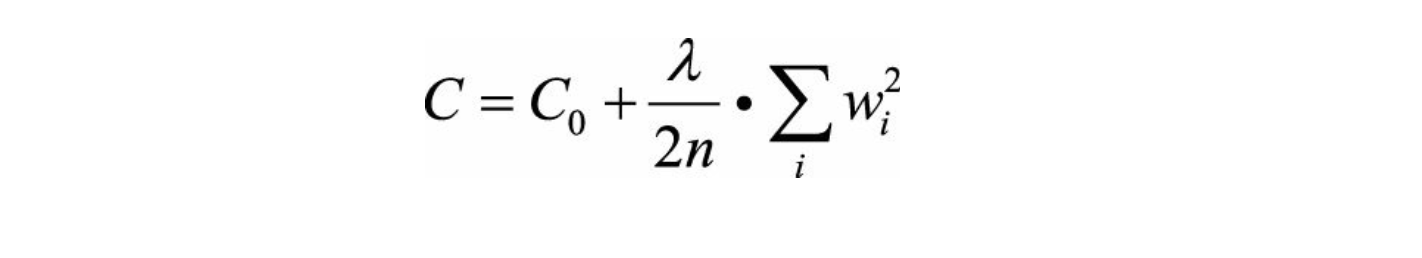

3.正则化方法。给模型的参数加上一定的正则约束。如将权值的大小加入到损失函数中。以L2正则化为例:

4.集成学习方法。把多个模型集成在一起,来降低单一模型的过拟合风险。

降低欠拟合

1.添加新特征。

2.增加模型复杂度。

3.减小正则化系数。

本文深入探讨了模型评估的多种方法,包括精确率、召回率及其权衡,以及P-R曲线和AUC值在排序和分类任务中的应用。提到了在面对离群点时,平均绝对百分比误差比RMSE更具鲁棒性。此外,介绍了ROC曲线和其下的AUC面积作为衡量模型性能的重要指标,以及ROC与PR曲线的区别。最后,讨论了模型验证方法如交叉验证、自助法,并概述了超参数调优的不同策略,如网格搜索、随机搜索和贝叶斯优化,以及如何应对过拟合和欠拟合问题。

本文深入探讨了模型评估的多种方法,包括精确率、召回率及其权衡,以及P-R曲线和AUC值在排序和分类任务中的应用。提到了在面对离群点时,平均绝对百分比误差比RMSE更具鲁棒性。此外,介绍了ROC曲线和其下的AUC面积作为衡量模型性能的重要指标,以及ROC与PR曲线的区别。最后,讨论了模型验证方法如交叉验证、自助法,并概述了超参数调优的不同策略,如网格搜索、随机搜索和贝叶斯优化,以及如何应对过拟合和欠拟合问题。

2705

2705

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?