以下为ELK技术栈完整使用指南,涵盖核心组件部署、配置及优化方案:

一、ELK核心组件功能

| 组件 | 作用 | 关键特性 |

|---|---|---|

| Elasticsearch | 分布式搜索与分析引擎 | 实时索引、横向扩展、RESTful API |

| Logstash | 日志收集、解析与传输管道 | 200+插件、Grok模式解析、数据过滤 |

| Kibana | 数据可视化与分析平台 | 仪表盘定制、机器学习分析、警报系统 |

二、部署流程(以CentOS 7为例)

1. 环境准备

# 安装Java环境

sudo yum install java-11-openjdk-devel

2. Elasticsearch安装

# 导入ES密钥

rpm --import https://artifacts.elastic.co/GPG-KEY-elasticsearch

# 安装ES

cat > /etc/yum.repos.d/elasticsearch.repo <<EOF

[elasticsearch]

name=Elasticsearch repository

baseurl=https://artifacts.elastic.co/packages/7.x/yum

gpgcheck=1

gpgkey=https://artifacts.elastic.co/GPG-KEY-elasticsearch

enabled=1

autorefresh=1

type=rpm-md

EOF

sudo yum install elasticsearch

3. 关键配置(/etc/elasticsearch/elasticsearch.yml)

cluster.name: prod-logs # 集群名称

node.name: node-1 # 节点标识

network.host: 192.168.1.100 # 监听IP

discovery.seed_hosts: ["node-1"] # 单节点发现

4. 启动服务

sudo systemctl enable elasticsearch

sudo systemctl start elasticsearch

5. Logstash部署

sudo yum install logstash

6. Logstash管道配置(/etc/logstash/conf.d/apache.conf)

input {

file {

path => "/var/log/apache2/access.log"

start_position => "beginning"

}

}

filter {

grok {

match => {

"message" => "%{COMBINEDAPACHELOG}" }

}

date {

match => [ "timestamp", "dd/MMM/yyyy:HH:mm:ss Z" ]

}

}

output {

elasticsearch {

hosts => ["http://192.168.1.100:9200"]

index => "apache-logs-%{+YYYY.MM.dd}"

}

}

7. Kibana安装与启动

sudo yum install kibana

sudo systemctl enable kibana && sudo systemctl start kibana

三、Kibana操作指南

-

数据接入

- 访问

http://<server_ip>:5601 - 进入 Management > Stack Management > Index Patterns 创建索引模式(如

apache-logs-*)

- 访问

-

日志分析

- 使用 Discover 界面进行实时日志搜索

response:200 AND bytes:>1000 # 筛选成功响应且传输量>1KB的请求 -

仪表盘构建

- 在 Dashboard 创建可视化图表:

- 柱状图:HTTP状态码分布

- 饼图:客户端操作系统占比

- 地图:访问者地理位置分布

- 在 Dashboard 创建可视化图表:

四、性能优化方案

-

Elasticsearch调参

# /etc/elasticsearch/jvm.options -Xms4g # JVM最小内存 -Xmx4g # JVM最大内存(不超过物理内存50%) -

Logstash管道优化

input { beats { # 改用轻量级Filebeat port => 5044 } } -

索引生命周期管理(ILM)

PUT _ilm/policy/logs_policy { "policy": { "phases": { "hot": { "actions": { "rollover": { "max_size": "50GB" } } }, "delete": { "min_age": "30d", "actions": { "delete": { } } } } } }

五、安全加固措施

-

启用X-Pack基础安全

# elasticsearch.yml xpack.security.enabled: true# 生成密码 sudo /usr/share/elasticsearch/bin/elasticsearch-setup-passwords auto -

Kibana用户角色配置

- 通过 Stack Management > Security 创建只读用户

六、常见问题排查

- 日志未入库

# 检查Logstash管道状态 tail -f /var/log/logstash/logstash-plain.log - 集群健康异常

curl -XGET 'http://localhost:9200/_cluster/health?pretty'- 关注

status字段(green/yellow/red)

- 关注

七、典型应用场景

- Web服务器监控

- 实时分析Nginx/Apache访问日志,检测异常请求

- 安全审计

- 通过自定义规则识别SSH暴力破解行为

event.type: "authentication_failure" | stats count by source.ip - 业务指标分析

- 统计电商平台订单处理延迟(ELK + Kafka流处理)

注:生产环境建议部署3节点ES集群,搭配Redis做日志缓冲队列

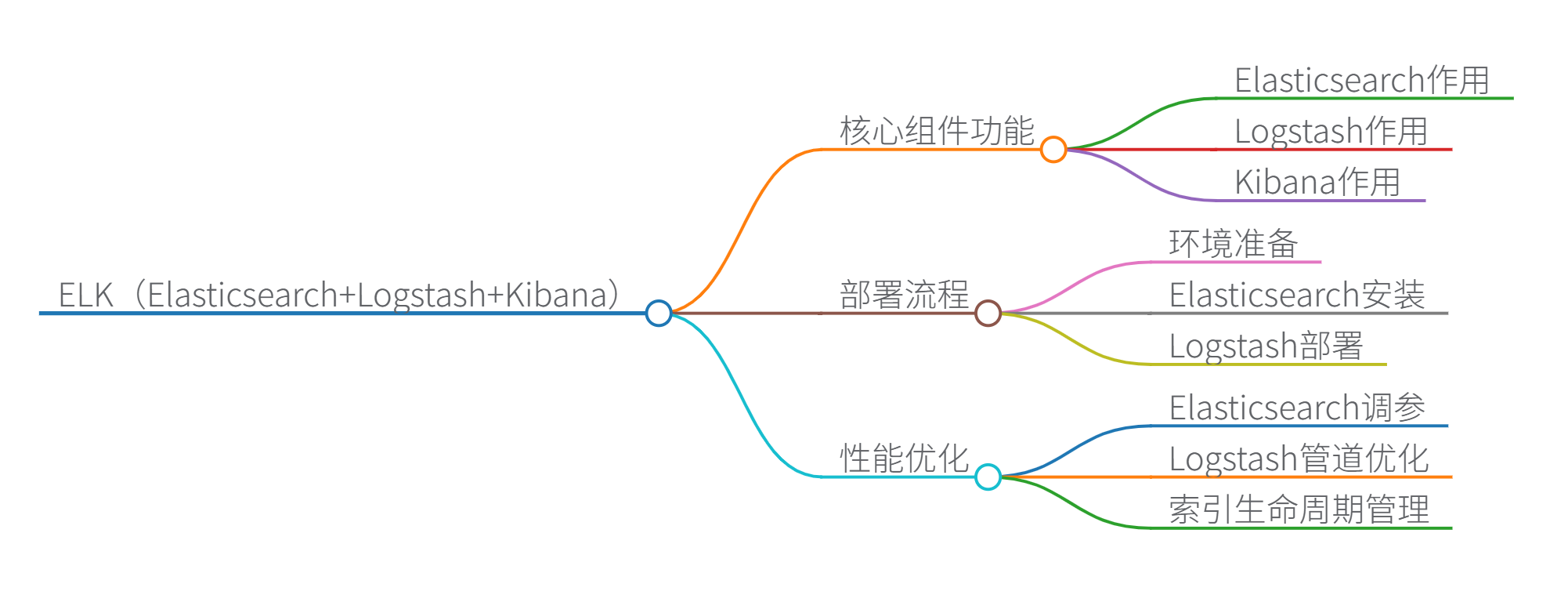

思维导图

以下是对ELK技术栈的全面解析,涵盖技术原理、设计架构、核心组件及代码实现:

一、技术原理与设计架构

1. 整体架构图

+----------------+ +----------------+ +----------------+ +----------------+

| 数据源 | ----> | Logstash | ----> | Elasticsearch | ----> | Kibana |

| (日志文件/DB等) | 采集 | (数据处理管道) | 传输 | (分布式搜索引擎) | 可视化 | (数据展示平台) |

+----------------+ +----------------+ +----------------+ +----------------+

2. 设计原理

- 分布式扩展:Elasticsearch采用分片(shard)机制实现水平扩展

- 近实时处理:数据从采集到可搜索延迟约1秒(refresh_interval)

- Schema-on-Read:无需预先定义数据结构,动态映射字段类型

- CAP原则:优先保证AP(可用性和分区容错性)

二、核心组件技术解析

1. Elasticsearch

数据结构与算法:

- 倒排索引:核心数据结构,实现O(1)O(1)O(1

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

3763

3763

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?