Apache Solr 使用指南与配置教程

Apache Solr 是基于 Lucene 的开源企业级搜索平台,支持全文检索、分面搜索、高亮显示等功能。以下为关键操作指南:

一、安装与启动

-

环境准备

- 安装 Java JDK(推荐 JDK 11+):

sudo apt install openjdk-11-jdk # Ubuntu/Debian - 验证安装:

java -version

- 安装 Java JDK(推荐 JDK 11+):

-

下载与解压 Solr

wget https://archive.apache.org/dist/solr/solr/8.11.2/solr-8.11.2.tgz tar -xzf solr-8.11.2.tgz cd solr-8.11.2 -

启动 Solr

bin/solr start -p 8983 # 指定端口启动- 访问管理界面:

http://localhost:8983/solr

- 访问管理界面:

-

配置为系统服务(Linux)

创建服务文件/etc/systemd/system/solr.service:[Unit] Description=Apache Solr After=network.target [Service] User=solr ExecStart=/opt/solr/bin/solr start -p 8983 Restart=on-failure [Install] WantedBy=multi-user.target启用服务:

sudo systemctl enable solr

二、核心配置

-

创建核心(Core)

bin/solr create_core -c my_core # 创建名为 my_core 的搜索核心- 配置文件路径:

server/solr/my_core/conf/

- 配置文件路径:

-

修改 schema.xml

定义字段类型(如文本、日期)和索引规则:<field name="title" type="string" indexed="true" stored="true"/> <field name="content" type="text_general" indexed="true" stored="false"/> -

配置中文分词

添加 IK Analyzer 插件:- 下载 IK Jar 包至

server/solr-webapp/webapp/WEB-INF/lib/ - 在

managed-schema中配置分词器:<fieldType name="text_ik" class="solr.TextField"> <analyzer type="index"> <tokenizer class="org.wltea.analyzer.lucene.IKTokenizerFactory"/> </analyzer> </fieldType>

- 下载 IK Jar 包至

三、数据操作

-

索引数据(JSON 示例)

通过 API 添加文档:curl -X POST -H 'Content-Type: application/json' \ 'http://localhost:8983/solr/my_core/update?commit=true' \ -d '[{"id":"1", "title":"Solr指南", "content":"全文搜索配置教程"}]' -

查询数据

- 基础查询:

http://localhost:8983/solr/my_core/select?q=title:指南 - 分面统计:

&facet=true&facet.field=category

- 基础查询:

四、常见问题解决

-

启动失败:端口冲突

- 检查端口占用:

lsof -i:8983 - 更换端口:

bin/solr start -p 8984

- 检查端口占用:

-

中文分词无效

- 确认 IK Jar 包已放入正确路径

- 重启 Solr 并重建索引

-

内存不足

修改bin/solr.in.sh:SOLR_JAVA_MEM="-Xms2g -Xmx4g" # 调整堆内存 -

数据未更新

- 添加文档后执行硬提交:

&commit=true - 或在

solrconfig.xml中配置自动提交

- 添加文档后执行硬提交:

五、高级功能

- 分面搜索(Faceting):统计字段分布(如商品分类计数)

- 高亮(Highlighting):匹配片段标红

- 近实时搜索(NRT):索引变更秒级可见

- 集群模式(SolrCloud):通过 ZooKeeper 管理分布式节点

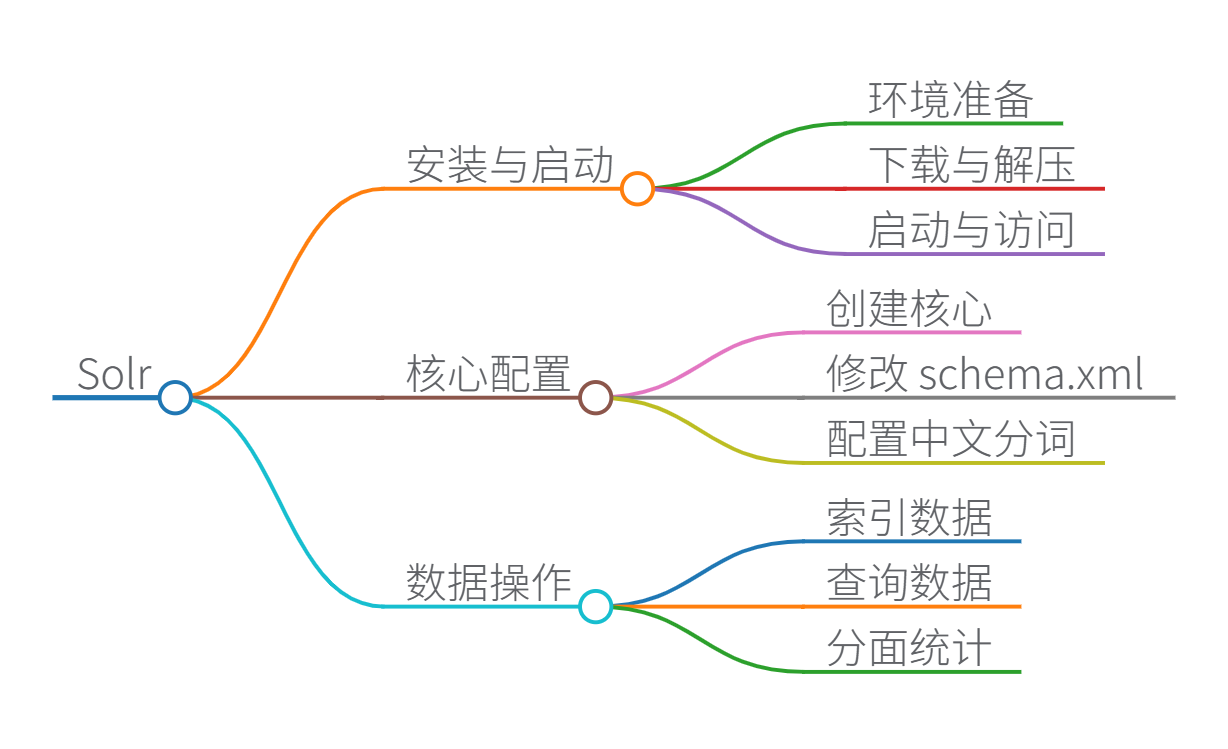

思维导图

Apache Solr 技术原理深度解析

一、技术原理与核心架构

Solr 基于 Lucene 倒排索引实现全文搜索,其核心流程如下:

- 索引构建:文档经分词器处理生成词元(Token),构建

词项→文档ID的映射

倒排索引={词项i:[文档ID1,文档ID2,…]} \text{倒排索引} = \left\{ \text{词项}_i : \left[ \text{文档ID}_1, \text{文档ID}_2, \ldots \right] \right\} 倒排索引={词项i:[文档ID1,文档ID2,…]} - 查询处理:将查询解析为布尔逻辑(AND/OR/NOT),通过跳跃表快速定位倒排链

- 相关性排序:使用 BM25 算法(优于传统 TF-IDF)计算文档得分:

score(D,Q)=∑i=1nIDF(qi)⋅f(qi,D)⋅(k1+1)f(qi,D)+k1⋅(1−b+b⋅∣D∣avgdl) \text{score}(D,Q) = \sum_{i=1}^{n} \text{IDF}(q_i) \cdot \frac{f(q_i, D) \cdot (k_1 + 1)}{f(q_i, D) + k_1 \cdot (1 - b + b \cdot \frac{|D|}{\text{avgdl}})} score(D,Q)=i=1∑nIDF(qi)⋅f(qi,D)+k1⋅(1−b+b⋅avgdl∣D∣)f(qi,D)⋅(k1+1)

其中 k1k_1k1 和 bbb 是可调参数,∣D∣|D|∣D∣ 是文档长度

二、关键数据结构

| 数据结构 | 作用 | 实现特点 |

|---|---|---|

| 倒排索引 | 核心搜索结构,存储词项到文档的映射 | 使用 FST(有限状态转换机)压缩存储 |

| DocValues | 列式存储,用于排序/聚合 | 内存映射文件,减少 Heap 压力 |

| BKD-Tree | 空间数据索引(如经纬度) | 高效多维范围查询 |

| 跳跃表 | 加速倒排链的交并集操作 | O(log n) 时间复杂度 |

三、核心组件功能

- 分词器(Tokenizer)

- 将文本拆分为词元(支持中文 IKAnalyzer)

- 示例流程:

"Solr搜索" → ["solr", "搜索"]

- 过滤器(Filter)

- 词元处理:小写转换、同义词扩展、停用词过滤

- 查询解析器(QueryParser)

- 解析

title:("大数据" AND "分析")~10等复杂语法

- 解析

- 请求处理器(RequestHandler)

- 路由请求到搜索/更新等操作模块

- SolrCloud 协调器

- 基于 ZooKeeper 实现分布式共识和故障转移

四、优缺点分析

优势:

- 全文检索精度高(支持短语搜索、模糊匹配)

- 实时性优秀(NRT 近实时搜索延迟<1s)

- 扩展性强(支持 PB 级分布式集群)

- 功能丰富(分面统计、高亮、拼写检查)

局限:

- 内存消耗较大(建议 16GB+ 内存)

- 聚合分析弱于 Elasticsearch

- 学习曲线陡峭(需掌握 Lucene 底层原理)

五、Java 示例代码(含中文注释)

import org.apache.solr.client.solrj.SolrClient;

import org.apache.solr.client.solrj.impl.HttpSolrClient;

import org.apache.solr.client.solrj.response.QueryResponse;

import org.apache.solr.common.SolrDocumentList;

import org.apache.solr.common.params.MapSolrParams;

import java.util.HashMap;

import java.util.Map;

public class SolrSearchDemo {

public static void main(String[] args) throws Exception {

// 1. 创建Solr客户端(指向核心my_core)

String solrUrl = "http://localhost:8983/solr";

try (SolrClient solrClient = new HttpSolrClient.Builder(solrUrl).build()) {

String coreName = "my_core";

// 2. 构建查询参数

Map<String, String> queryParams = new HashMap<>();

queryParams.put("q", "content:分布式系统"); // 查询内容包含"分布式系统"

queryParams.put("fl", "id,title,score"); // 返回字段:ID、标题、相关性得分

queryParams.put("fq", "category:IT"); // 过滤条件:IT分类

queryParams.put("sort", "score desc"); // 按相关性降序

queryParams.put("rows", "10"); // 返回前10条结果

// 3. 执行查询并获取响应

QueryResponse response = solrClient.query(coreName, new MapSolrParams(queryParams));

SolrDocumentList results = response.getResults();

// 4. 遍历结果

System.out.println("命中文档数: " + results.getNumFound());

results.forEach(doc -> {

System.out.println("ID: " + doc.get("id")

+ " | 标题: " + doc.get("title")

+ " | 得分: " + doc.get("score"));

});

}

}

}

关键代码注释:

HttpSolrClient:HTTP 协议客户端,连接 Solr 服务器MapSolrParams:封装查询参数(q=关键词,fl=返回字段)fq参数:过滤查询(Filter Query),不影响相关性评分score字段:BM25 算法计算的相关性得分(值越大越匹配)

六、性能优化建议

- 索引优化:

- 使用

docValues=true加速排序/聚合 - 避免存储不必要字段(

stored="false")

- 使用

- 查询优化:

- 用

fq替代q进行过滤(结果可缓存) - 避免通配符前缀查询

*term

- 用

- JVM 调优:

# solr.in.sh 配置 SOLR_JAVA_MEM="-Xms4g -Xmx8g" # 堆内存设置 GC_TUNE="-XX:+UseConcMarkSweepGC" # 低延迟GC

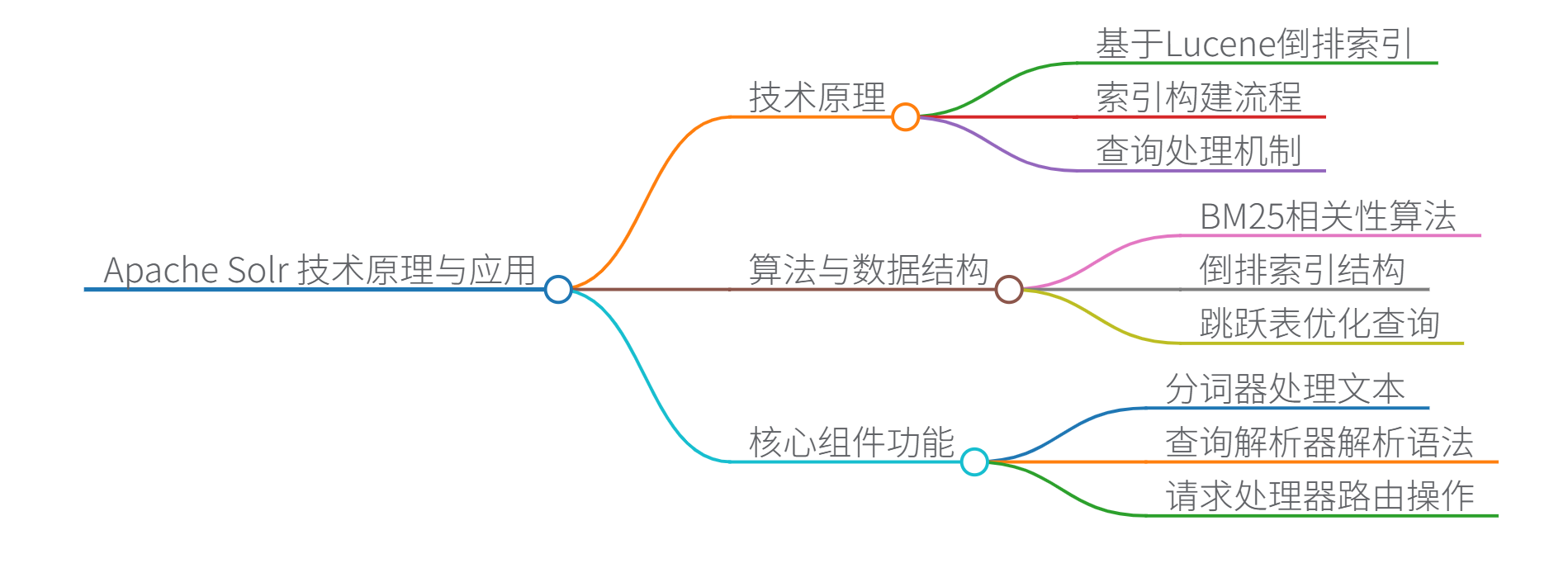

思维导图

1839

1839

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?