作者:趣趣

链接:https://zhuanlan.zhihu.com/p/37286494#:~:text=%E5%8D%B7%E7%A7%AF%E6%98%AF%E7%A7%BB%E5%8A%A8%E7%9A%84%E5%86%85%E7%A7%AF,%EF%BC%8C%E7%9B%B8%E5%BD%93%E4%BA%8E%E7%BB%99%E6%9F%90%E4%B8%80%E2%80%A6

来源:知乎

著作权归作者所有。商业转载请联系作者获得授权,非商业转载请注明出处。

卷积是移动的内积。内积的针对点,卷积针对序列。内积和卷积的意义是变换特征空间。

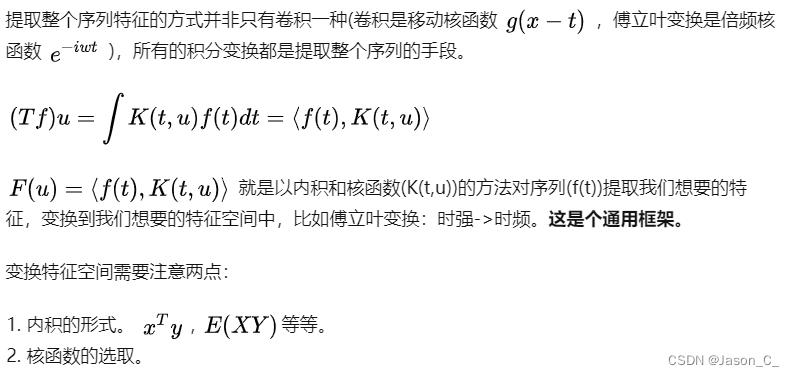

内积作用是提取我想要的特征。内积是向量在某个特征(向量)上的投影,直接意义是量在某特征上的强度。做一次内积,相当于给某一个点提取特征。想要提取一个序列(时间序列,图片等等)的特征,我们需要在信号上移动做内积,记录下来值的就是整个序列的特征。

卷积的积分形式:

f ∗ g = ∫ f ( τ ) g ( x − τ ) d τ f * g=\int f(\tau) g(x-\tau) d \tau f∗g=∫f(τ)g(x−τ)dτ

内积的积分形式:

⟨ f , g ⟩ = ∫ f ( τ ) g ( τ ) d τ \langle f, g\rangle=\int f(\tau) g(\tau) d \tau ⟨f,g⟩=∫f(τ)g(τ)dτ

移动做内积就是卷积。内积的形式有很多种,基本上就是分量的先乘后和。每一个核(g)决定一个特征,结果是信号在这个特征上的强度。

神经网络CNN的特征是卷积核是根据我们的目标自动选择的,而不是人为给定的。

卷积神经网络解析:移动特征提取的秘密

卷积神经网络解析:移动特征提取的秘密

本文探讨了卷积是如何在神经网络中作为移动内积的,强调其在特征提取过程中的核心作用。通过对比内积和卷积的数学定义,解释了卷积如何适用于时间序列和图像处理,以及CNN中的自动特征选择原理。

本文探讨了卷积是如何在神经网络中作为移动内积的,强调其在特征提取过程中的核心作用。通过对比内积和卷积的数学定义,解释了卷积如何适用于时间序列和图像处理,以及CNN中的自动特征选择原理。

1053

1053

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?