理解稀疏性(Sparsity):什么是矩阵的稀疏性?

在数据科学、机器学习、线性代数等多个领域中,矩阵是一个常见而基础的数学工具。而在处理大型矩阵时,我们经常会遇到“稀疏矩阵”(Sparse Matrix)。稀疏性(Sparsity)正是描述一个矩阵中“有多少是零元素”的一个重要概念。理解和利用稀疏性,有助于我们提升数据存储效率、加速运算过程。

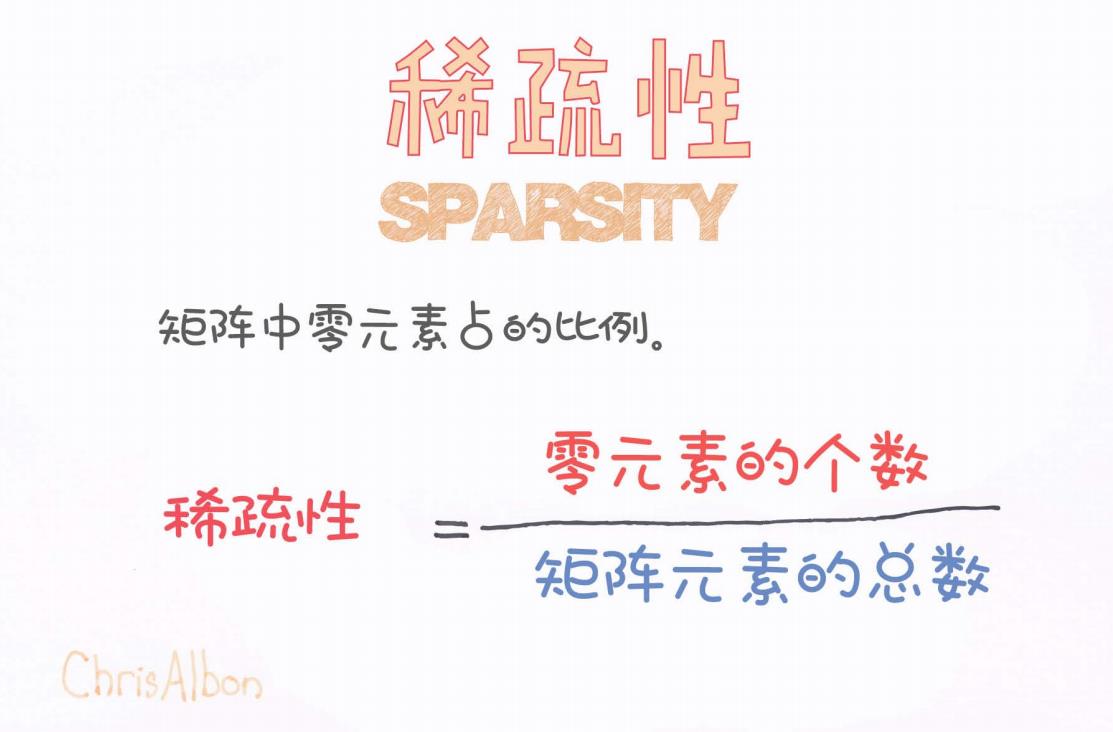

什么是稀疏性?

稀疏性(Sparsity)是指一个矩阵中零元素所占的比例。在很多实际应用中,比如自然语言处理中的词向量矩阵、图像识别中的特征矩阵、推荐系统中的用户-物品评分矩阵等,矩阵中大多数元素都是0,这就是稀疏矩阵的典型特征。

我们可以通过一个简单的公式来定义稀疏性:

也就是说,一个矩阵越“稀疏”,其稀疏性值就越高。相反,如果一个矩阵中非零元素很多,那么它就是一个“密集矩阵”(Dense Matrix),稀疏性就会很低。

举个例子说明

假设有如下一个 3 × 3 的矩阵:

我们来看一下它的稀疏性:

-

零元素的个数:7

-

矩阵总元素数:9(3行 × 3列)

因此,稀疏性为:

这意味着这个矩阵中约有 77.8% 的元素是 0,我们可以称它为“稀疏矩阵”。

稀疏矩阵的优势

那么为什么稀疏性这么重要?它带来了以下几个实际意义:

1. 节省存储空间

传统的二维数组需要存储所有元素(包括0),而稀疏矩阵可以采用稀疏存储格式(如 CSR、COO、CSC 等)仅记录非零元素,从而节省大量空间。

2. 提升计算效率

在进行矩阵运算(如乘法、求逆等)时,跳过0的计算可以显著减少时间复杂度。

3. 更快的建模与训练速度

在机器学习和深度学习中,模型输入往往是高维稀疏数据(如文本TF-IDF向量),对其优化能极大提升训练速度。

应用场景

-

自然语言处理(NLP):如词袋模型(Bag-of-Words)构造出的特征矩阵通常非常稀疏。

-

推荐系统:用户评分矩阵中,大部分用户未对大部分物品评分。

-

计算机视觉:稀疏编码(Sparse Coding)用于图像压缩和特征提取。

-

图神经网络(GNN):图的邻接矩阵在大多数情况下是稀疏的。

稀疏性与稠密性的对比

| 特征 | 稀疏矩阵(Sparse) | 稠密矩阵(Dense) |

|---|---|---|

| 零元素比例 | 高 | 低 |

| 存储方式 | 稀疏格式 | 全元素存储 |

| 运算速度 | 快(适当优化) | 慢 |

| 内存占用 | 小 | 大 |

| 应用场景 | 文本、图、推荐系统等 | 图像、音频、模拟等 |

总结

稀疏性(Sparsity)是一个简单却非常实用的概念,用来衡量一个矩阵中零元素的比例。它不仅仅是一个数值,更是我们在数据建模和计算优化时的重要参考指标。了解稀疏性并有效地利用它,可以帮助我们构建更加高效、可扩展的系统。

彩蛋:图片中的公式总结

正如图中所展示的:

稀疏性 = 零元素的个数 ÷ 矩阵元素的总数

记住这个公式,当你下次遇到一个大矩阵时,不妨先看看它是不是“稀疏”的!

如果你想了解更多关于稀疏矩阵的存储格式、稀疏线性代数库(如SciPy Sparse)、或在机器学习框架中的应用,欢迎留言,我们可以继续深入讨论!

2389

2389

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?