参数 VS 超参数:机器学习模型中的核心概念详解

在机器学习中,"参数"(parameters)和"超参数"(hyperparameters)是两个非常基础却又容易混淆的概念。理解它们的区别和作用,是深入掌握机器学习的第一步。

本文将通过图示讲解这两个概念的不同,并结合实际例子和优化方法,帮助你建立清晰的认知框架。

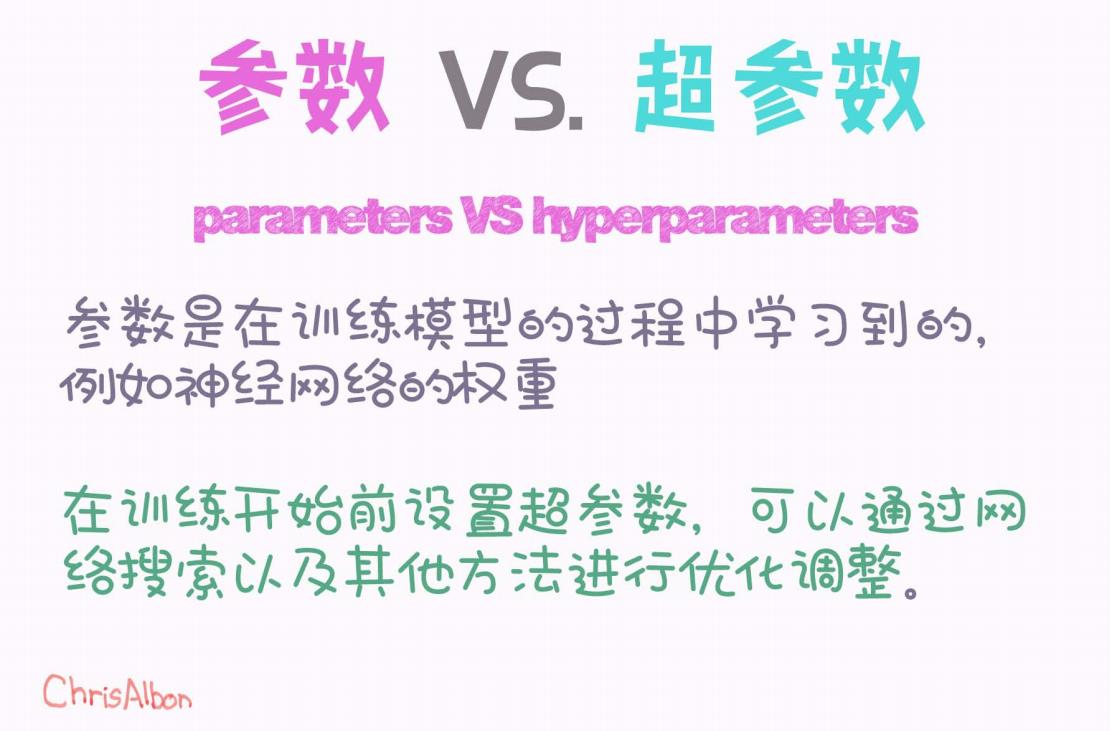

一、图解快速认识

图片内容简要说明:

-

参数(parameters):是在模型训练过程中由算法自动学习得到的,比如神经网络的权重。

-

超参数(hyperparameters):是在训练开始之前人为设定的,可以通过网格搜索、随机搜索等方式进行优化调整。

这张图用色彩鲜明的方式区分了两个概念的核心差异,并结合中文和英文术语双语标注,适合入门者快速建立感性认识。

二、什么是参数(Parameters)?

1. 定义

参数是模型在训练过程中,通过反向传播等机制从训练数据中学习到的数值,用于构建模型预测能力的核心。

2. 具体示例

以神经网络为例:

-

每一层的权重(weights)

-

偏置项(bias)

这些值是由训练数据决定的,不需要手动设置。在训练开始时,参数通常是随机初始化的,然后通过梯度下降等优化算法不断更新,最终得到使损失函数最小化的一组最佳参数。

3. 作用

参数的优劣直接决定了模型对数据的拟合能力。好的参数意味着模型能够从训练数据中学习出模式并进行泛化预测。

三、什么是超参数(Hyperparameters)?

1. 定义

超参数是在模型训练之前就需要人为设定的参数,它不会在训练过程中自动学习得到,而是直接影响模型训练的方式和结果。

2. 常见超参数举例

| 超参数名称 | 说明 |

|---|---|

| 学习率(learning rate) | 控制参数更新步长 |

| 批量大小(batch size) | 每次梯度更新使用的样本数量 |

| 训练轮数(epochs) | 数据集整体迭代训练的次数 |

| 神经网络的层数、每层神经元个数 | 决定模型的结构复杂度 |

| 正则化参数(L1/L2) | 控制过拟合的惩罚项 |

| 激活函数类型 | 如 ReLU、sigmoid、tanh 等 |

3. 如何设置和优化超参数?

设置超参数是一门艺术。可以使用以下方法:

-

网格搜索(Grid Search):尝试所有可能的超参数组合

-

随机搜索(Random Search):在设定的范围内随机选择组合

-

贝叶斯优化(Bayesian Optimization)

-

使用自动调参工具:如 Optuna、Hyperopt、Ray Tune

4. 作用

超参数决定了训练过程的质量和效率。例如,过高的学习率会导致模型发散,过小的学习率则可能导致训练速度太慢甚至陷入局部最优。

四、参数 VS 超参数:对比总结

| 对比点 | 参数(Parameters) | 超参数(Hyperparameters) |

|---|---|---|

| 决定方式 | 通过训练学习得到 | 训练前由人工设定 |

| 作用 | 决定模型的预测能力 | 决定模型训练的过程和效果 |

| 是否自动学习 | 是 | 否 |

| 优化方式 | 梯度下降、反向传播 | 网格搜索、随机搜索、贝叶斯优化等 |

| 示例 | 权重、偏置等 | 学习率、批大小、训练轮数、层数等 |

五、学习建议

对于初学者,以下建议可以帮助你更好地理解和使用参数与超参数:

-

多动手:多尝试调节模型的超参数,观察训练效果的变化。

-

使用可视化工具:如 TensorBoard 可以帮助你跟踪训练过程中的参数变化。

-

善用已有经验:查看优秀模型的超参数配置,作为调参起点。

-

避免过拟合与欠拟合:通过正则化、交叉验证等方式平衡模型复杂度。

六、结语

理解“参数”和“超参数”的区别,是你走进机器学习大门的重要一步。

-

参数是模型学习的结果

-

超参数是你赋予模型的“训练指导”

掌握二者的定义和调优方式,才能真正“驾驭”你的模型,而不是被模型牵着鼻子走。

843

843

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?