作为第八届 CCF 开源创新大赛的常规赛的赛题之一,第八届 CCF 开源创新大赛专项赛题 ——「开源 GPU 创新生态赛(常规赛)」第一期报名火热进行中。本次竞赛聚焦 GPU 底层算力革新与开源生态建设,HyperAI超神经是本次活动的官方合作社区,诚邀全球开发者共同攻坚。

作为第八届 CCF 开源创新大赛的常规赛的赛题之一,第八届 CCF 开源创新大赛专项赛题 ——「开源 GPU 创新生态赛(常规赛)」第一期报名火热进行中。本届大赛由中国计算机学会(CCF)主办,开源发展技术委员会(ODTC)承办。该赛事聚焦 GPU 技术与开源生态的深度融合,旨在推动国产算力创新及人工智能普惠化发展,吸引全球开发者、高校团队及企业共同探索 GPU 底层优化、算法加速与生态共建。面对大模型推理的「三高」困境(高延迟、高显存、高生态依赖),本次竞赛聚焦 GPU 底层算力革新与开源生态建设,HyperAI超神经是本次活动的官方合作社区,诚邀全球开发者共同攻坚。

具体而言,子赛题二——GPU 开源生态挑战赛,随着 AI 大模型规模不断扩大、推理需求急剧增长,如何高效释放国产 GPU 的算力潜能成为 AI 基础设施发展的关键问题。子赛题二覆盖大模型推理与服务框架方向,聚焦 vLLM、LMDeploy 等主流推理框架在国产 GPU 平台上的性能优化与适配,旨在推动高性能推理框架生态的本土化建设。

本赛题中,vLLM 以其高吞吐、低延迟的推理能力和灵活的架构设计,成为国产GPU推理生态的重要支撑之一。通过对 MACA 平台的深度适配,vLLM-MACA 实现了模型推理性能与系统兼容性的双提升,进一步完善了国产 GPU 软件栈的生态闭环。

为帮助开发者快速理解任务内容与评分细则,本文详细给大家介绍 vLLM 推理框架文档任务。涵盖环境验证、模型适配、特性测试与贡献机制等完整说明:

原文链接:

https://www.gitlink.org.cn/ccf-ai-infra/GPUApps/tree/main/mc_vLLM/task_level.md

一、前置说明

1. 提交要求:所有交付需提交至 MACA-vLLM 仓库的文档对应目录。

2. 参考资料:

vLLM 官方文档:

https://docs.vllm.ai

vLLM for MACA 版本社区文档:

https://vllm-metax.readthedocs.io/en/v0.11.0/

二、Level 1:

环境与基础验证类(5/10分)

1

核心目标

熟悉 vLLM-MetaX 基础环境开发,完成 MACA 平台上的模型推理验证。

2

任务内容

环境验证任务(5分)

* 使用 MACA 3.2.1 + PyTorch 2.6 镜像 完成 vLLM 源码安装;

* 检查环境变量配置及日志输出;

* 提交运行截图、验证日志至对应比赛的 Issue。

2. 代码编译构建文档完善并被合并(10分)

* 完善编译与构建文档,补充 MACA 环境下的依赖安装、环境变量配置及常见的编译错误解决方案;

* 提交验证文档参考

https://github.com/MetaX-MACA/vLLM-metax/pull/129

其中验证脚本提交至

https://github.com/MetaX-MACA/vLLM-metax/tree/master/docs/samples

并修改 supported_models.md

三、Level 2:

模型验证与适配类(5/15分)

1

模式验证清单

vLLM 官方模型支持列表:

https://docs.qq.com/sheet/DTkZWVGhBVWtKZHZU?tab=BB08J2

* 紫色标记的是已验证过可以在MACA-vLLM上支持的,故分值为5,若选手在验证过程中发现存在BUG并提出,可获得额外加分。

* 白色标记成功验证可在MACA-vLLM上支持,即得15分;若验证不成功提交详细日志和验证步骤也得15分。

核心目标:完成 vLLM 官方支持模型在 MACA 平台的验证。

2

任务内容

1. MACA-vLLM社区支持模型验证

* 参考 vLLM 官方模型支持列表的紫色标签部分;

* 验证 已列入 MACA 开源模型支持列表 能正确运行;

* 提交验证日志与推理结果截图;

* 验证离线推理(Offline Inference)与在线推理(Online Serving)均能正常运行;

* 计分标准:每完成 1 个模型验证得 5 分,单人上限 10 分,先到先得。

2. 不在 MACA 支持列表的模型验证(测试验证vLLM官方支持列表,并加入MACA 开源模型支持列表)

* 选择 在vLLM官方支持列表,但 MACA 开源模型支持列表暂未支持的模型,即表格中的白色标签部分;

* 尝试在 MACA-vLLM 上进行验证、复现或完善使用文档;

* 验证离线推理(Offline Inference)与在线推理(Online Serving)均能正常运行;

* 成功完成验证并提交对应验证文档合并到MACA开源模型支持列表的可得 15 分。

四、Level 3:

特性功能验证与 BUG 分析类(5/15分)

1

核心目标

验证 vLLM 关键特性在 MACA 上的实现情况,发现潜在兼容性问题。

2

任务内容

1. 特性验证任务

* 选择 1 项 vLLM 功能(如KV Cache、Quantization、LoRA、Paged Attention 等);

* 验证其在 MACA 平台是否可正常工作;

* 提供完整测试步骤与日志;

* 首次验证通过计 5 分,单人上限 10 分。

2. BUG 复现任务

* 找出 MACA 平台与 CUDA 平台差异导致的特性不支持问题或 BUG;

* 提供复现方法与详细日志;

* 若能定位问题原因并提交详细分析,得 15 分。

五、Level 4:

开发与贡献类(50分)

1

核心目标

完成特性修复、性能优化或完整案例开发,实现对 MACA 平台的增强贡献。

2

任务内容

BUG 修复与 PR 提交

* 找出 vLLM 在 MACA 平台的核心问题;

* 提供复现步骤、问题定位及修复代码;

* 提交可合并的 PR 并通过 Review;

* 合并后得 50 分。

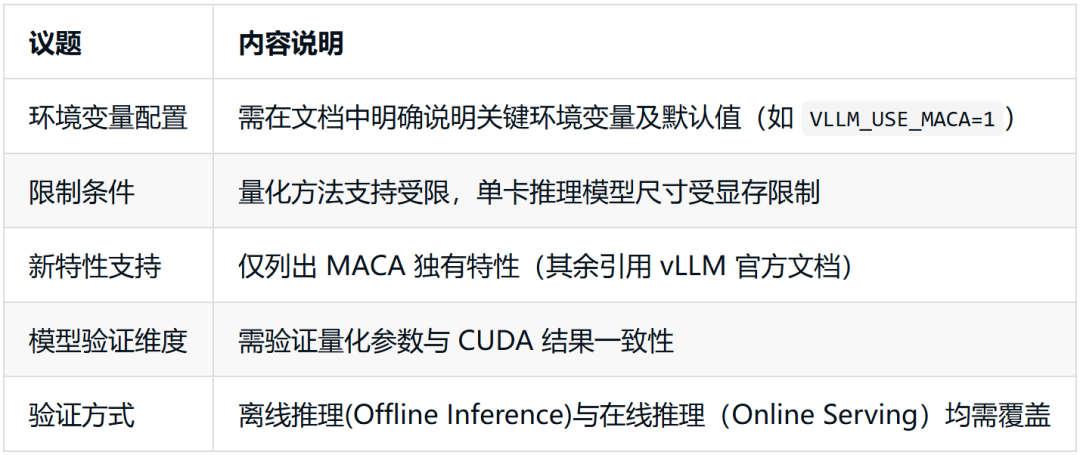

六、补充说明

七、附录与参考链接

* vLLM 官方支持模型列表

https://docs.vllm.ai/en/latest/models/supported_models/

* vLLM-MetaX 官方站点

https://vllm-metax.readthedocs.io/en/latest/getting_started/quickstart.html

* vLLM-MetaX GitHub 仓库

https://github.com/MetaX-MACA/vLLM-metax

* MACA Hardware Supported Models

https://github.com/MetaX-MACA/vLLM-metax/blob/v0.11.0-dev/docs/models/supported_models.md

模型验证清单共享文档

为便于选手认领验证任务、统一记录模型适配进度,现已开放模型验证共享表格:vLLM-MACA 模型验证清单。

【腾讯文档】开源 GPU 创新生态赛赛题二-vLLM 社区模型验证:

https://docs.qq.com/sheet/DTkZWVGhBVWtKZHZU?tab=BB08J2

欢迎各位开发者认领模型验证任务、提交运行日志,共同完善国产GPU上的vLLM生态适配。

vLLM-MACA的适配与优化,不仅展示了开源社区在大模型推理方向的技术积累,也标志着国产GPU生态在AI基础软件层的又一次突破。期待更多开发者加入 MACA 社区,共同探索高性能推理框架的无限可能,为中国算力生态注入创新力量。

赛事奖金设置

赛事安排

报名时间:2025 年 09 月 15 日-12 月 10 日

赛事时间:2025 年 09 月 15 日-12 月 10 日

赛事评审:2025 年 12 月 10 日-12 月 20 日

结果发布:2025 年 12 月 21 日-12 月 30 日

赛事报名

报名链接:

https://www.gitlink.org.cn/competitions/gitlinkGPU1

进入报名页面了解更多赛事详情介绍

报名二维码:

赛事答疑群:

扫码进入赛事群

获取答疑支持和赛事最新资讯

组织机构

主办单位:中国计算机学会

承办单位:CCF开源发展技术委员会

公益支持:中国光华科技基金会

合作伙伴:ODTC AI Infra工作组、模力方舟、木兰开源社区、书生、上海开源信息技术协会、机智流、魔乐社区、飞桨、上海源庐加佳信息科技有限公司、龙蜥社区、HyperAI超神经

一键获取 2023—2024 年 AI4S 领域高质量论文及深度解读文章 ⬇️

往期推荐

戳“阅读原文”,免费获取海量数据集资源!

12万+

12万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?