关注、星标公众号,精彩内容每日送达

来源:网络素材自从春节以来,DeepSeek的热度一直攀升,但很多同学对DeepSeek的相关部署和操作还不熟悉,于是小枣君奋笔疾书,完成了以下本地部署DeepSeek保姆级别的教学,大家可以直接在自己的笔记本电脑上按照如下教程进行部署操作,不需要有代码基础,只要一比一按照如下步骤进行操作即可!

一共三个步骤,10-15分钟完成!

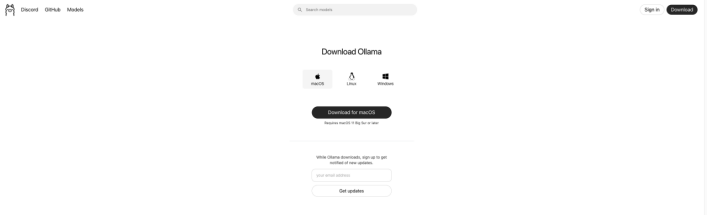

█ 第一步:按照自己的系统安装ollama

网址:https://ollama.com/download

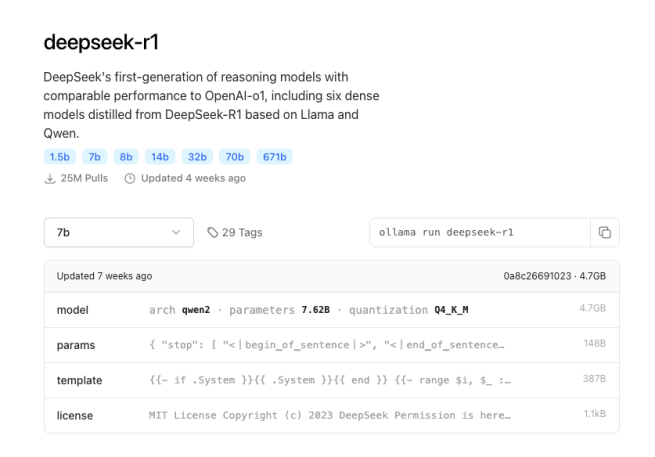

█ 第二步:在ollama官网搜索DeepSeek模型

https://ollama.com/

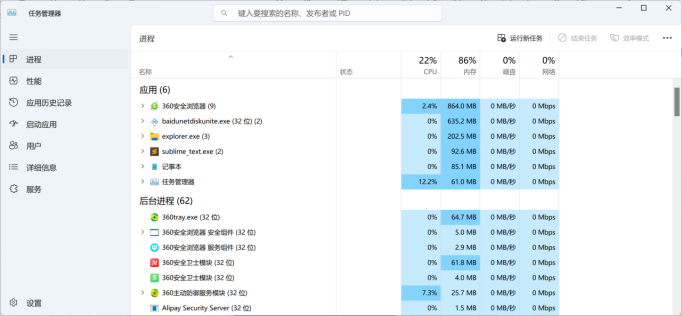

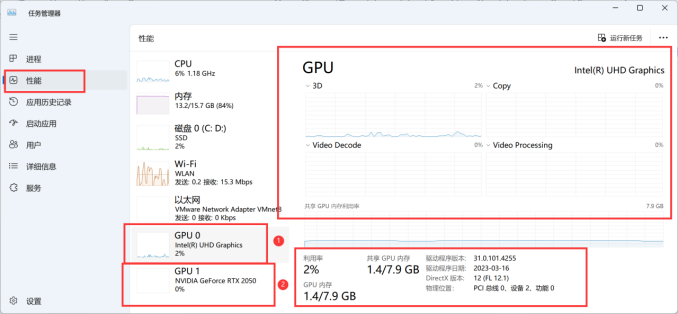

模型大小与显卡需求(这里大家需要根据自己电脑的显存进行对应模型的下载,显存的查看方式,任务管理器—性能)

如果感觉太麻烦,可以跳过这一步,直接下载最小的1.5b的模型即可,嘿嘿~(因为下面的在终端执行的命令也是按照1.5b来的)

最后一步!坚持住,输入完下面这行代码,就成功了!

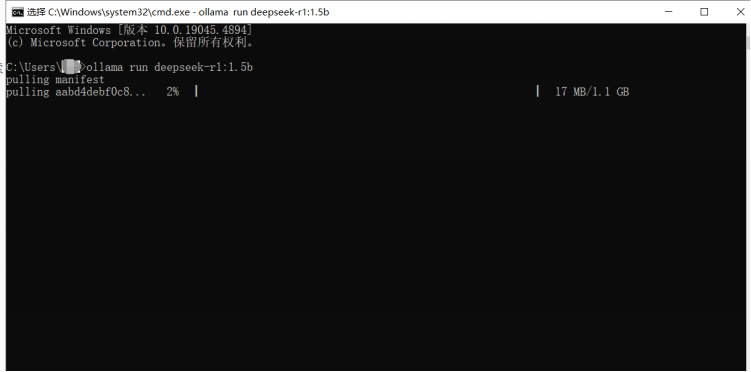

█ 第三步:在终端执行命令

ollama run deepseek-r1:1.5b

等待安装即可

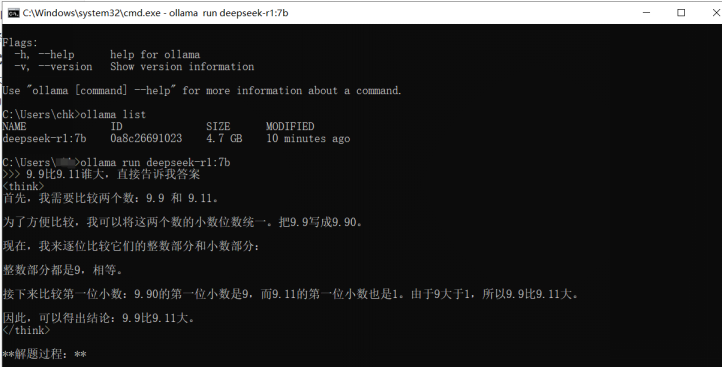

接下来,就可以在终端对话框里面和DeepSeek进行交流了!快去试试吧~

(全文完)

想要了解FPGA吗?这里有实例分享,ZYNQ设计,关注我们的公众号,探索

5495

5495

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?