一、测试环境

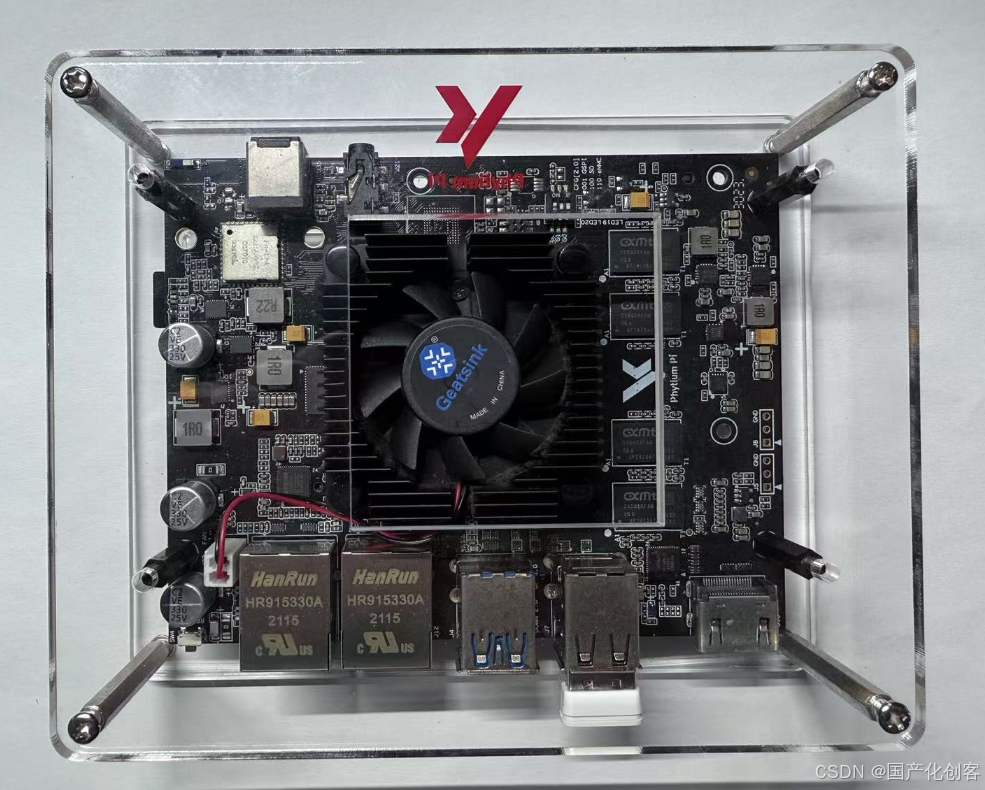

本测试使用的飞腾派开发板,主板处理器采用飞腾定制四核处理器,该处理器兼容 ARM V8 指令集,包含 2 个 FTC664 核和 2 个 FTC310 核,其中 FTC664 核主频可达 1.8GHz,FTC310 核主频可达 1.5GHz。主板板载 4G容量的64 位 DDR4 内存,支持 SD 或者 eMMC 外部存储。

本次测试使用飞腾公司基于板卡定制的Linux操作系统飞腾派OS(Phytium Pi OS),它是运行在飞腾派开发板上的深度定制的Linux系统(基于Debian11)。它针对飞腾派开发板的硬件定制了内核配置,不同的软件包,可以更好的适应不同的场景。它可以烧录在SD卡中,作为飞腾派开发板的启动系统。

二、安装ollama

部署DeepSeek要用到 Ollama,它支持多种大模型。针对网络下载情况,可以提供ollama的离线安装包和在线安装两种方法。

Ollama官网:ollama.com

方法一:在线下载,只需要输入下载指令即可进行在线安装。

curl -fsSL https://ollama.com/install.sh | sh方法二:离线安装包,在⽹盘中下载 ollama-linux-arm64.tgz ,解压到指定路径

sudo tar -xzvf ollama-linux-arm64.tgz -C /usr/通过网盘分享的文件:ollama && deepseek

链接: https://pan.baidu.com/s/1FhBZOe1Y5UnI0cqKDMetXw?pwd=avbk 提取码: avbk

ollama安装包解压后约为3GB,内容如下。通过如下命令复制到系统对应目录:

sudo cp bin/* /bin

sudo cp lib/* /lib

三、配置ollama

配置组

sudo useradd -r -s /bin/false -m -d /usr/share/ollama ollama

sudo usermod -a -G ollama $(whoami)创建服务,使⽤ vim 创建 /etc/systemd/system/ollama.service 并加⼊以下内容

[Unit]

Description=Ollama

ServiceAfter=network-online.target

[Service]

ExecStart=/usr/bin/ollama serve

User=ollama

Group=ollama

Restart=always

RestartSec=3

[Install]

WantedBy=default.target启动服务器

sudo systemctl daemon-reload

sudo systemctl enable ollama

sudo systemctl restart ollama查看 ollama 服务,可以看到已经正常启动

四、安装deepseek模型

Ollama支持多种DeepSeek模型版本,用户可以根据硬件配置选择合适的模型。因为开发板硬件

DeepSeek 模型版本

DeepSeek Coder1:是 DeepSeek 于 2023 年 11 月 2 日推出的代码大模型,已开源 1B、7B、33B 全系列模型,包含 Base 模型和指令调优模型。

DeepSeek-R1 系列2:有 1.5B、7B、8B、14B、32B、70B 和 671B 等版本,其中 1.5B、7B、8B、14B、32B、70B 是蒸馏后的小模型,671B 是基础大模型。

DeepSeek-V1:主打自然语言处理和编码任务,支持多种编程语言,有 128K 标记的上下文窗口。

DeepSeek-V2:搭载 2360 亿个参数,采用 MoE 架构,训练成本仅为 GPT-4-Turbo 的 1%,开源免费。

DeepSeek-V2.5:在创作、问答、数学推理和编码能力方面都有所提升,还加入了联网搜索功能。

DeepSeek-V33:采用创新 MoE 架构,支持 FP8 混合精度训练,参数规模达 6710 亿,生成速度相比 V2.5 提升至 3 倍,支持 128k 上下文窗口。

对硬件环境的要求

DeepSeek 1.5B:CPU 最低 4 核,内存 8GB+,硬盘 3GB + 存储空间,显卡非必需,若需 GPU 加速可选 4GB + 显存。

DeepSeek 7B:CPU 8 核以上,内存 16GB+,硬盘 8GB+,显卡推荐 8GB + 显存。

DeepSeek 8B:硬件需求与 7B 相近略高。

DeepSeek 14B:CPU 12 核以上,内存 32GB+,硬盘 15GB+,显卡 16GB + 显存。

DeepSeek 32B:CPU 16 核以上,内存 64GB+,硬盘 30GB+,显卡 24GB + 显存。

DeepSeek 70B:CPU 32 核以上,内存 128GB+,硬盘 70GB+,显卡需多卡并行。

首次运行deepseek-r1:1.5b,会自动在线下载模型。

ollama run deepseek-r1:1.5b由于近期DeepSeek太火爆,在线下载过于拥堵可能会出现失败的情况,可从网盘中下载模型,复制到开发板,解压到 /usr/share/ollama/.ollama/models/目录

sudo tar -xzvf models.tar.gz -C /usr/share/ollama/.ollama通过网盘分享的文件:ollama && deepseek

链接: https://pan.baidu.com/s/1FhBZOe1Y5UnI0cqKDMetXw?pwd=avbk 提取码: avbk

显示系统模型列表:

user@phytiumpi:~$ ollama list

NAME ID SIZE MODIFIED

deepseek-r1:1.5b a42b25d8c10a 1.1 GB 2 weeks ago五、运行deepseek

deepseek-R1 1.5b安装成功后,再次输入启动指令:

ollama run deepseek-r1:1.5bdeepseek进行对话:

系统的硬件资源使用情况,因为E2000是一个嵌入式处理器,调用AI模型时对CPU的占用基本100%,对一些问题思考输出也不是很快。

六、Chatbox前端调用

通过前面的操作,已经部署好DeepSeek,但每次使用都要在终端里操作,相当繁琐。这里可以借助Chatbox,实现网页或客户端操作。

下述的方式是开发板本机运行Chatbox,比较占用系统资源,deepseek运行效率明显比终端中对话运行慢。建议使用Chatbox调用远程ollama服务功能。

下载安装Chatbox

Chatbox官网:chatboxai.app/zh

进入官网下载安装Chatbox客户端。这里下载Linux的ARM64架构版本。

下载完成后,把软件包复制到开发板系统,增加文件可执行权限。命令行执行运行app文件。(这里是通过windows系统ssh登录到开发板,运行Linux系统中的CharBox后会在windows启动界面程序)

user@phytiumpi:~$ chmod +x Chatbox-1.9.8-arm64.AppImage

user@phytiumpi:~$ ./Chatbox-1.9.8-arm64.AppImage

点击设置,选择Ollama API,选择安装好的deepseek r1模型,保存即可。

设置完成后,可以通过Chatbox跟deepseek对话。

1465

1465

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?