能将二次元老婆拉进现实,成为你的专属女友。本文将带你深入了解ControlNetLineArt模型的使用方法,助你轻松实现这一梦想。

ControlNet LineArt模型是StableDiffusion的最新进阶版本,它能够将二次元动漫人物以LineArt的形式生成现实中的照片。这一功能的出现,让二次元老婆瞬间变得触手可及,成为现实中的女友。

其实在很早之前我曾和我的爸妈说过我找了一个喜欢玩cos的女朋友,并借此申请了一些经费用于购买服饰啥的。

当然我没有说谎,我真的拿去买新衣服了,也是买给我的老婆“们”的。

我也用了一些Stable Diffusion的小技巧画出了一张张cos图,虽然每张图片长得都有丢丢不太一样不过好在我爸妈那边是过关了。

当然后续还是得学习一下怎么炼模型好让自己的图片产出不要差别太大,但是这个不是今天的主题。

前段时间可能大伙都听过了海贼王的真人版开播

有很多人觉得这是难得的真人比较符合动漫形象的漫改,而在更早期就有人用AI制作出了他们心目中海贼王在现实里的形象。

大部分是利用类似于Lora不断地喂养素材,让AI能够更好地画出一个“coser”而不是本人。

而今天的内容则是学习如何利用ControlNet LineArt模型及其应用原理,从而实现真人化转绘、线稿填色、三维渲染等以前我想都不敢想的操作。

看到这里相信各位都已经迫不及待准备将“老婆们”带进三次元世界,那我也就不卖关子让我们开始今天的学习吧!

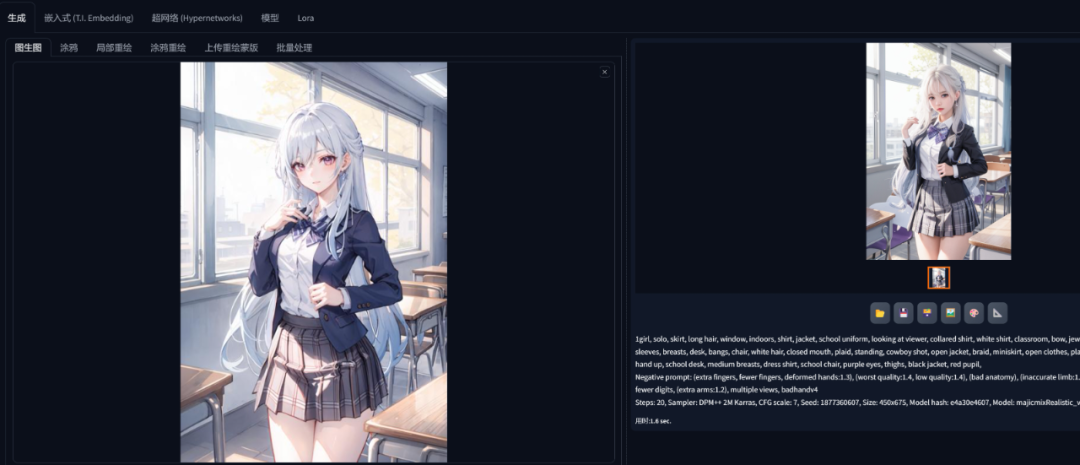

图生图转绘

到目前为止学会的知识点中直接用图生图功能进行三次元转绘是最简单的方法,也就相当于AI在原图的基础上进行关键元素的抽取,然后根据这些元素再进行重绘。

而像是一些模型例如我比较喜欢的majic

这类模型都会喂养大量的真实人物图片,AI就可以根据这些图片绘画出十分贴近现实的人物图像了。

当然这步骤也很简单,只需要跟着我操作就行。

第一步:挑选一张合适的角色原图

将这张图导入图生图中,这个时候可以自己填写提示词或者利用DeepBooru反推功能进行提示词的反推。

又或者可以用WD1.4 标签器这个插件进行提示词反推,不过记得删改那些觉得不合适的提示词。

第二步:选择合适的模型

-

像是MajicMix Realistic适合东亚面孔以及年轻的女性,就很适合绝大部分符合东南亚审美的角色。

-

而Realistic Vision则适合西方面孔以及男性角色,会显得比较硬朗的那种。

-

A-Zovya Photoreal则适合非亚洲面孔以及一些少数族裔面孔。

第三部:参数的调整

因为是重绘,所以下方的重绘幅度不适合过高(小于0.5),之后点击生成就可以得到一份“三次元”写真了!

这么看下来效果其实还ok,不过图生图这么用还是有些不足的地方,最直观的就是图片清晰度不够从而细节方面有些对不上号。

例如这个椅子、发夹、胸前的头发等,如果想要让生成的结果更符合预期,那么还得给AI来点猛的。

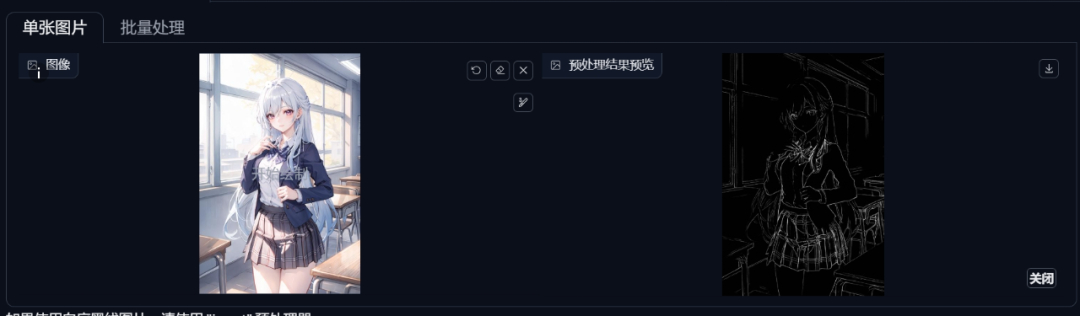

ControlNet LineArt

ControlNet这东西蛮早就学习过了,在后续其他知识点的学习运用中也不止一次地出现,究其原因还是太好用了。

ControlNet可以将图像中人物的姿势、画面细节等东西提炼出来塞给AI,目前的ControlNet有着18种控制类型以及数不清的新模型和预处理器。

而这篇文章的主力也就是之前提起过的老朋友-LineArt线稿,这功能本质上是一种基于边缘萧条的图像控制引导。

也就是将一幅画的人物轮廓等画成一张线稿图,然后在根据这幅线稿图重新绘画,这样就起到了固定形体和细节特征。

来到下方的ControlNet后选择启用,在图生图中不需要再单独上传图像,如果需要的话也可以上传。

选择Lineart线稿并且选择动漫线稿提取,其余的参数就不变动了,直接点击生成。

在有了线条的指引之后可以看出AI绘画的图片更加接近原作的效果。

而在上面选择了动漫线稿的预处理器可以看出其绘画出来的效果是这样的:

点击下方预处理器右边爆炸的按钮

而不同逻辑的预处理器识别线条也会有所差异,二次元转真人选择lineart_anime就对了,选择去噪的那个则会让线条更精细些。

如果是从真实照片中提取线条就选择Realistic,这一般用于真人转动漫的绘画。

Standard和Invert一般用于真正的白底黑线“线稿图”,这两个起到反色的作用,将白底黑线的线稿图转化为AI可以识别的黑底白线。

而Coarse则是可以让AI有更多创作空间,因为这个选项会让线稿没那么细致,AI就可以自己发挥了。

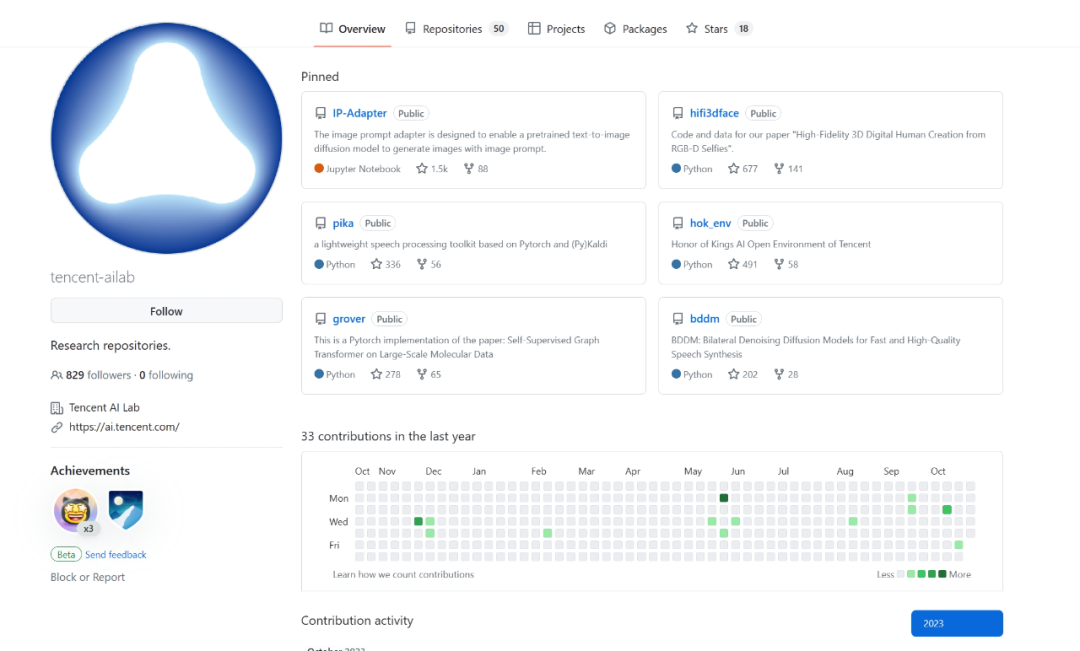

IP-Adapter

如果就到此结束今天的内容就有点少了,对于二次元角色而言有着多套衣服是很正常的事情,而这个全新的IP-Adapter控制模型也就是这一部分内容的主角。

这个IP-Adapter是由腾讯AI实验室开发的图片生成项目

在以往的学习中往往只能通过提示词的方式来向AI传递一些内容方面的信息,图生图功能严格意义上来说更像是复制色彩上的相似性。

而IP-Adapter则会真正地去理解这张图片的含义,并用学习到的东西去微调输出的结果,从而让结果无论是色彩、形象上都更像输入的那张参考图。

当IP-Adapter与其他模型组合起来的时候就可以起到“画风迁移”的效果,接下来看一下演示的效果就知道了。

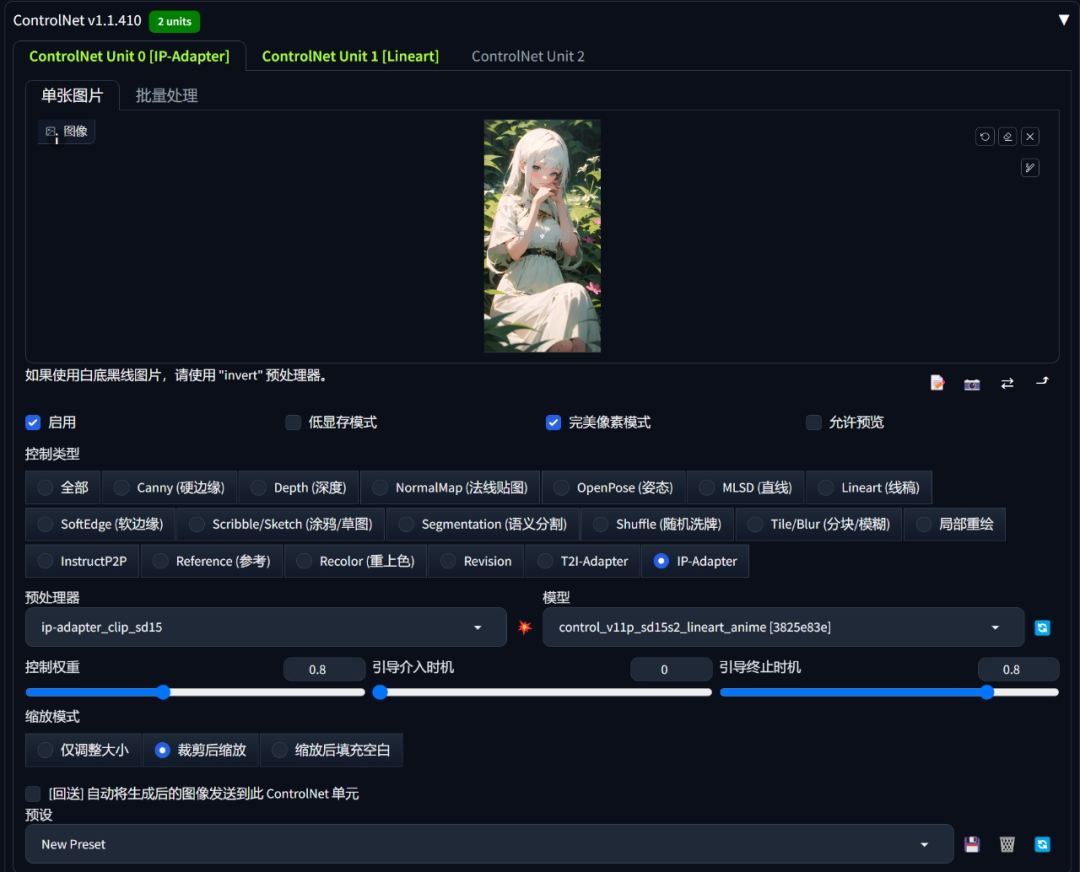

第一步:进入到文生图,在ControlNet的第一个窗口中导入想要制定的风格参考图

控制权重和引导终止时机一般设置在0.8会比较好,这样AI就不会过度发挥

第二步:打开第二个ControlNet Unit将角色原图导入进去

第二个Unit还是选择LineArt就可以了

第三步:选择与原图画风相似的模型

大部分二次元模型都可以,这个看自己选图的结果。

第四步:输入提示词,然后点击生成。

提示词中可以适当补充与该灵感相关的描述,例如我上面例图中绿色,白毛等等。

这里我借用原教程作者演示的图片,我发现目前而言LineArt与IP-Adapter结合的话像是作者例图的纯白背景人物图会比较不容易出错。

也就是白色的背景加上色调没那么杂乱的类似于人物设定图的比较好生成,而我尝试了几次用的图颜色都比较丰富并且结果也不稳定,当然也可能是我自己操作漏了或者什么情况,这个还需要我再研究研究。

看到这里可以发现其实IP-Adapter像是一个一键换肤的功能,可以帮助二次元角色进行风格的更换:

今天的内容就到这里结束啦!

主要是一个LineArt和IP-Adapter的学习使用,当然后面还有一小部分我放在下篇文章中去学习。

在LineArt将二次元图像转换为三次元之后就可以拿去超分放大,这样一来细节不足的地方也就可以弥补上了。

那么大伙下篇笔记见,拜了个拜!

但由于AIGC刚刚爆火,网上相关内容的文章博客五花八门、良莠不齐。要么杂乱、零散、碎片化,看着看着就衔接不上了,要么内容质量太浅,学不到干货。

这里分享给大家一份Adobe大神整理的《AIGC全家桶学习笔记》,相信大家会对AIGC有着更深入、更系统的理解。

有需要的朋友,可以长按下方二维码,免费领取!

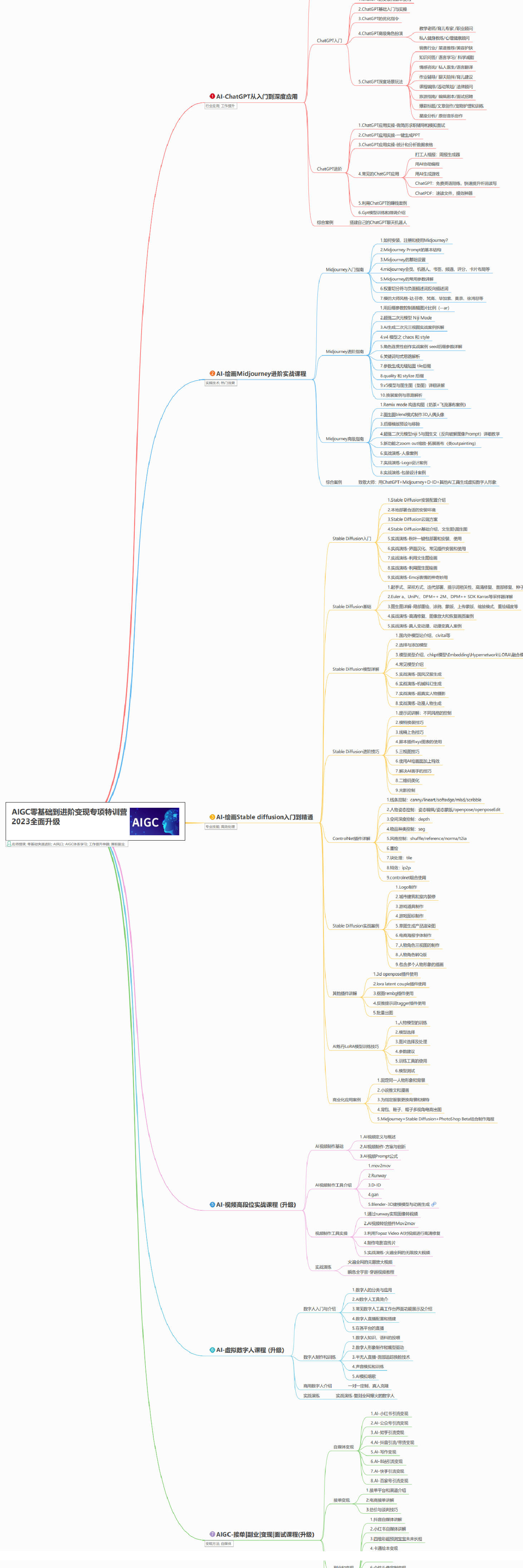

AIGC所有方向的学习路线思维导图

这里为大家提供了总的路线图。它的用处就在于,你可以按照上面的知识点去找对应的学习资源,保证自己学得较为全面。如果下面这个学习路线能帮助大家将AI利用到自身工作上去,那么我的使命也就完成了:

AIGC工具库

AIGC工具库是一个利用人工智能技术来生成应用程序的代码和内容的工具集合,通过使用AIGC工具库,能更加快速,准确的辅助我们学习AIGC

有需要的朋友,可以点击下方卡片免费领取!

精品AIGC学习书籍手册

书籍阅读永不过时,阅读AIGC经典书籍可以帮助读者提高技术水平,开拓视野,掌握核心技术,提高解决问题的能力,同时也可以借鉴他人的经验,结合自身案例融会贯通。

AI绘画视频合集

我们在学习的时候,往往书籍源码难以理解,阅读困难,这时候视频教程教程是就很适合了,生动形象加上案例实战,科学有趣才能更方便的学习下去。

有需要的朋友,可以长按下方二维码,免费领取!

825

825

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?