Windows系统基于ollama+anythingLLM本地化部署deepseek

一、写在前面

本方法对计算机硬件有一定要求,如本机硬件性能有限,可调用第三方api方式进行部署,操作文档稍后更新。

二、下载、安装ollama

官网下载:打开ollama官网,点击Download,选择相应操作系统下载。如下载出现网络问题可使用百度网盘下载:

链接: https://pan.baidu.com/s/1Bc69x3N5Ey_egJt1aZ4Ecg?pwd=9jc5 提取码: 9jc5(OllamaSetup.exe),下载后按提示正常安装软件即可。

安装成功后无提示,系统右下角出现ollama图标即表示安装成功。

三、下载并运行deepseek-r1模型。

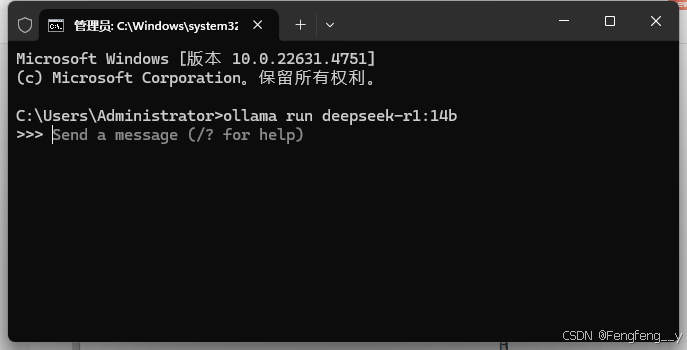

1.键盘键入win+R 键,输入CMD,点击确定或按回车键进入命令行。

2. 命令行中输入 ollama run deepseek-r1:14b,初次运行会自动下载模型并运行,其中14b为模型参数,目前deepseek主流模型参数为:1.5b、7b、8b、14b、32b、70b、671b。模型运行成功后如下图所示,此时可以在会话框中与deepseek进行交互。

四、下载anythingLLM,安装、配置

官网: https://anythingllm.com/desktop 下载或网盘:

https://pan.baidu.com/s/1fs8EnjXBwup6f3ZONOzVeg?pwd=pqj1 提取码: pqj1 下载,下载后双击安装软件,选择用户并单击下一步

选择安装目标文件夹,单击安装。

安装出现如下报错可忽视,点击确定即可。

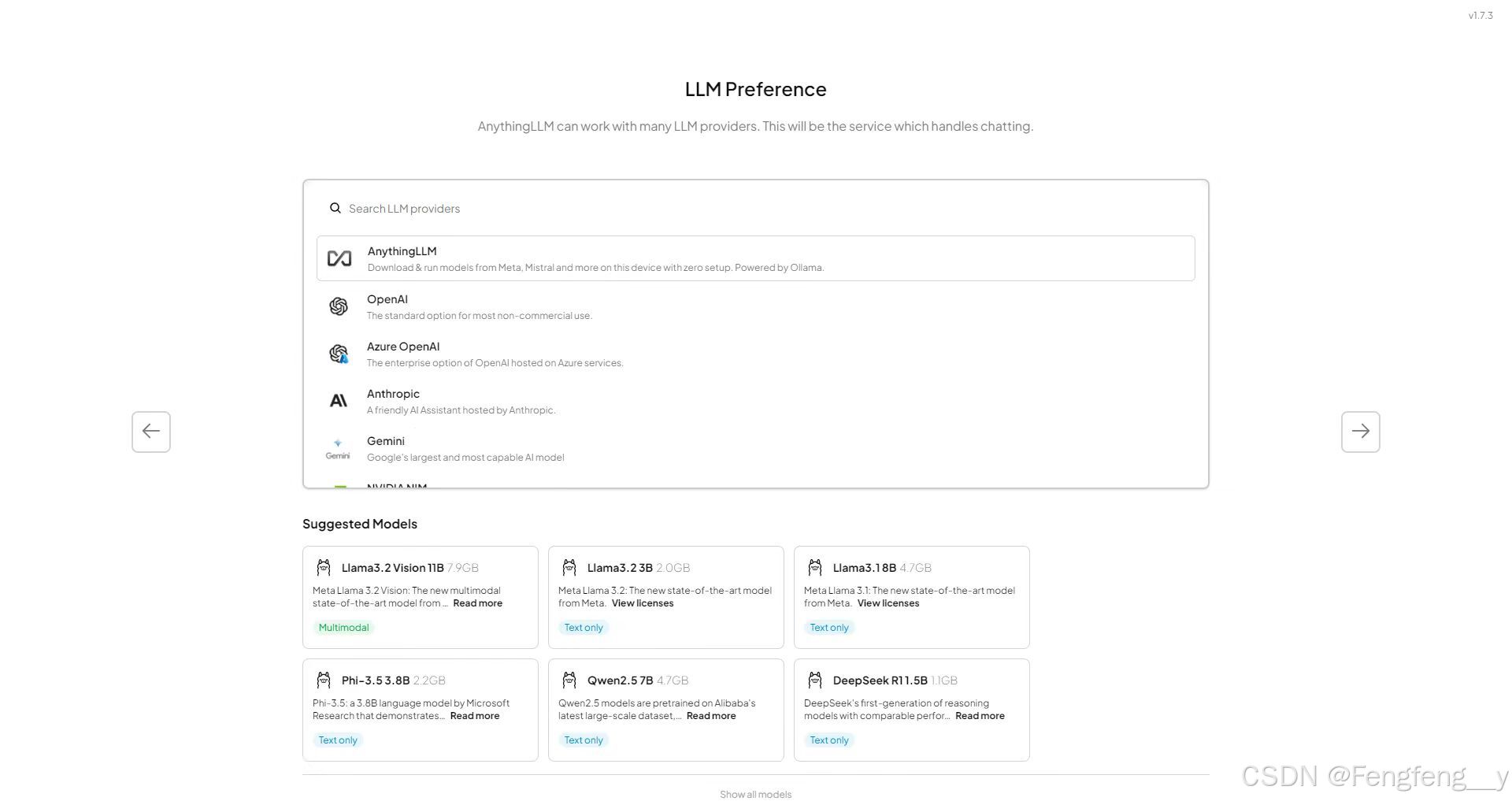

点击:Get started,右侧下一步。

下滑选择ollama,右侧下一步。

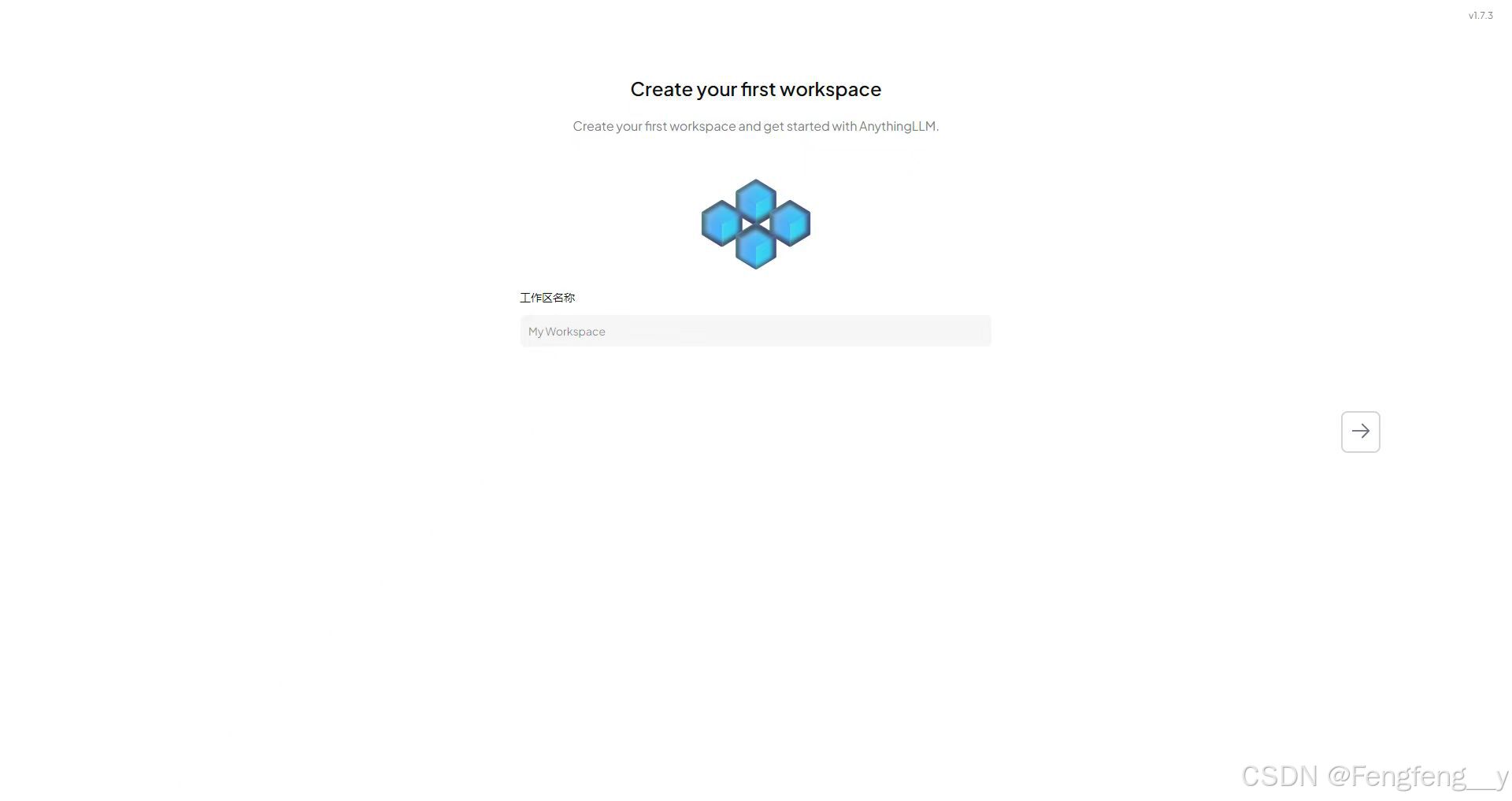

持续下一步,直到输入工作区名称,下一步,即可开始体验与大模型交互。

五、anythingLLM知识库导入、配置修改说明

点击左下角设置图标

确认各项参数与下图一致,若不一致请按下图更正。

确认一致后单击左下角返回按钮回到首页,在相应工作区中将本地文件上传至大模型,即可进行提问测试。

接下来请开始探索您的大模型之旅吧~

64

64

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?