前言

刚好有空顺便整理一下以前学习pytorch的笔记,做一个梳理,便于后面的学习~

在学习pytorch之前,建议可以先掌握numpy,本质上来说,最早的版本来说,pytorch其实是numpy的增强,让矩阵可以在GPU里面运行,之后具备自动求导的特性,也就是咱们的梯度,学过线性回归的朋友应该知道,我们是通过损失函数来计算修正我们的未知参数的,那么在这里手算的话我们就需要求导,那么在pytorch里面肯定不是直接求导,而是通过记录变化值,也就是通过当前参数的变化值来进行反向修改。那么这个东西就叫做梯度,可以正向传播,也可以反向传播。

之后就是pytorch官方给咱们提供的一些API,例如自制数据集,常用神经网络,CNN 卷积核等。

环境

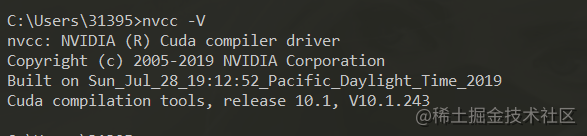

这里注意一下,我的环境是Windows10,N卡,装的pytorch版本是GPU版本,CUDA驱动版本是10.1(10.2也是一样的)

可以看到,我这边的显卡是GTX1650

没有显卡的朋友不要慌,我们可以使用谷歌实验室,当然你得会那啥。免费,一个礼拜30个小时的使用时长,代码你可以在本地写好,然后改成GPU版本,放到实验平台先跑一下,能过,然后在完整地训练一下。

本文提供了一天内快速上手PyTorch的教程,涵盖了环境配置、Tensor基础知识、数据加载与转换、TensorBoard可视化、CIFAR10网络搭建和模型部署等。讲解了Tensor的梯度计算、numpy与Tensor的转换,以及如何在GPU上运行。此外,还介绍了数据处理、使用TensorBoard进行训练过程的可视化,以及模型的训练、保存和加载。最后,讨论了模型部署到Django应用的方法。

本文提供了一天内快速上手PyTorch的教程,涵盖了环境配置、Tensor基础知识、数据加载与转换、TensorBoard可视化、CIFAR10网络搭建和模型部署等。讲解了Tensor的梯度计算、numpy与Tensor的转换,以及如何在GPU上运行。此外,还介绍了数据处理、使用TensorBoard进行训练过程的可视化,以及模型的训练、保存和加载。最后,讨论了模型部署到Django应用的方法。

订阅专栏 解锁全文

订阅专栏 解锁全文

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?