SVM简介

SVM,Support Vector Machine,它是一种二分类模型,其基本模型定义为特征空间上的间隔最大的线性分类器,其学习策略便是间隔最大化,最终可转化为一个凸二次规划问题的求解。

这里涉及了几个概念,二分类模型,线性分类器,间隔最大化,凸二次规划问题。

- 二分类模型:给定的各个样本数据分别属于两个类之一,而目标是确定新数据点将归属到哪个类中。

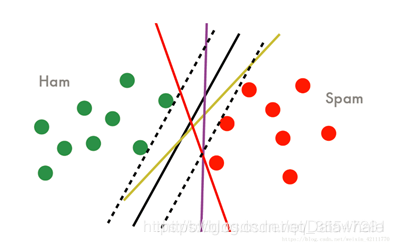

- 线性分类器:分割样本点的分类器是一个超平面,这也就要求样本线性可分,这是hard-margin SVM的要求,对于后来的soft-margin SVM,放低为近似线性可分,再到后来的核技巧,要求映射到高维空间后要近似线性可分。

- 线性可分: D 0 D0 D0和 D 1 D1 D1是 n n n维欧氏空间中的两个点集(点的集合)。如果存在 n n n维向量 w w w和实数 b b b,使得所有属于 D 0 D0 D0的点 xi 都有 w x i + b > 0 wx_i+b>0 wxi+b>0,而对于所有属于 D 1 D1 D1的点 x j x_j xj则有 w x j + b < 0 wx_j+b<0 wxj+b<0。则我们称 D 0 D0 D0和 D 1 D1 D1线性可分。

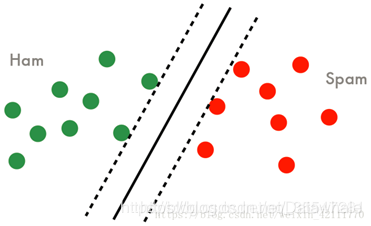

- 间隔最大化:首先要知道SVM中有函数间隔和几何间隔,函数间隔刻画样本点到超平面的相对距离,几何间隔刻画的是样本点到超平面的绝对距离,SVM的直观目的就是找到最小函数距离的样本点,然后最大化它的几何间隔。

- 凸二次规划:目标函数是二次的,约束条件是线性的。

核心公式

- 线性可分训练集: T = { ( x 1 , y 1 ) , ( x 2 , y 2 ) , … , ( x n , y n ) } T=\left\{\left(x_{1}, y_{1}\right),\left(x_{2}, y_{2}\right), \ldots,\left(x_{n}, y_{n}\right)\right\} T={ (x1,y1),(x2,y2),…,(xn,yn)}

- 学习得到的超平面: w ∗ T x + b ∗ = 0 w^{* T} x+b^{*}=0 w∗Tx+b∗=0

- 相应的分类决策函数: f ( x ) = sign ( w ∗ T x + b ∗ ) f(x)=\operatorname{sign}\left(w^{* T} x+b^{*}\right) f(x)=sign(w∗Tx+b∗)

- SVM基本思想:间隔最大化,不仅要讲正负类样本分开,而且对最难分的点(离超平面最近的点)也要有足够大的确信度将他们分开。

函数间隔

给定一个超平面 ( w , b ) (w, b) (w,b),定义该超平面关于样本点 ( x i , y i ) (x_i,y_i ) (xi,yi) 的函数间隔为: γ ^ i = y i ( w T x i + b ) \widehat{\gamma}{i}=y{i}\left(w^{T} x_{i}+b\right) γ i=yi(wTxi+b) 定义该超平面关于训练集 T T T的函数间隔为: γ ^ = min i = 1 , 2 , … , N γ ^ i \widehat{\gamma}=\min {i=1,2, \ldots, N} \widehat{\gamma}{i} γ =mini=1,2,…,Nγ i

几何间隔

给定一个超平面 ( w , b ) (w, b) (w,b),定义该超平面关于样本点 ( x i , y i ) (x_i,y_i ) (xi,yi) 的几何间隔为: γ i = y i ( w T ∣ w ∣ x i + b ∣ w ∣ ) \gamma_{i}=y_{i}\left(\frac{w^{T}}{|w|} x_{i}+\frac{b}{|w|}\right) γi=yi(∣w∣wTxi+∣w∣b) 定义该超平面关于训练集 T T T的几何间隔为: γ = min i = 1 , 2 , … , N γ i \gamma=\min {i=1,2, \ldots, N} \gamma{i} γ=mini=1,2,…,Nγi

函数间隔与几何间隔的关系

γ i = γ ^ i ∣ w ∣ , i = 1 , 2 , … , N γ = γ ^ ∣ w ∣ \begin{array}{c}{\gamma_{i}=\frac{\hat{\gamma}_{i}}{|w|}, i=1,2, \ldots, N} \ {\gamma=\frac{\hat{\gamma}}{|w|}}\end{array} γi=∣w∣γ^i,i=1,2,…,N γ=∣w∣γ^

间隔最大化

- 求得一个几何间隔最大的分离超平面,可以表示为如下的最优化问题:

max w , b γ s.t. y i ( w T ∣ w ∣ x i + b ∣ w ∣ ) ≥ γ , i = 1 , 2 , … , N \begin{array}{c}{\max {w, b} \gamma} \ {\text {s.t.} y{i}\left(\frac{w^{T}}{|w|} x_{i}+\frac{b}{|w|}\right) \geq \gamma, i=1,2, \ldots, N}\end{array} maxw,bγ s.t.yi(∣w∣wTxi+∣w∣b)≥γ,i=1,2,…,N- 考虑函数间隔与几何间隔的关系式,改写为:

max w , b γ ^ ∣ w ∣ s.t. y i ( w T x i + b ) ≥ γ ^ , i = 1 , 2 , … , N \begin{array}{c}{\max {w, b} \frac{\hat{\gamma}}{|w|}} \ {\text {s.t. } y{i}\left(w^{T} x_{i}+b\right) \geq \hat{\gamma}, i=1,2, \ldots, N}\end{array} maxw,b∣w∣γ^ s.t. yi(wTxi+b)≥γ^,i=1,2,…,N- 等价与下式

max w , b 1 ∣ w ∣ s.t. 1 − y i ( w T x i + b ) ≤ 0 , i = 1 , 2 , … , N \begin{array}{c}{\max {w, b} \frac{1}{|w|}} \ {\text {s.t. } 1-y{i}\left(w^{T} x_{i}+b\right) \leq 0, i=1,2, \ldots, N}\end{array} maxw,b∣w∣1 s.t. 1−yi(wTxi+b)≤0,i=1,2,…,N- 注意到最大化 1 ∣ w ∣ \frac{1}{|w|} ∣w∣1 和最小化 1 2 ∣ w ∣ 2 \frac{1}{2}|w|^{2} 21∣w∣2是等价的,故最优化问题可转化为:

min w , b 1 2 ∣ w ∣ 2 s.t. 1 − y i ( w T x i + b ) ≤ 0 , i = 1 , 2 , … , N \begin{array}{c}{\min {w, b} \frac{1}{2}|w|^{2}} \ {\text {s.t. } 1-y{i}\left(w^{T} x_{i}+b\right) \leq 0, i=1,2, \ldots, N}\end{array} minw,b21∣w∣2 s.t. 1−yi(wTxi+b)≤0,i=1,2,…,

SVM是一种二分类模型,旨在找到最大间隔的超平面进行分类。通过间隔最大化,SVM解决了线性可分和近似线性可分问题。对偶问题的求解是SVM的核心,允许引入核技巧处理非线性问题。常见的核函数包括线性、多项式和高斯核。SVM对缺失数据敏感,适用于线性可分和非线性问题,且在处理小样本时表现出良好的泛化能力。

SVM是一种二分类模型,旨在找到最大间隔的超平面进行分类。通过间隔最大化,SVM解决了线性可分和近似线性可分问题。对偶问题的求解是SVM的核心,允许引入核技巧处理非线性问题。常见的核函数包括线性、多项式和高斯核。SVM对缺失数据敏感,适用于线性可分和非线性问题,且在处理小样本时表现出良好的泛化能力。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

617

617

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?