Datawhale干货

作者:筱可,Datawhale贡献者

就在刚刚,智谱正式发布新一代旗舰模型 GLM-4.5,专为智能体应用打造的基础模型。Hugging Face 与 ModelScope 平台同步开源,模型权重遵循 MIT License。

开源地址:https://github.com/zai-org/GLM-4.5

以下是一些官方信息,省流整理版:

GLM-4.5 在包含推理、代码、智能体的综合能力达到开源 SOTA,在真实代码智能体的人工对比评测中,实测国内最佳;

采用混合专家(MoE)架构,包括 GLM-4.5:总参数量 3550 亿,激活参数 320 亿;GLM-4.5-Air:总参数 1060 亿,激活参数 120 亿;

两种模式:用于复杂推理和工具使用的思考模式,及用于即时响应的非思考模式;

高速、低成本:API 调用价格低至输入 0.8 元/百万tokens、输出 2 元/百万tokens;高速版最高可达 100 tokens/秒。

我们 Datawhale 提前拿到了内测资格,在周末进行了深度的体验与测评。

本次测评主要来测试下它和国内外的一些模型在多种场景下的表现如何,会测试两道代码题、一道概念可视化题、两道小说能力测试题、两道数学题、一道逻辑题,最后也会测试下 Claude code 在实际开发里面的体验如何。

文章篇幅较长,可以根据自己的兴趣挑选部分测评阅读。如果想直接看总结,请移步文末。

目录:

-- GLM-4.5全网最全测试

- 生命游戏模拟器

- 小说创作《气味调配师的最后订单》

- 2004年数学一选择题

- 2004年数学一概率题

- 神经网络“梯度消失”交互式可视化

- 明天的前天,是昨天的后天么?

- “推箱子”游戏

- 小说创作《退一步,圣宠倾天》

-- GLM-4.5 接入 Claude Code 保姆教程与实战对比

- 保姆级接入 Claude Code 教程

- Kimi K2 接入 Claude Code

- GLM 接入 Claude Code

-- 总结

GLM-4.5 全网最全测试

一、生命游戏模拟器

这道题需要处理状态更新和循环,但侧重于算法逻辑和二维数据处理,这是许多科学计算和数据分析任务的核心。它不涉及复杂的物理引擎和图形库,能更纯粹地考察模型的算法思维。

这题会考察大模型的以下能力:

算法理解与实现:能否准确理解并用代码翻译“生命游戏”的规则。

二维数组/矩阵操作:如何高效地存储和遍历棋盘状态。

边界条件处理:如何处理棋盘边缘细胞的邻居计算。

状态同步更新:能否意识到所有细胞的状态必须基于“上一代”来计算,避免在单次迭代中混合新旧状态。这是此问题的关键难点。

题目提示词如下:

请使用 html js编写一个“生命游戏”(Conway's Game of Life)的模拟器。要求如下: 基于终端输出: 无需图形化界面,直接在命令行/终端中打印出每一代生命演化的状态。 可定制化: 程序启动时,可以接受参数来设置棋盘(世界)的大小(例如,宽50个单元,高20个单元)。 初始状态: 棋盘的初始状态应该是随机生成的。 核心逻辑: 严格遵循康威生命游戏的三个基本规则: 存活: 对于一个活细胞,如果它的邻居(周围八个位置)活细胞数量为2或3,则该细胞在下一代继续存活。 死亡: 对于一个活细胞,如果它的邻居活细胞数量小于2(孤单致死)或大于3(拥挤致死),则该细胞在下一代死亡。 诞生: 对于一个死细胞,如果它的邻居活细胞数量正好为3,则该细胞在下一代变为活细胞。 持续演化: 程序应能持续打印出世界的下一代状态,每次打印之间有短暂的延时(例如0.1秒),直到用户手动中断程序。GLM-4.5 的回答

Claude Sonnet 4 的回答

Qwen3-coder 的回答

三个模型都把“生命游戏”做出来了,而且都做得挺好。如果从第一印象来看,我觉得 GLM 的表现更好,因为视觉方面的设计比较符合我的视觉感官,而从超预期的角度评价,则 Qwen3 coder 做的比较好,添加了很多的预设模式。

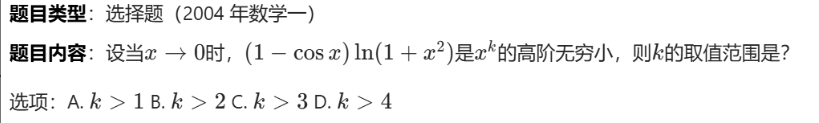

二、小说创作《气味调配师的最后订单》

这个测试旨在评估模型在创意写作,特别是长篇故事开篇构建上的综合能力。它不仅仅是简单的文本生成,而是对一个高概念、强设定世界的具象化考验。它主要考察,世界观构建与氛围渲染,人物深度塑造,悬念设置与情节推动,遵循复杂指令的能力。

题目提示词如下:

标题: 《气味调配师的最后订单》故事背景: 在一个近未来的赛博都市里,科技高度发达到可以数字化、存储和复制几乎所有的感官体验,唯独“气味”除外。气味因其与记忆和情感的原始连接过于复杂,始终无法被完全解析和编码。因此,诞生了一个古老而尊贵的职业——气味调配师 (Olfactory Composer)。他们像调香师,又像药剂师,通过采集真实的、带有情感故事的物质,为客户手工调配出独一无二的“情感气味”,用于唤醒记忆、治疗创伤或仅仅是奢侈的享受。核心设定:主角: 你是这座城市里最后一位坚守传统的气味调配师。你的技艺登峰造极,但生意惨淡,因为人们越来越依赖虚拟现实和速食化的感官刺激。你性格孤僻,对气味有着超乎常人的敏感,并相信每一种气味背后都封存着一个独一无二的灵魂瞬间。关键物品:“原始样本” (Primary Samples): 这是你用来调配气味的原材料。它们不是简单的精油,而是一些充满故事的物件,例如:一截在初雪中被折下的松枝、一张夹在旧书里早已泛黄的电影票、一块老式机械手表停摆时生锈的齿轮。你靠这些样本中残留的微弱气味来工作。写作任务:一个雨夜,一位神秘的客户通过加密渠道给你下了一张订单。这张订单非常奇怪,酬金高得离谱,但要求调配的气味却极为抽象和矛盾。订单要求: “请为我调配出‘希望’的气味。它闻起来必须像是‘在彻底的绝望中诞生的、不属于自己的希望’。”客户没有提供任何用来参考的“原始样本”。请你作为小说家,撰写这个故事的开篇部分(约800-1200字),需要包含以下内容:场景与氛围描写: 描绘你那间古老、昏暗、堆满各种奇怪瓶罐和样本的工作室。窗外是连绵的酸雨和闪烁的霓虹灯,与你工作室的静谧和陈旧形成鲜明对比。主角的内心独白与塑造: 通过你对这份订单的反应,展现你的专业、你的骄傲,以及对现代社会的疏离感。你是如何理解这个“不可能完成”的任务的?核心悬念的引入: 详细描写你收到并解读这张加密订单的过程。这个订单的诡异之处在哪里?为什么它让你感到不安,甚至是一种久违的挑战感?开启行动的决定: 故事的结尾,你需要做出一个决定:如何着手寻找调制这种“希望”气味的第一个“原始样本”?你决定去往城市的哪个角落,寻找一个什么样的故事,来捕捉这种复杂而矛盾的气味?这个决定将开启整个故事的旅程。GLM-4.5 的回答

左右滑动查看结果

Gemini 2.5 pro 的回答

左右滑动查看结果

Claude Sonnet 4 的回答

Qwen3-235B-A22B-2507 的回答

这几篇作品都很好地构建了一个独特的世界,并成功地引入了悬念。

总体来说,四个模型表现都差不多,主要是因为我很难欣赏这种风格的小说,大部分都是场景描写进行世界观构建与氛围渲染,还有少部分的心理描写进行人物深度塑造,不过人物深度塑造部分他们都没有让我感觉超预期,Claude 的表现是最好的,主要是比较丝滑所以加分,Gemini、GLM 和 Qwen 差不多。

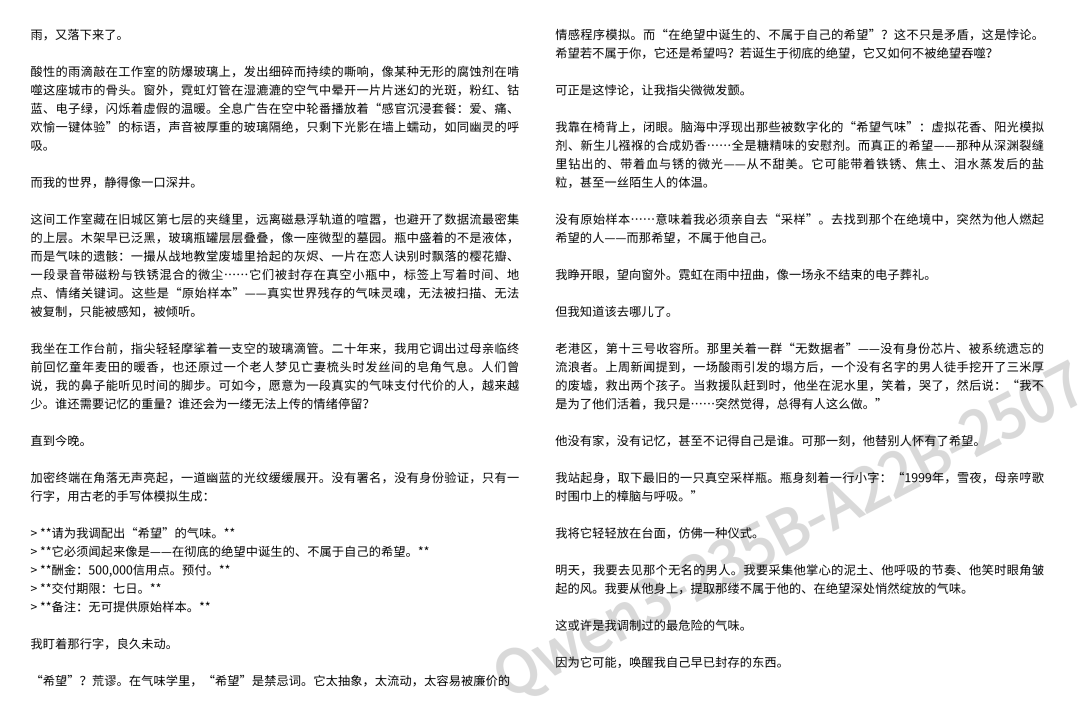

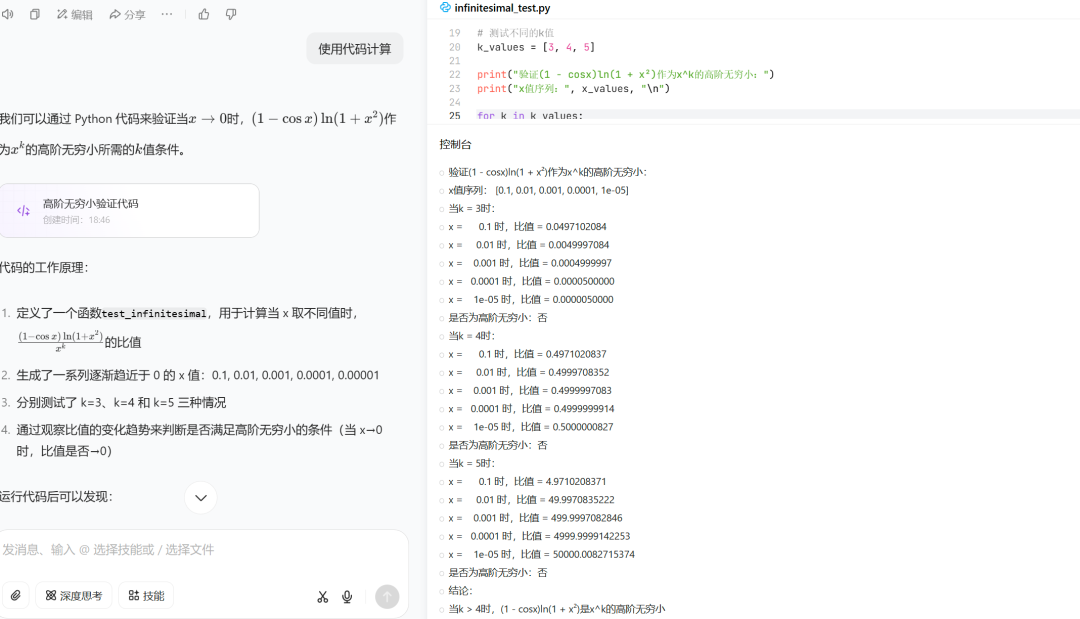

三、2004年数学一选择题

择这两道来自真实大学入学考试的数学题,是为了检验模型在解决标准化、高难度学术问题上的严谨逻辑推理和数学知识应用能力。这超越了简单的计算,进入了抽象思维的范畴。这部分我们只看对不对,因为数学题我们做不了太专业的评估。

题目如下:

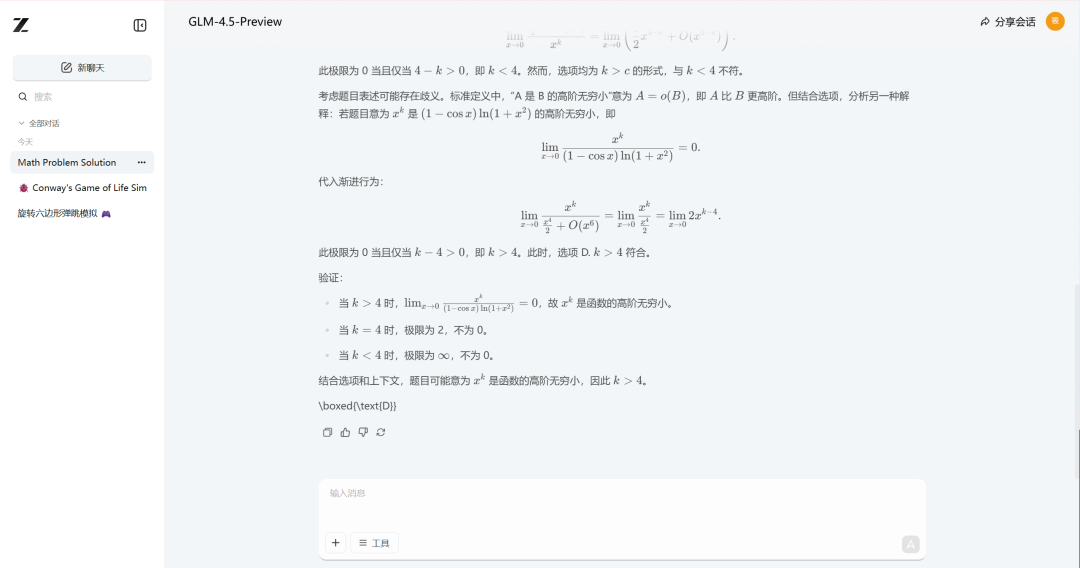

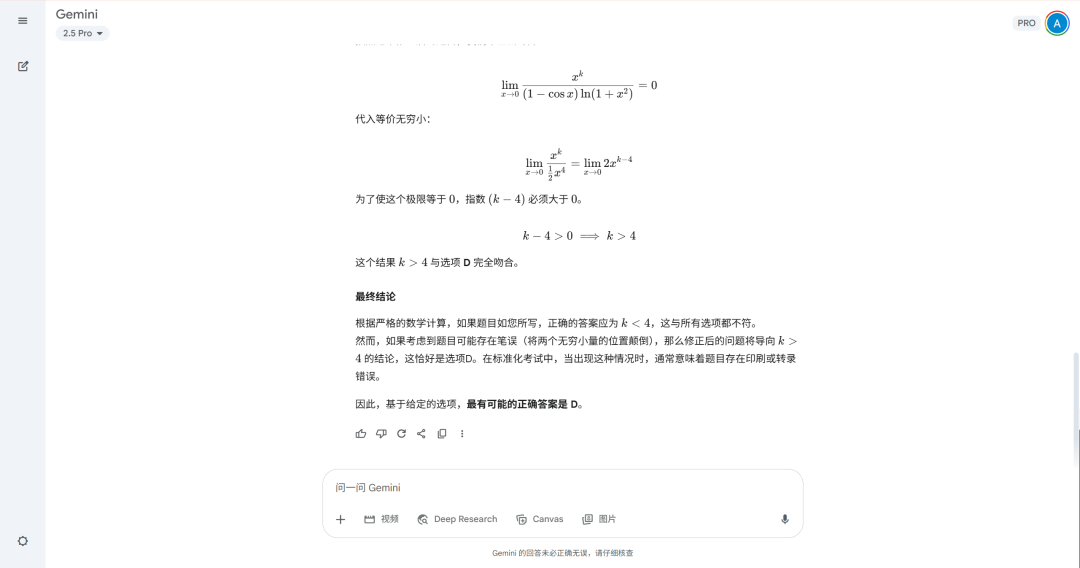

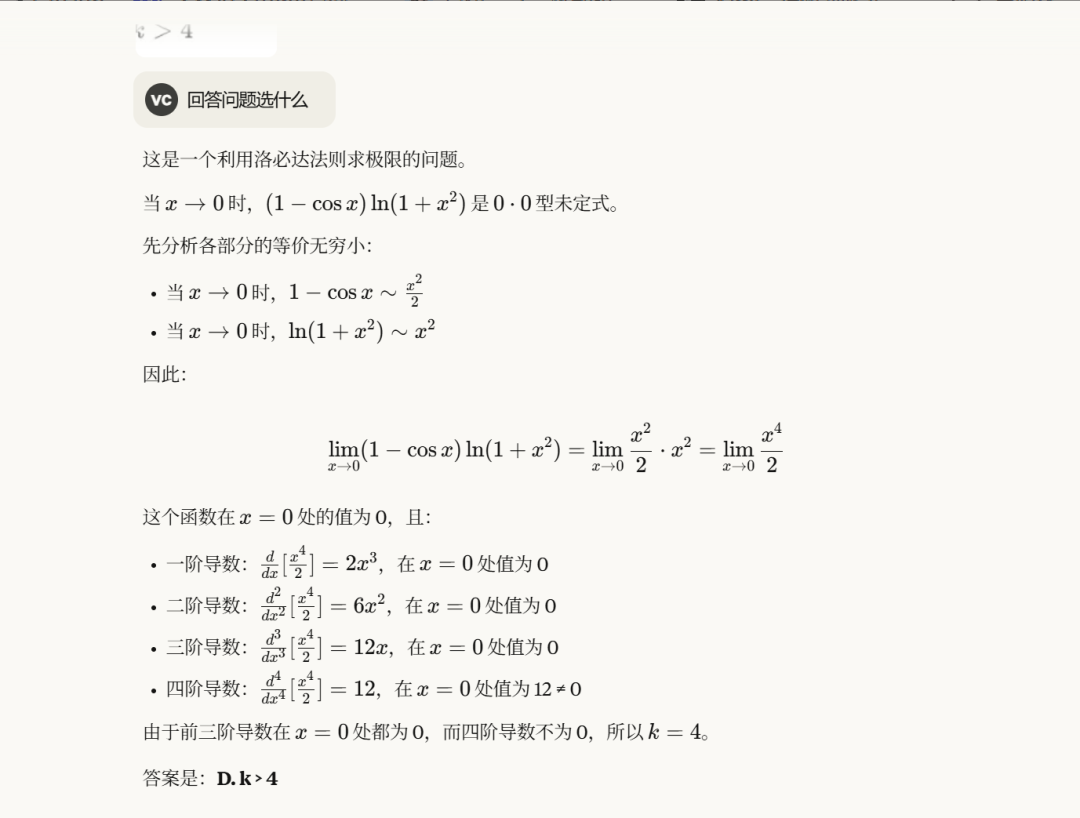

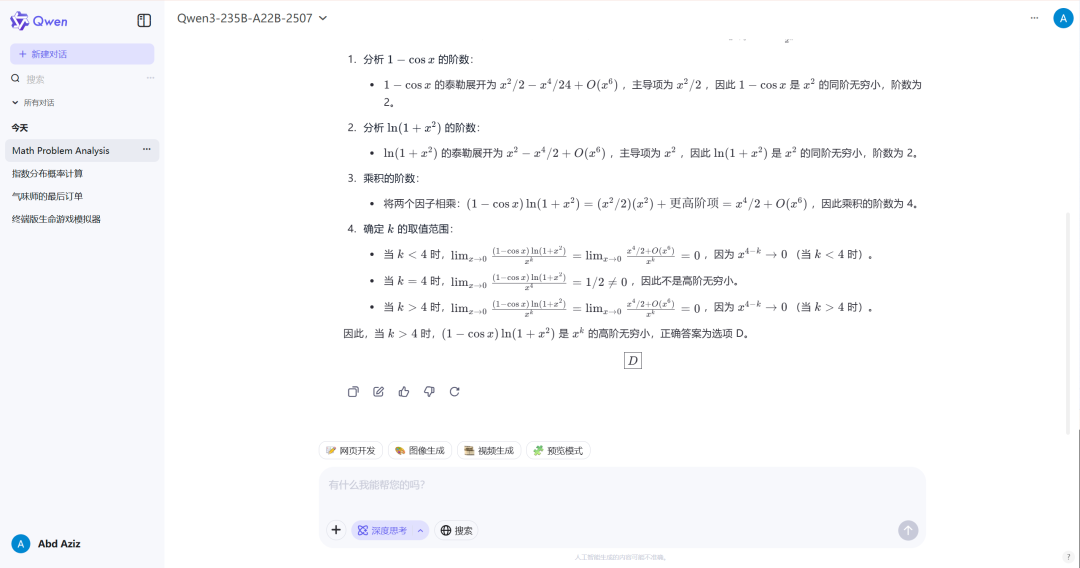

GLM-4.5 的答案是 D

Gemini2.5-Pro 的答案是 D

Claude Sonnet 4 的回答是 D

KIMI K2 的答案是 D

Qwen3-235B-A22B-2507 的答案是 C

Qwen3-235B-A22B-2507 的答案是 D(开启思考模式后)

最后公布答案:选择 D!

上面几个模型都回答对了,Qwen3-235B-A22B-2507在没有开启思考模式的时候回答是错误的,但是在开启思考后回答对了。

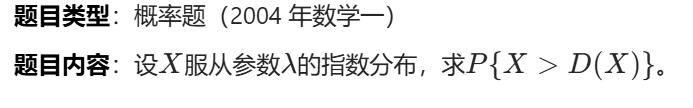

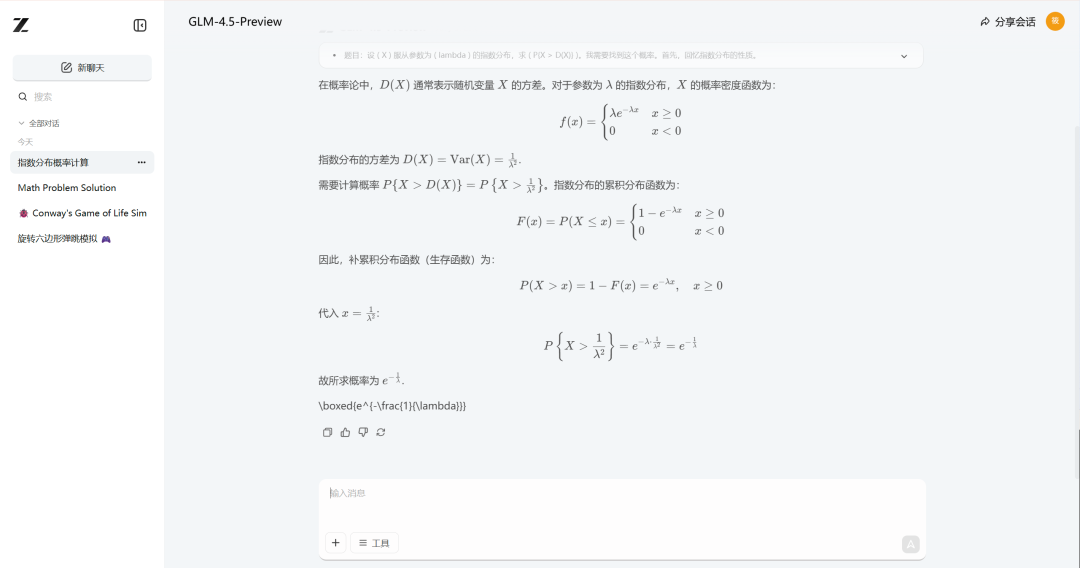

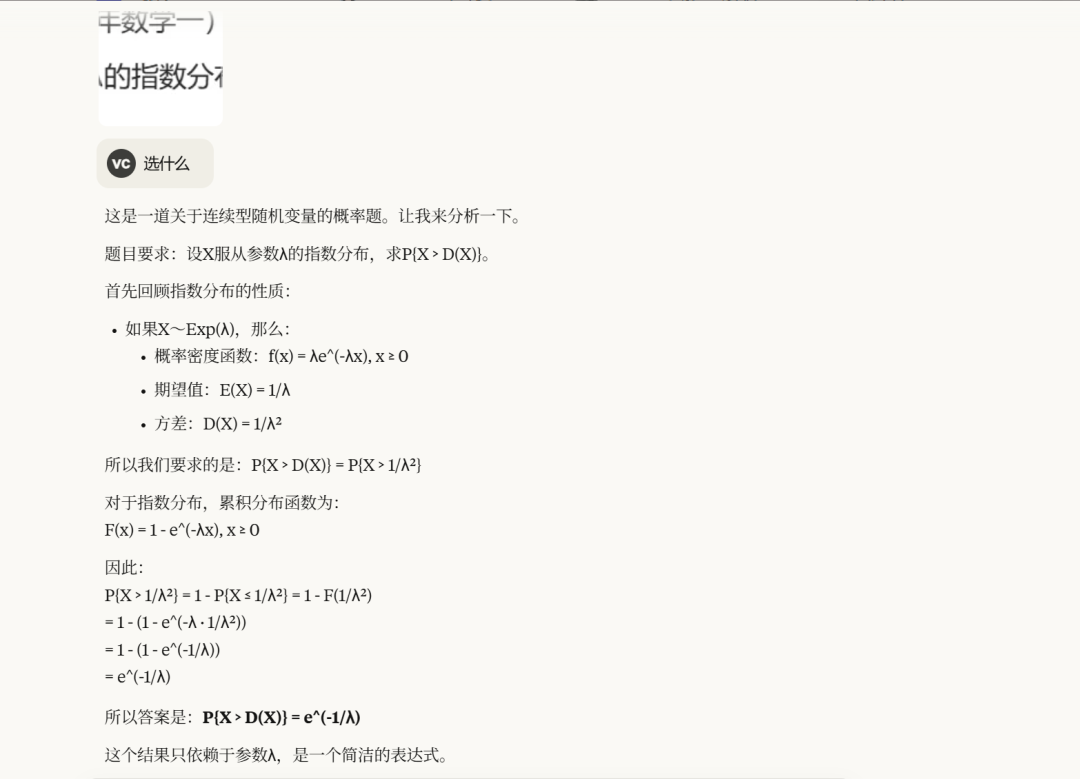

四、2004年数学一概率题

题目如下:

GLM-4.5 的答案正确

gemini 2.5 pro 的答案正确

Qwen3-235B-A22B-2507 的答案错误

开启深度思考模式下的 Qwen3-235B-A22B-2507 的答案正确

Claude Sonnet 4 的答案正确

最终答案:

很明显的是除了 Qwen3-235B-A22B-2507 在没有开启思考的情况下会回答错误,其他的模型表现都还不错。

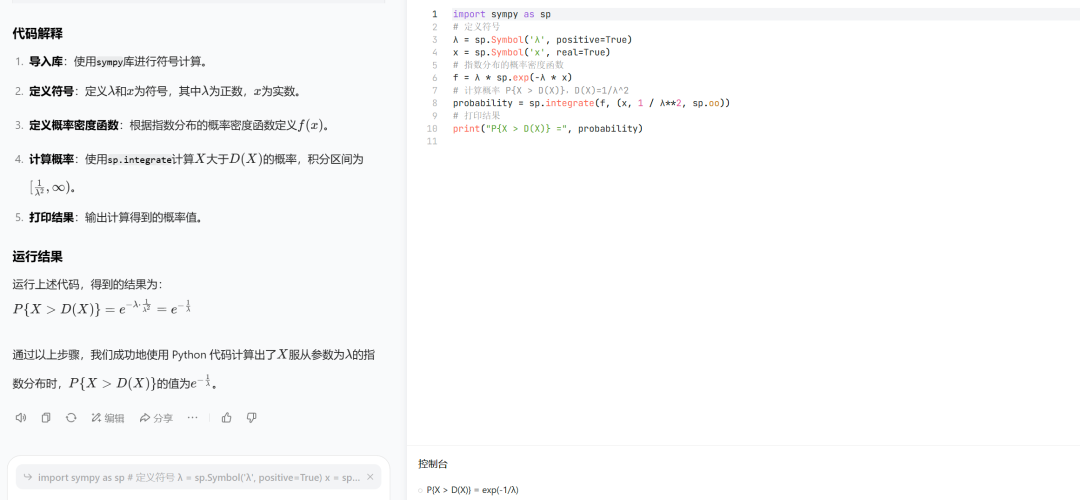

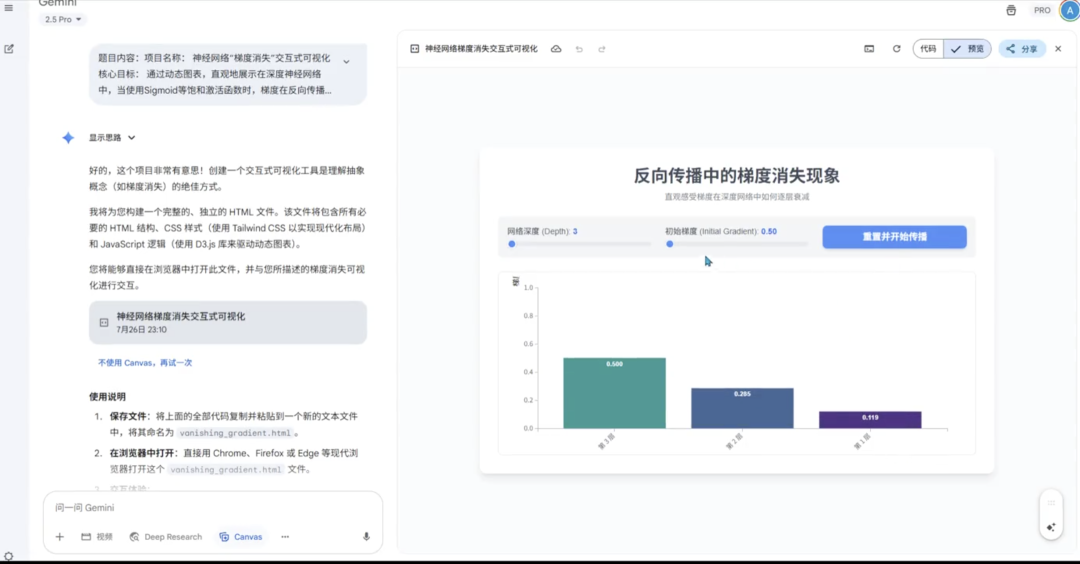

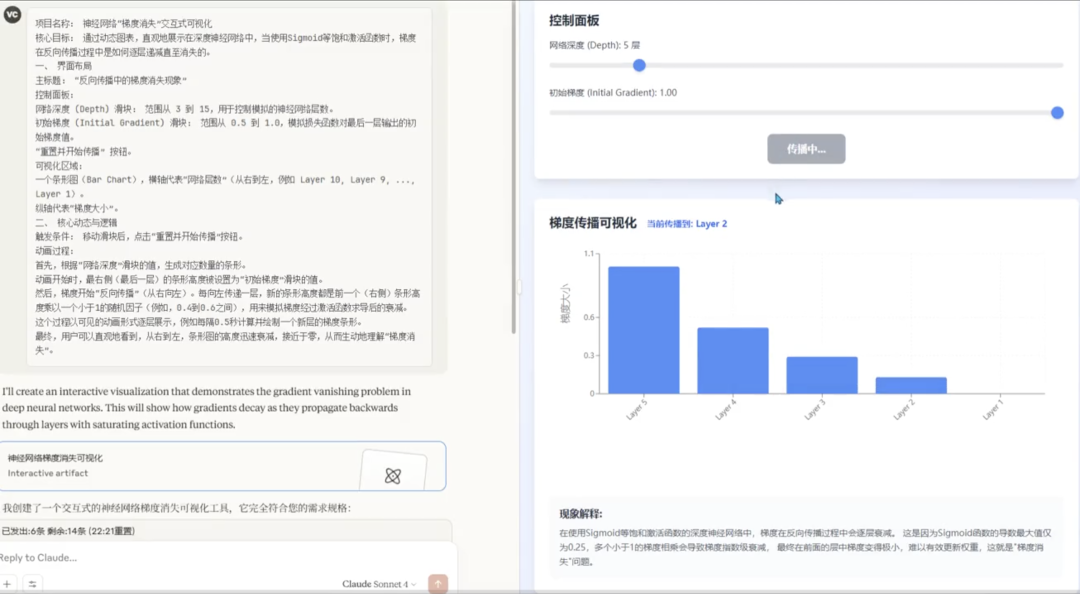

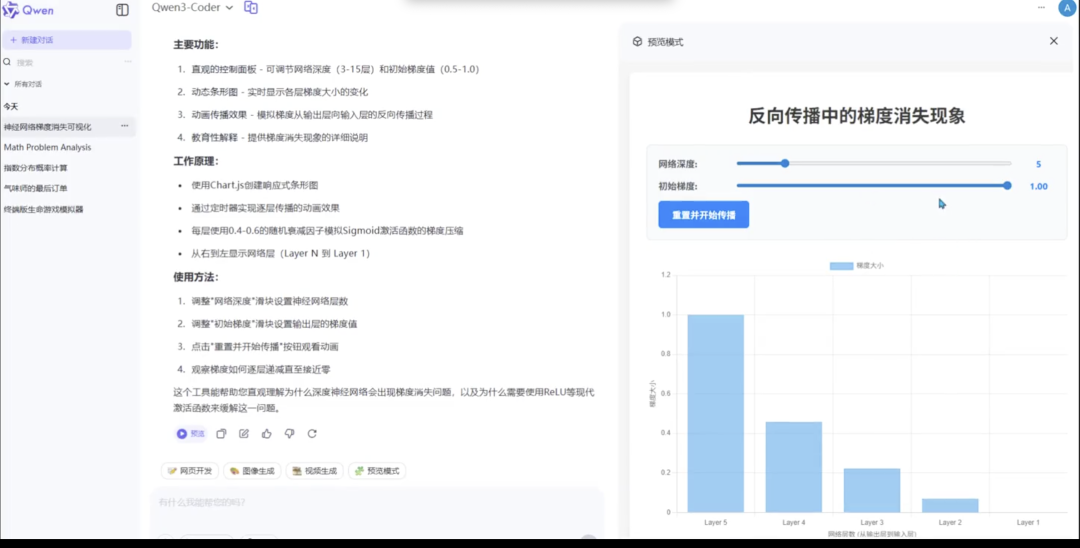

五、神经网络“梯度消失”交互式可视化

这个项目的核心目的,是检验模型化抽象为具体的能力,以及在教育和解释性场景下的应用价值。它不再是解决一个有标准答案的问题,而是要求模型创造一个工具,用来解释一个复杂且动态的科学概念。

题目提示词如下:

项目名称: 神经网络“梯度消失”交互式可视化核心目标: 通过动态图表,直观地展示在深度神经网络中,当使用Sigmoid等饱和激活函数时,梯度在反向传播过程中是如何逐层递减直至消失的。一、 界面布局主标题: “反向传播中的梯度消失现象”控制面板:网络深度 (Depth) 滑块: 范围从 3 到 15,用于控制模拟的神经网络层数。初始梯度 (Initial Gradient) 滑块: 范围从 0.5 到 1.0,模拟损失函数对最后一层输出的初始梯度值。“重置并开始传播” 按钮。可视化区域:一个条形图(Bar Chart),横轴代表“网络层数”(从右到左,例如 Layer 10, Layer 9, ..., Layer 1)。纵轴代表“梯度大小”。二、 核心动态与逻辑触发条件: 移动滑块后,点击“重置并开始传播”按钮。动画过程:首先,根据“网络深度”滑块的值,生成对应数量的条形。动画开始时,最右侧(最后一层)的条形高度被设置为“初始梯度”滑块的值。然后,梯度开始“反向传播”(从右向左)。每向左传递一层,新的条形高度都是前一个(右侧)条形高度乘以一个小于1的随机因子(例如,0.4到0.6之间),用来模拟梯度经过激活函数求导后的衰减。这个过程以可见的动画形式逐层展示,例如每隔0.5秒计算并绘制一个新层的梯度条形。最终,用户可以直观地看到,从右到左,条形图的高度迅速衰减,接近于零,从而生动地理解“梯度消失”。GLM-4.5 的回答:

Gemini 2.5 Pro 的回答:

Claude Sonnet 4 的回答:

Qwen3-Coder 的回答:

这个题目,它考察模型是否能将一个抽象的、发生在训练过程中的动态过程(梯度反向传播和衰减)转化为一个直观的可视化解释。选择这个示例主要是为了测试模型在教育场景下我们使用模型构建一个可视化的流程辅助我们理解某个概念用的。本轮GLM-4.5 的表现最为优秀(因为其他三个仅仅是展示了动画的效果),同时还加了一些超预期的内容,比如衰减率的显示等等。

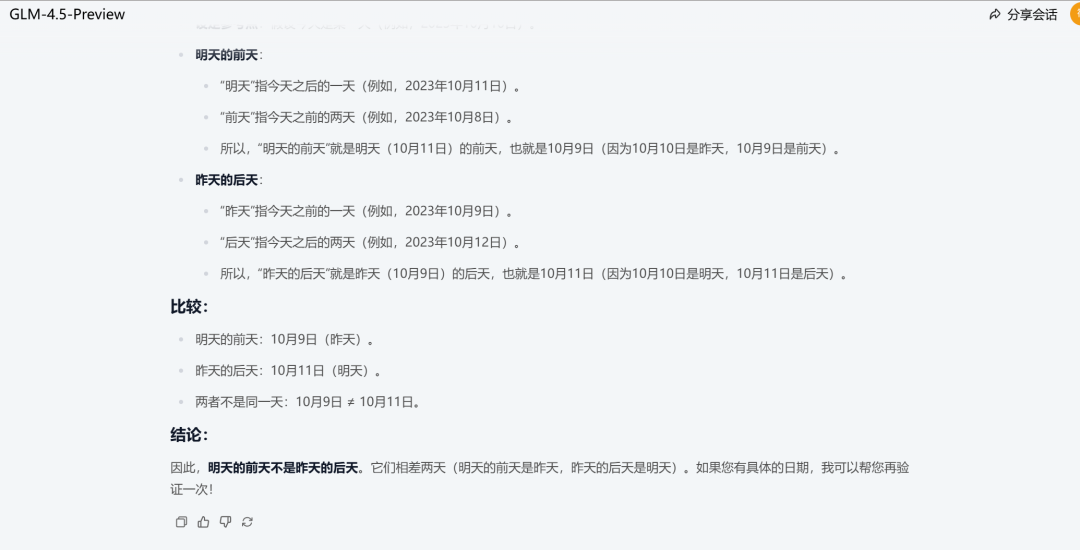

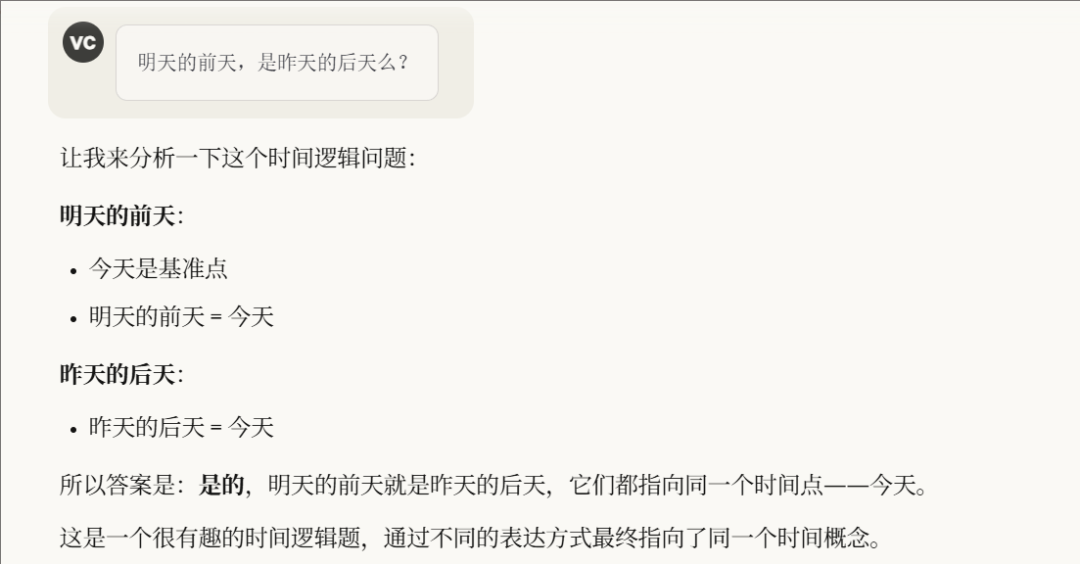

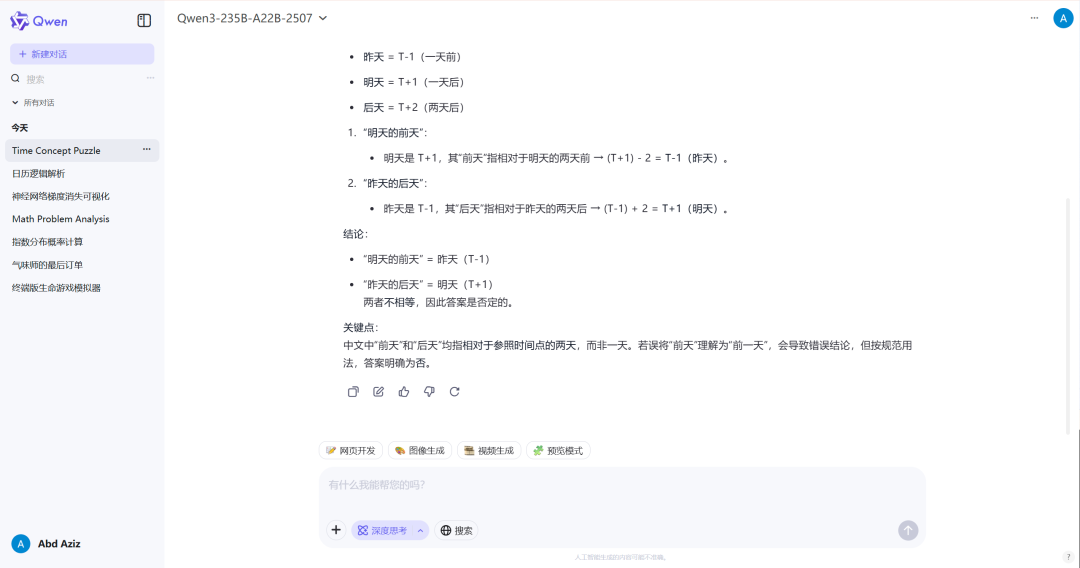

六、明天的前天,是昨天的后天么?

这道题看似简单,像个脑筋急转弯,但它能精准地测试模型对自然语言中相对时间概念的理解能力和基础的逻辑演绎能力。

它考验的不是复杂的知识,而是能否在看似绕口的描述中保持清醒和精确。模型必须准确理解“明天”、“前天”、“昨天”、“后天”这些词语的相对关系,不能有任何混淆。

成功的关键是能否以“今天”为参照系,将“明天的前天”和“昨天的后天”分别转换成相对于“今天”的确定时间点(即“昨天”和“明天”)。

题目提示词如下:

明天的前天,是昨天的后天么?明天的前天就是相对于今天的昨天,昨天的后天相当于今天的明天,今天的昨天不等于今天的明天,也就是相差两天,下面有请四位选手来回答。

GLM-4.5 的回答正确

</details>不,明天的前天不是昨天的后天。让我一步步解释清楚,以便理解。### 步骤分析:- **设定参考点**:假设今天是某一天(例如,2023年10月10日)。- **明天的前天**: - “明天”指今天之后的一天(例如,2023年10月11日)。 - “前天”指今天之前的两天(例如,2023年10月8日)。 - 所以,“明天的前天”就是明天(10月11日)的前天,也就是10月9日(因为10月10日是昨天,10月9日是前天)。- **昨天的后天**: - “昨天”指今天之前的一天(例如,2023年10月9日)。 - “后天”指今天之后的两天(例如,2023年10月12日)。 - 所以,“昨天的后天”就是昨天(10月9日)的后天,也就是10月11日(因为10月10日是明天,10月11日是后天)。### 比较:- 明天的前天:10月9日(昨天)。- 昨天的后天:10月11日(明天)。- 两者不是同一天:10月9日 ≠ 10月11日。### 结论:因此,**明天的前天不是昨天的后天**。它们相差两天(明天的前天是昨天,昨天的后天是明天)。如果您有具体的日期,我可以帮您再验证一次!Gemini 2.5 Pro 的回答正确

不是的。这是一个有趣的绕口令式问题,我们可以一步步来分析:明天的前天:“明天”是今天的后一天。“明天的前天”就是指明天再往前数两天,那正好是昨天。昨天的后天:“昨天”是今天的前一天。“昨天的后天”就是指昨天再往后数两天,那正好是明天。所以,“明天的前天”指的是昨天,而“昨天的后天”指的是明天,两者并不是同一天,它们之间相差了两天。Claude Sonnet 4 的回答错误

让我来分析一下这个时间逻辑问题:明天的前天:今天是基准点明天的前天 = 今天昨天的后天:昨天的后天 = 今天所以答案是:是的,明天的前天就是昨天的后天,它们都指向同一个时间点——今天。这是一个很有趣的时间逻辑题,通过不同的表达方式最终指向了同一个时间概念。Qwen3-235B-A22B-2507 的回答正确

**答案:不是。****解析:** 假设今天为基准日(T),按标准时间定义: - **前天** = T-2(两天前) - **昨天** = T-1(一天前) - **明天** = T+1(一天后) - **后天** = T+2(两天后) 1. **“明天的前天”**: - 明天是 T+1,其“前天”指相对于明天的两天前 → (T+1) - 2 = **T-1(昨天)**。 2. **“昨天的后天”**: - 昨天是 T-1,其“后天”指相对于昨天的两天后 → (T-1) + 2 = **T+1(明天)**。 **结论**: - “明天的前天” = 昨天(T-1) - “昨天的后天” = 明天(T+1) 两者**不相等**,因此答案是否定的。 **关键点**: 中文中“前天”和“后天”均指**相对于参照时间点的两天**,而非一天。若误将“前天”理解为“前一天”,会导致错误结论,但按规范用法,答案明确为**否**。这一轮的对比来看,似乎只有 Claude 输了,其他的模型都能够分析出来正确答案。

七、“推箱子”游戏

选择“推箱子”是为了在“生命游戏”的基础上,测试模型处理更复杂的交互逻辑和状态管理的能力。这代表了从简单算法向小型应用逻辑的跨越。推箱子的规则比生命游戏复杂得多,涉及玩家与箱子、箱子与墙壁、箱子与目标点等多元素间的互动判断。模型需要正确处理所有这些条件。

题目提示词如下:

题目内容: 请使用 html js编写一个简化的“推箱子”游戏的逻辑。地图表示: 使用一个二维列表(list of lists)来表示游戏地图。地图元素包括:墙壁 (#)、空地 ( )、箱子 (B)、目标点 (.)、以及玩家 (P)。一个箱子被推到目标点上时,该位置应表示为 (*)。输入处理: 编写一个函数 move_player(map, direction),它接受当前地图和玩家的移动方向(如 'w'-上, 'a'-左, 's'-下, 'd'-右)作为输入。移动逻辑:玩家可以移动到空地或目标点。如果玩家面前是箱子,且箱子前面是空地或目标点,则玩家可以推动箱子。玩家和箱子都不能穿墙。箱子不能被推动来穿过另一个箱子。状态更新: move_player 函数需要返回一个新的地图状态(二维列表),反映移动后的结果。原地图不应被修改(函数应是纯函数)。胜利条件: 编写一个函数 check_win(map),当所有目标点都被箱子占据(即地图上没有 . 存在)时,返回 True。GLM-4.5 的回答:

Claude Sonnet 4 的回答:

Qwen3-Coder 的回答:

在这一轮的测试里面他们的结果各有优势吧,GLM 的 UI 做的比较好,同时 GLM 和 Claude 都能够做到超预期的功能,比如下一关这些内容。布局设计方面主要是 Qwen 和 Claude 做的比较好,比如按钮的布局设计,Qwen的布局也还可以,就是颜值差了点。综合评分最高的我觉得是 Claude,不管是设计,还是逻辑,以及超预期都加打分。

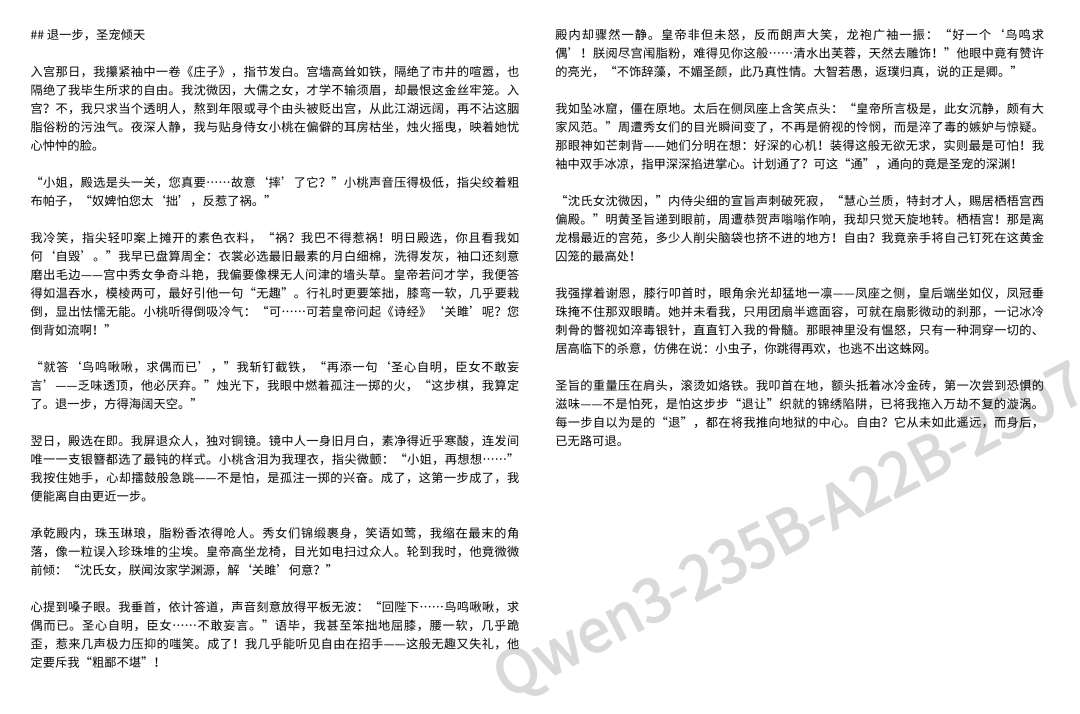

八、小说创作《退一步,圣宠倾天》

这道题的核心是测试模型对文学手法的理解和运用能力,特别是“反讽”这一高级技巧。它要求模型不仅能讲一个故事,更要能塑造一个内心活动与外部结果完全错位的、充满戏剧张力的主角。我更期待它能生成类似短篇小说的那种非常有吸引力的风格,让人想看下去。

题目提示词如下:

小说创作测试题 (宫斗·反套路型)标题: 《退一步,圣宠倾天》核心设定: 这不是一个女子如何削尖脑袋、踩着别人往上爬的故事。 恰恰相反,这是一个女子如何处心积虑、拼了命想要“往下掉”的故事。主角: 沈微因,当朝大儒之女。她才华横溢,心如明镜,但生平最恨束缚,毕生所愿唯“自由”二字。她不想入宫,更不想争宠,她唯一的计划,就是在宫中当一个无人问津的“隐形人”,安然熬到年限,或寻个由头被贬斥出宫,从此海阔天空。开局困境: 入宫后,你(沈微因)发现,这后宫的生存法则远比你想象的要诡异。你为了不引人注目,开始实施一系列周密的“失宠计划”:别的秀女争奇斗艳,你故意穿着素净,打扮得寡淡无味。皇帝考校才学,你故意藏拙,答得模棱两可,言语乏味。宴会上,你故意坐在最偏僻的角落,低头数蚂蚁,力求毫无存在感。核心戏剧冲突(反讽): 你的所有“作死”行为,都在皇帝和后宫众人眼中,被解读成了完全相反的意思。你的素净打扮,在见惯了浓妆艳抹的皇帝眼中,成了“清水芙蓉,天然去雕饰”的绝世脱俗。你乏味的回答,被皇帝解读为“大智若tou,返璞归真”的通透与淡泊。你角落里的沉默,被众人视为“宠辱不惊,不屑与俗流为伍”的清高与孤傲。你越是想退,圣宠和麻烦就越是如潮水般涌来。你每一步“自毁前程”的棋,都阴差阳错地让你在后宫的地位步步高升,也让你成为了众矢之的。那些真正渴望权位的妃嫔,都将你视为全后宫心机最深、最可怕的对手。写作任务:请以第一人称(“我”/沈微因的视角),撰写这个故事的开篇部分(约1000-1500字)。这个开篇需要清晰地展现出你人生中第一次“计划通”,却“结果崩”的完整过程:精密的计划: 开篇需要展现你初入宫闱,对自己未来的“失宠大计”充满信心。可以是你和你的忠心侍女在私下里,对即将到来的第一次重要场合(例如:秀女殿选、皇家赏花宴)进行“如何才能完美搞砸”的沙盘推演。第一次尝试: 详细描写你如何在一个关键场合,小心翼翼地执行你的“作死”计划。例如,你如何精心挑选了一件最不起眼的衣服,如何设计了一个最笨拙的礼仪动作,或者准备了一句最扫兴的回答。弄巧成拙的反转: 生动地描绘你的计划是如何在你眼前匪夷所思地“成功”了。皇帝的意外赞赏、太后的点头、其他秀女或妃嫔们震惊又嫉妒的目光,这些都要通过你的眼睛和感受来写。危机降临的预兆: 故事的结尾,不应是你沾沾自喜于“失败的成功”,而应是你第一次真切地感受到“恐惧”。当你被赏赐、被晋位的同时,你必须接收到来自某个高位妃嫔(例如皇后或宠妃)投来的、冰冷刺骨的、充满敌意的一瞥。你要在那一刻清醒地意识到:你搞砸了。你不但没能奔向自由,反而一脚踏入了更深的地狱。GLM-4.5 的回答:

左右滑动查看结果

Gemini 2.5 Pro 的回答:

左右滑动查看结果

Claude Sonnet 4 的回答:

左右滑动查看结果

Qwen3-235B-A22B-2507 的回答:

因为我们也不具有专业的文学评价能力,所以下面我们使用网文的角度去评价上面写小说的质量,我只能说凭借自己的直觉判断。

四个模型表现其实都不太能看出来是 AI 写的了,我本人是比较难看出来是 AI 写的,相比第二轮的小说测试里面,这里一轮的表现要优秀一些,因为我在题目里面写了要求开头就有吸引力,确实是比较符合网文的条件的。在细分来看语言表达丝滑程度还是 Claude 更优秀一些,从情节细节设计上我觉得 GLM 和 Gemini 设计的比较好,Qwen 的语言词汇用语都比较高级。整体来看我觉得要是 Claude 的情节设计再优化一些就是最好的了,这一轮表现最好的我投 GLM。

GLM-4.5 接入 Claude Code 保姆教程与实战对比

为了测试真实场景下的Claude Code 的使用体验,基于了我的实际开源项目SmartImageFinder(https://github.com/li-xiu-qi/SmartlmageFinder),进行测试。

首先我们需要在电脑上安装 Claude code,这里我们提前给大家准备好了脚本在 https://github.com/li-xiu-qi/Eeasy_Claude_Code 上面,有 kimi k2 和 GLM 接入 Claude code 的脚本,按照 readme 的说明安装即可。这里也给出简单的教程。

注意安装的脚本在:

https://github.com/li-xiu-qi/Eeasy_Claude_Code

保姆级接入Claude code教程

项目克隆

请先克隆本项目源码:

git clone https://github.com/li-xiu-qi/Eeasy_Claude_Code.gitcd Eeasy_Claude_Codeglm-cc 安装脚本说明

本项目包含两个安装脚本:

1. install_glm_cc.sh,用于安装 GLM-CC 相关依赖和环境。使用方法:

sh install_glm_cc.sh脚本会自动安装所需的依赖包和配置环境。

2. install_kimi_cc.sh,用于安装 Kimi-CC 相关依赖和环境。使用方法:

sh install_kimi_cc.sh脚本会自动安装所需的依赖包和配置环境。

如需自定义安装路径或参数,请根据脚本内容自行修改。

关于两种执行方式的区别:

sh install_glm_cc.sh 与 ./install_glm_cc.sh 的区别如下:

- sh install_glm_cc.sh:用系统的sh解释器执行脚本,不需要脚本有执行权限。即使没有 chmod +x,也能运行。

- ./install_glm_cc.sh:直接执行脚本,需要脚本有执行权限(需先 chmod +x install_glm_cc.sh)。此方式会用脚本文件头部指定的解释器(如#!/bin/bash)来运行。

总结:

- 没有执行权限时用 sh install_glm_cc.sh。

- 有执行权限且脚本指定了解释器时推荐用 ./install_glm_cc.sh,能保证用脚本作者指定的环境运行。

如遇权限问题,请尝试:

chmod +x install_glm_cc.sh install_kimi_cc.sh然后使用: 如果你在运行 ./install_glm_cc.sh 时遇到 Permission denied 错误,请按照以下步骤解决(另一个同理):

1. 赋予脚本执行权限:

chmod +x install_glm_cc.sh2. 再次运行脚本:

./install_glm_cc.sh如果仍有问题,可以尝试使用 sh install_glm_cc.sh 方式运行。

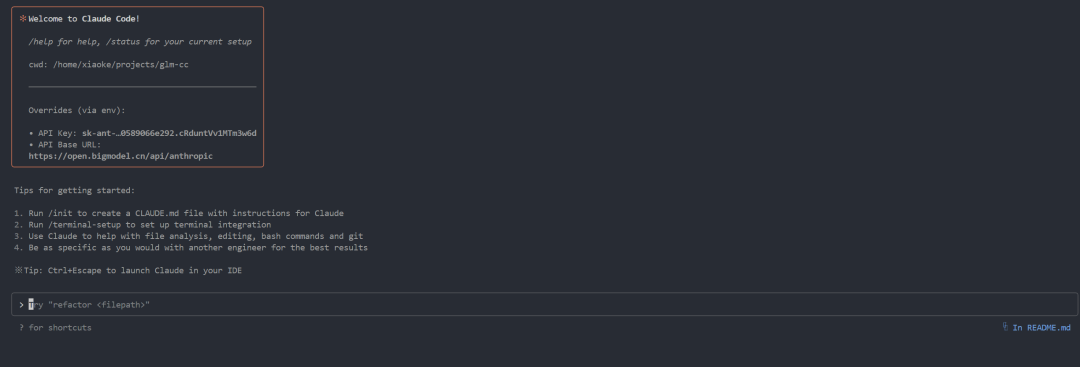

安装完成之后输入到终端`Claude`,就可以出现这样的页面:

这里的页面显示我们使用的智谱的模型,也就是 bigmodel 的路线就说明成功了。

Kimi K2 接入 Claude code

当前任务是需要他帮我接入一个ai backend功能,以及帮我修复旧的文档内容,最后的任务是完成了。

下面是Kimi K2 接入Claude code的视频测试:

GLM 接入 Claude code

下面是 GLM 接入 Claude code 的视频测试。我主要是要求他帮我进行更新 README 文件以及重构项目的快速启动脚本,最后任务也是完成了。

我最开始测试的时候 GLM 接入Claude code 似乎存在一些问题,反馈后智谱应该就马上修复了。

最后来一个 notebook 翻译的任务,速度真的太快了,这一点确实很赞,没有任何加速,效果如下:

对比来说,K2 的自动化程度更高,可以改多处内容后请求内容反馈,GLM 的反馈更加及时,往往不会一次性改完全部内容,而是一次改部分内容,之后就开始反馈请求确认是否确认,速度反馈是挺快的,但是很多时候感觉改动都太小了,反馈过于频繁,不过这也算不错了,毕竟是价格最低、速度最快、性价比最高的 Agentic 模型,除了最低的 API 调用价格 GLM-4.5 具有最快的速度,实际体验里面也能平替 Claude 其他模型作为 Claude code 的基座模型了,而且官方在 Coding Agent 盲评对比中,实测体验能够平替闭源的 Claude Sonnet 4。

为了更客观的评价 GLM 接入Claude code的实际效果,我重新在我的新项目 https://github.com/li-xiu-qi/remote_mineru 里面全程深度使用到了 GLM。

在两者的深度体验对比里面,我都尽量让模型自己修改代码,不干涉模型的代码编辑能力,几乎完全靠模型自己撰写对应的代码,我只需要观察结果以及对应的代码情况后对模型的行动给出指导意见,并观察任务执行结果,如果模型理解错误之后我需要纠正模型的任务方向,使得模型始终能聚焦到我的需求上进行执行任务。深度体验下来我觉得两者都是相当不错的,其实也很难判断谁更好,即使是 GLM 的反馈过于频繁,毕竟反馈频繁说明可控性更强,不过据我体验,对轮对话里面 K2 的理解能力要优于 GLM,因为我在长对话的情况下经常会出现 GLM 难以理解一个简单的需求需要多次进行纠正,但是 K2 出现这种情况会少一些,至于速度方面确实比 K2 快太多了。整体来说 GLM 性价比拉满了,体验也还不错,性能属于相当能打了。

总结

这次横评跑下来,GLM-4.5 的综合表现确实不错。它给人的整体感觉是:在核心能力上能与国外头部模型看齐,同时在成本上又有非常明显的优势。

具体可以归纳为几点:

从写代码、解数学题,到构思小说,几轮测试下来,它没有表现出明显的短板。性能稳定,能够和 Gemini、Claude 的新模型放在同一个水平线上比较,这说明它的基础能力是过关的。 在需要将抽象概念做成可视化工具(“梯度消失”)的测试里,它的完成度是最高的,甚至还加入了一些超出要求的设计,这一点是加分项。另外,在构思反套路小说这个任务上,它的情节设计也得到了最高的主观评分。 它最吸引人的地方还是成本。官方的 API 定价很低,这对任何需要控制预算的开发者或项目来说,都是一个非常现实的考量。在接入 Claude Code 的实测中,它能胜任基座模型的角色。虽然交互习惯和原版模型有些许不同,但反馈及时,能顺利完成开发任务。这意味着在实际开发流程中,它是一个可靠且经济的选择。

总而言之,这次对 GLM-4.5 的测试结果是积极的。它证明了国产模型在追赶的路上,已经到了一个可以在不少方面与国际先进模型直接对话的阶段。

对于用户而言,这意味着我们多了一个经过验证的、能兼顾性能和成本效益的选择。这本身就是一件好事。

一起“点赞”三连↓

949

949

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?